googLeNet--Inception四部曲四Inception-ResNet and the Impact of Residual Connections on Learning

阿新 • • 發佈:2019-01-30

原論文:Going deeper with convolutions

作者:Christian Szegedy,Wei Liu,Yangqing Jia,Pierre Sermanet,Scott Reed,Dragomir Anguelov,Dumitru Erhan,Vincent Vanhoucke,Andrew Rabinovich

時間:February 2012

本文的大部分觀點來自於這篇論文,並且加入了一些自己的理解。該部落格純屬讀書筆記。

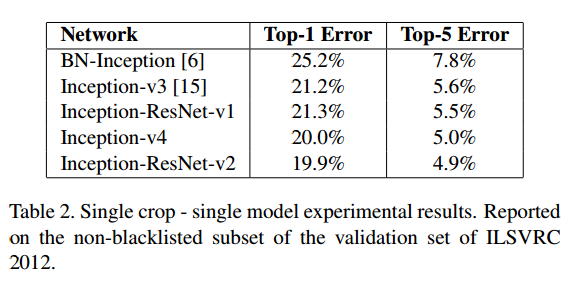

Pure Inception blocks

基於對TensorFlow系統的使用,使得Inception architecture不需要過多的考慮分散式訓練帶來的諸多問題,不需要考慮模型的分割。這樣我們的模型的結構會更簡潔,計算量也更少。Scaling of the Residuals

圖1

圖1