使用flume進行日誌收集的總結(1)

由於最近幾個月在搞一個實時監控平臺的專案,用的是flume+kafka+spark,之前領導說弄個文件總結一下專案開發中的用到技術以及容易出錯的地方,以供之後的新手們參考(其實我也才接觸了幾個月而已),現在才有時間弄文件,順便也發個部落格記錄一下(處女篇),畢竟當初我也是不斷在網上查資料的 ,希望這份資料對大家有用吧。

,希望這份資料對大家有用吧。

由於網上對於flume的簡介很多,這裡就不多做贅述了,直奔主題,flume的安裝就不說了,直接解壓就可以了,解壓之後需要修改一下配置檔案

①cp flume-conf.properties.template flume-conf.properties

②vi flume-conf.properties

接下來就是配置flume的source,channel和sink

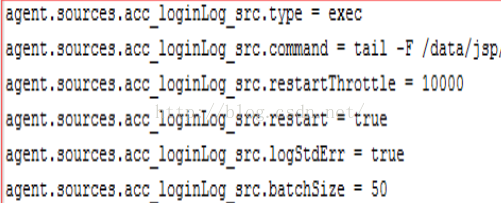

source配置:

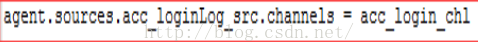

channel配置:

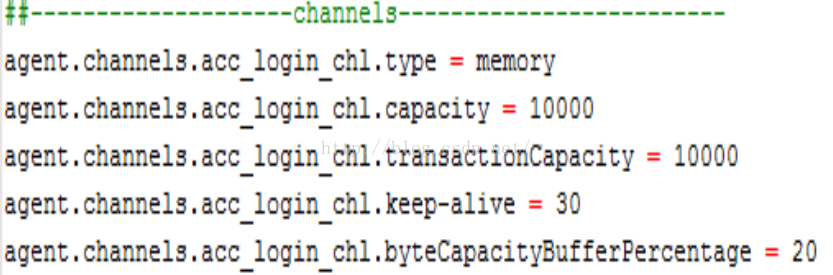

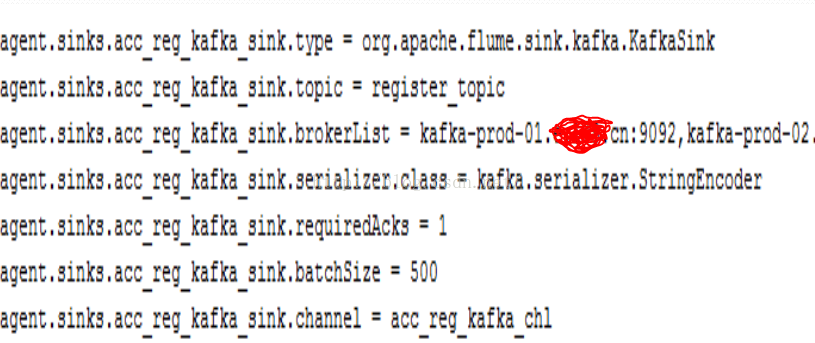

sink配置:

彙總的flume的kafkaSink配置:

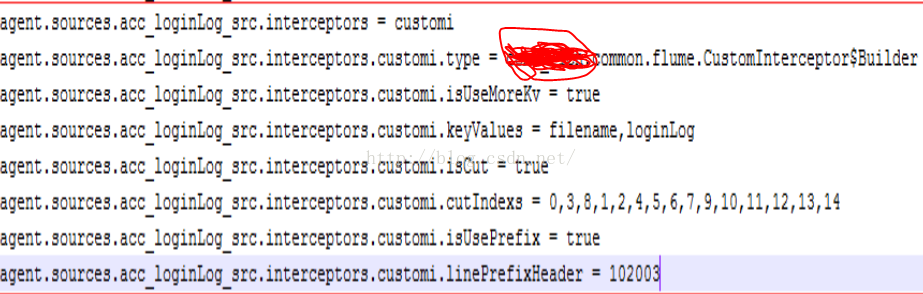

接下來簡單說說flume的攔截器,flume提供了許多攔截器,當Source指定一個攔截器後,攔截器會得到Event資料,可以在攔截器中過濾提取資料,一個Source可以指定多個攔截器形成攔截器chain

攔截器配置:

好了,先說這麼多,這些應該算是簡單的入門知識(畢竟是第一篇),下一篇會說一下我接觸到的flume的負載均衡以及監控工具方面的東西,接下來也會更新工作中用到的kafka方面的知識點,希望大家多多支援