python app多執行緒爬蟲以及代理ip的使用

用的是執行緒池

import requests import json from multiprocessing import Queue from handle_mongo import mongo_info from concurrent.futures import ThreadPoolExecutor

max_workers 執行緒數

pool = ThreadPoolExecutor(max_workers=2)

while queue_list.qsize() > 0:

pool.submit(handle_caipu_list, queue_list.get())

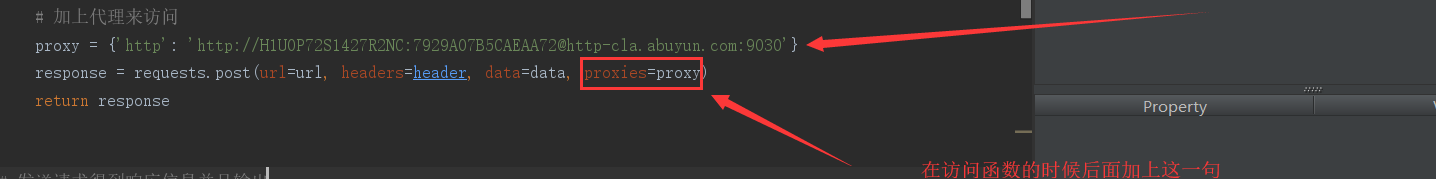

代理的使用

阿布雲

# 加上代理來訪問

proxy = {'http': 'http://H1U0P72S1427R2NC:[email protected]:9030'}

response = requests.post(url=url, headers=header, data=data, proxies=proxy)

相關推薦

python app多執行緒爬蟲以及代理ip的使用

用的是執行緒池 import requests import json from multiprocessing import Queue from handle_mongo import mongo_info from concurrent.futures import

python:多執行緒抓取西刺和快站 高匿代理IP

一開始是打算去抓取一些資料,但是總是訪問次數多了之後被封IP,所以做了一個專門做了個工具用來抓取在西刺和快站的高匿IP。 執行環境的話是在python3.5下執行的,需要requests庫 在製作的過程中也參考的以下網上其他人的做法,但是發現很大一部分都不是多執行緒去抓取有點浪費時間了,又或者

Python多執行緒爬蟲學習

此程式碼包含以下學習內容: 程式封裝 網頁獲取與解析 retry裝飾器與thread多執行緒 Anime code # -*- coding: utf-8 -*- import requests import demjson from retry imp

python多執行緒爬蟲時,主執行緒一直等待錯誤。

1、抓取網站的專輯資訊時,遇到了加上守護執行緒 ,程式執行完主執行緒,唰的一下就結束了,子執行緒在哪裡?嗯,丟掉了 t.setDaemon(True) #設定守護執行緒 把上邊那句註釋掉後,子執行緒…….emmmmm….. 執行了,然後就一直在等待………………………等一個不知道是

Python爬蟲從入門到精通(3): BeautifulSoup用法總結及多執行緒爬蟲爬取糗事百科

本文是Python爬蟲從入門到精通系列的第3篇。我們將總結BeautifulSoup這個解析庫以及常用的find和select方法。我們還會利用requests庫和BeauitfulSoup來爬取糗事百科上的段子, 並對比下單執行緒爬蟲和多執行緒爬蟲的爬取效率。 什麼是

python多執行緒爬蟲+批量下載鬥圖啦圖片專案(關注、持續更新)

python多執行緒爬蟲專案() 爬取目標:鬥圖啦(起始url:http://www.doutula.com/photo/list/?page=1) 爬取內容:鬥圖啦全網圖片 使用工具:requests庫實現傳送請求、獲取響應。 xpath實現資料解析、提取和清洗 thr

Python使用多執行緒(附:爬蟲使用的執行緒池)

python開啟多執行緒。 使用的庫: python 3.+ :threading(較高階,常用), _thread(python2.+中叫 thread)(偏底層) python 2.+ :th

python爬蟲入門(四)利用多執行緒爬蟲

#!/usr/bin/env python # -*- coding:utf-8 -*- # 使用了執行緒庫 import threading # 佇列 from Queue import Queue # 解析庫 from lxml import etree # 請求處理 impor

python多執行緒爬蟲學習--去除html的標籤

import re import urllib page = urllib.urlopen("http://www.baidu.com") html = page.read() patter

python多執行緒爬蟲學習--Queue

Queue是python多執行緒安全的佇列實現,封裝了資料結構中的佇列,保證了執行緒之間使用佇列同步資料不會出錯。 也就是說使用Queue就不用使用鎖去同步資料。 Queue預設構造的大小是無限的,也

python多執行緒爬蟲學習--去除字串中間空格

python去除字串中間空格的方法 1、使用字串函式replace >>> a = 'hello world' >>> a.replace(' ', '') 'helloworld'12341234 看上這種方法真的是很笨。 2、

使用scrapy+IP代理+多執行緒爬蟲對拉鉤網在杭州網際網路職位資訊的抓取

#encoding=utf8 import urllib2 from bs4 import BeautifulSoup import socket import urllib import requests import random from LagouProject.dbhelper import Tes

Python 爬蟲第三步 -- 多執行緒爬蟲爬取噹噹網書籍資訊

XPath 的安裝以及使用 1 . XPath 的介紹 剛學過正則表示式,用的正順手,現在就把正則表示式替換掉,使用 XPath,有人表示這太坑爹了,早知道剛上來就學習 XPath 多省事 啊。其實我個人認為學習一下正則表示式是大有益處的,之所以換成 XPa

Python+Selenium多執行緒基礎微博爬蟲

一、隨便扯扯的概述 大家好,雖然我自上大學以來就一直在關注著CSDN,在這上面學到了很多知識,可是卻從來沒有發過部落格(還不是因為自己太菜,什麼都不會),這段時間正好在機房進行期末實訓,我們組做的是一個基於微博資訊的商品推薦系統,不說這個系統是不是真的可行可用,

python 的多執行緒以及鎖定

下面的程式碼主要是使用一個類對外部資料(myList)進行修改,由於兩個執行緒同時對myList修改,在不加鎖的情況下,可能導致資料被不安全修改。 讀者可嘗試將“開啟鎖”和“釋放鎖”註釋,重執行,看效

python中多執行緒排程機制以及GIL

總結下python中執行緒排程機制. 對於執行緒排程機制而言,同作業系統的程序排程一樣,最關鍵是要解決兩個問題: 1.在何時選擇掛起當前執行緒,並選擇處於等待的先一個執行緒呢? 2.在眾多等待的執行緒中,選擇哪一個作為啟用執行緒呢? 在python多執行緒機制中,這個兩

Python Threading 多執行緒程式設計

寫在篇前 threading模組是python多執行緒處理包,使用該模組可以很方便的實現多執行緒處理任務,本篇文章的基礎是需要掌握程序、執行緒基本概念,對PV原語、鎖等傳統同步處理方法有一定的瞭解。另外,threading模組的實現是參考java多執行緒處理方式,並且只實現了其中的一

Python建立多執行緒任務並獲取每個執行緒返回值

轉自:https://www.cnblogs.com/bethansy/p/7965820.html 1.程序和執行緒 (1)程序是一個執行中的程式。每個程序都擁有自己的地址空間、記憶體、資料棧以及其他用於跟蹤執行的輔助資料。程序也可以派生新的程序來執行其他任務,

python 通過多執行緒實現Excel 批量更新商品價格

import openpyxl import threading wb = openpyxl.load_workbook('produceSales.xlsx') sheet = wb.active all_info = [] for row in sheet.rows: child

非結構化資料與結構化資料提取---多執行緒爬蟲案例

多執行緒糗事百科案例 案例要求參考上一個糗事百科單程序案例 Queue(佇列物件) Queue是python中的標準庫,可以直接import Queue引用;佇列是執行緒間最常用的交換資料的形式 python下多執行緒的思考 對於資源,加鎖是個重要的環節。因為python原生的list,dict等,