SVM的matlab實現——CVX工具箱應用

阿新 • • 發佈:2019-02-07

機器學習經典演算法SVM,網上有各種部落格介紹,以及各種語言的原始碼。 這裡提供SVM幾種版本的matlab實現,主要目的是熟悉利用CVX來求解凸優化問題。

basic SVM

推導什麼的就不說了,直接搬最後的公式:

minw,b2∥w∥22

s.t.yi(wTxi+b)≥1,i=1,...,L x_i+b)\ge1,i=1,…,L

然後是程式碼:`

function [ w,b ] = svm_prim_sep( data,labels )

%UNTITLED2 此處顯示有關此函式的摘要

% Input:

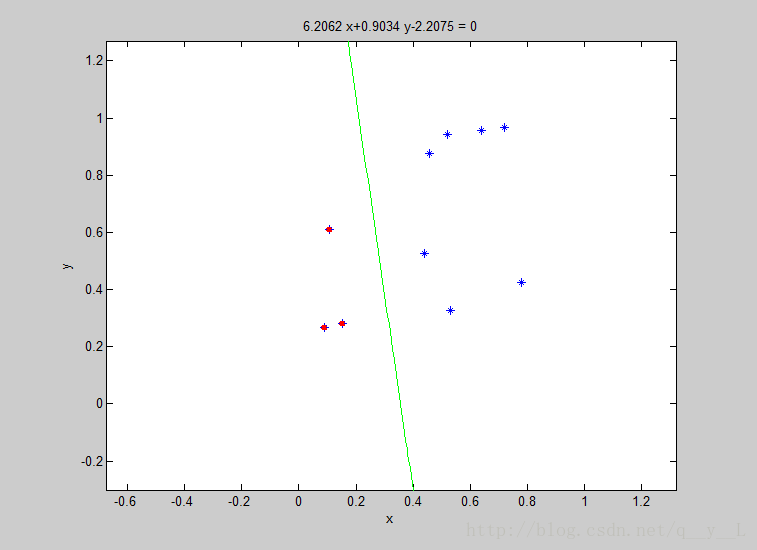

% data: num-by-dim matrix .mun is 然後隨便隨機生成了10個2維樣本,執行結果如下:

- Soft Margin SVM

Soft Margin SVM

線性不可分的時候,通過引入罰函式(penalty function)來解決,使得分類誤差最小。公式如下:

程式碼依然很簡單:

function [ w,b ] = svm_prim_sep( data,labels )

%UNTITLED2 此處顯示有關此函式的摘要

% Input:

% data: num-by 是不是很簡單?例子以後再給吧。(公式亂碼,請嘗試其它瀏覽器)

未完待續,