阿里雲Spark安裝教程_完全分散式_Spark-2.2.0_CentOS7.4

阿新 • • 發佈:2019-02-09

一、環境

本教程中使用兩臺阿里雲伺服器,其配置為單核CPU,2G記憶體,作業系統為CentOS7.4。預設已經安裝了JDK1.8及Hadoop2.7.4。安裝方法請檢視阿里雲安裝hadoop教程_完全分散式_Hadoop2.7.4_Centos7.4。

使用scala-2.11.8及spark-2.2.0。主節點命名為master,從節點命名為node1。

二、安裝scala

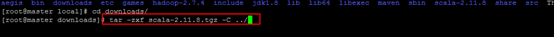

解壓檔案到指定目錄

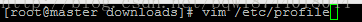

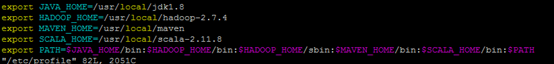

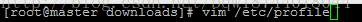

配置環境變數

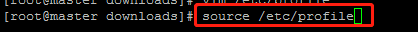

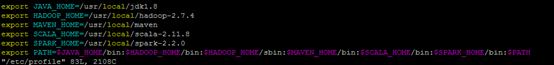

使配置的環境變數生效

使用scala –version測試安裝是否成功

三、安裝Spark

解壓檔案到指定目錄

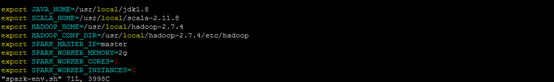

配置環境變數

使配置的環境變數生效

使用pyspark測試安裝是否成功,如果進入到shell中則安裝成功

四、配置spark

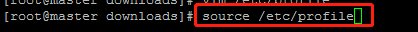

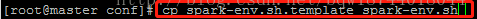

切換目錄

拷貝一份spark-env.sh.template並命名為spark-env.sh

編輯spark-env.sh

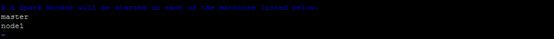

拷貝一份slaves.template並命名為slaves

編輯slaves

注:將上述的spark-env.sh及slaves檔案拷貝一份到node1對應的目錄下

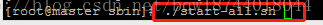

五、啟動程序

進入sbin目錄並執行start-all.sh

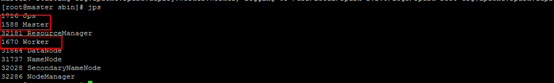

使用jps檢視結果,如果包含了Master程序和Worker程序,那麼說明程序啟動成功。