Mac 配置Spark環境scala+python版本(Spark1.6.0)

1. 從官網下載Spark安裝包,解壓到自己的安裝目錄下(預設已經安裝好JDK,JDK安裝可自行查詢); spark官網:http://spark.apache.org/downloads.html

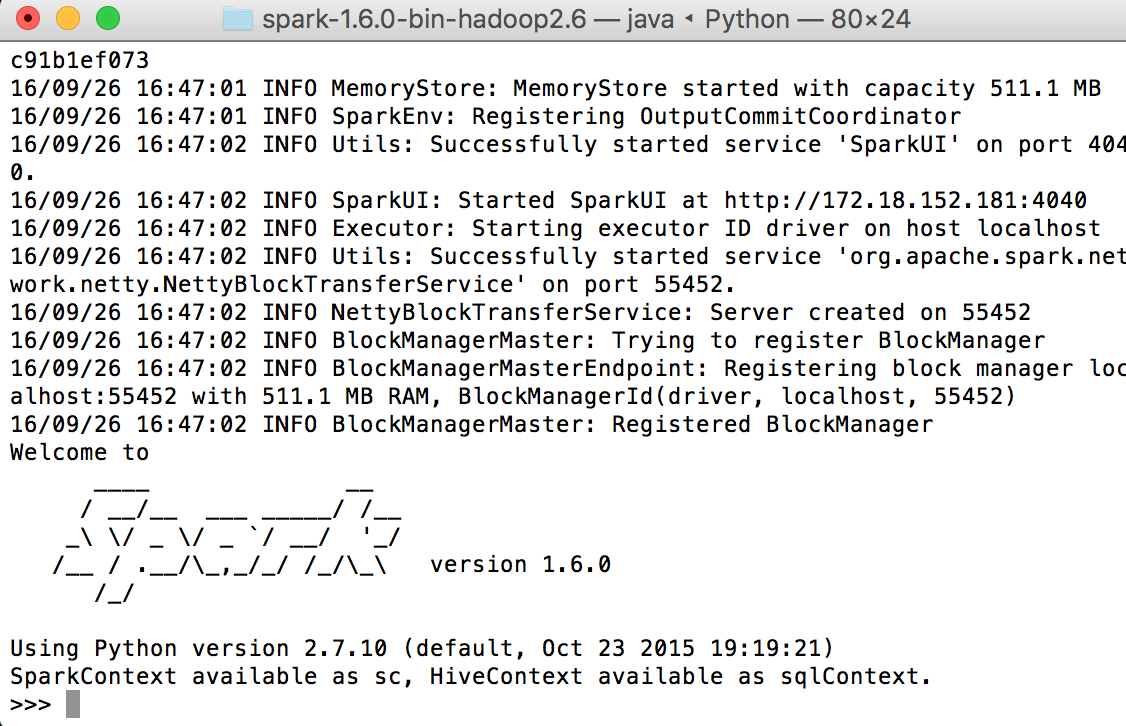

2. 進入系統命令列介面,進入安裝目錄下,如"/安裝目錄/spark-1.6.0-bin-hadoop-2.6.0 ",輸入命令"./bin/pyspark"驗證pyspark能否執行,再輸入命令“./bin/spark-shell”,檢視scala環境能否執行。成功的話會顯示Spark圖形,並能輸入python或scala命令列。如下圖(python版):

3. 對於python版,先下載pycharm,點選完成安裝。新建一個工程,開啟Edit configuration,找到Environment variables,點選後面的編輯框,在變數欄目中依次新增PYTHONPATH,值為spark目錄/python,SPARK_HOMR,值為spark安裝目錄,點ok退出。

4. 如果是用python的話還要下載py4j包,用在命令列輸入“easy_install py4j”命令就行。然後進入spark安裝目錄中的python資料夾下,開啟lib資料夾,把裡面的py4j壓縮包複製到上一級python資料夾下,解壓。

5. 在pycharm中寫好demo,點選執行即可。demo示例如下:

"""SimpleApp.py"""

from pyspark import SparkContext

logFile = "/Spark/spark-1.6.0-bin-hadoop2.6/README.md" # Should be some file on your system

sc = SparkContext("local", "Simple App")

logData = sc.textFile(logFile).cache()

numAs = logData.filter(lambda s: 'a' in s).count()

numBs = logData.filter(lambda s: 'b' in s).count()

print("Lines with a: %i, lines with b: %i" % (numAs, numBs))

6. 如果用scala環境,那麼需要下載IntelliJ IDEA,和Pycharm是同一個公司出品,直接去搜名字去官網下 免費版。在第一次開啟時會提示安裝外掛,這時候選擇安裝scala外掛,spark1.6對應scala2.10版本,大概47M。外掛下載好之後就可以新建一個scala工程。

7. 單擊Intellij IDE選單欄上File選項,選擇Project Structure,在彈出的對話方塊中單擊左側Libraries,之後單擊中間上方綠色“+”號,新增spark中的lib資料夾下的assembly jar包,點選應用。

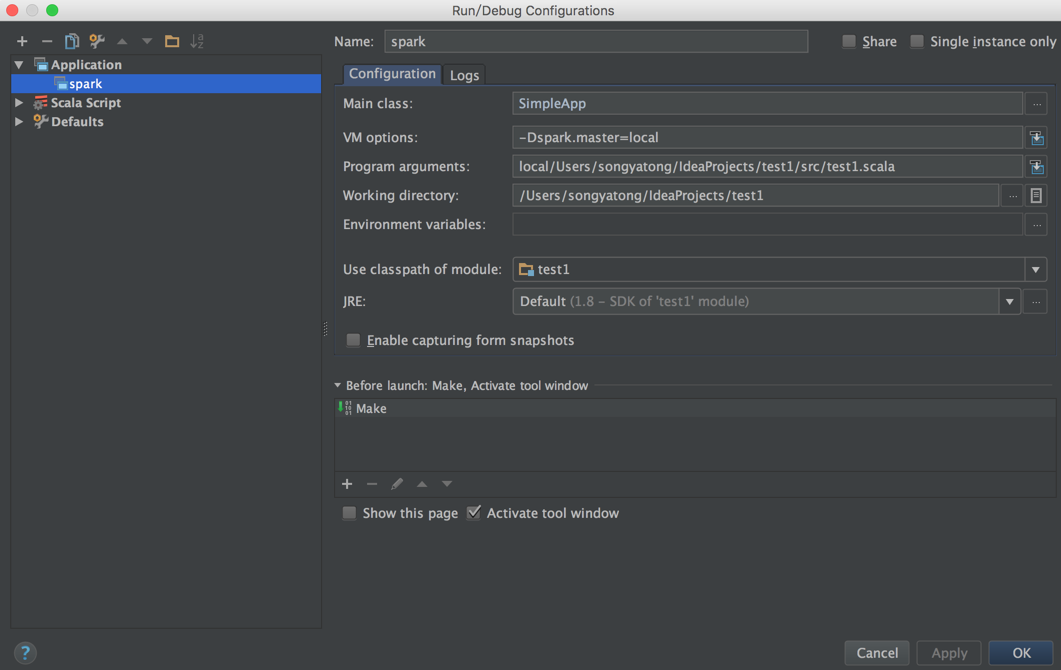

8. 然後從Spark官網上找一個demo,把裡面的spark路徑換成自己的。開啟Edit configuration,點選左上角加號,選擇Application,進入設定執行配置的對話方塊,按照下圖配置,其中Program arguments手動輸入local,然後右鍵選擇main 函式地址,系統會自動新增。VM options 的值是設定單機執行,不設定會報錯。

9. 點選ok完成配置,執行程式即可。