重學 Statistics, Cha16 General Linear Model

Curvilnear Relationship

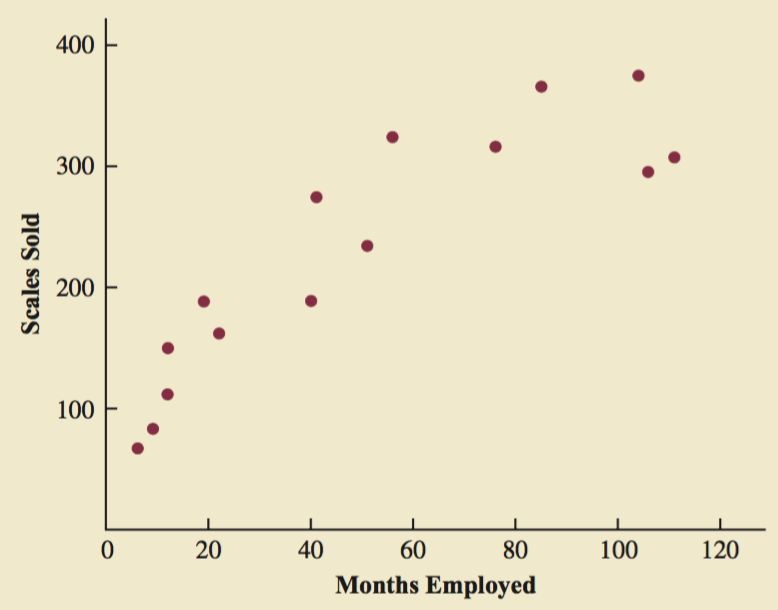

當我們用 scatter diagram 來看的時候,發現 x y 的關係不完全是一條直線

另外把 residual 和 y 做一個 plot,也看到,是一個弧形的:

所以,我們用二次模型, second order model. 結果就比較好,r square 也高。

Interaction

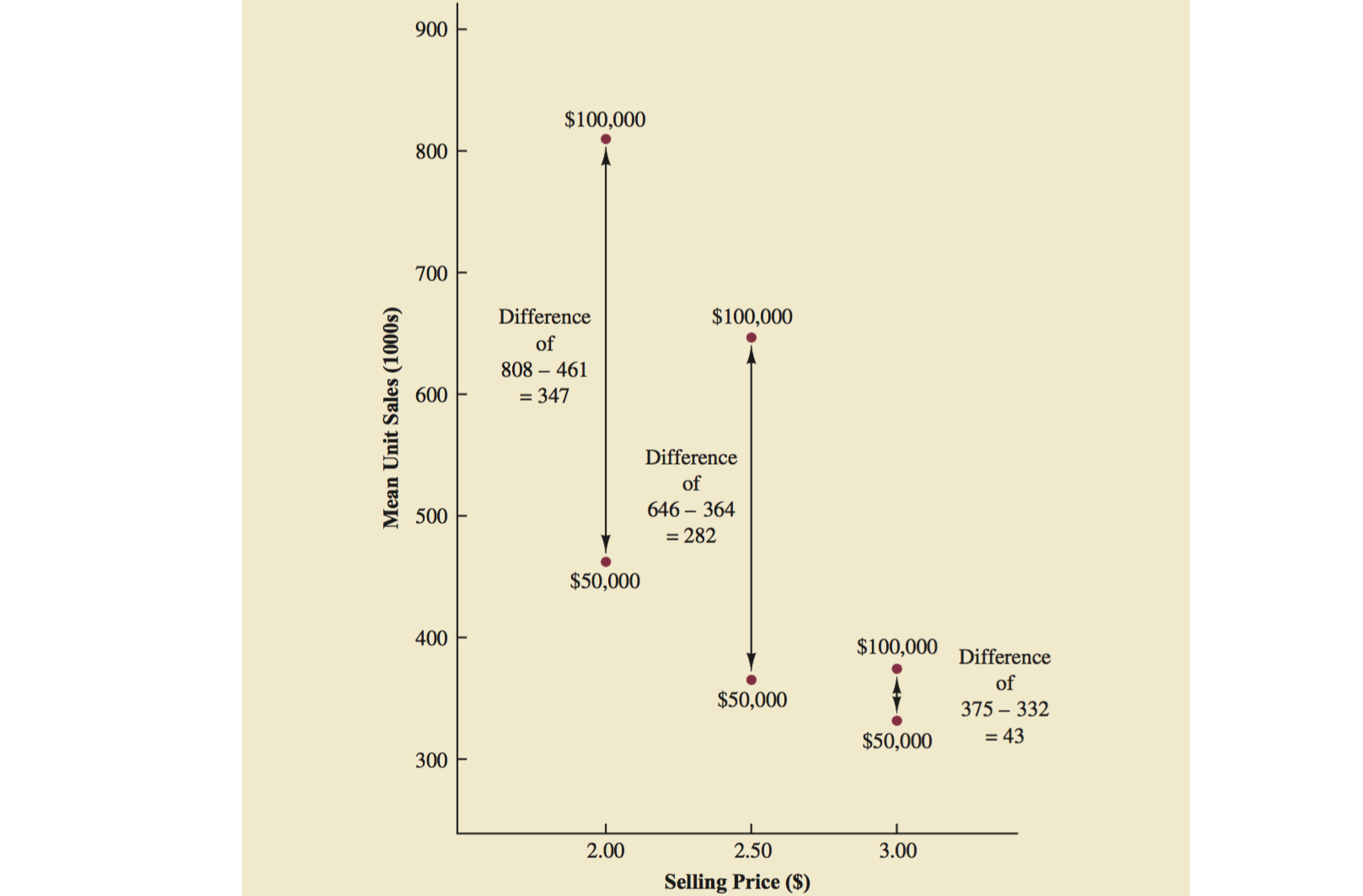

怎麼發現 x1 和 x2 之間有 interaction?

我們發現:廣告花費 50000和100000所產生的平均銷售區別,依賴於產品的價格。

在更高的價格,增加廣告花費所帶來的銷售變化更小。

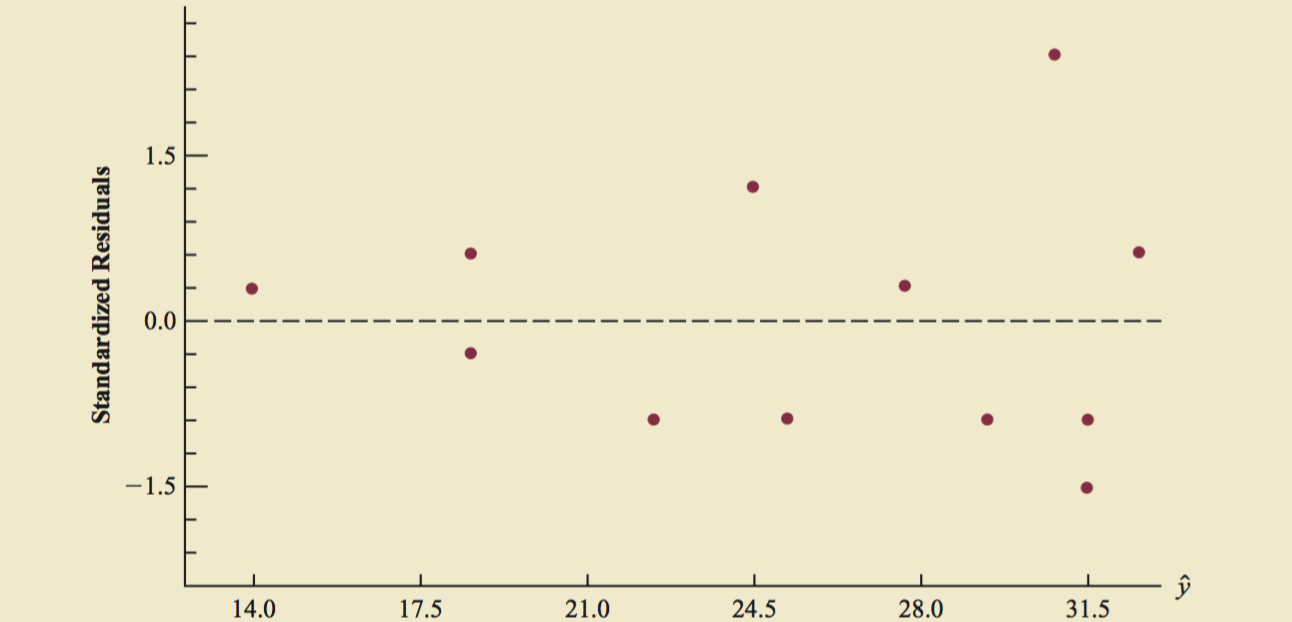

Transformation involving dependent variable

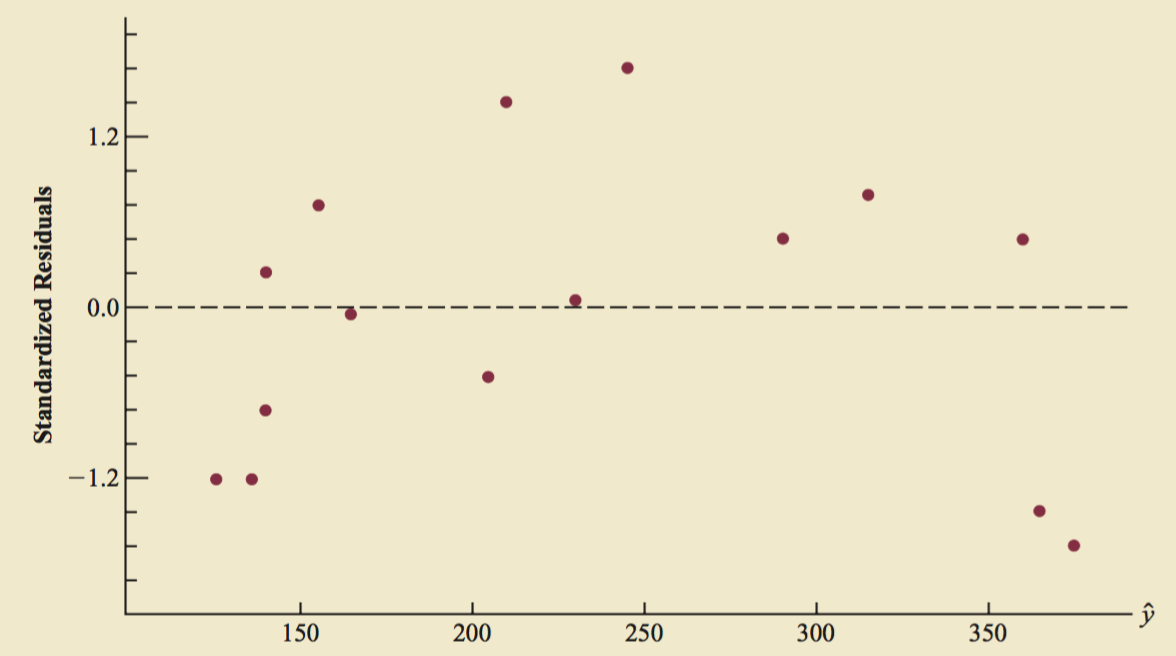

當我們用正常的 regression 得到的式子,發現:standardized residuals 和 y 畫出來的圖是一個三角形:

The variability in the residuals appears to increase as the value of y increase.

Problem : Nonconstant variance

If we work with the logarithm of the dependent variable instead of the original dependent variable, the effect will be to compress the values of the dependent variable and thus diminish the effects of nonconstant variance.

用因變數的對數代替原來的因變數,這樣做的效果是壓縮了因變數的數量,從而達到減少非常數方差的影響。

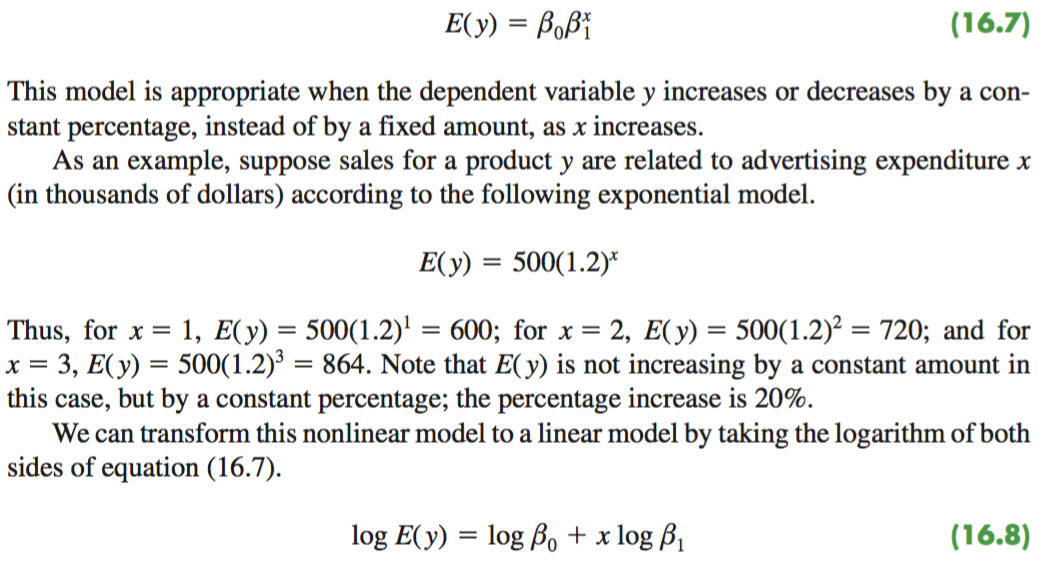

Nonlinear Model 用 linear 來做

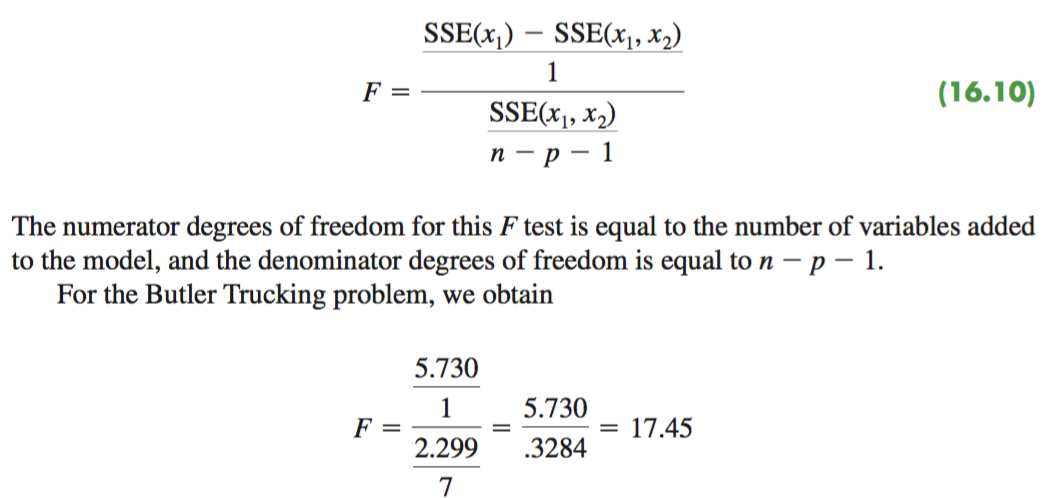

16.2 Determining when to add or delete variables

問題: Does adding the variable x2 lead to a significant reduction in SSE?

Variable Selection Procedures

- Stepwise Regression

- 看現在 model 裡面,delete 哪一個。 If the p-value for any inependent variable is greater than Alpha to remove, the independent variable with the largest p-value is removed from the model and the stepwise regression procedure begins a new step.

- 從未在 model 中,候選的變數選一個 p-value 最低的,但是要小區 Alpha to enter. It does so by first computing an F statistic and corresponding p-value for each independent variable that is not in the model.

問題:怎麼一個個新增 Variable,用 f test 來做?

- Forward Regression

- Variables 一個個進入,進入的條件和 stepwise 一樣

- 但是進去了之後就不會再考察了,進去之後不會再出來

- Backward Regression

- Variables 先全部進去,一個個剔除,剔除的條件和 stepwise 一樣

- 剔除了之後,就不會再出來了

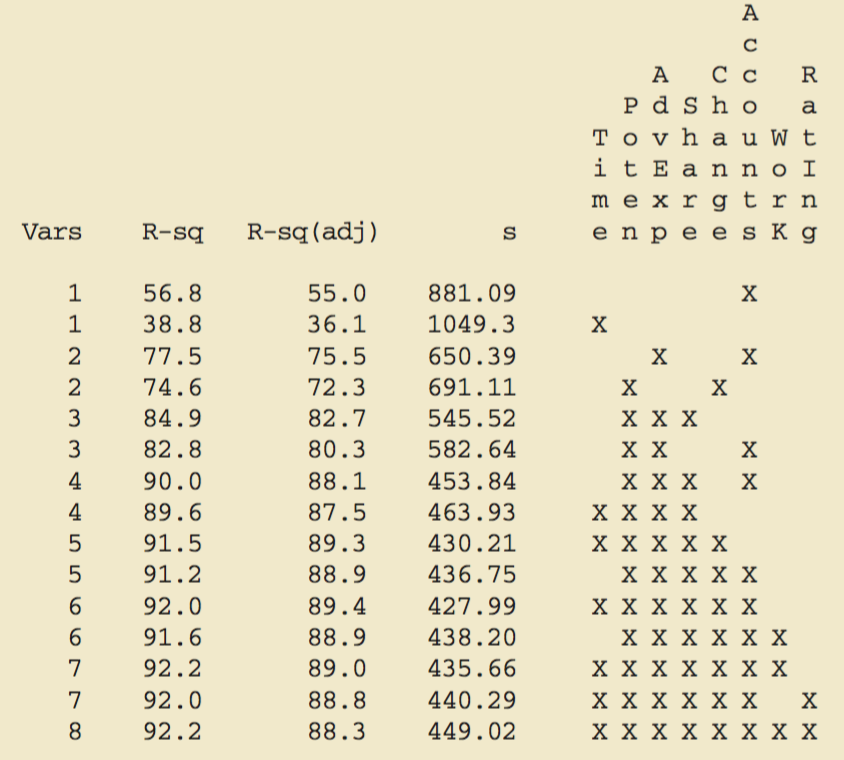

- Best-subsets Regression

- 把所有 model 都列出來

- 把所有 model 都列出來

雖然6個的有最高的 r square, 但是 a simpler model with fewer variables is usually preferred. 所以選4個 Variables, r-sq 是88.1%的那個。