Zookeeper和分散式環境中的假死腦裂問題(轉發)

阿新 • • 發佈:2019-02-18

最近和同事聊天無意間發現他們的系統也存在腦裂的問題。想想當初在我們的系統中為了解決腦裂花了非常大的功夫,現在和大家一起討論下腦裂,假死等等這些問題和解決的方法。

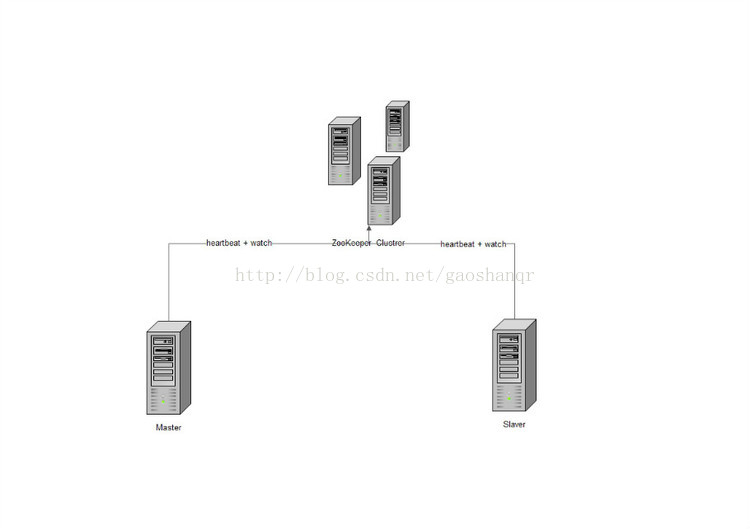

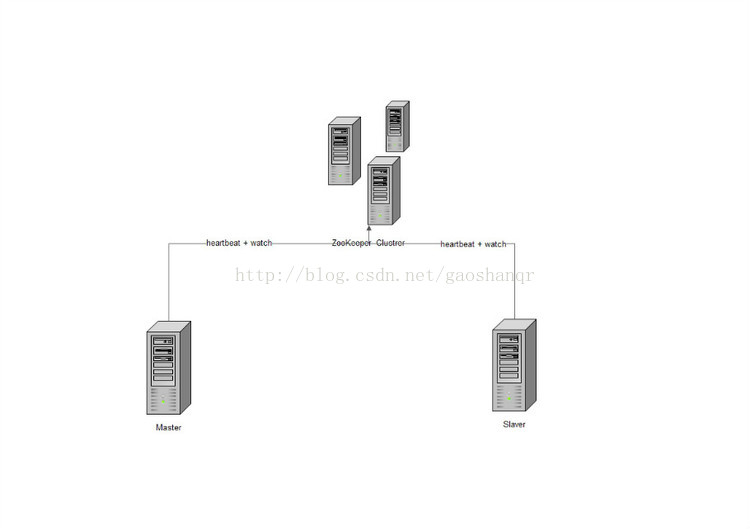

在一個大叢集中往往會有一個master存在,在長期執行過程中不可避免的會出現宕機等問題導致master不可用,在出現這樣的情況以後往往會對系統產生很大的影響,所以一般的分散式叢集中的master都採用了高可用的解決方案來避免這樣的情況發生。

master-slaver方式,存在一個master節點,平時對外服務,同時有一個slaver節點,監控著master,同時有某種方式來進行資料的同步。如果在master掛掉以後slaver能很快獲知並迅速切換成為新的master。在以往master-slaver的監控切換是個很大的難題,但是現在有了Zookeeper的話能比較優雅的解決這一類問題。