1 自然語言處理中文語料與詞彙資源從哪裡獲取

按照網上大神的自己動手做聊天機器人教材來一步步學習,在邊學的時候,一邊總結,一邊思考提問,對後續自己做機器學習人應該會有幫助。

自己動手做聊天機器人 三-語料與詞彙資源這裡面介紹的英文的語料庫,我們中國的語料庫就得自己找找了

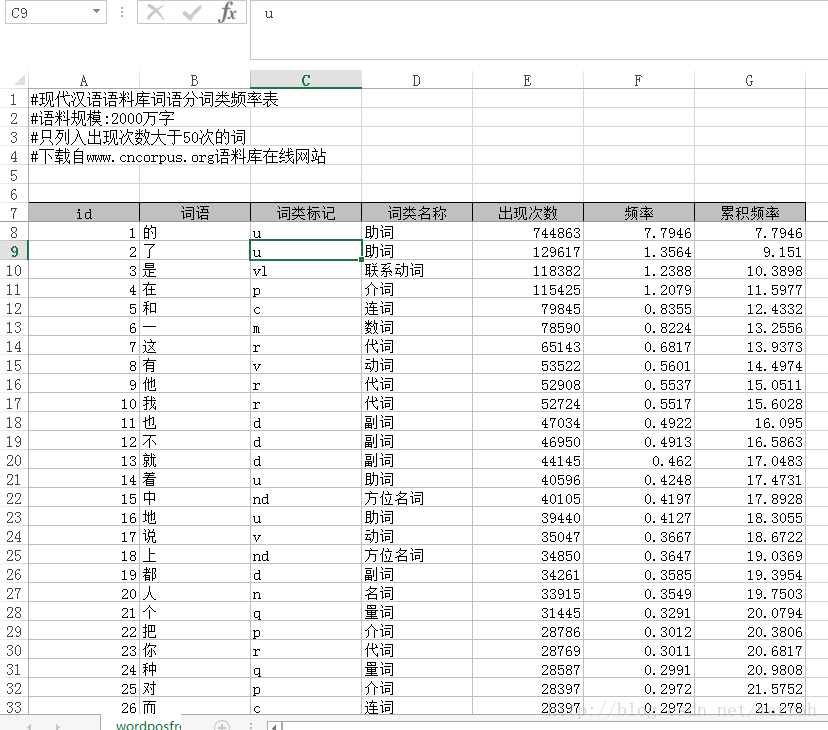

國家語委現代漢語語料庫,這資料裡面現代漢語的常見字,以及字使用的頻率。下圖是下載後的一個表格,將詞語的詞類和詞類英文標記標註清楚了。標準是按照資訊處理用現代漢語詞類標記規範

下面這個資料比較全,國內可外用免費語料庫下載資源彙總

資源有些可以下載,有些不能,我沒有統計,接下來需要思考,這些資源在自然語言處理中怎麼用呢?

相關推薦

1 自然語言處理中文語料與詞彙資源從哪裡獲取

按照網上大神的自己動手做聊天機器人教材來一步步學習,在邊學的時候,一邊總結,一邊思考提問,對後續自己做機器學習人應該會有幫助。 自己動手做聊天機器人 三-語料與詞彙資源這裡面介紹的英文的語料庫,我們中

1.自然語言處理(NLP)與Python

自然語言工具包(NLTK) NLTK 創建於 2001 年,最初是賓州大學計算機與資訊科學系計算語言學課程的一部分 。從那以後,在數十名貢獻者的幫助下不斷髮展壯大。如今,它已被幾十所大學的課程所採納 ,並作為許多研究專案的基礎。NLTK模組及功能介紹如下:

自然語言處理相關技術與任務簡介

更多學習筆記關注: 公眾號:StudyForAI 知乎專欄:https://www.zhihu.com/people/yuquanle/columns 自然語言處理(NLP)是人工智慧的一個重要應用領域,由於本人主要研究方向為NLP,也由於最近學習的需要,特意蒐羅資料,整理了

自然語言處理——中文分詞原理及分詞工具介紹

本文首先介紹下中文分詞的基本原理,然後介紹下國內比較流行的中文分詞工具,如jieba、SnowNLP、THULAC、NLPIR,上述分詞工具都已經在github上開源,後續也會附上github連結,以供參考。 1.中文分詞原理介紹 1.1 中文分詞概述 中文分詞(Chinese Word Seg

自然語言處理-中文分詞方法總結

中文分詞是中文文字處理的一個基礎步驟,也是中文人機自然語言互動的基礎模組。不同於英文的是,中文句子中沒有詞的界限,因此在進行中文自然語言處理時,通常需要先進行分詞,分詞效果將直接影響詞性、句法樹等模組的效果。當然分詞只是一個工具,場景不同,要求也不同。前人做的工

基於python的自然語言處理 分類和標註詞彙之5.5N-gram標註

一元標註器unigram tagging一元標註器利用一種簡單的統計演算法,對每個識別符號分配最有可能的標記。建立一元標註器的技術稱為訓練。>>> fromnltk.corpus import brown>>> importnltk>

Python自然語言處理------分類和標註詞彙

寫在前面一篇讀書筆記。1. 使用詞性標註器將詞彙按它們的詞性(parts-of-speech,POS)分類以及相應的標註它們的過程被稱為詞性標註(part-of-speech tagging, POS tagging)或乾脆簡稱標註。詞性也稱為詞類或詞彙範疇。用於特定任務的標

自然語言處理--中文分詞之機械分詞

說到自然語言處理,對於中文首當其衝的就是分詞。 和西方語言不同,中文句子中不像英語,每個單詞間有空格隔開,而是全部連在一起,詞間沒有明顯的界限。這就為我們的翻譯、檢索等等更高階的資訊處理帶來了不小的麻煩,怎樣將一句話中的關鍵詞提取出來,便成為了中文資訊處理首先要

自然語言處理領域重要論文&資源全索引

自然語言處理(NLP)是人工智慧研究中極具挑戰的一個分支。隨著深度學習等技術的引入,NLP 領域正在以前所未有的速度向前發展。但對於初學者來說,這一領域目前有哪些研究和資源是必讀的?最近,Kyubyong Park 為我們整理了一份完整列表。 GitHub 專案連結:https:/

自然語言處理相關書籍及其他資源

二、課件: 1、哈工大劉挺老師的“統計自然語言處理”課件; 2、哈工大劉秉權老師的“自然語言處理”課件; 3、中科院計算所劉群老師的“計算語言學講義“課件; 4、中科院自動化所宗成慶老師的“自然語言理解”課件; 5、北大常寶寶老師的“計算語言學”課件; 6、北大詹衛東老師的“中文資訊處理基礎”的課件及

最好的入門自然語言處理(NLP)的資源清單

Melanie Tosik目前就職於旅遊搜尋公司WayBlazer,她的工作內容是通過自然語言請求來生產個性化旅遊推薦路線。回顧她的學習歷程,她為期望入門自然語言處理的初學者列出了一份學習資源清單。 目錄: · 線上課程 · 圖書館和開放資源 · 活躍的

自然語言處理---用隱馬爾科夫模型(HMM)實現詞性標註---1998年1月份人民日報語料---learn---test---evaluation---Demo---java實現

fileinput 流程 n) 一次 tostring model pen mem rbd 先放上一張Demo的測試圖 測試的句子及每個分詞的詞性標註為: 目前/t 這/rzv 條/q 高速公路/n 之間/f 的/ude1 路段/n 已/d 緊急/a 封閉/v 。/

《NLP漢語自然語言處理原理與實踐》第三章 詞彙與分詞技術

中文分詞的研究經歷了二十多年,基本上可以分為如下三個流派。 1.機械式分詞法(基於字典)。機械分詞的原理是將文件中的字串與詞典中的詞條進行逐一匹配,如果詞典中找到某個字串,則匹配成功,可以切分,否則不予切分。基於詞典的機械分詞法,實現簡單、實用性強,但機械分詞法的最大的缺點是詞典的完備

python自然語言處理——2.1 獲取文字語料庫

微信公眾號:資料運營人本系列為博主的讀書學習筆記,如需轉載請註明出處。 第二章 獲取文字預料和詞彙資源 2.1 獲取文字語料庫古騰堡語料庫網路和聊天文字布朗語料庫路透社語料庫就職演說語料庫標註文字語料庫其他文字語料庫文字語料庫結構 2.1 獲取文字語料庫 一個文字語料庫是一

CS224n-自然語言處理與深度學習簡介1

CS224n-自然語言處理與深度學習簡介1 自然語言處理 自然語言處理 自然語言處理的目標是讓計算機能夠“理解”自然語言,代替人去做一些有意義的事,比如,聊天機器人,機器翻譯等。 想要理解自然語言很難,人類語言是離散的、明確的符號系統,但又有

【讀書筆記】《Python自然語言處理》第1章 語言處理與Python

1.1 語言計算:文字和詞彙 入門 nltk下載地址 使用pip安裝 >>>import nltk 檢驗是否成功。 >>>nltk.download() 選擇語料下載 使用python直譯器載入book模組中的條目 >&g

python與自然語言處理(五):中文文字詞雲

之前一直想要做一個文字的視覺化:詞雲,然後在網上搜到的一些製作詞雲的工具,有些是線上的就沒有使用,今天偶然看到python提供的wordcloud庫,可以方便製作詞雲,中英文皆可,趕緊試試,做個筆記,

自然語言處理與中文分詞的難點總結

中文自動分詞 指的是使用計算機自動對中文文字進行詞語的切分,即像英文那樣使得中文句子中的詞之間有空格以標識。中文自動分詞被認為是中文自然語言處理中的一個最基本的環節。 中文分詞的難點 · 未登入詞,基於詞庫的分詞方法往往不能識別新詞、特定領域的專有詞。人名、機構名、

《用Python進行自然語言處理》第 1 章 語言處理與 Python

1. 將簡單的程式與大量的文字結合起來,我們能實現什麼?2. 我們如何能自動提取概括文字風格和內容的關鍵詞和短語?3. Python 程式語言為上述工作提供了哪些工具和技術?4. 自然語言處理中的有哪些有趣的挑戰?1.1 語言計算:文字和單詞python入門NLTK 入門fr

python與自然語言處理(六):中文文字轉影象

最近使用word2vec對文字進行向量化表示,然後模仿基於CNN的影象分類實現文字分類。既然是模仿影象,那就應該可以將文字用影象視覺化一下,看看量化後的文字是什麼樣子。python處理影象的基本模組是Image庫,由於實驗中使用的是python3,需要安裝的影象處理庫為Pil