如何在java中去除中文文字的停用詞

1. 整體思路

第一步:先將中文文字進行分詞,這裡使用的HanLP-漢語言處理包進行中文文字分詞。

第二步:使用停用詞表,去除分好的詞中的停用詞。

2. 中文文字分詞環境配置

使用的HanLP-漢語言處理包進行中文文字分詞。

·HanLP-漢語言處理包下載,可以去github上下載

·HanLP 的環境配置有兩種方式:方式一、Maven;方式二、下載jar、data、hanlp.properties。

·官方環境配置步驟也可以在github上查詢到。

·環境配置好後,java使用HanLP進行中文分詞文件如下:hanlp.linrunsoft.com/doc.html

3. 下載停用詞表

停用詞表可以去百度或者其他搜尋引擎檢索一份,很容易就找到!

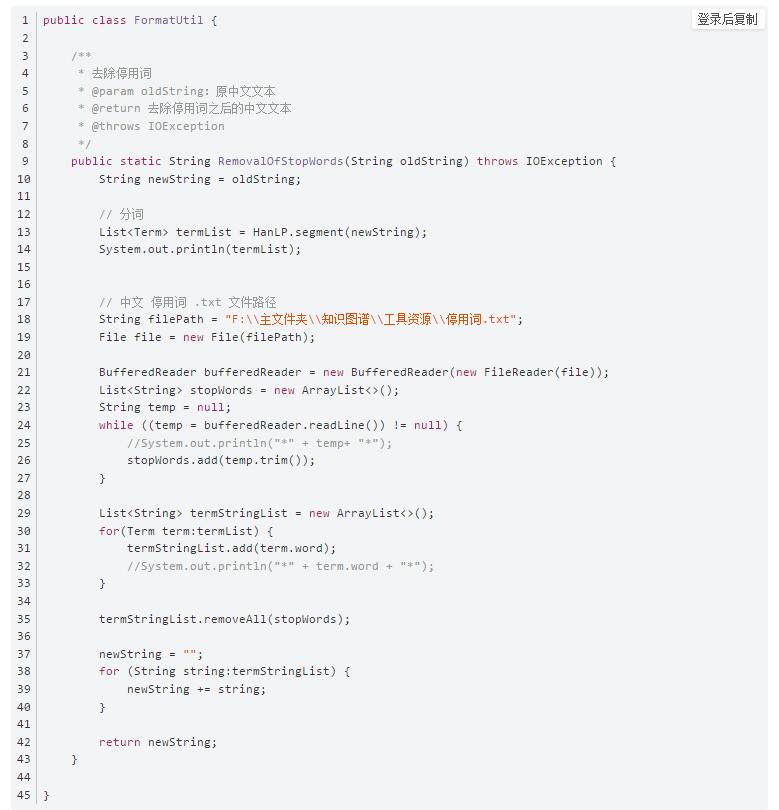

4. 去除停用詞工具類

使用這個工具類的之前,請先完成中文文字分詞環境配置,並測試一下。停用詞 .txt 檔案路徑請修改為自己的本地路徑。

圖1

5. 工具類測試

5.1 測試程式碼

public class test {

public static void main(String args[]) {

try {

System.out.println(FormatUtil.RemovalOfStopWords("床前明月光,疑是地上霜。舉頭望明月,低頭思故鄉。"));

} catch (IOException e) {

e.printStackTrace();

}

}

5.2 測試結果

相關推薦

如何在java中去除中文文字的停用詞

1. 整體思路 第一步:先將中文文字進行分詞,這裡使用的HanLP-漢語言處理包進行中文文字分詞。 第二步:使用停

利用java實現對文字的去除停用詞以及分詞處理

功能: 對txt文件進行分詞處理,並去除停用詞。 工具: IDEA,java,hankcs.hanlp.seg.common.Term等庫。 程式: import java.util.*; import java.io.*; import java.lang.String; imp

【java HanNLP】HanNLP 利用java實現對文字的去除停用詞以及分詞處理

HanNLP 功能很強大,利用它去停用詞,加入使用者自定義詞庫,中文分詞等,計算分詞後去重的個數、 maven pom.xml 匯入 <dependency> <groupId>com.hankcs</g

php 去除常見中文停用詞(過濾敏感詞)

在用sphinx通過文章標題匹配相關文章時,去除停用詞後調出的文章相關性更好。 <?php header("Content-type:text/html;charset=utf-8"); $str = file_get_contents('stop.txt');//將常見中文停用詞表內容讀入

使用IKAnalyzer實現中文分詞&去除中文停用詞

1、簡介:IKAnalyzer是一個開源的,基於java語言開發的輕量級的中文分詞工具包。這裡使用的是IKAnalyzer2012。 2、IK Analyzer 2012特性: (1)採用了特有的“正向迭代最細粒度切分演算法“,支援細粒度和智慧分詞兩種切分模式; (2)在

es中的停用詞

其他 搜索 last 高頻 包含 代碼 標簽 score 大小 停用詞主要是為了提升性能與精度。從早期的信息檢索到如今,我們已習慣於磁盤空間和內存被限制為很小一部分,所以 必須使你的索引盡可能小。 每個字節都意味著巨大的性能提升。 詞幹提取的重要性不僅是因為它讓搜索的內容更

python使用jieba實現中文文檔分詞和去停用詞

分享圖片 lac lena idt center cut inpu span code 分詞工具的選擇: 現在對於中文分詞,分詞工具有很多種,比如說:jieba分詞、thulac、SnowNLP等。在這篇文檔中,筆者使用的jieba分詞,並且基於python3環境,選擇

使用jieba分詞並去除停用詞流程程式

準備工作 ① 構建未分詞檔案、已分詞檔案兩個資料夾,將未分詞資料夾按類目定義檔名,各個類目的資料夾下可放置多個需要分詞的檔案。 ② 準備一份停用詞(jieba自身應該是沒有停用詞的) ③ 根據業務需要自定義詞典(此處使用jieba自帶字典) 分詞去停詞.py

【Python】中文分詞並過濾停用詞

中文分詞並過濾停用詞,python程式碼如下。 #coding=utf-8 import jieba input_path='../data/train_pos_100.txt' output_path='../data/train_pos_100_seg.txt' st

python 去除停用詞 結巴分詞

#coding:gbk import jieba #stopwords = {}.fromkeys([ line.rstrip() for line in open('stopword.txt') ]) stopwords = {}.fromkeys(['的', '附近']) segs =

jieba 去除停用詞、提取關鍵詞、詞性標註

#-*- coding:utf-8 -*- import sys import jieba import os import jieba.analyse import string import ma

Python進行文字預處理(文字分詞,過濾停用詞,詞頻統計,特徵選擇,文字表示)

系統:win7 32位 分詞軟體:PyNLPIR 整合開發環境(IDE):Pycharm 功能:實現多級文字預處理全過程,包括文字分詞,過濾停用詞,詞頻統計,特徵選擇,文字表示,並將結果匯出為WEKA能夠處理的.arff格式。 直接上程式碼: #!/usr/bin/

3h: 中文 前處理4:斷句 前處理8:標點清洗 前處理12:停用詞清洗

0.讀取檔案的處理辦法# encoding: UTF-8 import re fileBefPro=open('E:\\dataMining\\data.txt') fileAftPro=open('E:\\dataMining\\after.txt','a') it

使用TfidfVectorizer並且不去掉停用詞的條件下,對文字特徵進行量化的樸素貝葉斯分類效能測試

from sklearn.datasets import fetch_20newsgroups news = fetch_20newsgroups() from sklearn.model_selection import train_test_split x_train

中文分詞與停用詞的作用

首先什麼是中文分詞stop word? 英文是以詞為單位的,詞和詞之間是靠空格隔開,而中文是以字為單位,句子中所有的字連起來才能描述一個意思。例如,英文句子I am a student,用中文則為:“我是一個學生”。計算機可以很簡單通過空格知道studen

Java過濾停用詞原始碼

package SimilarityCompution; import Java.io.BufferedReader; import java.io.BufferedWriter; import java.io.File; import java.io.FileInputStream; impo

多版本中文停用詞詞表 + 多版本英文停用詞詞表 + python詞表合併程式

文章簡介與更新記錄 如果你只想獲取中文停用詞此表,請直接到文章結尾下載專案檔案,其中包括三個中文停用詞詞表,一個英文停用詞詞表和一個合併詞表的.py檔案 2017/07/04 建立文章,上傳檔案 2017/07/04 更新了合併程式碼,添加了新的中文停用詞

ES 實現實時從Mysql資料庫中讀取熱詞,停用詞

IK分詞器雖然自帶詞庫 但是在實際開發應用中對於詞庫的靈活度的要求是遠遠不夠的,IK分詞器雖然配置檔案中能新增擴充套件詞庫,但是需要重啟ES 這章就當寫一篇擴充套件了 其實IK本身是支援熱更新詞庫的,但是需要我感覺不是很好 詞庫熱更新方案: 1:IK&n

Java中的中文亂碼問題

jsp req 安裝路徑 漢字 mysql配置文件 rac name line 進行 客戶端向服務器發送請求時,有兩種方式post和get請求,當客戶端提交的內容有中文時。服務器要進行設置才能獲得中文,否則獲得的是亂碼。那麽怎麽設置呢:在servlet中進行設置,有兩種情

Java中RMI遠程調用demo

exp 通過 實現 light interface 程序員 eth 消息 編程 Java遠程方法調用,即Java RMI(Java Remote Method Invocation),一種用於實現遠程過程調用的應用程序編程接口。它使客戶機上運行的程序可以調用遠程服務器上的對