容器雲未來:Kubernetes、Istio 和 Knative

導讀

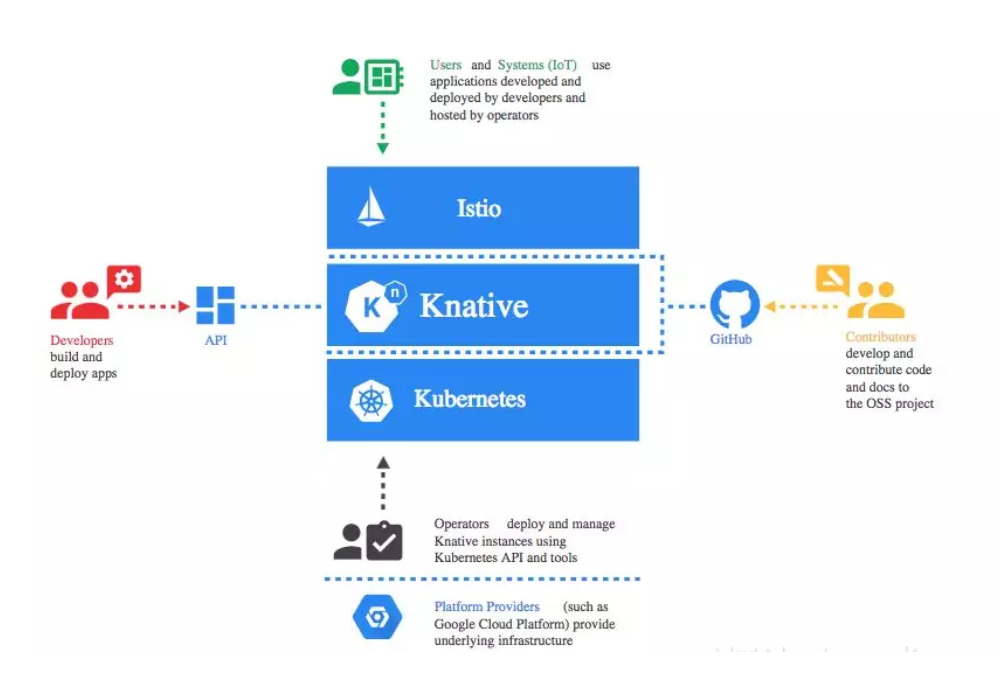

目前以Kubernetes為基礎構建的容器生態逐漸完善,這其中Kubernetes、Istio、Knative三個獨立專案被越來越多的人提及,並且已經開始嘗試大規模落地實踐,它們恰好構成了容器雲的未來拼圖。今天與大家一起分享下,這三個專案究竟解決了什麼問題,為什麼它們能夠一鳴驚人。

隨著微服務理念不斷深入人心,越來越多的企業把自己的應用逐步由單體轉變成微服務架構,Container容器技術的出現恰恰加速了這個轉移過程,因為它有效地解決了N多服務的快速部署問題。但是隨著服務數目的增多,越來越多的企業希望能夠把相關服務有效地“聚合”在一起,方便統一部署與管理。Kubenretes的出現恰恰解決了大規模微服務編排部署所帶來的挑戰,讓整個行業意識到PaaS的落地可以成為現實。

當隨著微服務體系下的服務數目越來越多,服務運維成為必然要解決的問題,於是Istio出現了,基於網路代理與控制相分離的實現策略,允許對服務控制策略進行有效合理的管控。

到這裡似乎到了很美好的階段:

-

微服務:解決應用內聚、臃腫的問題。

-

Container:解決服務執行環境統一,和部署問題。

-

Kubernetes:解決大量微服務有效“聚合”部署問題。

-

Istio:解決服務上線面臨的一系列治理問題。

這個階段乍一看來,構建容器雲似乎有了一個完整的鏈路和解決方式,一切都將變得那麼“完美”。

現在讓我們回過頭來深入分析一下,微服務體系下的服務互動,目前是否存在問題。

首先,無論是http,還是rpc,本質上都是服務與服務的遠端呼叫。開發應用程式中,無法做到服務與服務間的彼此透明。這樣會導致一個問題:無論微服務業務拆分多麼“精細”,本質上業務單元之間還是不能夠獨立執行和發展。同時在面向不同開發領域的衍生,無法選擇最合適的實現方式。因此我們希望能夠基於不同的“模板”+“配置”的方式能夠把開發環境標準化處理,同時提供“事件”機制,將服務與服務互動的耦合度降到最低。

其次,服務線上執行的動態伸縮問題。當下kubernetes環境下的彈性伸縮,需要由客戶蒐集監測資料,並自主手動來實現,但是我們更希望服務線上能夠更加自動化和智慧化。

最後,服務標準化問題。我們希望服務內部的模型是標準的、能夠快速複製和快速構建的;服務通訊是標準的:協議標準,格式標準;執行環境是標準的:快速部署,快速遷移。

Knative的出現恰好解決遠端直接呼叫,服務線上自動管理以及一些列標準化問題。

下面我們來看一下三者的關聯:

Kubernetes和Istio相信大家比較熟悉了,這裡不做過多介紹,有需要的同學可以關注下我們之前釋出的相關文章,這裡我們重點來看一下Knative。

Knative是谷歌開源的serverless架構方案,旨在提供一套簡單易用的serverless方案,把serverless標準化。目前參與的公司主要是Google、Pivotal、IBM、Red Hat,於2018年7月份對外發布,目前處於快速發展階段。

Knative組成

Build

構建系統:把使用者定義的應用構建成容器映象,面向kubernetes的標準化構建,區別於Dockerfile映象構建,重點解決kubernetes環境的構建標準化問題。

Serving

服務系統:利用Istio的部分功能,來配置應用路由,升級以及彈性伸縮。Serving中包括容器生命週期管理,容器外圍物件(service,ingres)生成(恰到好處的把服務例項與訪問統一在一起),監控應用請求,自動彈性負載,並且利用Virtual service和destination配置服務訪問規則。只有這樣才能保證服務呈現一致性以及服務執行自動化管理。

Eventing

事件系統:用於自動完成事件的繫結與觸發。事件系統與直接呼叫最大的區別在於響應式設計,它允許執行服務本身不需要遮蔽了呼叫方與被呼叫方的關係。從而在業務層面能夠實現業務的快速聚合,或許為後續業務編排創新提供事件。

現在我們換一個角度,聚焦應用服務生命週期:

-

Knative 解決應用模板+面向統一環境的標準化構建場景;

-

Kubernetes作為基礎設施,解決應用編排和執行環境場景;

-

Isito作為通訊基礎設施層,保證應用服務執行可檢測、可配置、可追蹤問題。

這三者貫穿應用服務生命週期全過程,容器雲恰恰也是管理應用服務的控制平臺,這就能夠很好地解釋,為什麼Kubernetes,Istio,Knative在未來會成為構建容器雲的三駕馬車。

本文由博雲研究院原創發表,轉載請註明出處。

&n