雲上快速搭建Serverless AI實驗室

阿新 • • 發佈:2019-06-18

Serverless Kubernetes和ACK虛擬節點都已基於ECI提供GPU容器例項功能,讓使用者在雲上低成本快速搭建serverless AI實驗室,使用者無需維護伺服器和GPU基礎執行環境,極大降低AI平臺運維的負擔,顯著提升整體計算效率。

如何使用GPU容器例項

在pod的annotation中指定所需GPU的型別(P4/P100/V100等),同時在resource.limits中指定GPU的個數即可建立GPU容器例項。每個pod獨佔GPU,暫不支援vGPU,GPU例項的收費與ECS GPU型別收費一致,不產生額外費用,目前ECI提供多種規格的GPU型別。(請參考https://help.aliyun.com/document_detail/114581.html

示例

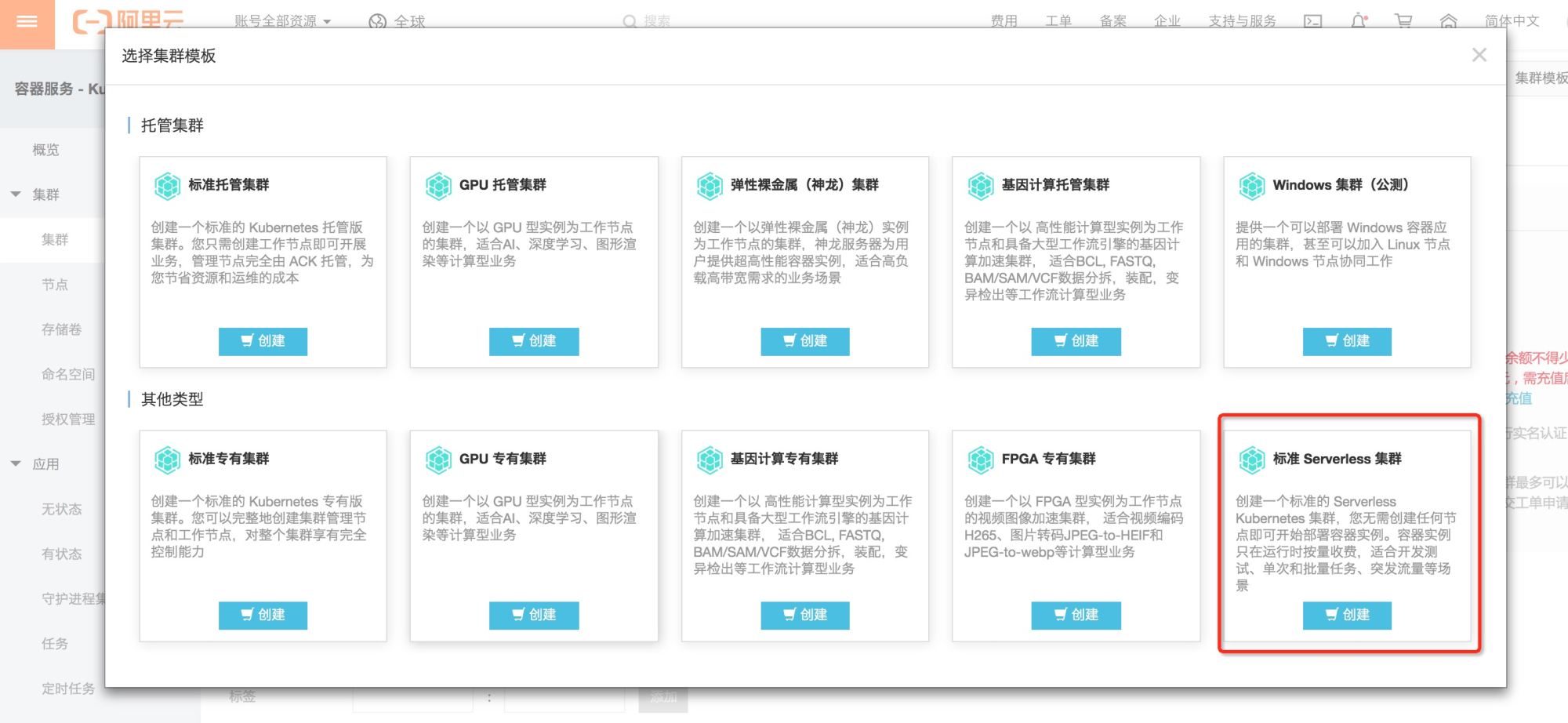

1. 建立Serverless Kubernetes叢集

選擇深圳區域,可用區D。

2. 建立GPU容器例項

我們使用tensorflow模型對如下圖片進行識別:

使用模版建立pod,其中選擇P100 GPU規格。在pod中的指令碼會下載上述圖片檔案,並根據模型進行識別計算。

apiVersion: v1 kind: Pod metadata: name: tensorflow annotations: k8s.aliyun.com/eci-gpu-type : "P100" spec: containers: - image: registry-vpc.cn-shenzhen.aliyuncs.com/ack-serverless/tensorflow name: tensorflow command: - "sh" - "-c" - "python models/tutorials/image/imagenet/classify_image.py" resources: limits: nvidia.com/gpu: "1" restartPolicy: OnFailure

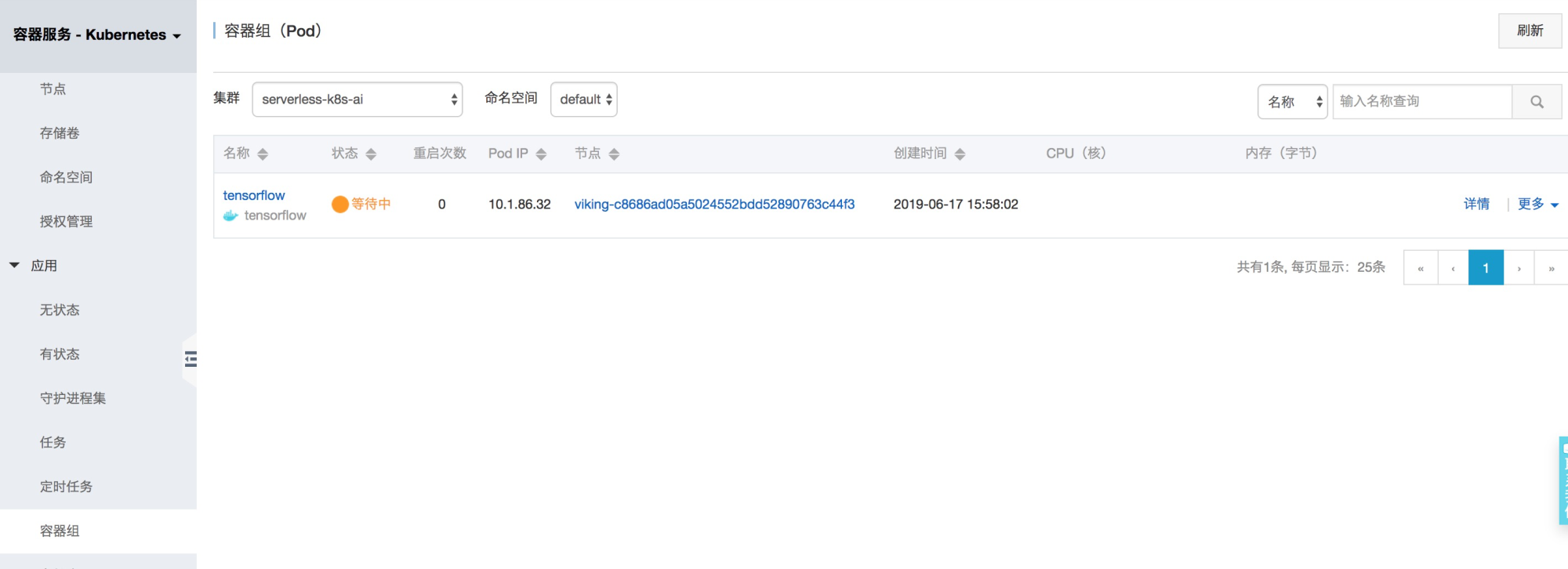

部署後pod會處於pending狀態:

等待幾十秒後pod狀態變成Running,待計算完成後會變成Terminated狀態。

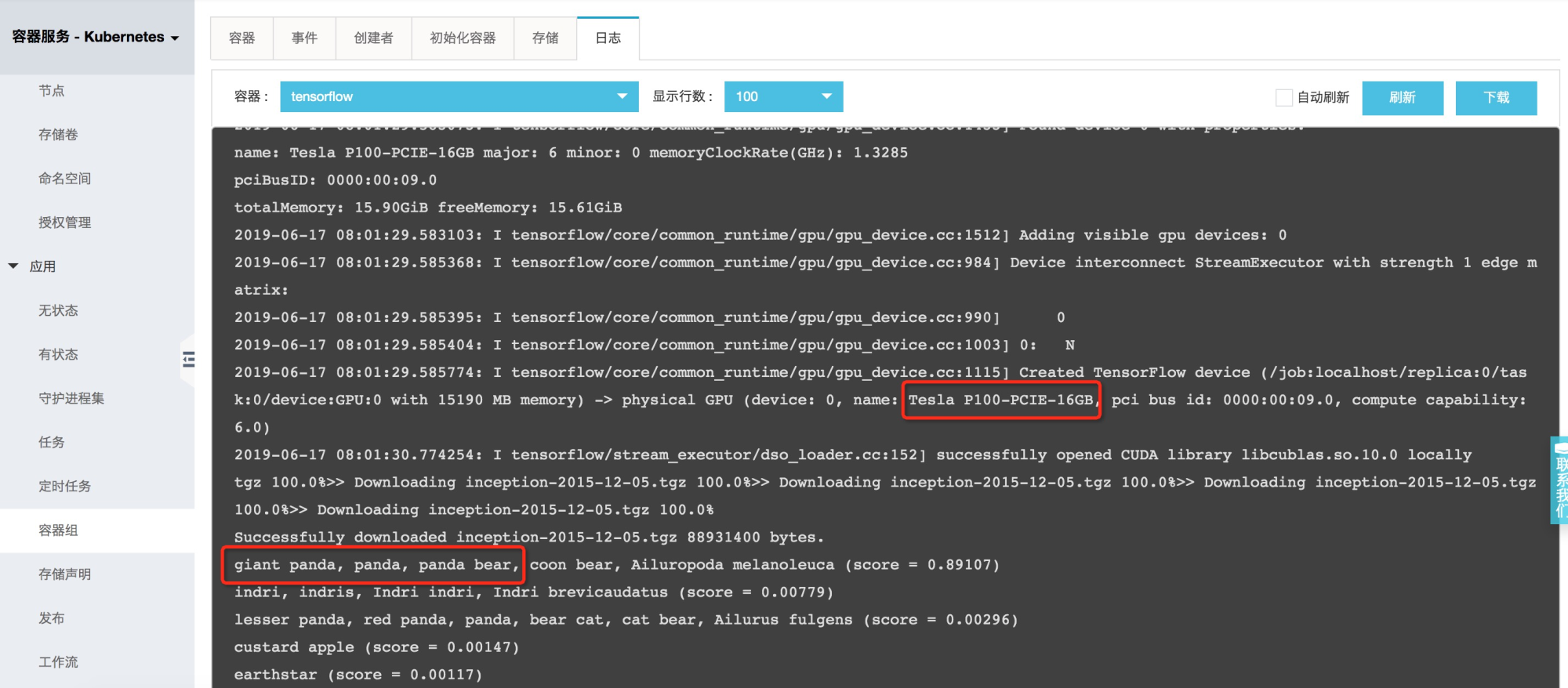

從pod的日誌我們可以看到pod能夠識別P100 GPU硬體,而且可以正確識別圖片為Panda。

總結

通過以上示例可以看出,從環境搭建到計算結束,整個過程使用者無需購買和管理伺服器,無需安裝GPU執行環境,serverless的方式可以讓使用者更加關注在AI模型構建,而不是底層基礎設施的管理和維護。

作者:賢維

原文連結

本文為雲棲社群原創內容,未經