Istio 太複雜?KubeSphere基於Ingress-Nginx實現灰度釋出

在 Bookinfo 微服務的灰度釋出示例 中,KubeSphere 基於 Istio 對 Bookinfo 微服務示例應用實現了灰度釋出。有使用者表示自己的專案還沒有上 Istio,要如何實現灰度釋出?

在 Ingress-Nginx (0.21.0 版本) 中,引入了一個新的 Canary 功能,可用於為閘道器入口配置多個後端服務,還可以使用指定的 annotation 來控制多個後端服務之間的流量分配。 KubeSphere 在 2.0.2 的版本 中,升級了專案閘道器 (Ingress Controller) 版本至 0.24.1,支援基於 Ingress-Nginx 的灰度釋出。

上一篇文章已經對灰度釋出的幾個應用場景進行了詳細介紹,本文將直接介紹和演示基於 KubeSphere 使用應用路由 (Ingress) 和專案閘道器 (Ingress Controller) 實現灰度釋出。

說明: 本文用到的示例 yaml 原始檔及程式碼已上傳至 GitHub,可 clone 至本地方便參考。

Ingress-Nginx Annotation 簡介

KubeSphere 基於 Nginx Ingress Controller 實現了專案的閘道器,作為專案對外的流量入口和專案中各個服務的反向代理。而 Ingress-Nginx 支援配置 Ingress Annotations 來實現不同場景下的灰度釋出和測試,可以滿足金絲雀釋出、藍綠部署與 A/B 測試等業務場景。

Nginx Annotations 支援以下 4 種 Canary 規則:

nginx.ingress.kubernetes.io/canary-by-header:基於 Request Header 的流量切分,適用於灰度釋出以及 A/B 測試。當 Request Header 設定為always時,請求將會被一直髮送到 Canary 版本;當 Request Header 設定為never時,請求不會被髮送到 Canary 入口;對於任何其他 Header 值,將忽略 Header,並通過優先順序將請求與其他金絲雀規則進行優先順序的比較。nginx.ingress.kubernetes.io/canary-by-header-value:要匹配的 Request Header 的值,用於通知 Ingress 將請求路由到 Canary Ingress 中指定的服務。當 Request Header 設定為此值時,它將被路由到 Canary 入口。該規則允許使用者自定義 Request Header 的值,必須與上一個 annotation (即:canary-by-header)一起使用。nginx.ingress.kubernetes.io/canary-weight:基於服務權重的流量切分,適用於藍綠部署,權重範圍 0 - 100 按百分比將請求路由到 Canary Ingress 中指定的服務。權重為 0 意味著該金絲雀規則不會向 Canary 入口的服務傳送任何請求。權重為 100 意味著所有請求都將被髮送到 Canary 入口。nginx.ingress.kubernetes.io/canary-by-cookie:基於 Cookie 的流量切分,適用於灰度釋出與 A/B 測試。用於通知 Ingress 將請求路由到 Canary Ingress 中指定的服務的cookie。當 cookie 值設定為always時,它將被路由到 Canary 入口;當 cookie 值設定為never時,請求不會被髮送到 Canary 入口;對於任何其他值,將忽略 cookie 並將請求與其他金絲雀規則進行優先順序的比較。注意:金絲雀規則按優先順序進行如下排序:

canary-by-header - > canary-by-cookie - > canary-weight

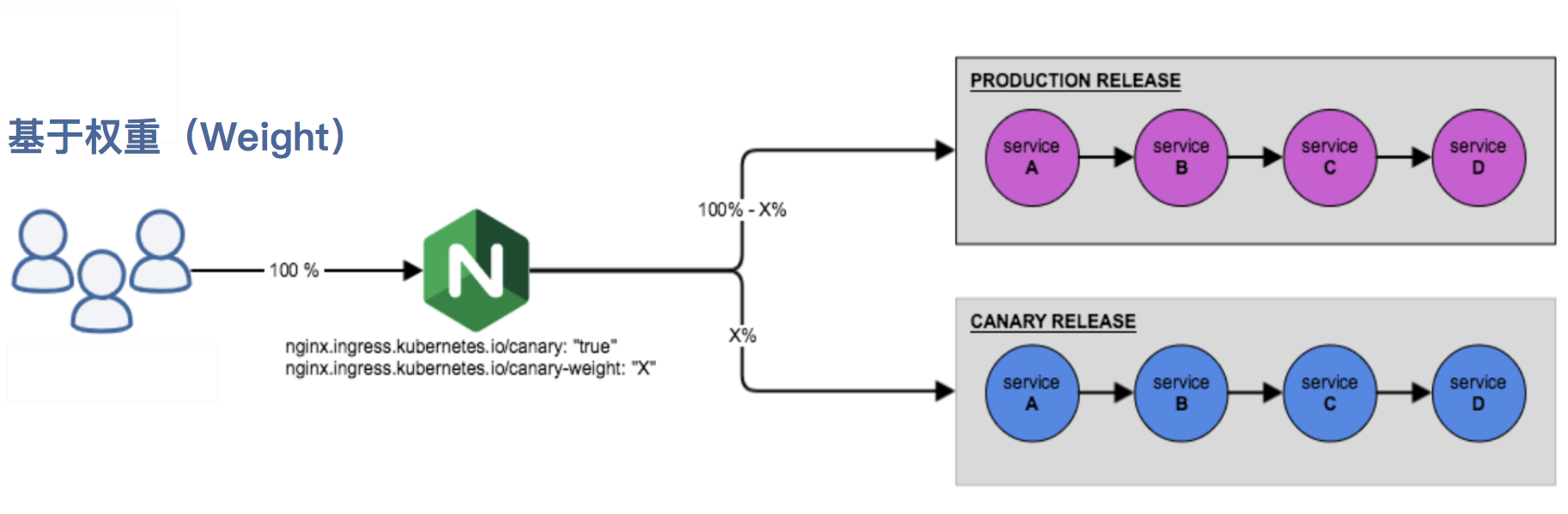

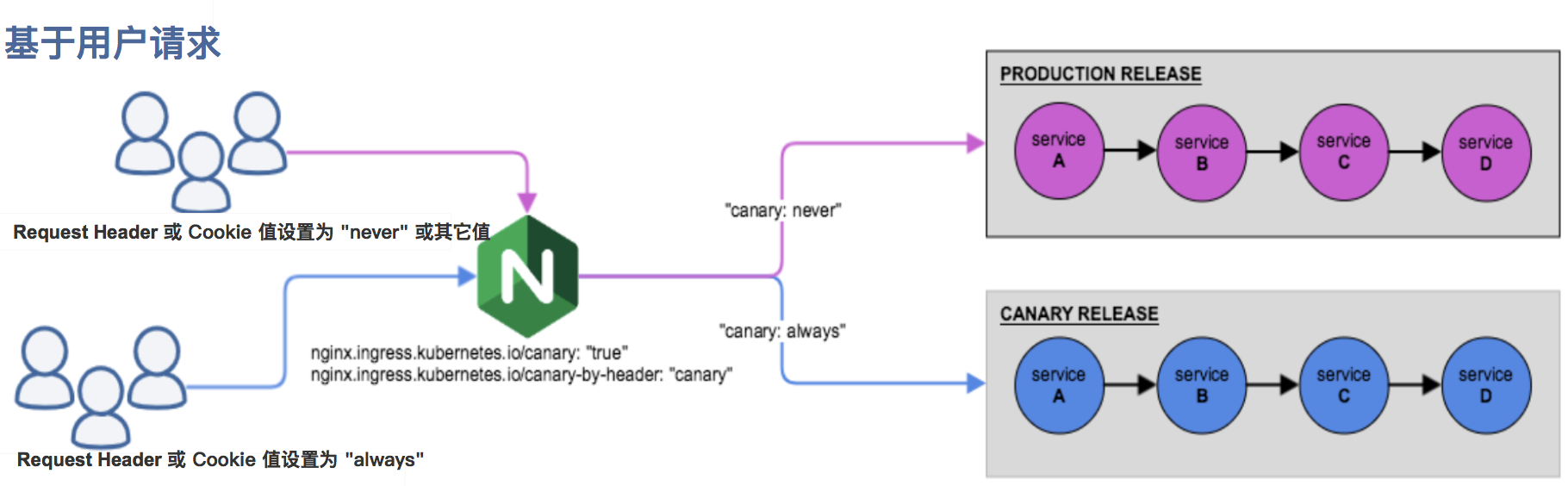

把以上的四個 annotation 規則可以總體劃分為以下兩類:

- 基於權重的 Canary 規則

- 基於使用者請求的 Canary 規則

第一步:建立專案和 Production 版本的應用

1.1. 在 KubeSphere 中建立一個企業空間 (workspace) 和專案 (namespace) ,可參考 多租戶管理快速入門。如下已建立了一個示例專案。

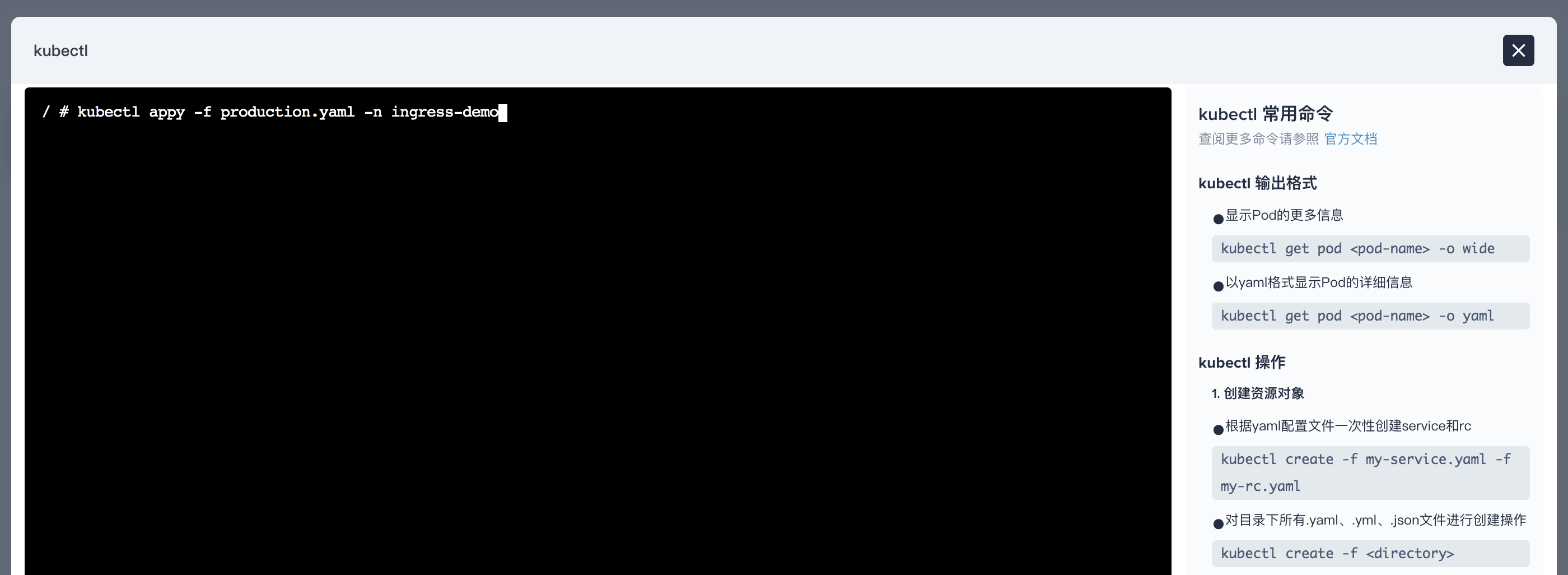

1.2. 為了快速建立應用,在專案中建立工作負載和服務時可通過 編輯 yaml 的方式,或使用 KubeSphere 右下角的工具箱開啟 web kubectl 並使用以下命令和 yaml 檔案建立一個 Production 版本的應用並暴露給叢集外訪問。如下建立 Production 版本的 deployment 和 service。

$ kubectl appy -f production.yaml -n ingress-demo

deployment.extensions/production created

service/production created

其中用到的 yaml 檔案如下:

production.yaml

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

name: production

spec:

replicas: 1

selector:

matchLabels:

app: production

template:

metadata:

labels:

app: production

spec:

containers:

- name: production

image: mirrorgooglecontainers/echoserver:1.10

ports:

- containerPort: 8080

env:

- name: NODE_NAME

valueFrom:

fieldRef:

fieldPath: spec.nodeName

- name: POD_NAME

valueFrom:

fieldRef:

fieldPath: metadata.name

- name: POD_NAMESPACE

valueFrom:

fieldRef:

fieldPath: metadata.namespace

- name: POD_IP

valueFrom:

fieldRef:

fieldPath: status.podIP

---

apiVersion: v1

kind: Service

metadata:

name: production

labels:

app: production

spec:

ports:

- port: 80

targetPort: 8080

protocol: TCP

name: http

selector:

app: production

1.3. 建立 Production 版本的應用路由 (Ingress)。

$ kubectl appy -f production.ingress -n ingress-demo

ingress.extensions/production created

其中用到的 yaml 檔案如下:

production.ingress

apiVersion: extensions/v1beta1

kind: Ingress

metadata:

name: production

annotations:

kubernetes.io/ingress.class: nginx

spec:

rules:

- host: kubesphere.io

http:

paths:

- backend:

serviceName: production

servicePort: 80

第二步:訪問 Production 版本的應用

2.1. 此時,在 KubeSphere UI 的企業空間 demo-workspace 下,可以看到 ingress-demo 專案下的所有資源。

Deployment

Service

Ingress

2.2. 訪問 Production 版本的應用需確保當前專案已開啟了閘道器,在外網訪問下開啟閘道器,型別為 NodePort。

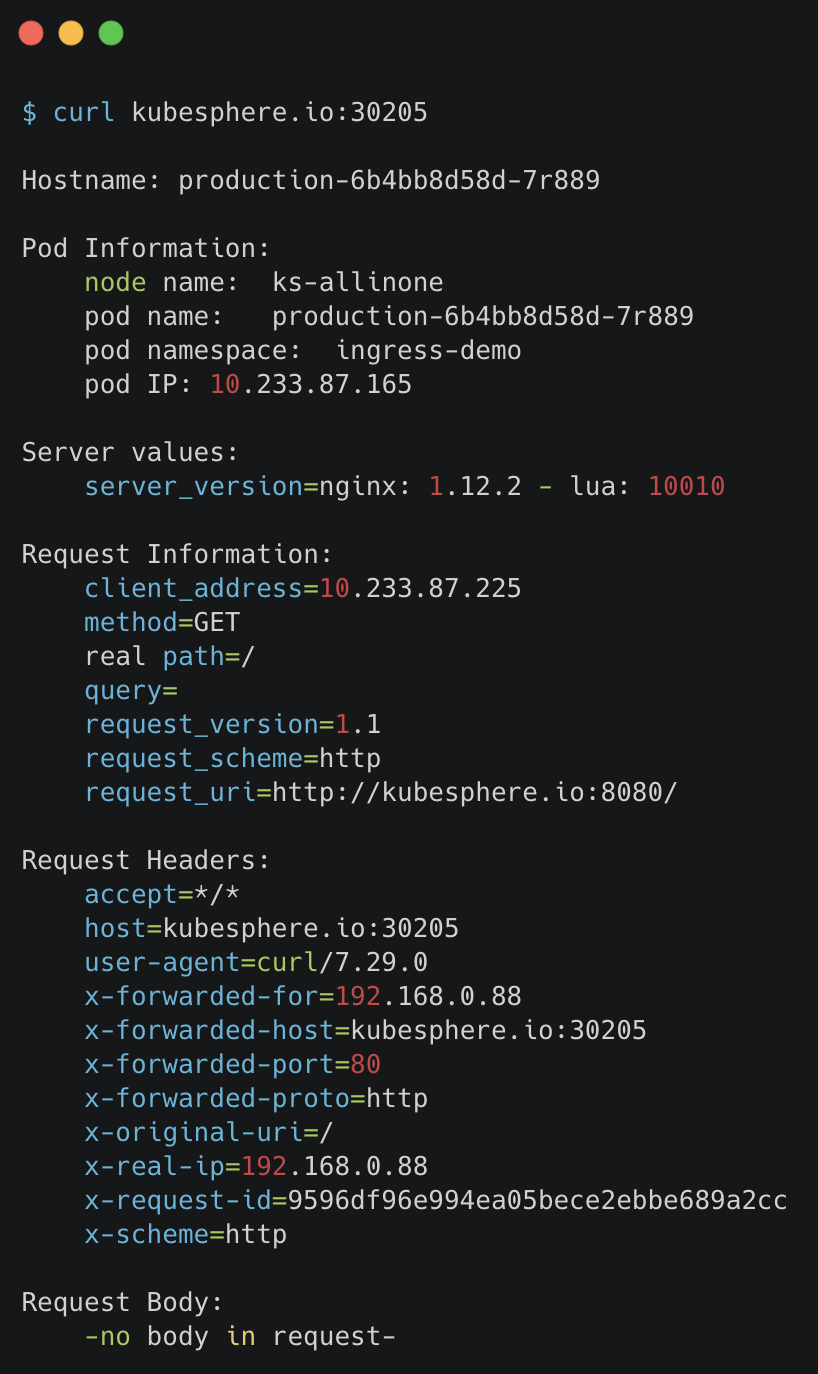

2.3. 如下訪問 Production 版本的應用。

<!--  -->

$ curl kubesphere.io:30205

Hostname: production-6b4bb8d58d-7r889

Pod Information:

node name: ks-allinone

pod name: production-6b4bb8d58d-7r889

pod namespace: ingress-demo

pod IP: 10.233.87.165

Server values:

server_version=nginx: 1.12.2 - lua: 10010

Request Information:

client_address=10.233.87.225

method=GET

real path=/

query=

request_version=1.1

request_scheme=http

request_uri=http://kubesphere.io:8080/

Request Headers:

accept=*/*

host=kubesphere.io:30205

user-agent=curl/7.29.0

apiVersion: extensions/v1beta1

x-forwarded-for=192.168.0.88

x-forwarded-host=kubesphere.io:30205

x-forwarded-port=80

x-forwarded-proto=http

x-original-uri=/

x-real-ip=192.168.0.88

x-request-id=9596df96e994ea05bece2ebbe689a2cc

x-scheme=http

Request Body:

-no body in request-

第三步:建立 Canary 版本

參考將上述 Production 版本的 production.yaml 檔案,再建立一個 Canary 版本的應用,包括一個 Canary 版本的 deployment 和 service (為方便快速演示,僅需將 production.yaml 的 deployment 和 service 中的關鍵字 production 直接替換為 canary,實際場景中可能涉及業務程式碼變更)。

第四步:Ingress-Nginx Annotation 規則

基於權重 (Weight)

基於權重的流量切分的典型應用場景就是藍綠部署,可通過將權重設定為 0 或 100 來實現。例如,可將 Green 版本設定為主要部分,並將 Blue 版本的入口配置為 Canary。最初,將權重設定為 0,因此不會將流量代理到 Blue 版本。一旦新版本測試和驗證都成功後,即可將 Blue 版本的權重設定為 100,即所有流量從 Green 版本轉向 Blue。

4.1. 使用以下 canary.ingress 的 yaml 檔案再建立一個基於權重的 Canary 版本的應用路由 (Ingress)。

注意:要開啟灰度釋出機制,首先需設定

nginx.ingress.kubernetes.io/canary: "true"啟用 Canary,以下 Ingress 示例的 Canary 版本使用了基於權重進行流量切分的 annotation 規則,將分配 30% 的流量請求傳送至 Canary 版本。

apiVersion: extensions/v1beta1

kind: Ingress

metadata:

name: canary

annotations:

kubernetes.io/ingress.class: nginx

nginx.ingress.kubernetes.io/canary: "true"

nginx.ingress.kubernetes.io/canary-weight: "30"

spec:

rules:

- host: kubesphere.io

http:

paths:

- backend:

serviceName: canary

servicePort: 80

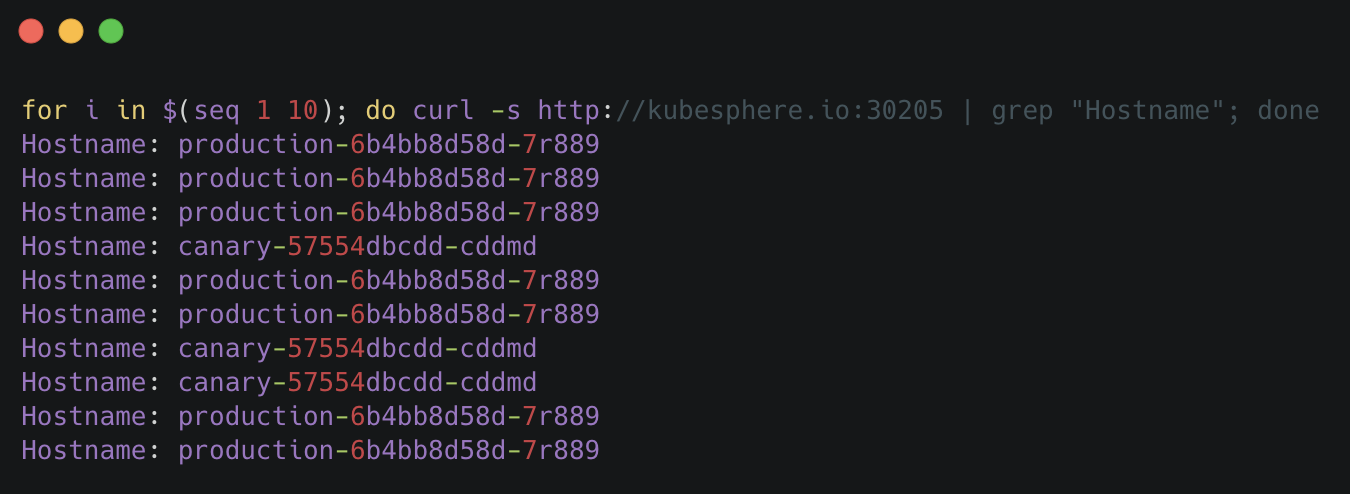

4.2. 訪問應用的域名。

說明:應用的 Canary 版本基於權重 (30%) 進行流量切分後,訪問到 Canary 版本的概率接近 30%,流量比例可能會有小範圍的浮動。

基於 Request Header

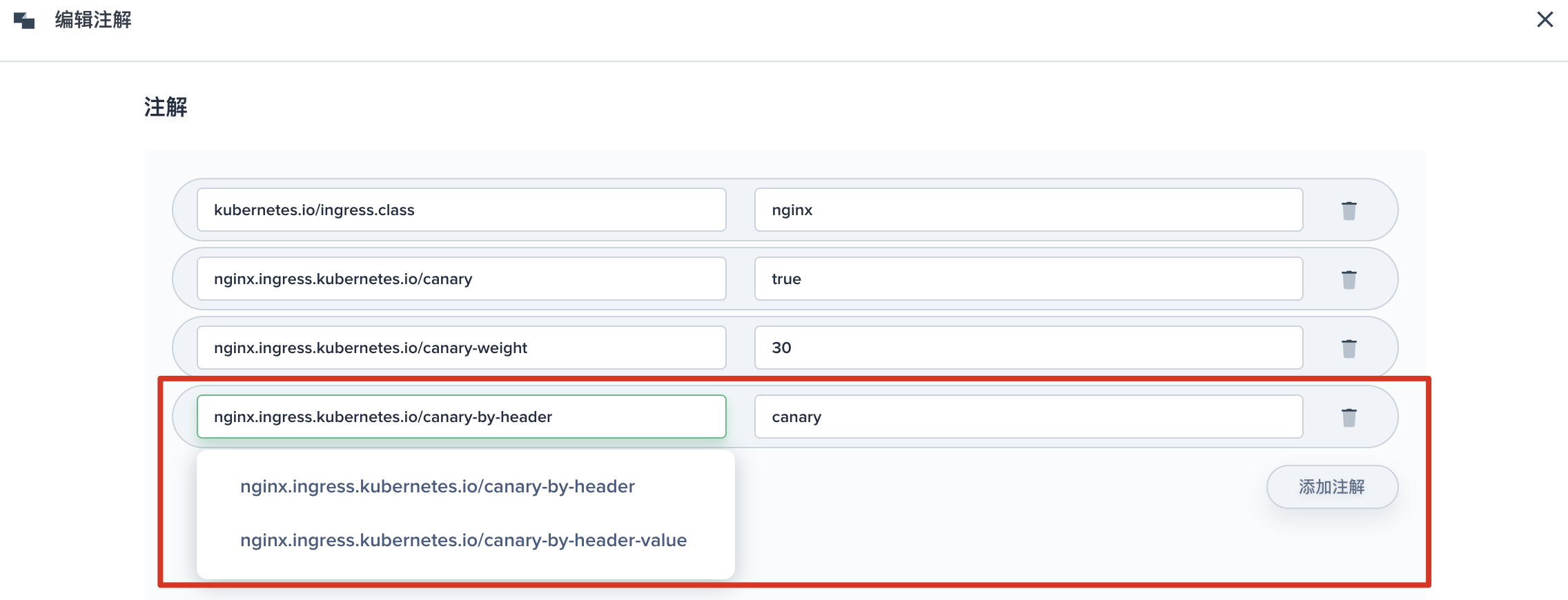

4.3. 基於 Request Header 進行流量切分的典型應用場景即灰度釋出或 A/B 測試場景。參考以下截圖,在 KubeSphere 給 Canary 版本的 Ingress 新增一條 annotation nginx.ingress.kubernetes.io/canary-by-header: canary (這裡的 annotation 的 value 可以是任意值),使當前的 Ingress 實現基於 Request Header 進行流量切分。

說明:金絲雀規則按優先順序

canary-by-header - > canary-by-cookie - > canary-weight進行如下排序,因此以下情況將忽略原有 canary-weight 的規則。

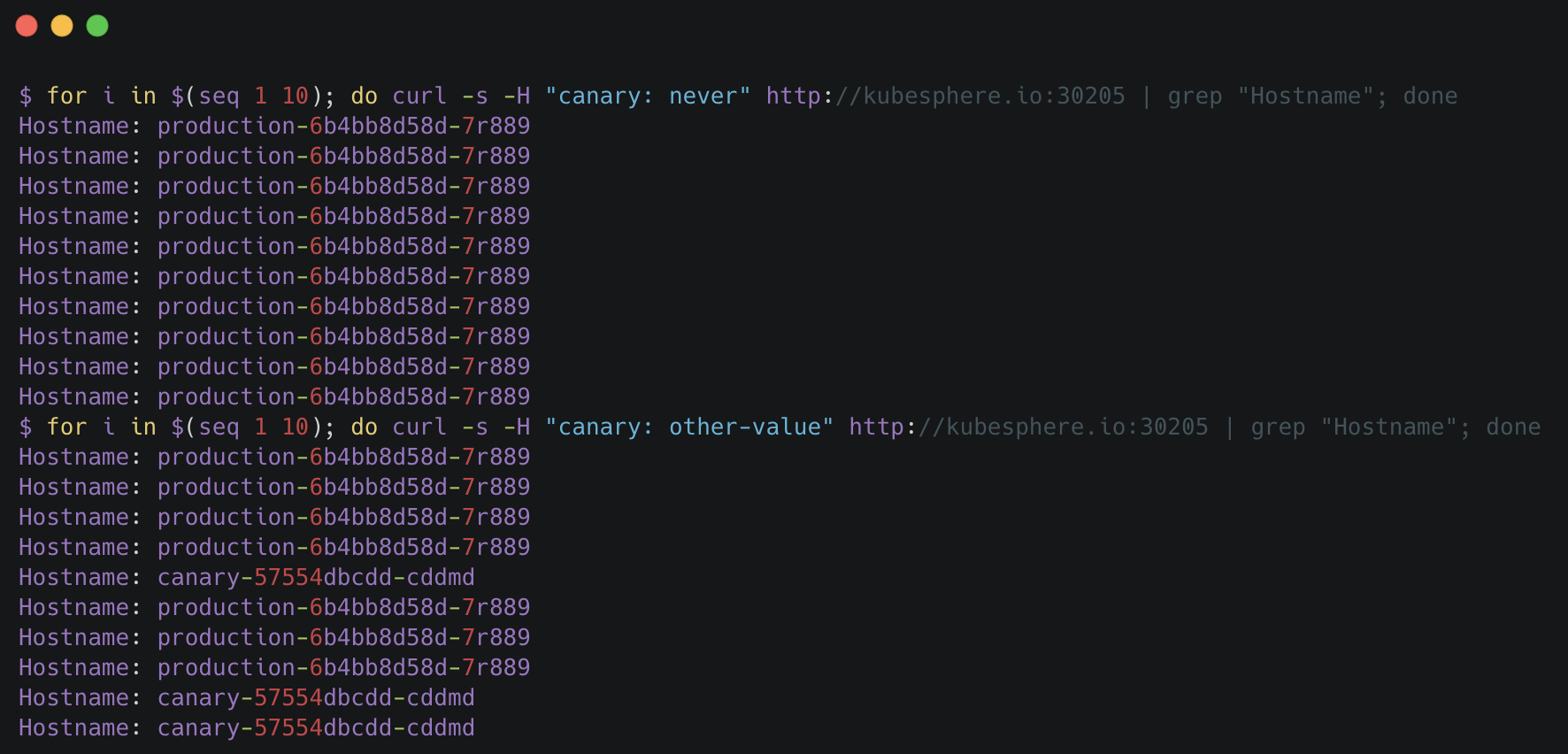

4.4. 在請求中加入不同的 Header 值,再次訪問應用的域名。

說明:

舉兩個例子,如開篇提到的當 Request Header 設定為

never或always時,請求將不會或一直被髮送到 Canary 版本;對於任何其他 Header 值,將忽略 Header,並通過優先順序將請求與其他 Canary 規則進行優先順序的比較(如下第二次請求已將

基於 30% 權重作為第一優先順序)。

4.5. 此時可以在上一個 annotation (即 canary-by-header)的基礎上新增一條 nginx.ingress.kubernetes.io/canary-by-header-value: user-value 。用於通知 Ingress 將請求路由到 Canary Ingress 中指定的服務。

4.6. 如下訪問應用的域名,當 Request Header 滿足此值時,所有請求被路由到 Canary 版本(該規則允許使用者自定義 Request Header 的值)。

基於 Cookie

4.7. 與基於 Request Header 的 annotation 用法規則類似。例如在 A/B 測試場景 下,需要讓地域為北京的使用者訪問 Canary 版本。那麼當 cookie 的 annotation 設定為 nginx.ingress.kubernetes.io/canary-by-cookie: "users_from_Beijing",此時後臺可對登入的使用者請求進行檢查,如果該使用者訪問源來自北京則設定 cookie users_from_Beijing 的值為 always,這樣就可以確保北京的使用者僅訪問 Canary 版本。

總結

灰度釋出可以保證整體系統的穩定,在初始灰度的時候就可以對新版本進行測試、發現和調整問題,以保證其影響度。本文通過多個示例演示和說明了基於 KubeSphere 使用應用路由 (Ingress) 和專案閘道器 (Ingress Controller) 實現灰度釋出,並詳細介紹了 Ingress-Nginx 的四種 Annotation,還未使用 Istio 的使用者也能借助 Ingress-Nginx 輕鬆實現灰度釋出與金絲雀釋出。

參考

- NGINX Ingress Controller - Annotations

- canary deployment with ingress-nginx

- Canary Deployments on Kubernetes without Service Mesh KubeSphere (https://github.com/kubesphere/kubesphere) 是一個開源的以應用為中心的容器管理平臺,支援部署在任何基礎設施之上,並提供簡單易用的 UI,極大減輕日常開發、測試、運維的複雜度,旨在解決 Kubernetes 本身存在的儲存、網路、安全和易用性等痛點,幫助企業輕鬆應對敏捷開發與自動化監控運維、端到端應用交付、微服務治理、多租戶管理、多叢集管理、服務與網路管理、映象倉庫、AI 平臺、邊緣計算等