BPN反向傳播神經網絡

BP算法細節

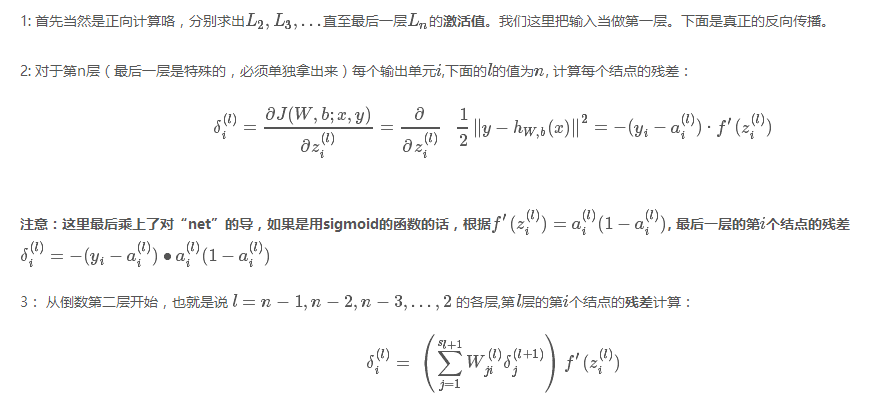

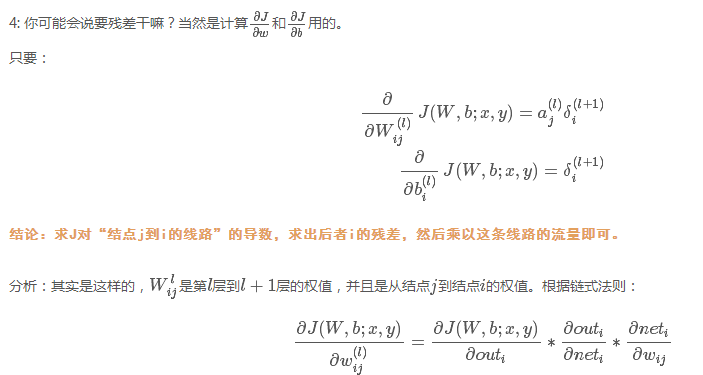

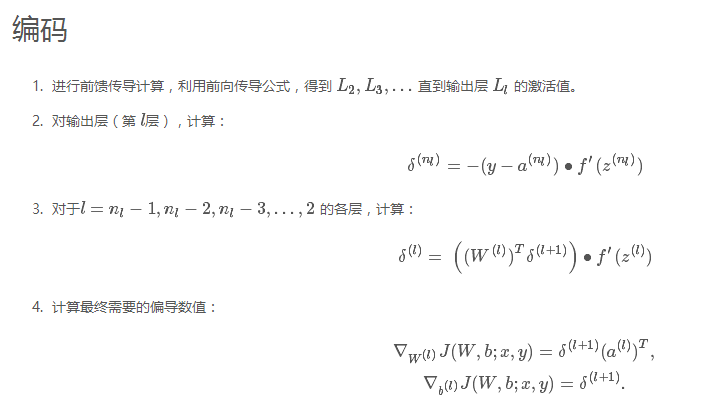

參數說明:假設有n層。J表示代價函數,和上面的E是同樣的意思,只不過用不同的字母寫而已。

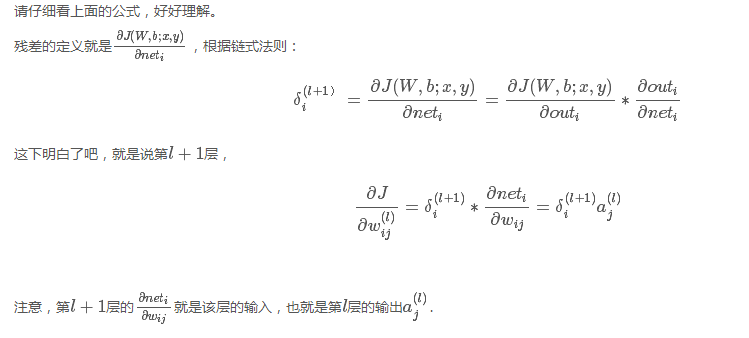

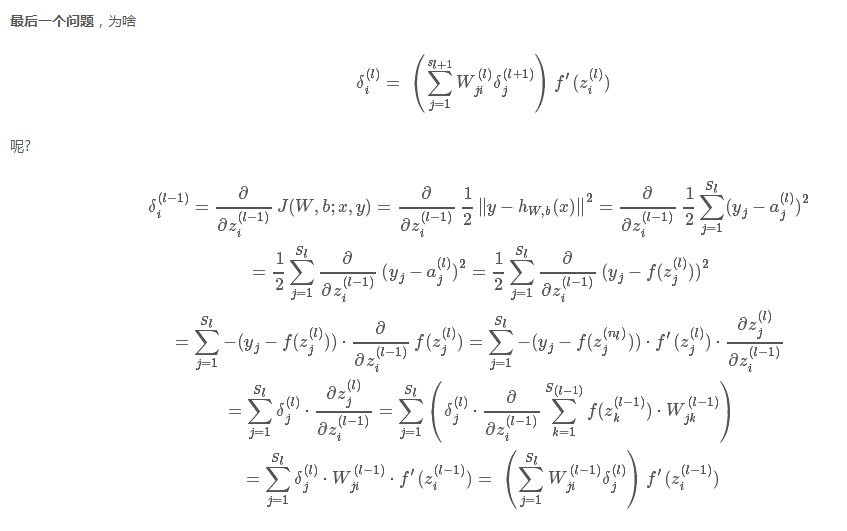

分析:要想知道第l層的第i個結點的殘差,必須知道該節點所連接的下一層的各個結點的權值,以及這些結點的殘差,幸虧第l+1層已經計算出來了殘差,你只要把後面一層的每個結點j的殘差乘以該結點與這一層的結點i相連的權值,然後加和,最後別忘了乘以這一層的激活方式的導數。

最後說明一點,BP傳播,計算各層的各點的殘差是關鍵,殘差是總的代價函數對於該點的net的偏導,從倒數第二層開始,求殘差就要用到其後面的一層的各個殘差,只要用後面一層的各個結點殘差乘以其與這一層這個的結點所連接的權值,再求和,最後乘以這一層這個結點的out對net的偏導就可以了。如此一來,殘差乘以這個結點的輸入,就可以得到整個代價函數對於這個結點的w偏導了。

BPN反向傳播神經網絡

相關推薦

BPN反向傳播神經網絡

frame 計算 size view row bp算法 image 表示 細節 BP算法細節 參數說明:假設有n層。J表示代價函數,和上面的E是同樣的意思,只不過用不同的字母寫而已。 分析:要想知道第l層的第i個結點的殘差,必須知道該節點所連接的下一層的各個結點的

【神經網絡和深度學習】筆記 - 第二章 反向傳播算法

討論 固定 特征 array sed 並不會 思想 隨機梯度 相關 上一章中我們遺留了一個問題,就是在神經網絡的學習過程中,在更新參數的時候,如何去計算損失函數關於參數的梯度。這一章,我們將會學到一種快速的計算梯度的算法:反向傳播算法。 這一章相較於後面的章節涉及到的數學

神經網絡正向傳播與反向傳播公式

src 反向傳播 http 技術分享 img inf 分享圖片 公式 info 神經網絡正向傳播與反向傳播公式

神經網絡入門——15反向傳播

html 多層 產生 https none 算法 erro 實現 節點和 反向傳播 如何讓多層神經網絡學習呢?我們已了解了使用梯度下降來更新權重,反向傳播算法則是它的一個延伸。以一個兩層神經網絡為例,可以使用鏈式法則計算輸入層-隱藏層間權重的誤差。 要使用梯度下降法

一文弄懂神經網絡中的反向傳播法——BackPropagation

簡化 range get -s 數學公式 eight 可能 width 文章 最近在看深度學習的東西,一開始看的吳恩達的UFLDL教程,有中文版就直接看了,後來發現有些地方總是不是很明確,又去看英文版,然後又找了些資料看,才發現,中文版的譯者在翻譯的時候會對省略的公式推

007-卷積神經網絡-前向傳播-反向傳播

ron inf nbsp bubuko src 深度 圖片 矩陣 png 前向傳播: 前向傳播就是求特征圖的過程 通常x和w有四個維度[編號,深度,高度,寬度] 反向傳播: 先來復習一下反向傳播的知識: 反向傳播回來的是梯度,也就是偏導數 反向傳播力有一個鏈式法則:對

神經網絡學習筆記二——反向傳導

操作 nbsp 算法 oid 輸入 atl 防止 反向 ... 參考自 http://deeplearning.stanford.edu/wiki/index.php/%E5%8F%8D%E5%90%91%E4%BC%A0%E5%AF%BC%E7%AE%97%E6%B3%9

TensorFlow筆記-04-神經網絡的實現過程,前向傳播

com 描述 矩陣相乘 ons === nor 技術分享 轉載 .html TensorFlow筆記-04-神經網絡的實現過程 基於TensorFlow的NN:用張量表示數據,用計算圖搭建神經網絡,用會話執行計算圖,優化線上的權重(參數),得到模型 張量(tensor):

2. DNN神經網絡的反向更新(BP)

還需要 轉載 for 批量 span log 叠代 partial 得到 1. DNN神經網絡的前向傳播(FeedForward) 2. DNN神經網絡的反向更新(BP) 1. 前言 DNN前向傳播介紹了DNN的網絡是如何的從前向後的把數據傳遞過去的,但是只有這個過程還不夠

DNN網絡(二)反向傳播算法

通過 圖片 center 微分方程 log ext 部分 算法 輸入 本文摘自: https://www.cnblogs.com/pinard/p/6422831.html http://www.cnblogs.com/charlotte77/p/5629865.html

吳裕雄 python 神經網絡——TensorFlow 三層簡單神經網絡的前向傳播算法

tdd global dom NPU sta seed flow python dde import tensorflow as tf w1= tf.Variable(tf.random_normal([2, 3], stddev=1, seed=1)) w2=

神經網絡之dropout層

軟件 同時 依賴 chm ast 縮減 ref word 叠代 一:引言 因為在機器學習的一些模型中,如果模型的參數太多,而訓練樣本又太少的話,這樣訓練出來的模型很容易產生過擬合現象。在訓練bp網絡時經常遇到的一個問題,過擬合指的是模型在訓練數據上損失函數比較小,預測準

利用Tensorflow實現神經網絡模型

flow one 什麽 hold test ase tensor dom def 首先看一下神經網絡模型,一個比較簡單的兩層神經。 代碼如下: # 定義參數 n_hidden_1 = 256 #第一層神經元 n_hidden_2 = 128 #第

神經網絡結構在命名實體識別(NER)中的應用

field edi most 好的 向量 後來 目標 領域 png 神經網絡結構在命名實體識別(NER)中的應用 近年來,基於神經網絡的深度學習方法在自然語言處理領域已經取得了不少進展。作為NLP領域的基礎任務—命名實體識別(Named Entity Recogni

《神經網絡設計》讀書筆記第一章

tails 人工 讀書筆記 進一步 結構 network 設計 消失 第一章 包括記憶在內的所有生物神經功能,都存儲在神經元及其之間的連接上。 神經網絡中關於學習的過程是 神經元之間建立新的連接或對已有連接進行修改的過程。 神經網絡的起源:M-P模型 是按照生物神經元的

bp神經網絡的實現C++

tin sam col class () nbsp out cout 0.00 #include <iostream> #include<stdlib.h> #include <math.h> using namespace std;

機器學習:神經網絡之表達

聚類 推薦系統 處理 mar 添加 gist 課程筆記 像素 ... ************************************** 註:本系列博客是博主學習Stanford大學 Andrew Ng 教授的《機器學習》課程筆記。博主深感學過課程後,不進行總

二、計算機的神經網絡系統-操作系統

平板電腦 行數 其它 電腦 hone 貴的 模式 不同的 操作系統 上篇介紹了計算機的身體構造,但是把那幾大塊部件拼湊在一起,還不能稱之為計算機,還得讓它能夠思考,今天我們來說說計算機是如何思考的。 人類之所以能夠思考,是因為我們的身體中有無數的神經元組成的神奇的神

Network In Network——卷積神經網絡的革新

gin src center log 感知 eat line pro bsp Network In Network 是13年的一篇paper 引用:Lin M, Chen Q, Yan S. Network in network[J]. arXiv preprint ar

vijos1105 神經網絡

== 每次 div std turn getchar() digi () return 主要就是一個拓撲排序,每次找到一個入度為零的點,然後更新別的點的C值。 #include<cstdio> #include<cctype> #include