多個變量的線性回歸

多元線性回歸也被稱為多元線性回歸。

我們現在介紹方程的符號,我們可以有任意數量的輸入變量。

xj(i):第i個訓練樣本中的第j個變量。

x(i):第i個訓練樣本中的變量。

m:訓練樣本的數量。

n:變量的個數。

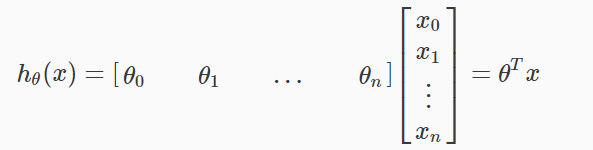

容納這些多個特征的假設函數的多變量形式如下:

![]()

為了開發這個功能的直覺,我們可以想一想,θ0作為房子的基本價格,θ1每平方米的價格,θ2每層樓的價格,等X1將在房子的平方米數,x2樓層數,等等。

利用矩陣乘法的定義,我們的多變量假設函數可以簡潔地表示為:

這是對一個訓練例子的假設函數的矢量化。

備註:請註意,為了方便起見,我們假設![]() 。這允許我們做矩陣運算與θ和X使兩向量的θ和X(我)互相匹配元素(即有相同數目的元素:N + 1)]

。這允許我們做矩陣運算與θ和X使兩向量的θ和X(我)互相匹配元素(即有相同數目的元素:N + 1)]

多個變量的線性回歸

相關推薦

Ng第二課:單變量線性回歸(Linear Regression with One Variable)

dll oba vcf 更多 dba cfq dpf gis avd 二、單變量線性回歸(Linear Regression with One Variable) 2.1 模型表示 2.2 代價函數 2.3 代價函數的直觀理解 2.4 梯度下降

【吳恩達機器學習】學習筆記——2.1單變量線性回歸算法

工作方式 樣本 body 聚類 屬性 bsp 定義 算法 信息 1 回顧1.1 監督學習定義:給定正確答案的機器學習算法分類:(1)回歸算法:預測連續值的輸出,如房價的預測(2)分類算法:離散值的輸出,如判斷患病是否為某種癌癥1.2 非監督學習定義:不給定數據的信息的情況下

機器學習【第二篇】單變量線性回歸

重復 mil 最大 在線 局部最優 記得 算法 描點 3d模型 吳恩達機器學習筆記整理——單變量線性回歸 通過模型分析,擬合什麽類型的曲線。 一、基本概念 1.訓練集 由訓練樣例(training example)組成的集合就是訓練集(training set), 如下

Andrew Ng機器學習第一章——單變量線性回歸

梯度 tex 回歸 同步 常常 最好 可能 機器 http 監督學習算法工作流程 h代表假設函數,h是一個引導x得到y的函數 如何表示h函數是監督學習的關鍵問題 線性回歸:h函數是一個線性函數 代價函數 在線性回歸問題中,常常需要解決最小化問題。代

ML:單變量線性回歸(Linear Regression With One Variable)

one mod gre line lin 我們 目的 技術 ESS 模型表達(model regression) 用於描述回歸問題的標記 m 訓練集(training set)中實例的數量 x 特征/輸入變量 y 目標變量/輸出變量 (x,y) 訓練集中的實例 (x(

吳恩達機器學習筆記4-單變量線性回歸

alt 方法 bsp 目標 .com 函數 bubuko 機器學習 絕對值 今天看個5個課時的視頻,對假設函數、代價函數、以及梯度下降有了一個大概的了解。 假設函數: 代價函數: 我們的目標就是求得J的最小值 梯度下降:在一個上坡上找一個點,求得這個點周圍的絕對值最大的導數

吳恩達機器學習筆記一_單變量線性回歸

gre ima 梯度下降算法 line 公式 delta mat 所有 pan 單變量線性回歸 綱要 代價函數 梯度下降算法 全局最優與局部最優 代價函數 函數定義: \[ J(\theta_0,\theta_1,...)=\frac{1}{2m}\sum_{i=1}^

2、單變量線性回歸

ping con src 面積 變量 選擇 spa nbsp 損失函數 p.p1 { margin: 0.0px 0.0px 0.0px 0.0px; font: 12.0px ".PingFang SC" } 引例:以房價和房屋面積作為訓練集,學習如何預測房價 p.p

第02周-單變量線性回歸

技術分享 分享圖片 http 問題: 有監督 都是 family 數組 src 一個有監督的房價訓練模型如下所示: 單變量線性回歸問題: 模型預測值與訓練實際值之間的差距,就是建模誤差。 一般常用的代價函數是平方誤差函數,之所以提出誤差的平方和,是因為誤差平方代價

機器學習筆記(2)單變量線性回歸

learn 曲線 數學分析 spl 學習 裏的 計算 需要 全局 模型介紹 關於回歸問題的模型,相當於給一些x(自變量),y(因變量)的數據對構成的數據集,去建立一個數學函數模型(model),之後就能根據這個函數模型,給出x(自變量條件)之後,預測出y(因變量結果)的值。

機器學習---吳恩達---Week1(機器學習概述與單變量線性回歸方程分析)

行數 操作 相加 vision 強化學習 machine 其余 tro ram 機器學習概述 Machine Learning: Grew out of work in AI & New capability for computers Examples:

多個變量的線性回歸

.cn 允許 com 們的 alt 線性回歸 功能 wid .com 多元線性回歸也被稱為多元線性回歸。 我們現在介紹方程的符號,我們可以有任意數量的輸入變量。 xj(i):第i個訓練樣本中的第j個變量。 x(i):第i個訓練樣本中的變量。 m:訓練樣本的數量。 n:變

吳恩達機器學習筆記8-多變量線性回歸(Linear Regression with Multiple Variables)--多維特征

學習筆記 機器 增加 都是 維度 能夠 因此 表示 轉置 我們探討了單變量/特征的回歸模型,現在我們對房價模型增加更多的特征,例如房間數樓層等,構成一個含有多個變量的模型,模型中的特征為(??1, ??1, . . . , ????)。 增添更多特征後,我們引入一

Python學習-解壓可叠代對象賦值給多個變量

col 如果 可變 home nbsp one nobody lis 輸出 解壓序列賦值給多個對象 任何的序列(或者是可叠代對象)可以通過一個簡單的賦值語句解壓並賦值給多個變量。唯一的前提就是變量的數量必須跟序列元素的數量是一樣的。 >>> data =

Python 給多個變量同時賦值

賦值 第一個 int hello msg pytho data 多個 pri #給多個變量賦值data=[‘alex‘,84,[1900,3,38]]name,age,birth=dataprint(name)print(age)print(birth)#msg=‘hell

機器學習(3)——多變量線性回歸

function 包括 ade each pop text times value 應該 【一、多變量線性回歸模型】 多變量線性回歸是指輸入為多維特征的情況。比如: 在上圖中可看出房子的價格price由四個變量(size、number of be

C++實現給多個變量傳值

ucs userinfo weibo ref hid gin left use margin 浦88TBR疵95閹TJ糜骯http://weibo.com/u/6348338757 屠貉業17慕M紗杜73油萊http://jz.docin.com/rido621 2B0

python多個變量賦值

pre log color a + b 計算 輸出 class tle clas 1 a, b = 3, 4 2 c, d = 3, 4 3 4 a, b = b, a + b 5 c = d 6 d = c + d 7 print(a, b, c, d) 輸

vue監聽多個變量的方法

control val param query als pre log 變量 tor vue當中有時需要監聽多個變量,方法如下,推薦方法一 一、把多個變量放在一個對象裏 data() { return { switchParam: {

神經網絡實現連續型變量的回歸預測(python)

是我 labels set 直接 append TP 輸入數據 main setup 轉至:https://blog.csdn.net/langb2014/article/details/50488727 輸入數據變為房價預測: 105.0,2,0.89,510.010