java爬蟲一(分析要爬取數據的網站)

阿新 • • 發佈:2017-09-07

java爬蟲

一、獲取你想要抓取的網站地址:

http://www.zhaopin.com/

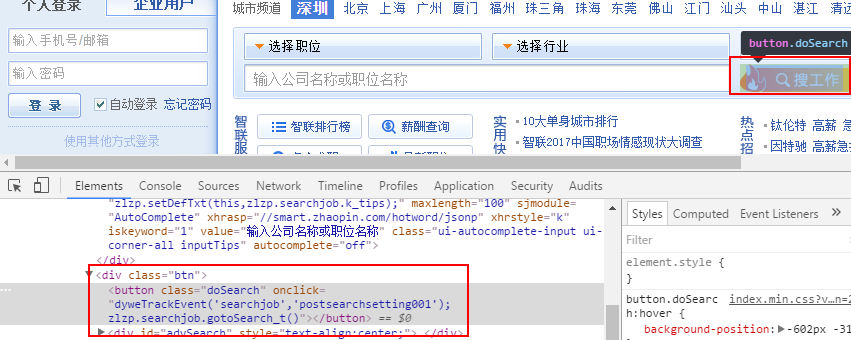

然後打開控制臺,F12,打開。我用的是Chrome瀏覽器,跟個人更喜歡Chrome的控制臺字體。

找到搜索欄對應的html標簽:

http://sou.zhaopin.com/jobs/searchresult.ashx?jl=%E6%B7%B1%E5%9C%B3&kw=Java&sm=0&p=1

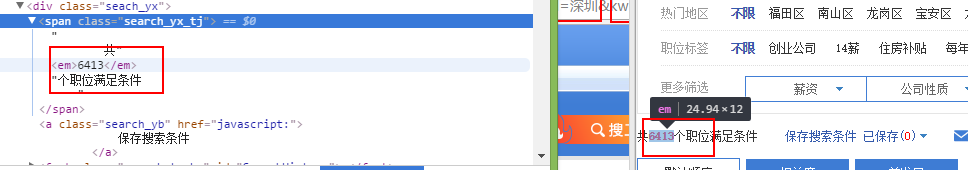

也可以直接在地址欄輸入這個網址。和之前在輸入職位框輸入java,地區為深圳是一致的,在之前點擊“搜工作”按鈕也是這樣跳轉到這個頁面的。

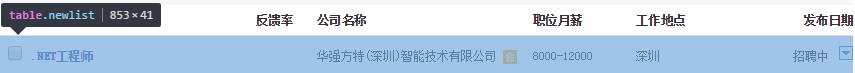

下面這一欄是搜索的結果條數,可能對於我們執行循環有幫助。

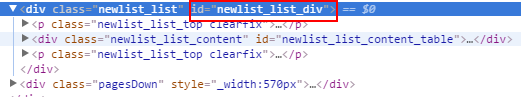

這是定位到某個頁面的所有招聘信息的html的div塊:

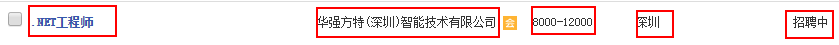

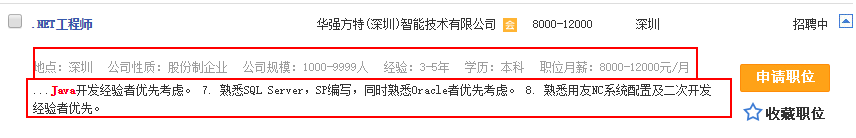

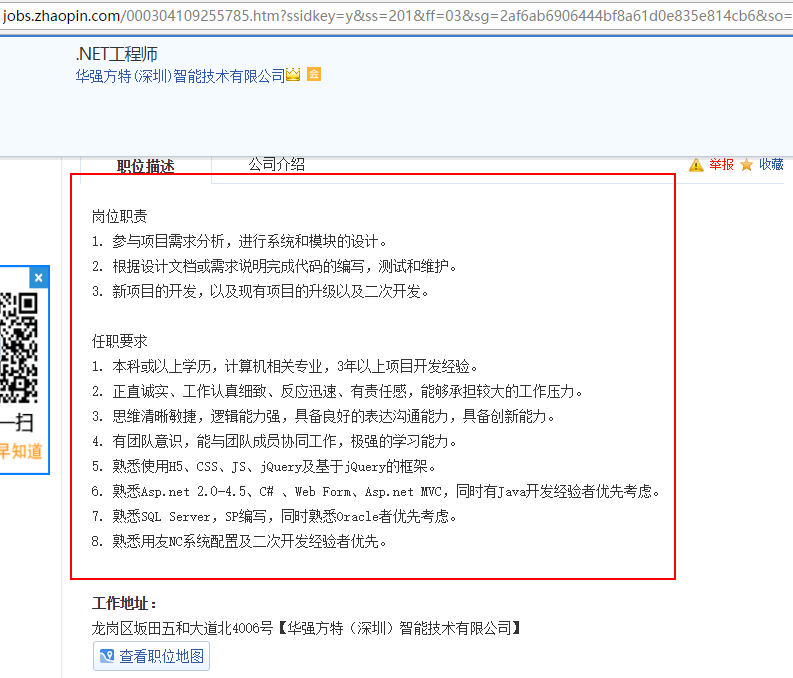

那麽具體到某一家公司的招聘信息:

這就對應到這一家公司了:

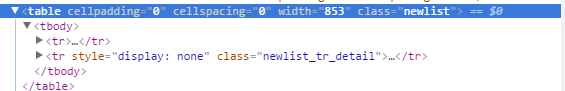

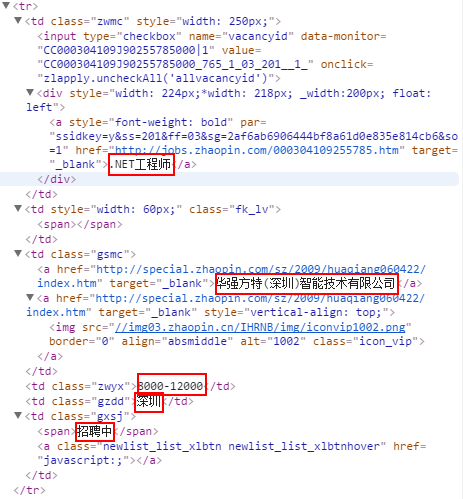

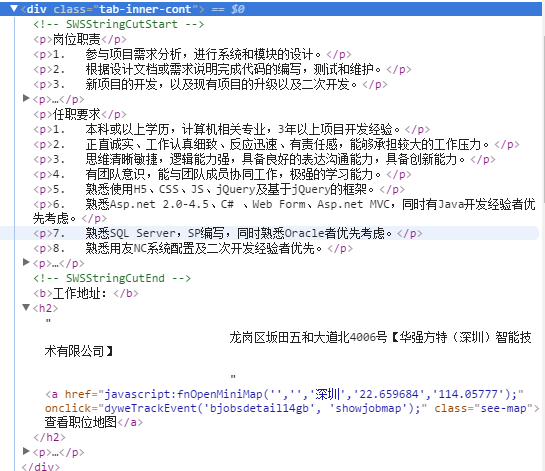

但是我們需要的是具體的信息,於是我們展開剛才上面那個<table></table>的<tr></tr>:

但是我們需要的是具體的信息,於是我們展開剛才上面那個<table></table>的<tr></tr>:

所有的標簽展開內容過長,我們分開來看:

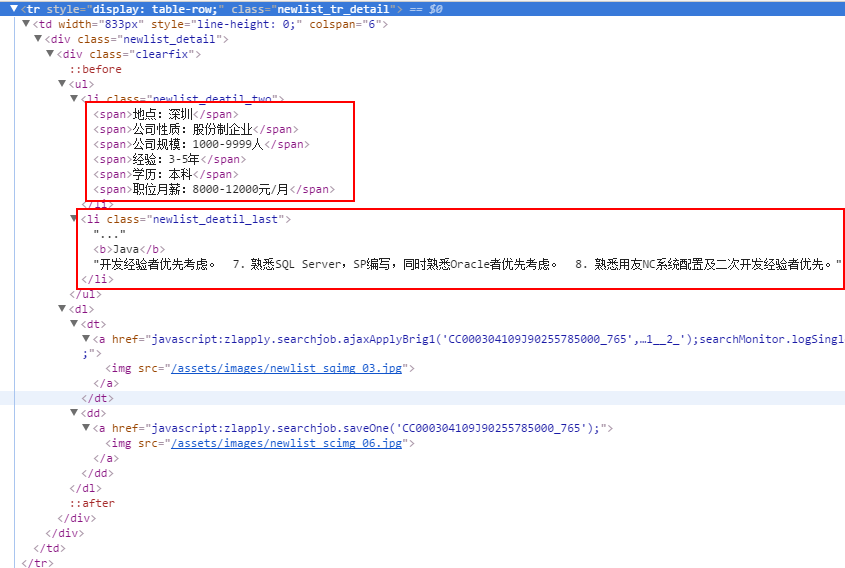

那麽還有一個我們在網頁上看見的:下拉箭頭。打開下拉箭頭就會看到詳細信息,這裏其實該頁面的html已經包含了,只是默認隱藏而已。

那麽還有一個我們在網頁上看見的:下拉箭頭。打開下拉箭頭就會看到詳細信息,這裏其實該頁面的html已經包含了,只是默認隱藏而已。

對應的顯示結果:

對應的顯示結果:

那麽我想獲取的是什麽信息呢,我不會獲取太多信息。這裏我只想獲取的是“崗位名稱”、“經驗”、“學歷”、“薪水”等。如果需要獲取崗位要求和公司地址的話,則必須點擊進入該崗位下進行查看。

那麽我想獲取的是什麽信息呢,我不會獲取太多信息。這裏我只想獲取的是“崗位名稱”、“經驗”、“學歷”、“薪水”等。如果需要獲取崗位要求和公司地址的話,則必須點擊進入該崗位下進行查看。

java爬蟲一(分析要爬取數據的網站)