中文詞頻統計

- 下載一中文長篇小說,並轉換成UTF-8編碼。

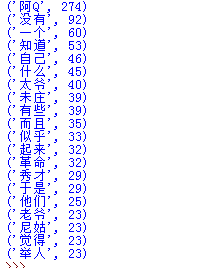

- 使用jieba庫,進行中文詞頻統計,輸出TOP20的詞及出現次數。

- 排除一些無意義詞、合並同一詞。

- 對詞頻統計結果做簡單的解讀。

import jieba q=open(‘阿Q正傳.txt‘,‘r‘,encoding=‘utf-8‘).read() q=list(jieba.cut_for_search(q)) zex={‘,‘,‘。‘,‘!‘} dic={} keys=set(q)-zex#鍵的集合 for i in keys: if len(i)>1: dic[i]= q.count(i)#單詞計數 q=list(dic.items())#

字典轉換成列表,由元組組成 q.sort(key=lambda x:x[1],reverse=True)#排序 for i in range(20): print(q[i])

- 解讀:阿Q是一個生活在革命年代的人。

中文詞頻統計

相關推薦

中文詞頻統計及詞雲制作

print word 詞雲 出現 不能 分享 item 希望 技術 1.中軟國際華南區技術總監曾老師還會來上兩次課,同學們希望曾老師講些什麽內容?(認真想一想回答) 希望能講一些大數據相關內容,深入了解一下。 2.中文分詞 下載一中文長篇小說,並轉換成UTF-8編

9-25提出問題和中文詞頻統計

工作 ever 哥哥 mat 小說 他也 blog 只恐 {} 1.中軟國際華南區技術總監曾老師還會來上兩次課。希望老師能夠講一下 現在的網絡發展和現狀,感覺計算機專業是最受歡迎的,但是憑借著每年不斷畢業(增多)的人數,我們憑借著什麽來跟好比如我們是網工專業,跟學軟件班的同

+中文詞頻統計及詞雲制作9-25

輸出 很難 imp range 著名 python cloud 基本 jieba 1.我希望老師能講一點python在數據挖掘,數據分析領域的應用,最好能舉些實例,或者說帶我們實際操作一波。 2.中文分詞 下載一中文長篇小說,並轉換成UTF-8編碼 使用

中文詞頻統計

item 輸出 lis text 詞頻 ima {} set img 下載一中文長篇小說,並轉換成UTF-8編碼。 使用jieba庫,進行中文詞頻統計,輸出TOP20的詞及出現次數。 排除一些無意義詞、合並同一詞。 對詞頻統計結果做簡單的解讀。 import jieba

1.英文詞頻統2.中文詞頻統計

diff earch port pboc [1] ould ret framework poi 1.英文詞頻統 news=‘‘‘ Guo Shuqing, head of the newly established China banking and insurance

Java實現中文詞頻統計

昨日有個中文詞頻統計的需求, 百度一番後, 發現一大堆標題黨文章, 講的與內容嚴重不符, 這裡就簡單記錄下自己實現的流程吧! 與英文單詞的詞頻統計不同, 中文的難點在於如何分詞, 不過好在有許多優秀的現成庫供呼叫,這裡就使用了 ansj_seg 外掛. 首先新增依賴: 下載jar 訪問

基於jieba庫實現中文詞頻統計

要實現中文分詞功能,大家基本上都是在使用 jieba 這個庫來實現,下面就看看怎樣實現一個簡單文字分詞功能。 安裝 python的工具,安裝當然是使用pip安裝了。 pip install jieba 使用 先看一個小例子,下面的程式碼是從一個文字檔案中分詞並統計出

中文詞頻統計與詞雲生成

讀取 word .com cloud 雲圖 文本文 span odi otl 中文詞頻統計 1. 下載一長篇中文小說。 2. 從文件讀取待分析文本。 ltxz = open(r‘F:/ltxz.txt‘,‘r‘,encoding=‘utf-8‘).read()

中文分詞,詞頻統計,詞雲圖製作

from collections import Counter import jieba #jieba的安裝就不多介紹,網上相應的教程比較多 import matplotlib.pyplot as plt from wordcloud import WordClo

中文分詞與詞頻統計例項

http://blog.ourren.com/2014/09/24/chinese_token_and_frequency/ 話說近兩年大資料確實火了,帶給我們最直接的視覺感受就是利用圖或者表來展示大資料所隱藏的內容,真是真實而又直觀。然而技術部落格的側邊欄標籤雲就

自然語言處理學習3:中文分句re.split(),jieba分詞和詞頻統計FreqDist

1. 使用re.split() 分句,re.split(delimiter, text) import jieba import re # 輸入一個段落,分成句子,可使用split函式來實現 paragraph = "生活對我們任何人來說都不容易!我們必須努力,最重要的是

利用jieba進行中文分詞並進行詞頻統計

1.安裝jieba庫 在windows的Anaconda環境下如果沒有設定環境變數,則從Dos命令先進入...\Anaconda3\Scripts 目錄中,然後執行以下命令即可: pip install jieba 2.分詞示例 我們先用一段文字來進

NLTK統計中文詞頻並輸出

# -*- coding: utf-8 -*- ''' 使用NLTK對中文進行詞頻統計並輸出 ''' from nltk import FreqDist def delblankline(infil

perl 大文本詞頻統計.

pre bst geb don nbsp length $2 詞頻統計 int 思想是設置子文本最大長度,然後分割成多個子文本, 最後合並. 詞頻則是當前位置字和前一位置的字的組合 進入hash. 代碼如下 use Encode; ##編碼解碼 system("ti

Java8新特性——lambda表達式.(案例:詞頻統計)

word ont lose args list lower cep stream spa 需求:讀入一個文本文件,確定所有單詞的使用頻率並從高到低排序,打印出所有單詞及其頻率的排序列表 先用傳統方法解: 1 package cn._1.wordfrequency; 2

hive進行詞頻統計

exp 通過 zookeeper oracle bin 文件 create order lec 統計文件信息: $ /opt/cdh-5.3.6/hadoop-2.5.0/bin/hdfs dfs -text /user/hadoop/wordcount/input/wc

字符串操作練習:星座、凱撒密碼、99乘法表、詞頻統計預處理

千分位 不足 last 乘法表 控制 ise 精度 end for 實例:輸出12個星座符號,以反斜線分隔。 for i in range(12): print(chr(9800+i),end="/") 愷撒密碼的編碼 sr1="abcdefghij

軟件工程第二次作業 詞頻統計

mage std pen not pytho replace mon 知識 ljust 1.項目名稱:詞頻統計 2.代碼地址:https://coding.net/u/songyuu/p/python_wf/git 3.代碼如下: 1 import os 2 impo

字符串操作練習:星座、凱撒密碼、99乘法表、詞頻統計預處

姓名 orm 99乘法表 不足 log inpu 輸入 print 實例 1 實例:輸出12個星座符號,以反斜線分隔。 >>>for i in range (12): >>>print(chr(9800+i),end=" ") 2

組合數據類型練習,英文詞頻統計實例

news forever .com 分隔 ima hat http war nis 實例:由字符串創建一個作業評分列表,做增刪改查詢統計遍歷操作。例如,查詢第一個3分的下標統計1分的同學有多少個,3分的同學有多少個 >>> ap=list("02