#Deep Learning回顧#之LeNet、AlexNet、GoogLeNet、VGG、ResNet

#Deep Learning回顧#之LeNet、AlexNet、GoogLeNet、VGG、ResNet

深入淺出——網絡模型中Inception的作用與結構全解析

#Deep Learning回顧#之LeNet、AlexNet、GoogLeNet、VGG、ResNet

相關推薦

#Deep Learning回顧#之LeNet、AlexNet、GoogLeNet、VGG、ResNet

lenet src get alt article title cep 作用 target #Deep Learning回顧#之LeNet、AlexNet、GoogLeNet、VGG、ResNet 深入淺出——網絡模型中Inception的作用與結構全解析 #Dee

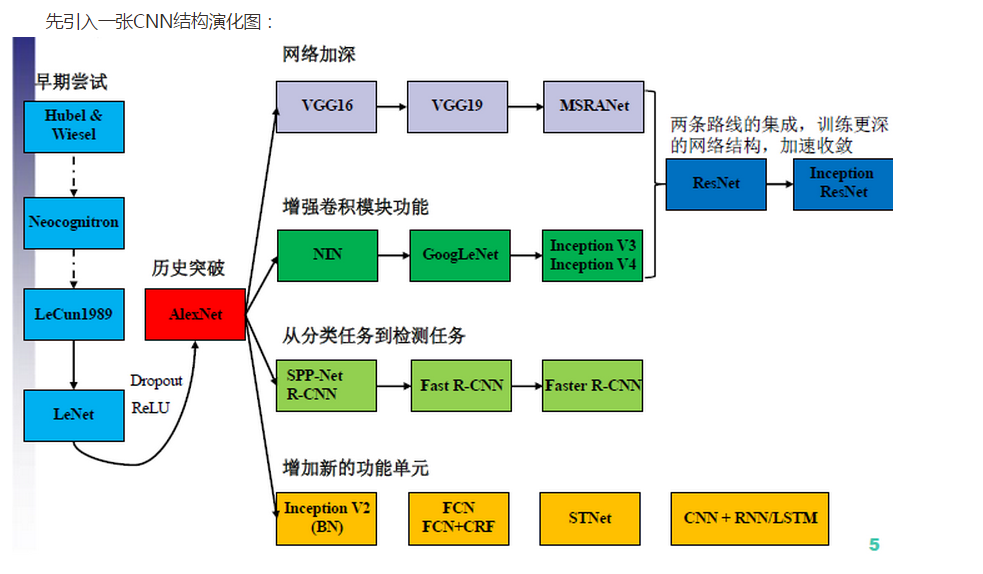

深度學習方法(五):卷積神經網路CNN經典模型整理Lenet,Alexnet,Googlenet,VGG,Deep Residual Learning

歡迎轉載,轉載請註明:本文出自Bin的專欄blog.csdn.net/xbinworld。 技術交流QQ群:433250724,歡迎對演算法、技術感興趣的同學加入。 關於卷積神經網路CNN,網路和文獻中有非常多的資料,我在工作/研究中也用了好一段時間各種常見的model了,就想著

Deep Learning回顧之基於深度學習的目標檢測

轉自:https://www.52ml.net/20287.html 引言 普通的深度學習監督演算法主要是用來做分類,如圖1(1)所示,分類的目標是要識別出圖中所示是一隻貓。而在ILSVRC(ImageNet Large Scale Visual Recognitio

#Deep Learning回顧#之2006年的Science Paper

大家都清楚神經網路在上個世紀七八十年代是著實火過一回的,尤其是後向傳播BP演算法出來之後,但90年代後被SVM之類搶了風頭,再後來大家更熟悉的是SVM、AdaBoost、隨機森林、GBDT、LR、FTRL這些概念。究其原因,主要是神經網路很難解決訓練的問題,比如梯度消失。當時的神經網路研究進入一個低潮期,不過

詳解CNN五大經典模型:Lenet,Alexnet,Googlenet,VGG,DRL

關於卷積神經網路CNN,網路和文獻中有非常多的資料,我在工作/研究中也用了好一段時間各種常見的model了,就想著簡單整理一下,以備查閱之需。Lenet,1986年Alexnet,2012年GoogleNet,2014年VGG,2014年Deep Residual Learn

機器學習(Machine Learning)與深度學習(Deep Learning)資料 之 文章、部落格

介紹:這是一篇介紹機器學習歷史的文章,介紹很全面,從感知機、神經網路、決策樹、SVM、Adaboost到隨機森林、DeepLearning.介紹:這一篇介紹如果設計和管理屬於你自己的機器學習專案的文章,裡面提供了管理模版、資料管理與實踐方法.介紹:如果你還不知道什麼是機器學習

Deep Learning學習 之 卷積神經網路(文字識別系統LeNet-5)

部分預備知識可以先看博文,統一了一些專業名詞。 原文摘自,在此文中對原文增加了一些註釋和修改,統一了與之前博文的專業名詞說法,有助於理解。 !!!如果讀者發現一些數學符號後面有一些奇怪的豎線,那是CSDN的Latex除了問題,大家自行過濾。 在經典的模式識

【深度學習】Deep Learning必備之必背知識點

這篇文章有哪些需要背誦的內容: 1、張量、計算圖、會話 神經網路:用張量表示資料,用計算圖搭建神經網路,用會話執行計算圖,優化線上的權重(引數),得到模型。 張量:標量(單個)、向量(1維)、矩陣(2維)、張量(n維) 2、前向傳播 網路的

Deep Learning模型之:CNN卷積神經網路(一)深度解析CNN

http://m.blog.csdn.net/blog/wu010555688/24487301 本文整理了網上幾位大牛的部落格,詳細地講解了CNN的基礎結構與核心思想,歡迎交流。 1. 概述 卷積神經網路是一種特殊的深層的神經網路模型,它的特殊性體現在兩個方面,一方面它的神經元

Deep Learning學習 之 CNN程式碼解析(MATLAB)

MATLAB實現CNN一般會用到deepLearnToolbox-master。但是根據Git上面的說明,現在已經停止更新了,而且有很多功能也不太能夠支援,具體的請大家自習看一看Git中的README。 deepLearnToolbox-master是一個深度

機器學習(Machine Learning)與深度學習(Deep Learning)資料 之 相關論文和會議報告

介紹:對深度學習和representationlearning最新進展有興趣的同學可以瞭解一下介紹:主要是順著Bengio的PAMIreview的文章找出來的。包括幾本綜述文章,將近100篇論文,各位山頭們的Presentation。全部都可以在google上找到。介紹:20

深度學習之(十一)Deep learning中的優化方法:隨機梯度下降、受限的BFGS、共軛梯度法

三種常見優化演算法:SGD(隨機梯度下降),LBFGS(受限的BFGS),CG(共軛梯度法)。 1.SGD(隨機梯度下降) 隨機梯度下降(Stochastic Gradient Descent, SGD)是隨機和優化相結合的產物,是一種很神奇的優化方法,屬於

[深度學習之CNN] CNN的發展史 之LeNet、AlexNet、GoogLeNet、VGG、ResNet

CNN的發展史 上一篇回顧講的是2006年Hinton他們的Science Paper,當時提到,2006年雖然Deep Learning的概念被提出來了,但是學術界的大家還是表示不服。當時有流傳的段子是Hinton的學生在臺上講paper時,臺下的機器學習大牛們不屑一顧,質問你們的東西有理

C++知識回顧之__stdcall、__cdcel和__fastcall三者的區別

進行 pan span number 適用於 編譯器 api num 處理 __stdcall、__cdecl和__fastcall是三種函數調用協議,函數調用協議會影響函數參數的入棧方式、棧內數據的清除方式、編譯器函數名的修飾規則等。 調用協議常用場合 __stdca

Deep Learning基礎--線性解碼器、卷積、池化

sparse pca 過程 條件 連接 移動 .cn 計算過程 htm 本文主要是學習下Linear Decoder已經在大圖片中經常采用的技術convolution和pooling,分別參考網頁http://deeplearning.stanford.edu/wiki/i

經典卷積神經網絡(LeNet、AlexNet、VGG、GoogleNet、ResNet)的實現(MXNet版本)

lns dataset frame outer soft 想法 object googlenet bat 卷積神經網絡(Convolutional Neural Network, CNN)是一種前饋神經網絡,它的人工神經元可以響應一部分覆蓋範圍內的周圍單元,對於大型圖像

深度學習——卷積神經網絡 的經典網絡(LeNet-5、AlexNet、ZFNet、VGG-16、GoogLeNet、ResNet)

足夠 論文 ogl 相關性 spa 原因 線性 pad fan 一、CNN卷積神經網絡的經典網絡綜述 下面圖片參照博客:http://blog.csdn.net/cyh_24/article/details/51440344 二、LeNet-5網絡

Java基礎知識回顧之三 ----- 封裝、繼承和多態

get flex 防止 應用 需要 當前 nim lex aging 前言 在上一篇中回顧了java的修飾符和String類,這篇就來回顧下Java的三大特性:封裝、繼承、多態。 封裝 什麽是封裝 在面向對象程式設計方法中,封裝是指一種將抽象性函式接口的實現細節部份包裝、

課程一(Neural Networks and Deep Learning),第一週(Introduction to Deep Learning)—— 0、學習目標

1. Understand the major trends driving the rise of deep learning. 2. Be able to explain how deep learning is applied to supervised learning. 3. Unde

課程一(Neural Networks and Deep Learning),第二週(Basics of Neural Network programming)—— 1、10個測驗題(Neural N

--------------------------------------------------中文翻譯-------