CNCC2017中的深度學習與跨媒體智能

轉載請註明作者:夢裏茶

目錄

- 機器學習與跨媒體智能

- 傳統方法與深度學習

- 圖像分割

- 小數據集下的深度學習

- 語音前沿技術

- 生成模型

- 基於貝葉斯的視覺信息編解碼

- 珠算:基於別噎死推斷的深度生成模型庫

- 圖像與視頻生成的規則約束

- 景深風景生成

- 骨架約束的人體視頻生成

- 跨媒體智能

- 視頻檢索的哈希學習

- 多媒體與知識圖譜

- 基於錨圖的視覺數據分析

- 視頻問答

- 細粒度分類

- 跨媒體關聯與檢索(待補充)

正片開始

傳統方法與深度學習

圖像分割

圖像分割是醫療圖像中一個很重要的任務,通常分為分割,配準,可視化幾個子任務。這裏貼一張廣義的圖像分割的圖:

存在的困難:

- 不同目標區域亮度一致,區分度小,

- 不同目標區域邊界模糊,

- 圖像采集存在噪聲

常用分割步驟

檢測(定位)-> 邊界尋優

常用分割方法

- 按照圖像中區域的能量與聯系,建立

圖模型,用圖割,圖搜索的方法對圖像進行分割 外觀模型:特定的目標區域往往具有特殊的外觀,包括輪廓,形狀,可以用外觀模型進行匹配,做粗粒度的分割,或者對細粒度處理後的圖像進行校正- 多模態圖像處理:融合

結構信息和功能信息進行分割 - 對準兩個模型(結構和功能)的圖像,對兩個模型的預測結果進行約束(比如希望兩個模型的輸出相近)

雙模型交互叠代優化- 多邊形近似

- 對於某種目標區域,有著固定的多邊形外觀,可通過多邊形近似的方法,標記出圖像中近似的特征點

語音前沿技術

任務

降噪,增強,雜音分離,消除回響

結合領域知識和DNN

- 數據標註:結合領域知識提出需要標註哪些數據

- 不直接學習目標,而是根據領域知識將目標任務進行分解

- 比如識別字母,分解為識別摩擦音,爆破音 - 將傳統模型中裏程碑式的東西拿過來用

移動端語音挑戰

模型壓縮,輕量化

生成模型

基於貝葉斯的視覺信息編解碼

任務

- 視覺信息編碼:視覺信息通過人腦轉為神經活動的過程

- 視覺信息解碼:神經活動新號轉為視覺信息的過程

模型(基於卷積和反卷積的自編碼器)

- 推理網絡:卷積神經網絡,得到中間特征,建立中間特征與神經活動信號之間的關聯,從而得到神經活動得到編碼

- 生成網絡:將神經活動進行反卷積,得到圖像

- 對於兩個信號,學習兩個信號產生於同一對象的概率(相似度分析),建立起一個貝葉斯推斷模型

多視圖生成式自編碼器

除了視覺數據之外,還有其他模態的數據,可以根據多個模態的數據構建多視圖的生成時自編碼器

珠算:基於貝葉斯推斷的深度生成模型庫

任務

大數據中有許多不確定因素,需要學習對不確定性建模

模型

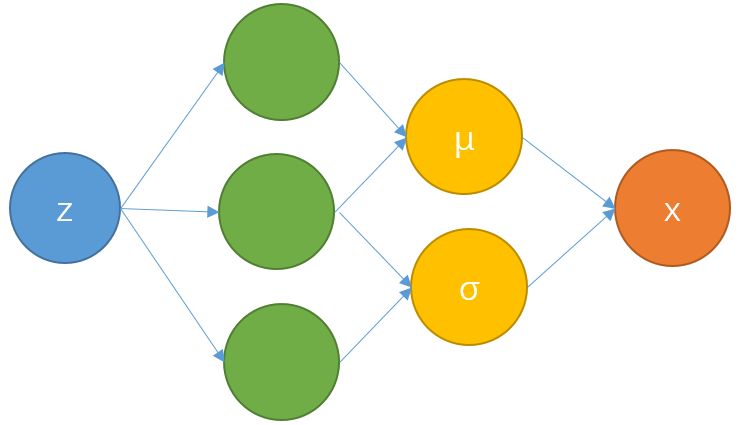

給定一個輸入z,用神經網絡學習變量x的分布的參數(均值和方差),約束生成樣本與真實樣本的相似性

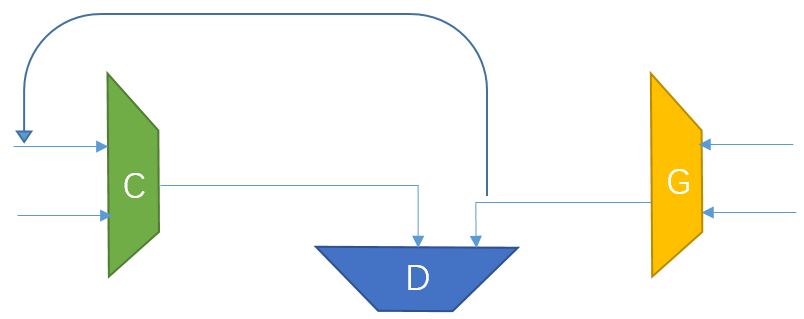

有約束的GAN

在GAN的基礎上,加一個分類器C,對生成器G生成的對象加中間約束,使得生成的對象更符合實際需求,比如生成不同姿態的人臉,要求不同人的人臉盡量不同,同個人的人臉盡量相同。

珠算

- 基於Tensorflow的python庫,無監督生成模型

- 貝葉斯推斷

- 適合傳統多層貝葉斯推斷模型以及深度生成模型

- 可用於

- 多變量回歸

- 變分自編碼器實現 - http://zhusuan.readthedocs.io

圖像與視頻生成的規則約束學習

- GAN成為無監督領域的新框架

- WGAN,DCGAN

- 在生成中,往往通過隨機性引入創意 - 已有工作

- 人臉姿態轉換,人臉年齡轉換,人臉表情轉換

- 圖像超分辨率生成,畫風轉換,字體轉換,圖像轉視頻 - 應用

- 動畫自動制作,手語生成

- 視頻自動編輯(如生成不同天氣情況下的風景) 創意+規則約束+復雜場景+復雜交互

難點

- 解空間巨大:需要找出解所在的低維子空間

- 宏觀結構的一致性(視頻生成需要的像素感受野(pooling)很大,難以預測長期運動變化)

- 微觀結構的清晰度,要同時逼近多模分布,避免單模生成的結果不夠精確- 解決方法

用領域中的規則去約束GAN,加入破壞規則的代價

- 縮小預測空間,保證宏觀結構,加快細節生成

景深風景生成

- 難點:要求空間結構合理,不能有嚴重的模糊

- 約束:從現有風景圖像中對景深關系建模(對區域進行標註, 不同區域,即圖層,有不同的遠近限制)

- 建立位置和對象的關系,得到某個位置有某個對象的概率分布

- Hawkes過程模型

- 根據對象對圖層做分解,由概率約束建立圖層約束(樹在人之前的概率有多大)

- 層內DCGAN,層間LSTM聚合出整圖

骨架約束的人體視頻生成

- 骨架運動有約束

- 骨架提取很魯棒,可以得到很多有標簽知識(傳統方法用來提取知識),作為約束條件

- 靜圖+動作序列變動圖

- CNN編碼解碼,孿生網絡雙輸入進行生成

- 判別器:對生成和實際幀做Triplet loss優化

- gan loss和視頻相似度loss相加

- 交互運動視頻生成

視頻檢索的哈希學習

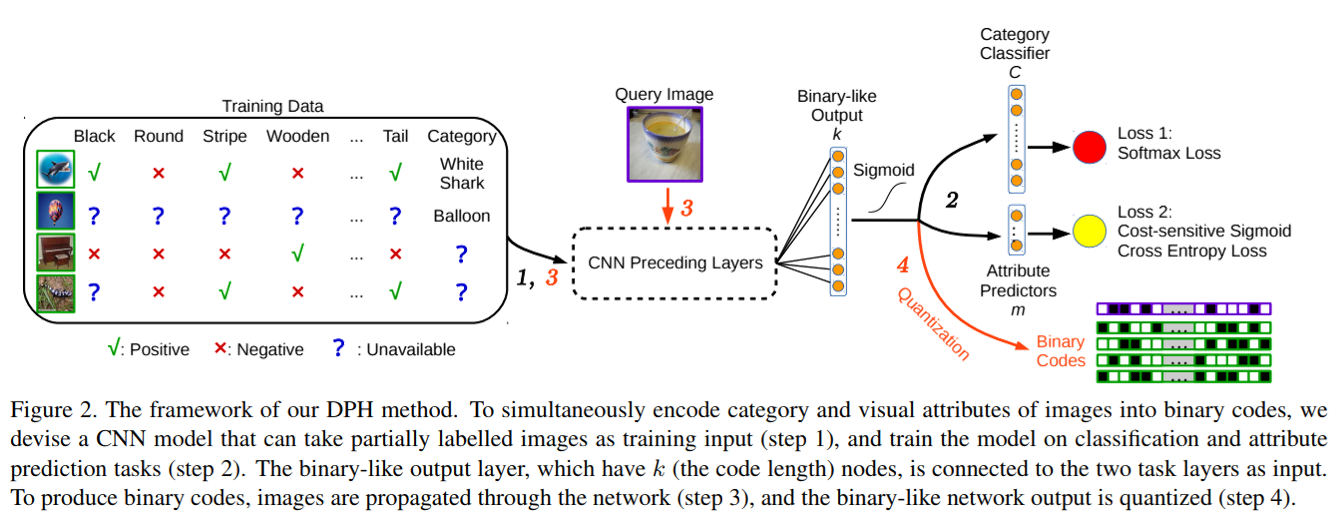

Learning Multifunctional Binary Codes for Both Category and Attribute Oriented Retrieval Tasks

視頻檢索基於圖像檢索,大規模圖像檢索對性能要求較高

- 圖像檢索

- 任務:通常圖像特征很大,直接檢索特征太慢

- 方法:

- 用二進制編碼出一個哈希值來表達特征

- 對哈希值做高效的異或運算求相似度

- 模型(添加了對二進制編碼的約束,希望絕對值與1盡量相近):

多媒體與知識圖譜

Cross-media analysis and reasoning: advances and directions

- 任務:

- 將文本,圖像,語音,視頻及其交互屬性進行混合

- 多源融合+知識演化+系統演化

- 難點:

- 解決語義鴻溝(機器認識世界是什麽)

- 意圖鴻溝(機器理解人要達到什麽目標)

- 離散的知識和連續的特征如何轉化如何關聯

- 典型問題:

- 跨媒體知識學習推理,多媒體情感分析

- 現狀:

- 機器學習助力多媒體效果很好

多媒體助力機器學習還不成熟

- 任務:

- 跨媒體深度分析和綜合推理

- 方法:

- 從淺層到深度

- 知識圖譜指導多媒體分析,屬性補全

- 深度學習+反饋(知識和規則進行反饋/強化學習)(黑箱方法)

- 統計推理,貝葉斯推理(白盒方法)

趨勢:

- 知識表達理解,多媒體理解

基於錨圖的視覺數據分析

- 圖學習

- 對視覺數據可以計算相似度,對於整個數據集就可以得到一個相似度矩陣,學過圖論的同學都知道,矩陣就是圖

- 相似度矩陣 -> 圖的鄰接矩陣 -> 用圖的方法對鄰接矩陣進行優化 - 標號建模 標號平滑 標號學習

- 錨圖學習(速度+)

- 這是一種coarse to fine的思路

- 利用數據點圖,生成錨點圖,先采一部分有代表性的數據(例如聚類中心)生成一個圖模型,然後推理出其他圖

- 圖模型中需要建立表示矩陣(特征工程),鄰接矩陣(度量學習),並加快相似度計算 - 高效錨圖(性能速度+)

- 從數學上優化錨圖的約束條件,使得優化問題的復雜度大大降低 - 層次化錨圖(速度++)

- 建立多層的錨圖,也就是對采樣點再采樣

- 錨點是線性增加的,也會增加得很快 - 對第一層采樣的點做再采樣,多層采樣減少了錨點數目,從最少的錨點的層逐層推理

- 標號預測器(速度+++)

- 優化對錨點的標號(打偽標簽進行半監督學習)

- 對最小的錨點層接一個優化器進行標號預測 - 主動學習(樣本選擇)

- 是一種hard mining的思路,選擇更有用的樣本作為錨點

- 減小標號的誤差損失 - 對比Google Expander Graph Learning平臺:經典方法,並行運算,而錨圖可以通過並行進一步提升速度

視頻問答

- 任務:

- 輸入視頻,問題,輸出答案

- 模型(層次記憶網絡+視頻時序推理):

- 對圖像進行分層

- 對問題進行記憶

- 用文本和圖像特征一同訓練生成答案

- 用LSTM做時序推理

細粒度分類

- 任務:

- 識別圖像同一大類中的子類 - 挑戰:

- 姿態視角不同導致類內差異大,外形顏色相似導致類間差異小

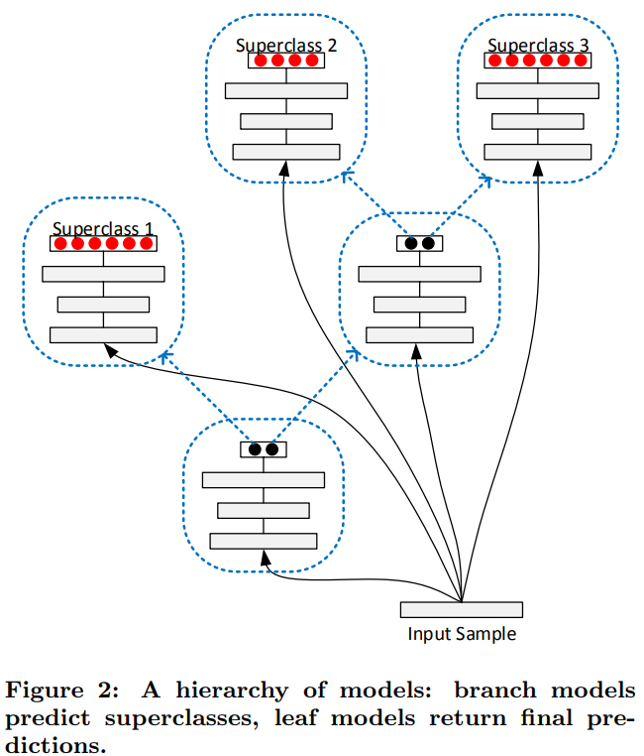

基於模型動態擴容的增量深度學習方法

論文:Error-Driven Incremental Learning in Deep Convolutional Neural Network for Large-Scale Image Classification

- 將目標的多個類別按相似度劃分為幾個大類,

- 增加一個新的類別時,將其歸入最相近的大類中,重用大類的參數,擴展小類分類層參數

- 利用類別子集合劃分實現模型動態擴容,利用特征遷移學習實現訓練加速(對類別做聚類)

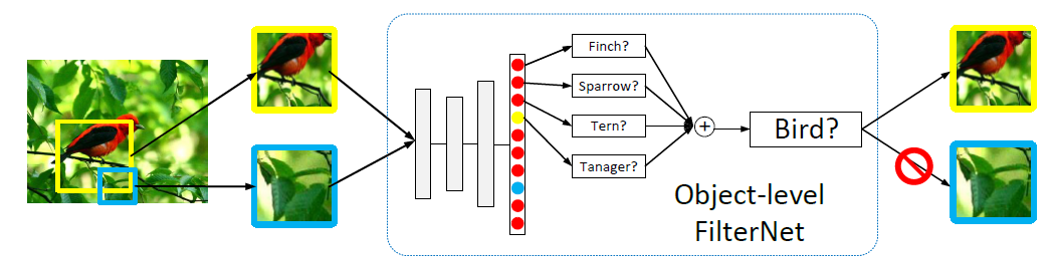

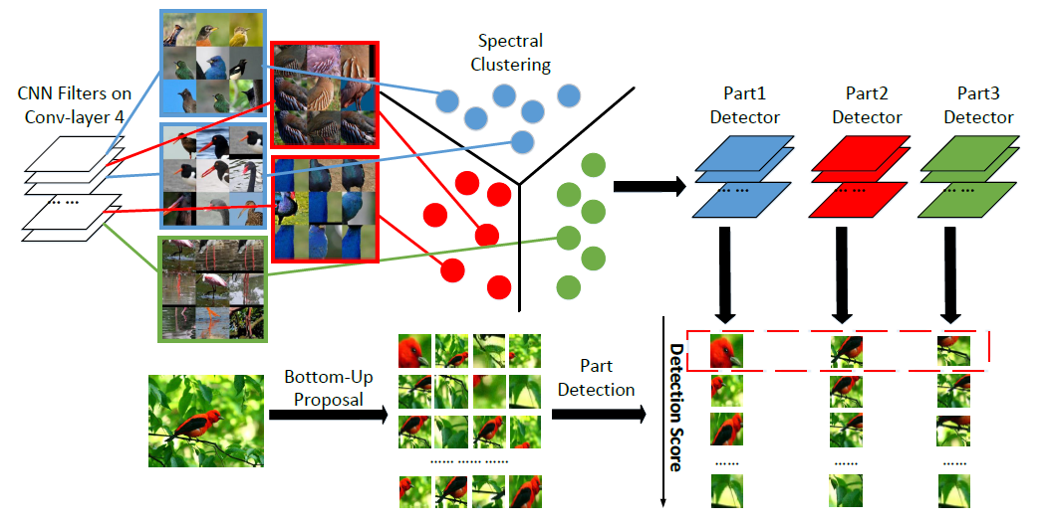

局部兩級註意力深度模型

The Application of Two-level Attention Models in Deep Convolutional Neural Network for Fine-grained Image Classification

給定圖片-類別,不給出對象位置(bounding box)和局部的位置(part location),用Attention學習對象位置和局部特征

- Object level: 首先用公開的數據集預訓練模型,top-down地作用在整圖上,選出跟目標相關的區域(響應度最高的區域),相當於摳圖,對摳過的區域再加上類別標簽進行遷移學習。

- Part level:

- 對於Object level得到的模型,對卷積層的filter做相似度聚類,同一類的卷積層合為一個part detector,用來為具體的對象局部做識別

- 結合總體評分和局部評分來對對象做細粒度分類

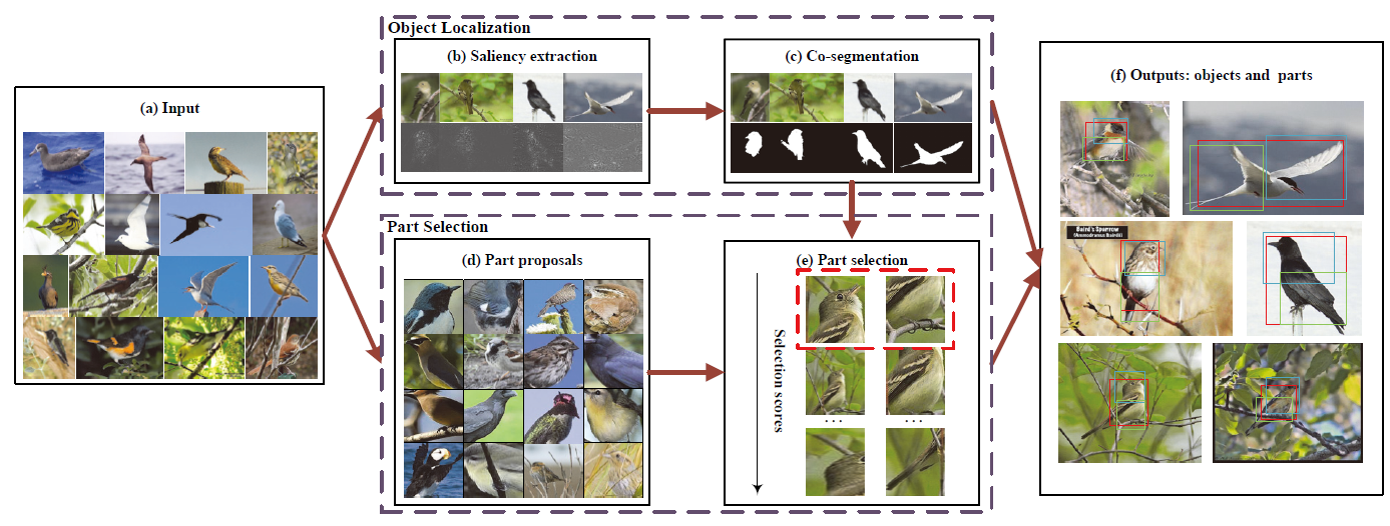

空間約束的顯著性部件選擇模型

Weakly Supervised Learning of Part Selection Model with Spatial Constraints for Fine-grained Image Classification

- 顯著性提取和協同分割定位對象

- 先通過顯著性聚類提出備選局部,

- 再對局部位置關系提出兩個空間約束:局部和整體必須有盡可能多的重疊,局部之間有盡可能少的重疊。

上面兩篇都是不需要局部組件的標註,就學到了局部的特征和約束

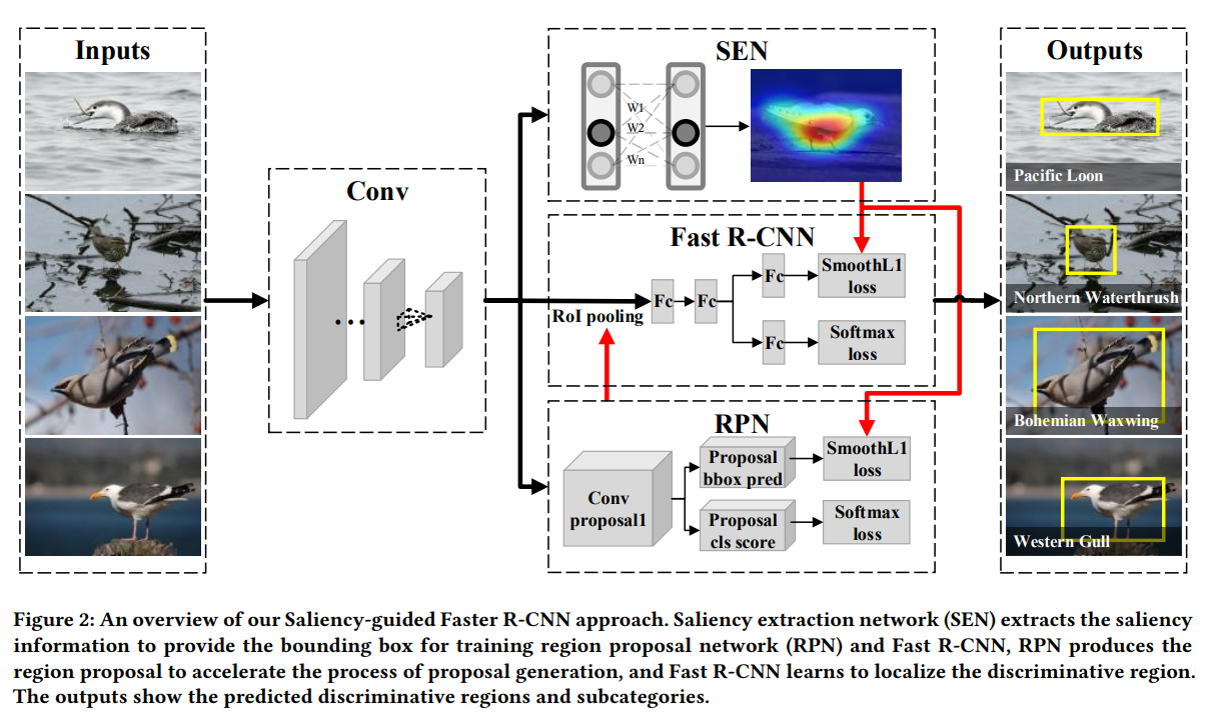

顯著性引導的細粒度辨識性定位方法

Fine-grained Discriminative Localization via Saliency-guided Faster R-CNN

結合分類模型和檢測模型做更高精度的細粒度分類

- 顯著性模型提供弱標記的圖片訓練faster r-cnn檢測模型

- 檢測模型提供更精確的備選區域進行分類

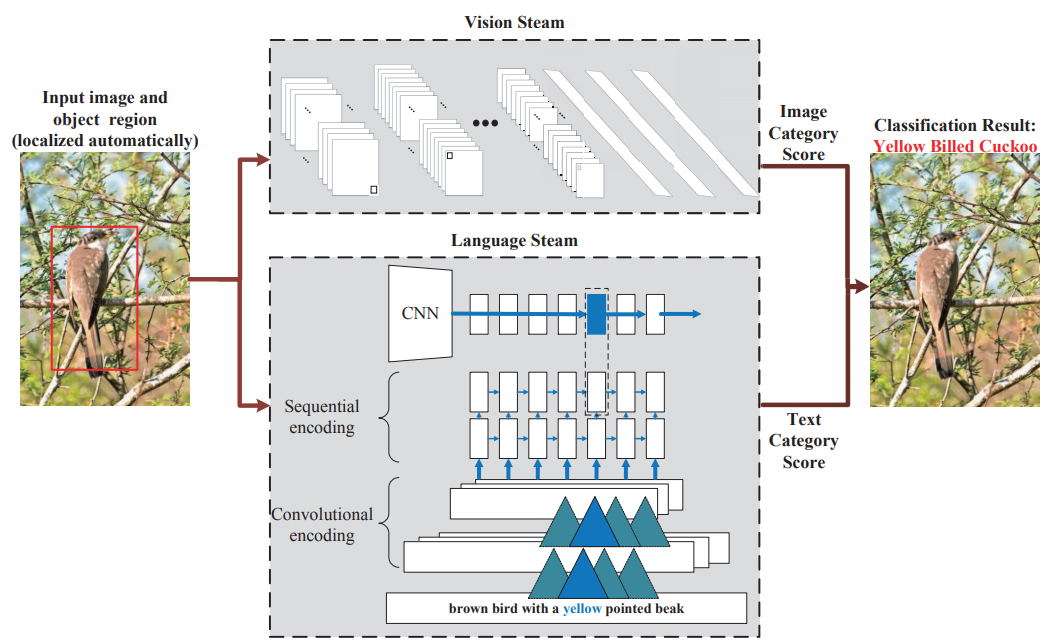

視覺文本聯合建模的圖像細粒度表示

Fine-grained Image Classification via Combining Vision and Language

- 在圖片數據集的基礎上,增加對圖片的描述文本,利用這兩個模態的數據提供更高精度的細粒度分類

- 卷積做圖像分類,CNN+LSTM做文本分類,兩個分類結果合起來

跨媒體關聯與檢索

- 跨媒體統一表征學習:使用相同的特征類型表征不同媒體的數據

- 跨媒體相似度計算:通過分析跨媒體關聯關系,計算不同媒體數據的語義相似性

這裏的六篇論文我還沒讀完,讀完之後補具體的理解

跨媒體關聯傳遞方法

IJCV2013: Exhaustive and Efficient Constraint Propagation

基於稀疏和半監督的統一表征方法

Learning Cross-Media Joint Representation With Sparse and Semisupervised Regularization

基於跨媒體語義單元的統一表征方法

Semi-Supervised Cross-Media Feature Learning with Unified Patch Graph Regularization

基於跨媒體多深度網絡的統一表征方法

Cross-media Shared Representation by Hierarchical Learning with Multiple Deep Networks

基於多粒度層級網絡跨媒體關聯學習方法

CCL: Cross-modal Correlation Learning with Multi-grained Fusion by Hierarchical Network

跨媒體混合遷移網絡方法

Cross-modal Common Representation Learning by Hybrid Transfer Network, IJCAI2017

跨媒體檢索數據集PKU-XMedia

- www.icst.pku.edu.cn/mlpl/XMedia

- 五種媒體類型(圖像、文本、視頻、音頻、3D)

- 10萬標註數據,200個語義類別,基於wordNet的層次結構

- 來自Wikipedia, Flickr, Youtube, Findsounds, Freesound, Yobi3D

CNCC2017中的深度學習與跨媒體智能