機器學習評價方法

阿新 • • 發佈:2017-12-12

論文 成了 har learning logs core 思想 img perf

剛開始看這方面論文的時候對於各種評價方法特別困惑,還總是記混,不完全統計下,備忘。

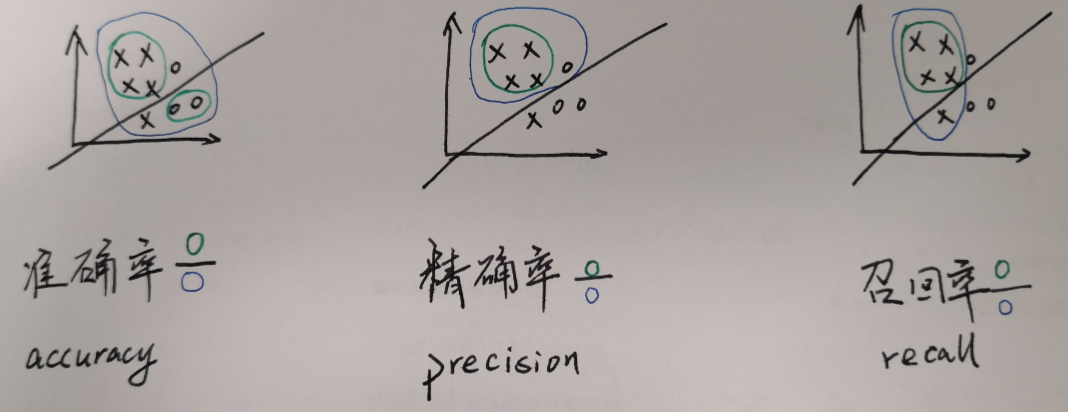

關於召回率和精確率,假設二分類問題,正樣本為x,負樣本為o:

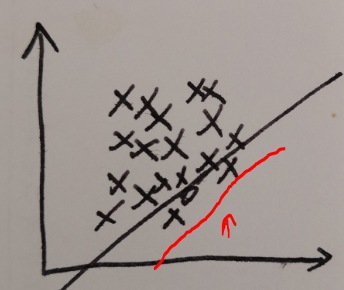

準確率存在的問題是當正負樣本數量不均衡的時候:

精心設計的分類器最後算準確率還不如直接預測所有的都是正樣本。

用Recall和Precision來衡量分類效果,可以使用F1 Score = 2PR/(P+R)來判斷分類效果。

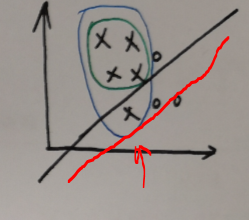

調整分類器,移動到這裏:

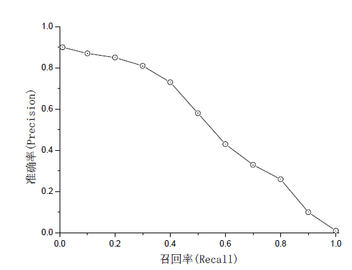

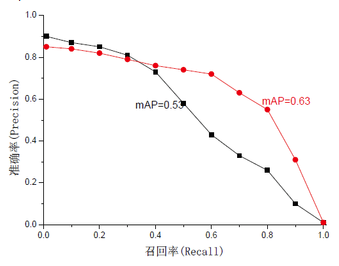

Recall達到百分之一百,但同時Precision也下降了:把不是負樣本也分類成了正樣本。一般來說,R高,P低,或者R低,P高。大概長這樣:

從這裏偷來的圖

一個好的分類方法當然是希望二者都盡量高,也就是右圖紅色線那樣,所以提出又提出了一個衡量標準:mAP=∫P(R)dR,(PR曲線面積越大越好)。

當然不同應用有不同需求,還是要根據具體應用設計。

記得微軟ECCV14的人臉檢測就是先用OpenCV裏的VJ方法,把Recall調得很高,盡量保證不漏檢,同時帶來的問題是Precision很低,有很多不是臉的東西,再通過3000幀人臉對齊方法,叠代幾次,一邊對齊人臉一邊把不是臉的排除掉。

另外還有 ROC AUC 及其他各種......

評價指標的很多思想在cousera Machine Learning week6 lecture11裏有

機器學習評價方法