使用Requests庫來進行爬蟲的詳解

Requests是用Python編寫,基於urllib,採用Apache2 Licensed開源協議的HTTP庫。它比urllib更方便,可以節約我們大量的工作,完全滿足HTTP測試需求。

安裝:

pip3 install requests

使用

例項:

import requests

response=requests.get('https://www.baidu.com')

print(type(response))

print(response.status_code)

print(type(response.text))

print(response.text) 各種請求方式

import requests

requests.post('http://httpbin.org/post')

requests.put('http://httpbin.org/put')

requests.delete('http://httpbin.org/delete')

requests.head('http://httpbin.org/get')

requests.options('http://httpbin.org/get')

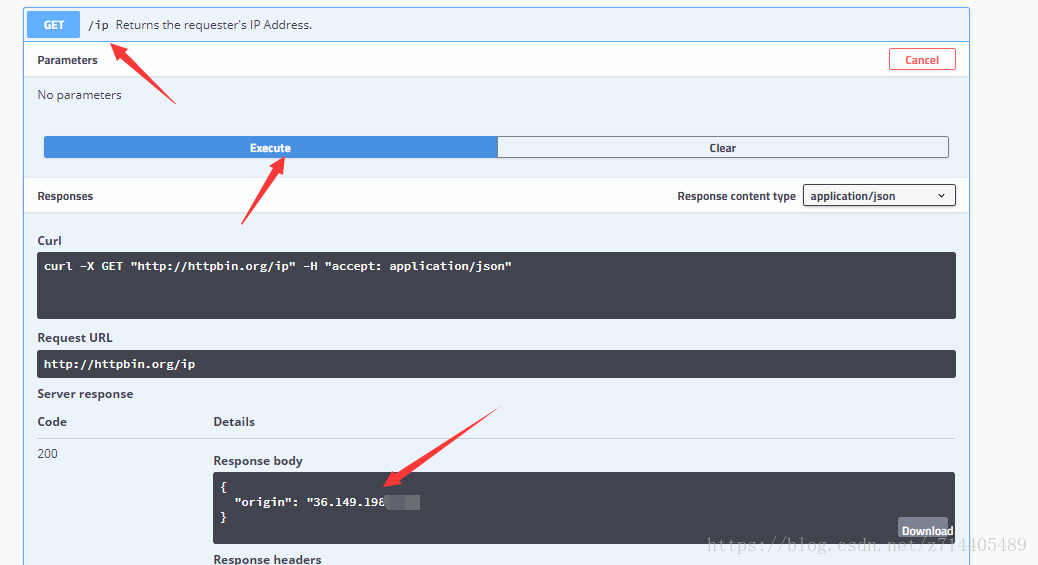

我們執行以上命令後,可以在這個網址進行驗證:

http://httpbin.org 這可以作為一個測試網址,它可以反饋一些我們請求時的資訊。例如:

可以檢視我們請求時的ip地址。

基本get請求

基本寫法

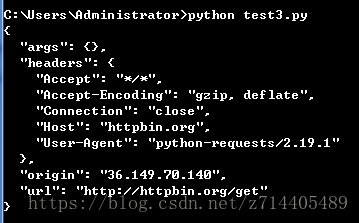

import requests

response=requests.get('http://httpbin.org/get')#用get方式傳送請求並獲得響應

print(response.text)#用text檢視響應內容

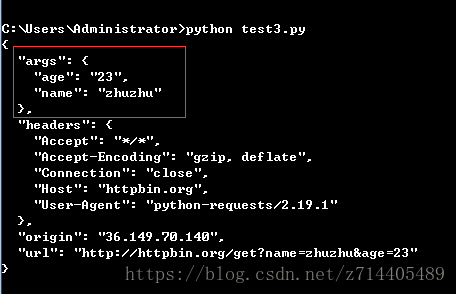

帶引數get

import requests response=requests.get('http://httpbin.org/get?name=zhuzhu&age=23') #將引數拼接到url後面,用問號分隔,引數間用&來分隔 print(response.text)

可以看到返回的args資訊中包含了我們的get引數。但是這種方法使用得不是很方便,再看下面的方式:

import requests

data={

'name':'zhuzhu',

'age':23

}

response=requests.get('http://httpbin.org/get',params=data)

#用字典的形式傳遞給params引數,不需要自己寫url編碼

print(response.text)

得到的結果與上面的方法是一樣的,但是方便了許多~

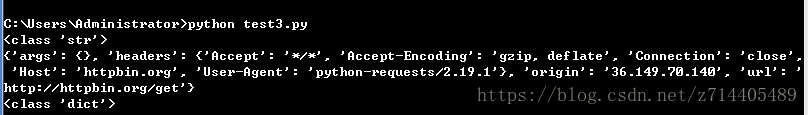

解析json

import requests

response=requests.get("http://httpbin.org/get")

print(type(response.text))

print(response.json())#把返回結果編碼成一個json物件

print(type(response.json()))

這個方法在返回一些AJEX請求時是比較常用的。

獲取二進位制資料

在下載一些內容(圖片、視訊)的時候常用的一個方法。

試試看,我們想要獲取一個github的圖示:

import requests

response=requests.get("https://github.com/favicon.ico")

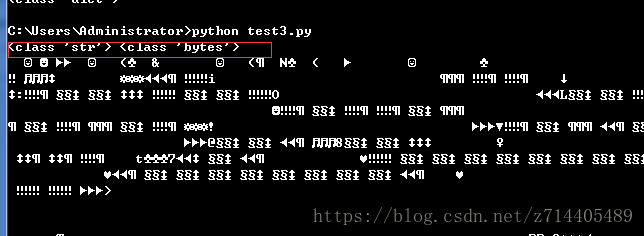

print(type(response.text),type(response.content))

print(response.text)

print(response.content)#可以使用content屬性來獲取二進位制內容

可以看到,在響應中,text的型別是string,而content的內容是bytes,也就是二進位制形式。

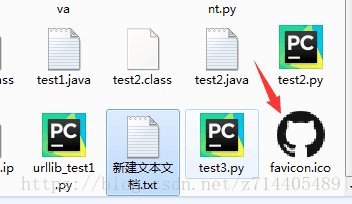

怎麼把這個圖示儲存到本地呢?我們已經知道怎麼獲取它的二進位制內容,現在只需要寫入檔案就可以了:

import requests

response=requests.get("https://github.com/favicon.ico")

with open('favicon.ico','wb')as f:

f.write(response.content)

f.close()

哈哈,成功儲存在執行目錄下了~

新增headers

headers在爬蟲中是非常必要的,很多時候如果請求不加headers,那麼你可能會被禁掉或出現伺服器錯誤…

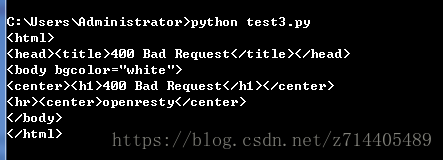

比如我們現在想爬取知乎上的資料,但是不加headers:

import requests

response=requests.get("https://www.zhihu.com/explore")

print(response.text)

那麼就會報錯,因為知乎是要識別你的瀏覽器資訊的。

我們現在加入headers試試看(做一個瀏覽器的偽裝),只需要向get方法傳入headers引數就好了:

import requests

headers={

'User-Agent':'Mozilla/5.0(Macintosh;Intel Mac OS X 10_11_4)AppleWebKit/537.36(KHTML,like Gecko)Chrome/52.0.2743.116 Safari/537.36'

}

response=requests.get("https://www.zhihu.com/explore",headers=headers)

print(response.text)

執行結果成功返回了響應資訊。

基本POST請求

直接用字典構造一個data並傳入方法,就可以實現post請求了,省去了編碼步驟,比起urllib方便許多:

import requests

data={'name':'zhuzhu','age':'23'}

response=requests.post("http://httpbin.org/post",data=data)

print(response.text)

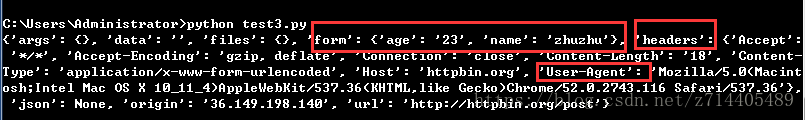

再加入headers:

import requests

data={'name':'zhuzhu','age':'23'}

headers={

'User-Agent':'Mozilla/5.0(Macintosh;Intel Mac OS X 10_11_4)AppleWebKit/537.36(KHTML,like Gecko)Chrome/52.0.2743.116 Safari/537.36'

}

response=requests.post("http://httpbin.org/post",data=data,headers=headers)

print(response.json())

可以看到,返回的json形式的響應中,我們成功添加了data和headers的資訊。

總結:get和post請求使用都很方便,區別只是換一下方法而已。

響應

response屬性

下面列出了常用的response屬性:

import requests

response=requests.get("http://www.jianshu.com")

print(type(response.status_code),response.status_code)#狀態碼

print(type(response.headers),response.headers)

print(type(response.cookies),response.cookies)

print(type(response.url),response.url)

print(type(response.history),response.history)

狀態碼判斷

常見的網頁狀態碼:

100: (‘continue’,),

101: (‘switching_protocols’,),

102: (‘processing’,),

103: (‘checkpoint’,),

122: (‘uri_too_long’, ‘request_uri_too_long’),

200: (‘ok’, ‘okay’, ‘all_ok’, ‘all_okay’, ‘all_good’, ‘\o/’, ‘✓’),

201: (‘created’,),

202: (‘accepted’,),

203: (‘non_authoritative_info’, ‘non_authoritative_information’),

204: (‘no_content’,),

205: (‘reset_content’, ‘reset’),

206: (‘partial_content’, ‘partial’),

207: (‘multi_status’, ‘multiple_status’, ‘multi_stati’, ‘multiple_stati’),

208: (‘already_reported’,),

226: (‘im_used’,),

Redirection.

300: (‘multiple_choices’,),

301: (‘moved_permanently’, ‘moved’, ‘\o-’),

302: (‘found’,),

303: (‘see_other’, ‘other’),

304: (‘not_modified’,),

305: (‘use_proxy’,),

306: (‘switch_proxy’,),

307: (‘temporary_redirect’, ‘temporary_moved’, ‘temporary’),

308: (‘permanent_redirect’,

‘resume_incomplete’, ‘resume’,), # These 2 to be removed in 3.0

Client Error.

400: (‘bad_request’, ‘bad’),

401: (‘unauthorized’,),

402: (‘payment_required’, ‘payment’),

403: (‘forbidden’,),

404: (‘not_found’, ‘-o-’),

405: (‘method_not_allowed’, ‘not_allowed’),

406: (‘not_acceptable’,),

407: (‘proxy_authentication_required’, ‘proxy_auth’, ‘proxy_authentication’),

408: (‘request_timeout’, ‘timeout’),

409: (‘conflict’,),

410: (‘gone’,),

411: (‘length_required’,),

412: (‘precondition_failed’, ‘precondition’),

413: (‘request_entity_too_large’,),

414: (‘request_uri_too_large’,),

415: (‘unsupported_media_type’, ‘unsupported_media’, ‘media_type’),

416: (‘requested_range_not_satisfiable’, ‘requested_range’, ‘range_not_satisfiable’),

417: (‘expectation_failed’,),

418: (‘im_a_teapot’, ‘teapot’, ‘i_am_a_teapot’),

421: (‘misdirected_request’,),

422: (‘unprocessable_entity’, ‘unprocessable’),

423: (‘locked’,),

424: (‘failed_dependency’, ‘dependency’),

425: (‘unordered_collection’, ‘unordered’),

426: (‘upgrade_required’, ‘upgrade’),

428: (‘precondition_required’, ‘precondition’),

429: (‘too_many_requests’, ‘too_many’),

431: (‘header_fields_too_large’, ‘fields_too_large’),

444: (‘no_response’, ‘none’),

449: (‘retry_with’, ‘retry’),

450: (‘blocked_by_windows_parental_controls’, ‘parental_controls’),

451: (‘unavailable_for_legal_reasons’, ‘legal_reasons’),

499: (‘client_closed_request’,),

Server Error.

500: (‘internal_server_error’, ‘server_error’, ‘/o\’, ‘✗’),

501: (‘not_implemented’,),

502: (‘bad_gateway’,),

503: (‘service_unavailable’, ‘unavailable’),

504: (‘gateway_timeout’,),

505: (‘http_version_not_supported’, ‘http_version’),

506: (‘variant_also_negotiates’,),

507: (‘insufficient_storage’,),

509: (‘bandwidth_limit_exceeded’, ‘bandwidth’),

510: (‘not_extended’,),

511: (‘network_authentication_required’, ‘network_auth’, ‘network_authentication’),

示例:

import requests

response=requests.get("http://www.baidu.com")

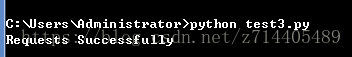

exit() if not response.status_code==200 else print("Requests Successfully")

這說明這次請求的狀態碼為200.

另一種寫法就是把數字200換位相應的字串內容,詳細的對應方式見上面列出的關係。

比如200對應著其中一個字串是“ok”,我們試試:

import requests

response=requests.get("http://www.baidu.com")

exit() if not response.status_code==requests.codes.ok else print("Requests Successfully")

可以看到效果是一樣的,可以根據實際情況選用。

高階操作

檔案上傳

import requests

files={'file':open('favicon.ico','rb')}

#通過files引數傳入post方法中,實現檔案的上傳

response=requests.post("http://httpbin.org/post",files=files)

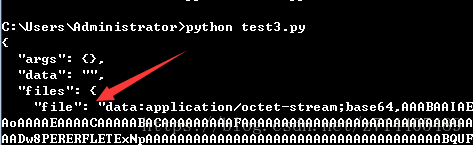

print(response.text)

這樣通過post請求,我們就完成了檔案的上傳,下圖file顯示的就是檔案的位元組流了:

獲取cookie

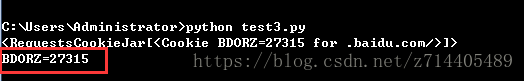

上面提到過,可以直接使用response.cookies就可以打印出cookie了。

實際上cookies是一個列表的形式,我們可以用for迴圈把每一個cookie取出來並且列印其key-value:

import requests

response=requests.get("http://www.baidu.com")

print(response.cookies)

for key,value in response.cookies.items():

print(key+'='+value)

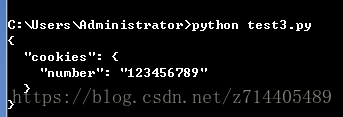

如上圖,非常方便地獲取到了cookie資訊。這比起urllib可要方便不少~

會話維持

基本上為了實現“模擬登入”的功能。

來看例子:

import requests

requests.get('http://httpbin.org/cookies/set/number/123456789')

#通過cookies/set方法來設定cookie

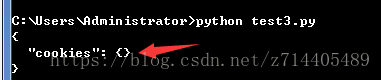

response=requests.get('http://httpbin.org/cookies')

print(response.text)

咦,cookies為空,和我們想象的不太一樣。這是因為上面那段程式碼中發起了兩次get請求,相當於兩個瀏覽器,相互獨立,所以第二次get並不能得到第一次的cookie。

那麼需要採用下面的方法,通過宣告Session物件來發起兩次get請求,視為一個瀏覽器中進行的操作:

import requests

s=requests.Session()

s.get('http://httpbin.org/cookies/set/number/123456789')

#通過cookies/set方法來設定cookie

response=s.get('http://httpbin.org/cookies')

print(response.text)

這回就成功了~

這個方法是比較常用的,用來模擬一個登入會話並維持之,這樣就可以獲取登入後的頁面了。

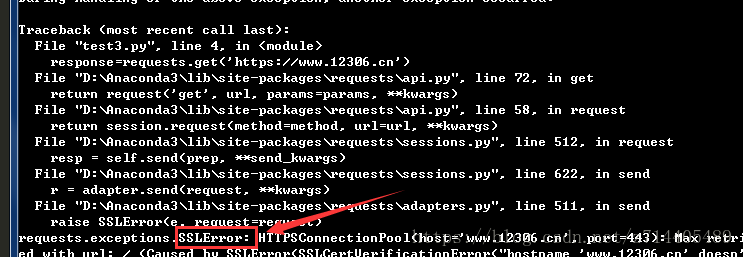

證書驗證

如果我們要爬取的是一個https協議的網站,那麼網站首先會檢查證書是否是合法的,若非法,會直接丟擲SSLError錯誤。如果要避免這種錯誤的話,可以把這個引數:verify設定為False就可以了(預設是True)。

先看未設定的:

import requests

response=requests.get('https://www.12306.cn')

print(response.status_code)

丟擲了SSLError錯誤。

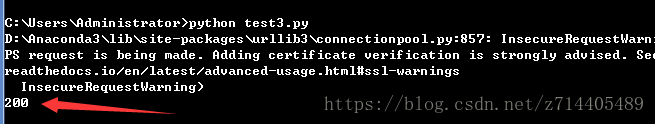

再看設定過的:

import requests

response=requests.get('https://www.12306.cn',verify=False)#把verify引數置否

print(response.status_code)

如此就返回了200的狀態碼,說明這個請求是正常的,沒有進行證書認證。

但是仍然會有警告資訊,提示你最好加上證書驗證。那麼怎麼消除這個警告資訊呢?

可以從原生包中匯入urllib3並使用其中的禁用警告這個方法:

import requests

from requests.packages import urllib3

urllib3.disable_warnings()#禁用警告資訊

response=requests.get('https://www.12306.cn',verify=False)

print(response.status_code)

這樣就不會有警告資訊了。

怎麼手動新增證書呢?

示例:通過cert來指定本地證書

import requests

response=requests.get('https://www.12306.cn',cert=('/path/server.crt','/path/key'))

print(response.status_code)

但由於我這兒沒有本地證書,就不進行演示了。

代理設定

可以通過字典形式構造一個引數,字典裡是你已經開通的代理ip。再把引數傳入get方法即可。

import requests

proxies={

"http":"http://127.0.0.1:9743",

"https":"https://127.0.0.1:9743"

}

response=requests.get("https://www.taobao.com",proxies=proxies)

print(response.status_code)

如果代理需要使用者名稱和密碼的時候怎麼辦呢?

我們可以在代理的url前面直接傳一個user:password,後面加個@符號,這樣我們就能傳入使用者名稱和密碼這個認證資訊了:

proxies={

"http":"http://uesr:[email protected]:9743/",

}

那如果代理方式不是https,而是一個socks型別的呢?

首先需要安裝,在命令列執行(windows環境下):

pip3 install request[socks]

安裝之後就可以使用這種形式的代理了。

import requests

proxies={

"http":"sock5://127.0.0.1:9743",

"https":"socks5://127.0.0.1:9743"

}

response=requests.get("https://www.taobao.com",proxies=proxies)

print(response.status_code)

超時設定

import requests

response=requests.get("https://www.taobao.com",timeout=1)

#設定一個時間限制,必須在1秒內得到應答

print(response.status_code)

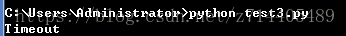

如果時間超出了限制,就會丟擲異常。怎麼捕獲這個異常呢?

import requests

from requests.exceptions import ReadTimeout

try:

response=requests.get("https://httpbin.org/get",timeout=0.5)

print(response.status_code)

except ReadTimeout:

print('Timeout')

成功捕獲了這個異常,並進行處理(報資訊)。

認證設定

有的網站在訪問時需要輸入使用者名稱和密碼,輸入之後才能看到網站的內容。

如果遇到這種網站,我們可以通過auth引數,把使用者名稱和密碼傳入。

import requests

from requests.auth import HTTPBasicAuth

r=requests.get('http://120.27.34.24:9001',auth=HTTPBasicAuth('user','123'))

#通過auth引數傳入。

print(r.status_code)

這樣就可以完成一個正常的請求,如果把auth引數去掉,那麼就會返回401引數(請求被禁止)。

異常處理

異常處理的部分還是比較重要的,它可以保證你的爬蟲不間斷地執行。

原則還是先捕獲子類異常,再捕捉父類異常(RequestException)。

import requests

from requests.exceptions import ReadTimeout,HTTPError,RequestException

try:

response=requests.get('http://httpbin.org/get',timeout=0.5)

print(response.status_code)

except ReadTimeout:#捕獲超時異常

print('Timeout')

except HTTPError:#捕獲HTTP異常

print('Http error')

except ConnectionError:#捕獲連線異常

print('Connection error')

except RequestException:#捕獲父類異常

print('Error')