spark2.2.2安裝和叢集搭建

阿新 • • 發佈:2018-11-06

1.環境準備

安裝Hadoop-2.7.2

安裝scala-2.11.8

安裝jdk-1.8.0_171

準備安裝包:spark-2.2.2-bin-hadoop2.7.tgz,並解壓至hadoop使用者目錄.

tar zxvf spark-2.2.2-bin-hadoop2.7.tgz

mv spark-2.2.2-bin-hadoop2.7 spark2.修改配置檔案

- .bash_profile

#新增

export SPARK_HOME=/home/hadoop/spark

export PATH=$SPARK_HOME/sbin:$PATH- spark-env.sh(從spark-env.sh.template拷貝)

#jdk安裝目錄 export JAVA_HOME=/usr/local/jdk1.8.0_171 #scala安裝目錄 export SCALA_HOME=/usr/local/scala-2.11.8 #hadoop安裝目錄 export HADOOP_HOME=/home/hadoop/hadoop #hadoop配置檔案目錄 export HADOOP_CONF_DIR=/home/hadoop/hadoop/etc/hadoop #master節點ip export SPARK_MASTER_IP=192.168.163.101 #每個worker節點能夠最大分配給exectors的記憶體大小 export SPARK_WORKER_MEMORY=1g #每個worker節點所佔有的CPU核數目 export SPARK_WORKER_CORES=1 #每臺機器上開啟的worker節點的數目 export SPARK_WORKER_INSTANCES=1

- slaves(從slaves.template拷貝)

centos7-1

centos7-2

centos7-3修改完成後,將spark目錄拷貝至各節點.

3.啟動

- 啟動hdfs

spark依賴hdfs,yarn可以不啟動.

start-dfs.sh- 啟動spark

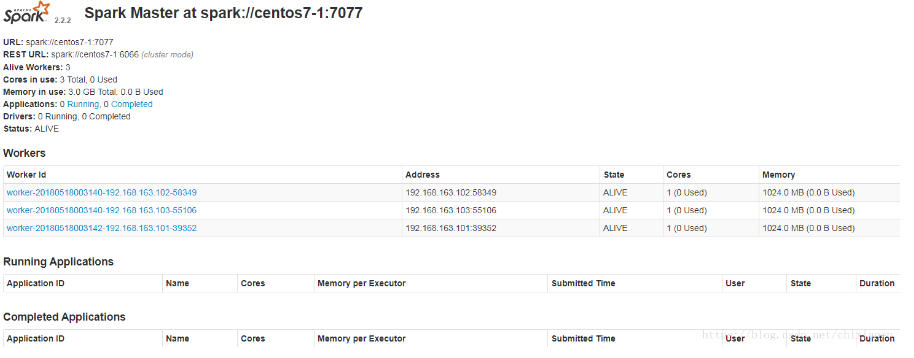

spark/sbin/start-spark.sh- 檢視程序

#主節點

Master

#工作節點

Worker

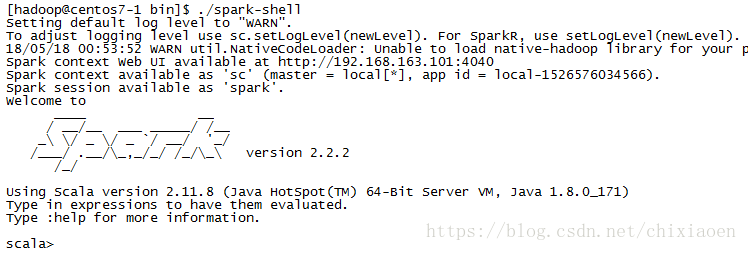

- spark-shell

spark/bin/spark-shell

- 檢視spark jobs