tensorflow中的reduce_xx系列函式

所謂reduce就是降維的意思,

我們以reduce_sum函式為例

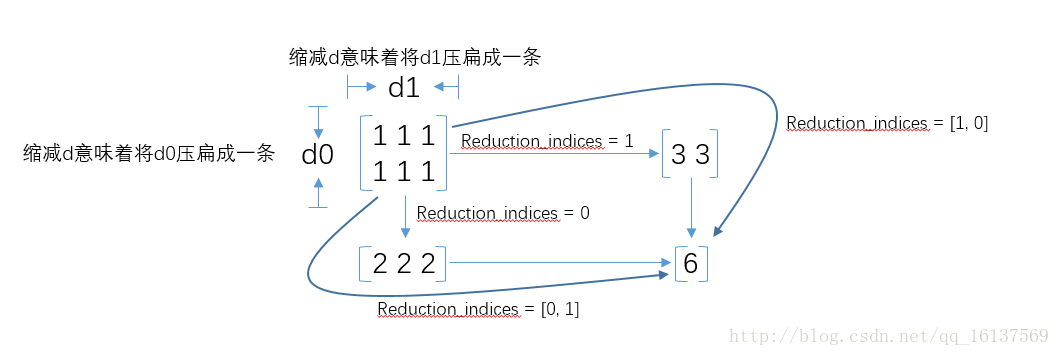

呼叫reduce_sum(arg1, arg2)時,引數arg1即為要求和的資料,arg2有兩個取值分別為0和1,通常用reduction_indices=[0]或reduction_indices=[1]來傳遞引數。

從上圖可以看出,當arg2(reduction_indices) = 0時,是縱向對矩陣求和(對行求和),原來矩陣有幾列就得到幾個值;相似地,當arg2(reduction_indices) = 1時,是橫向對矩陣求和(對列求和);當省略arg2引數時,預設對矩陣所有元素進行求和。

此外,reduction_indices=(0,1)意思是先在行上求和降維,然後在列上求和降維。

看到這裡,函式名的字首為什麼是reduce_其實也就很容易理解了,reduce就是“對矩陣降維”的含義,下劃線後面的部分就是降維的方式,在reduce_sum()中就是按照求和的方式對矩陣降維。那麼其他reduce字首的函式也舉一反三了,比如reduce_mean()就是按照某個維度求平均值,等等。

相關推薦

tensorflow中的reduce_xx系列函式

所謂reduce就是降維的意思, 我們以reduce_sum函式為例 呼叫reduce_sum(arg1, arg2)時,引數arg1即為要求和的資料,arg2有兩個取值分別為0和1,通常用reduction_indices=[0]或reduction_indices=[1]來傳遞引數。

tensorflow中的pad函式解釋

from: 說明:關於 tf.pad(...) 函式網上的解釋和官網都讓你看不懂,自己理解整理如下,希望可以幫到需要的人,以下內容只關注0擴充套件邊界 函式原型: tf.pad(input, paddings, name=None) input : 代表輸入張量 paddi

tensorflow 中tf.expand_dims函式用法

tf.expand_dims()(維度擴充套件)函式用法 tf.expand_dims(input,position,name) 其中input就是要擴充套件的變數,position就是選擇在那個位置上擴充套件維度,如果input原來是3維的,那麼p

關於tensorflow中的softmax_cross_entropy_with_logits_v2函式的區別

tf.nn.softmax_cross_entropy_with_logits(記為f1) 和 tf.nn.sparse_softmax_cross_entropy_with_logits(記為f3),以及 tf.nn.softmax_cros

Linux中exec系列函式的應用

這段時間在研究linux中使用者登陸和shell執行程式的原理。我們知道,shell命令分為內部命令和外部命令,內部命令有諸如cd,history,exit,echo等,常見的外部命令有ls,ping,netstat等,通過type命令可以檢視一個命令是內部命令還是外部命令

php中ob_start()系列函式的使用

我在看《php設計模式》的時候看到一個有趣的函式ob_start(),查了一下網友的部落格,滿心歡喜,我們在平時做模版快取會選擇Smart,實際上我們可以自己來,不借助其他工具,對於我這樣對程式碼控制慾強的人來說簡直好東西。輸出控制函式可以幫助我們自由的控制php指

Tensorflow中常用的函式總結(一)

1、tf.shape()和x.get_shape().as_list()的使用 (1) tf.shape() 先說tf.shape()很顯然這個是獲取張量的大小的,用法無需多說,直接上例子吧! import tensorflow as tf import numpy

TensorFlow中梯度下降函式

一 介紹下面介紹在TensorFlow中進行隨機梯度下降優化的函式。在TensorFlow中通過一個叫Optimizer的優化器類進行訓練優化。二 梯度下降優化器三 說明在訓練過程中先例項化一個優化函式如tf.train.GradientDescentOptimizer,並基

tensorflow中的常見函式(1)

1、tensorflow的基本運作 為了快速的熟悉TensorFlow程式設計,下面從一段簡單的程式碼開始: import tensorflow as tf #定義‘符號’變數,也稱為佔位符 a = tf.placeholder("float") b = tf.

Linux中backtrace()系列函式的應用例項

一、引言 backtrace()系列函式可用來輸出程式碼出錯時的函式呼叫關係。 A backtrace is the series of currently active function calls for the program. #include <ex

一文理解Tensorflow中reduce_mean() reduce_sum() reduce_max()...系列

原文medium部落格連結 在Tensorflow(TF)中,常常會看到“reduce_"系列的東西,比如reduce_sum,reduce_mean…,剛剛開始我覺得,求和就sum就行,為什麼加一個reduce_字首? 後來我意識到,每一次求和或者求平均值,其實都是自動的對Tens

tensorflow中的control_flow_ops.switch函式介紹

tensorflow中的control_flow_ops模組屬於tensorflow.python.ops中的一個模組,從switch函式的名稱上看就是一個開關函式。 函式:control_flow_ops.switch(data,pred,dtype=None,name=None) 功

tensorflow中常用的啟用函式

啟用函式(activation function)執行時啟用神經網路中某一部分神經元,將啟用神經元的資訊輸入到下一層神經網路中。神經網路之所以能處理非線性問題,這歸功於啟用函式的非線性表達能力。啟用函式需要滿足資料的輸入和輸出都是可微的,因為在進行反向傳播的時候,需要對啟用函式求導。 在Te

迴圈神經網路系列(三)Tensorflow中MultiRNNCell

迴圈神經網路系列(一) Tensorflow中BasicRNNCell 迴圈神經網路系列(二)Tensorflow中dynamic_rnn 經過前面兩篇博文,我們介紹瞭如何定義一個RNN單元,以及用dynamic_rnn來對其在時間維度(橫軸)上展開。我們今天要介紹的就是如何疊加多層

迴圈神經網路系列(二)Tensorflow中dynamic_rnn

1.回顧 上一篇博文(迴圈神經網路系列(一)Tensorflow中BasicRNNCell)中我們介紹了在Tensoflow中,每個RNN單元的實現,以及對應各個引數的含義。自那之後,我們就能通過Tensorflow實現一個單元的計算了。 import tensorflow as

迴圈神經網路系列(一)Tensorflow中BasicRNNCell

按道理看完RNN的原理之後,我們就應該來用某種框架來實現了。可偏偏在RNN的實現上,對於一個初學者來說Tensorflow的表達總是顯得那麼生澀難懂,比起CNN那確實是差了一點。比如裡面的引數就顯示不是那麼的友好。num_units到底指啥?原諒我最開始以為指的是RNN單元的個數。zer

對tensorflow中張量tensor的理解與tf.argmax()函式的用法

對tensorflow中張量tensor的理解: 一維張量: 如a=[1., 2., 3., 0., 9., ],其shape為(5,),故當我們選擇維度0時(張量的維度總是從第0個維度開始),實際上是在a的最外層括號上進行操作。 我們畫圖來表示: 二維張量: 如b=[

一、 tensorflow中有一類在tensor的某一維度上求值的函式。如:

一、 tensorflow中有一類在tensor的某一維度上求值的函式。如: 求最大值tf.reduce_max(input_tensor, reduction_indices=None, keep_dims=False, name=None) 求平均值tf.reduce_m

numpy中的arg系列函式

numpy中的arg系列函式 覺得有用的話,歡迎一起討論相互學習~Follow Me 不定期更新,現學現賣 numpy中arg系列函式被經常使用,通常先進行排序然後返回原陣列特定的索引。 argmax 將陣列排序後返回陣列元素從小到大依次排序的·最大的元素索引 argmin 將陣列排序後

JVMTI 中的JNI系列函式,執行緒安全及除錯技巧

JVMTI 中的JNI系列函式,執行緒安全及除錯技巧 jni functions 在使用 JVMTI 的過程中,有一大系列的函式是在 JVMTI 的文件中 沒有提及的,但在實際使用卻是非常有用的。這就是 jni functions.