tf.random_normal函式

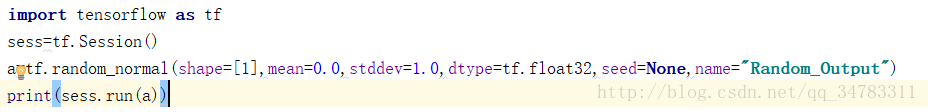

**tf.random_normal(shape, mean=0.0, stddev=1.0, dtype=tf.float32, seed=None, name=None)

函式的主要功能是實現從正態分佈中輸出隨機值

引數的意義:

shape: 一維的張量,也是輸出的張量。

mean: 正態分佈的均值。

stddev: 正態分佈的標準差。

dtype: 輸出的型別。

seed: 一個整數,當設定之後,每次生成的隨機數都一樣,如果想每次都生成不一樣,可以設定為None。

name: 操作的名字。**

程式碼如下:

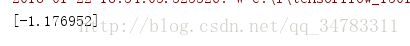

結果如下

相關推薦

tf.random_normal函式

**tf.random_normal(shape, mean=0.0, stddev=1.0, dtype=tf.float32, seed=None, name=None) 函式的主要功能是實現從正態分佈中輸出隨機值 引數的意義: shape: 一維的張量,也是輸出的張量。 m

TensorFlow函式之tf.random_normal()

tf.trandom_normal()函式是生成正太分佈隨機值 此函式有別於tf.truncated_normal()正太函式,請參考本部落格關於tf.truncated_normal()函式的介紹 (TensorFlow函式之tf.truncated_normal()) tf.ra

tensorflow中用正太分布隨機初始化網絡權重參數 ---tf.random_normal

generate tensor and .html 分布 sci pos 也有 隨機 https://www.tensorflow.org/api_docs/python/tf/random_normal numpy的random庫也有normal函數,功能類似,參數排列次

tf.py_func()函式

tensorflow由於構建的是靜態圖,所以導致在tf.Session().run()之前是沒有實際值的,因此,在網路搭建的時候,是不能對tensor進行判值操作的,即不能插入if…else…之類的程式碼。第二,相較於numpy array,Tensorflow中對tensor的操作介面靈活

tf.transpose函式的用法講解(多維情況,看似複雜,其實也簡單)

版權宣告:本文為博主原創文章,歡迎轉載,請標明出處。 https://blog.csdn.net/cc1949/article/details/78422704 tf.transpose函式中文意思是轉置,對於低維度的轉置問題,很簡單,不想討論,直接轉置就好(大家看下面文件,一看就懂)。 &

tf.argmax() tf.equal() tf.nn.softmax() eval tf.random_normal tf.reduce_mean tf.reduce_sum

先講幾個 函式 然後用程式碼測試一下 tf.reduce_sum input_tensor沿著給定的尺寸縮小axis。除非keepdims是真的,否則每個條目的張量等級減少1 axis。如果keepdims為真,則縮小尺寸將保留長度為1。 如果axis為None,則減小所有尺寸,並返

對tensorflow中張量tensor的理解與tf.argmax()函式的用法

對tensorflow中張量tensor的理解: 一維張量: 如a=[1., 2., 3., 0., 9., ],其shape為(5,),故當我們選擇維度0時(張量的維度總是從第0個維度開始),實際上是在a的最外層括號上進行操作。 我們畫圖來表示: 二維張量: 如b=[

TensorFlow學習(二):tf.random_normal() 和 tf.random_unform()

1. tf.random_normal() #正態分佈 tf.random_normal( shape, mean=0.0, stddev=1.0, dtype=tf.float32, seed=None, name=None ) Args:

tensorflow中tf.random_normal和tf.truncated_normal的區別

tensorflow中tf.random_normal和tf.truncated_normal的區別 原創 2017年06月24日 15:31:01 9322 1、tf.truncated_normal使用方法 tf

tf.strided_slice函式

在keras_yolo中model函式下的yolo_head下:grid_shape = K.shape(feats)[1:3] grid_shape: <tf.Tensor ‘strided_slice:0’ shape=(0,) dtype=int32> cifar10的例子中也有。 具體參

tf.py_func函式用來擴充套件tensorflow的靈活性

tf.py_func(func, inp, Tout) 在這裡第一個引數是核心,也就是一個使用者自定義的函式,輸入是numpy array,輸出也是numpy array,在該函式中,使用者可以自由的使用numpy 操作 第二個引數是inp,是func函式接受的輸入,是一個列表。 第三個

tf.slice()函式用法

import tensorflow as tf t = tf.constant([[1, 1, 1, 0], [2, 2, 0, 0], [3, 0, 0, 0], [4, 0, 0,

tf.cond()函式的用法

這個函式跟if...else...的功能很像,主要控制tensorflow中計算圖的張量的流向。官網中有對函式引數的解釋如下: tf.cond( pred, true_fn=None, fals

TensorFlow的tf.random_uniform()函式的用法

tf.random_uniform((6, 6), minval=low,maxval=high,dtype=tf.float32))) 返回6*6的矩陣,產生於low和high之間,產生的值是均勻分佈的。 import tensorflow as tf

tf.sigmoid()函式

tf.sigmoid 函式 tf.sigmoid函式具有以下所列的別名: tf.nn.sigmoid tf.sigmoid sigmoid( x, name=None ) 定義在:tensorflow/python/ops/math_ops.py。

tf.valuable_scope()函式/類用法

官網的解釋和例子實在是wast time,不用去看它了。 import tensorflow as tf a1 = tf.get_variable(name='a1', shape=[1], initializer=tf.constant_initializer(1)) with

tf.squared_difference函式

tf.squared_difference函式 From: https://www.w3cschool.cn/tensorflow_python/tensorflow_python-o6al2mig.html squared_difference( x, y, nam

tf.add_n函式的用法

tf.add_n([p1, p2, p3…])函式是實現一個列表的元素的相加。就是輸入的物件是一個列表,列表裡的元素可以是向量,矩陣,等 例如: import tensorflow as tf; import numpy as np; input1 = tf

tf.assign()函式簡單解釋

例項程式碼 import tensorflow as tf import os os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2' state = tf.Variabl

Tensorflow 十六 用tf.keras函式重寫Mnist識別

# coding=utf-8 import os os.environ["TF_CPP_MIN_LOG_LEVEL"]='2' # 只顯示 warning 和 Error #### Libraries # Standard library import pickle