Actor Critic學習筆記

什麼是Actor-Critic

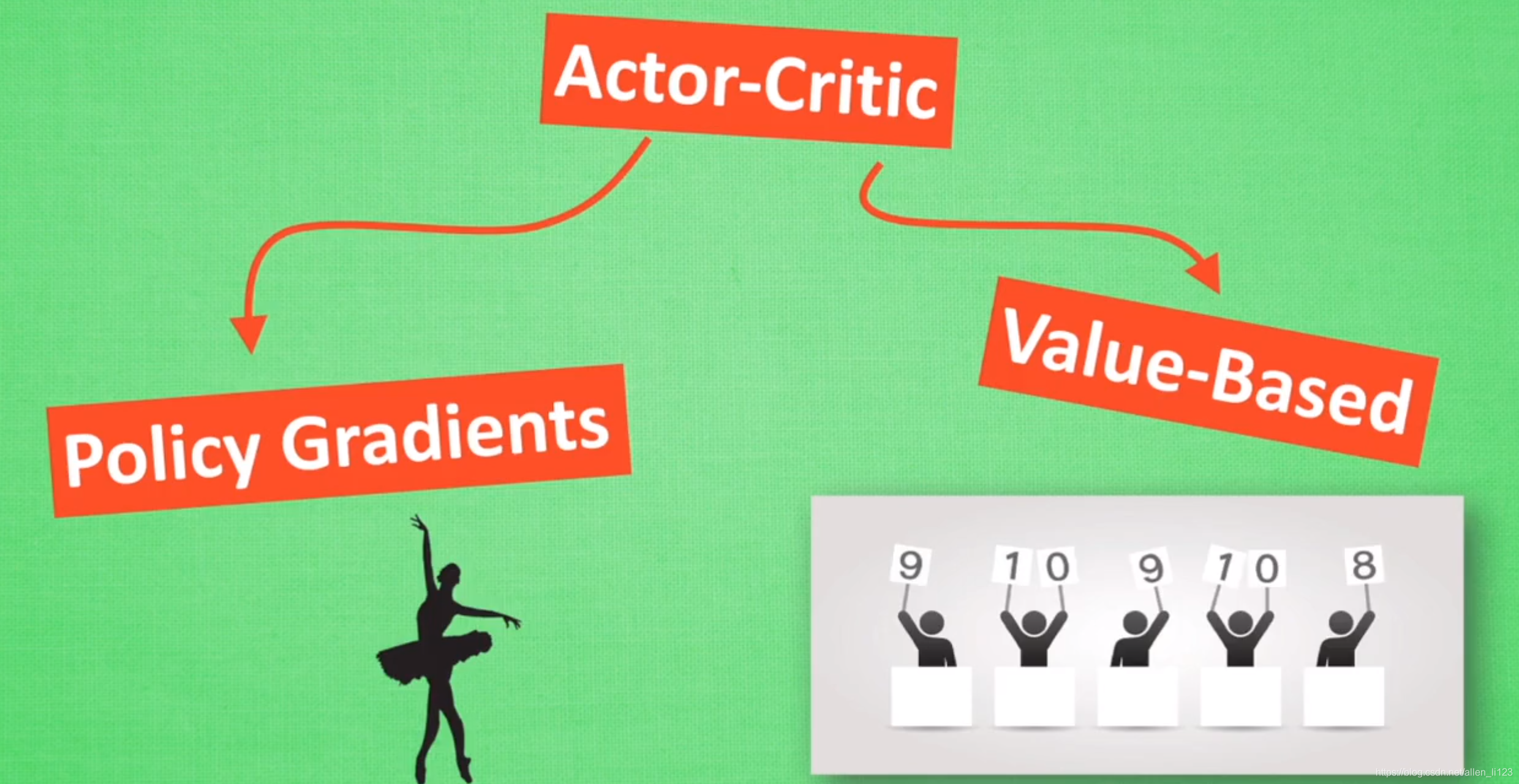

Actor-Critic 的 Actor 是 Policy Gradients,因為他直接根據概率進行選擇所以能夠很容易選出當前最優解,而Q-learning存在 選擇,不能及時選擇出當前最優解.但是 Policy Gradients 容易陷入區域性最優解,而且PG是回合更新,降低了學習效率。 Actor Critic 中的 Critic 是 Q-learning 或者其他的 以值為基礎的學習法 , 能進行單步更新,兩者結合就解決掉了彼此的缺點。

如何更新

現在我們有兩套不同的體系, Actor 和 Critic, 他們都能用不同的神經網路來代替 . 現實中的獎懲會左右 Actor 的更新情況,但是Policy Gradients 是根據回合結束後的獎懲來更新. 那麼如何讓Actor進行單步更新呢?我們用一個 Critic 去學習這些獎懲機制, 學習完了以後. 由 Actor 來進行動作採取, 由 Critic 來告訴 Actor 這些動作哪些獎勵高, 哪些獎勵低, Critic 通過學習環境和獎勵之間的關係, 能看到現在所處狀態的潛在獎勵, 所以用它來指點 Actor 便能使 Actor 每一步都在更新, 如果使用單純的 Policy Gradients, Actor 只能等到回合結束才能開始更新.

Actor-Critic的改進

Actor-Critic 涉及到了兩個神經網路, 而且每次都是在連續狀態中更新引數, 每次引數更新前後都存在相關性, 導致神經網路只能片面的看待問題, 甚至導致神經網路學不到東西. Google DeepMind 為了解決這個問題, 修改了 Actor Critic 的演算法。

將 DQN 網路加入進 Actor Critic 系統中, 這種新演算法叫做 Deep Deterministic Policy Gradient, 成功的解決的在連續動作預測上的學不到東西問題.