MapReduce配置遇到的問題和ubuntu 16.04下使用eclipse建立工程時卡死的解決方法

1、左邊欄的Project Explorer裡一直不出現DFS Locations.

發現在把hadoop-eclipse-plugin-2.6.0.jar放到eclipse下的pluins資料夾下並且eclipse -clean之後依舊不顯示,後來找到問題所在。

在Linux虛擬機器裡換了新的Eclipse,又重新配置MapReduce。

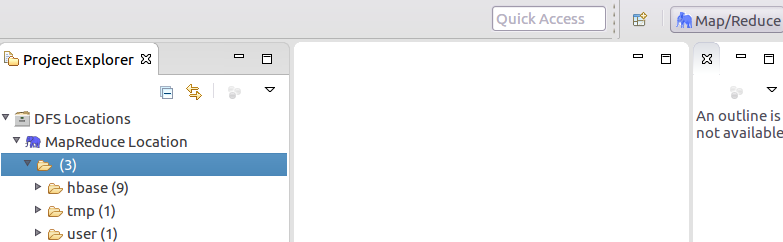

這次再把hadoop-eclipse-plugin-2.6.0.jar放到eclipse下的pluins資料夾下並且eclipse -clean之後,DFS Locations出現了。

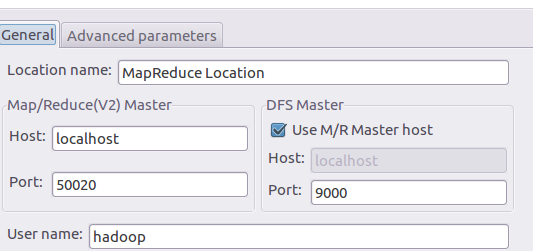

2、配置:

3、在配置好MapReduce的路徑和常規之後,將埠與hadoop配置的一致,之後能正常顯示hdfs下的檔案了。

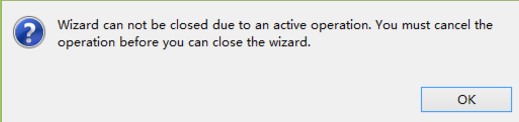

不過,新的eclipse出現了一個很大的問題,卡,非常卡,新建一個MapReduce專案卡了一下午,滑鼠變成了圓圈進度條轉了一下午,還關不掉。當我直接去關閉新建專案的視窗時,出現這個問題:

這就很皮,卡的要死還不讓關閉,直接關eclipse也是顯示這個。

最後百度查了之後,使用了這個命令:

1 kill -9 `ps -ef|grep program_name|awk '{print $2}'`

將無法關閉的eclipse強制關閉。

我本來以為是我把虛擬機器的記憶體開小了,或者是eclipse記憶體不夠才卡頓,後來發現在eclipse.ini裡配置了各個執行記憶體的大小後,eclipse啟動變快了,但是並不影響新建專案直接卡死。

總之在這裡走了很多彎路,試過了各種方法,最後走出一條可行的路,這裡記載下方法,以便以後再遇到類似的問題可以解決:

首先開啟終端,輸入export SWT_GTK3=0

然後使用終端開啟eclipse。

在eclipse資料夾下的eclipse.ini檔案中,找到:

1 --launcher.appendVmargs

在這個程式碼的前面,加上這兩行:

1 --launcher.GTK_version 2 2

問題迎刃而解,啟動eclipse正常使用了。

4.記錄一下dfs location連線的錯誤

這個是連線問題,配置裡出現了問題(沒有把那些引數的值和自己的hadoop配置時修改的值保持一致)

還有一個是hadoop版本和hadoop-eclipse-plugin-2.6.0.jar這個外掛的版本不匹配,也會報一個錯。