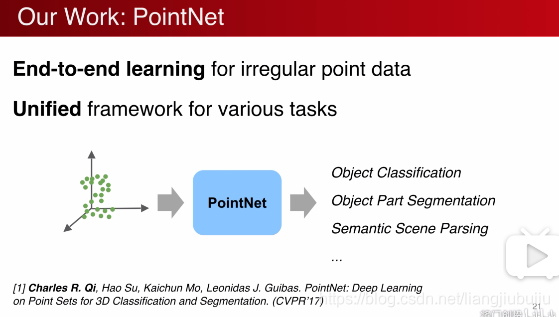

Pointnet&Pointnet++點雲上的深度學習及其在三維場景理解中的應用

-

- 轉化為柵格資料,使用CNN提取特徵

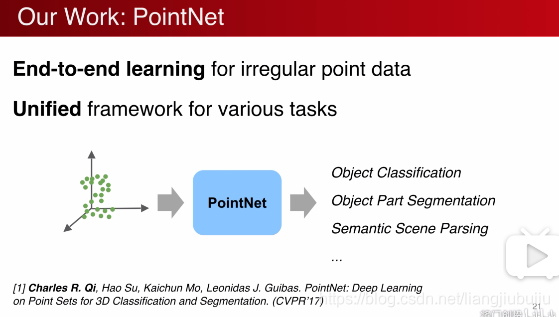

- 使用點雲的原生資料對特徵進行端到端的提取

螢幕剪輯的捕獲時間: 2018/11/17 21:36

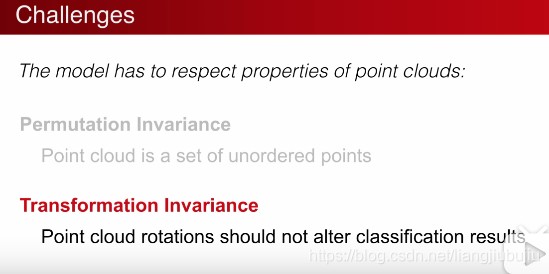

設計的演算法和網路對點雲需要滿足:

點排序置換不變性。

視角轉換不變性。

螢幕剪輯的捕獲時間: 2018/11/17 21:30

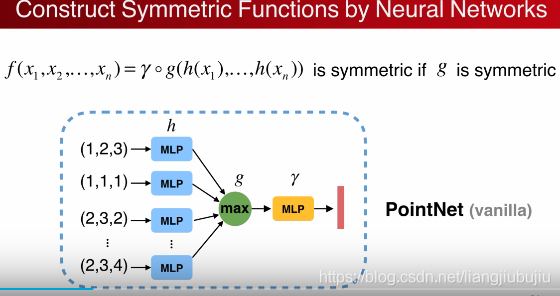

對稱函式的置換不變性,例如,取最大值、重心平均等保證點雲資料輸入的無序性。

先高維再降維的網路結構:

螢幕剪輯的捕獲時間

g=max-pooling, MLP=multi-payer perception

螢幕剪輯的捕獲時間: 2018/11/18 10:37

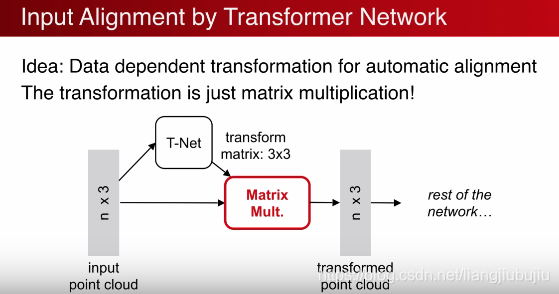

點雲的座標旋轉不影響分類原則,保證視角變換下,函式的適用性。

視角變換的對齊處理,當然也可以用來進行神經網路中間層的特徵變換處理。

螢幕剪輯的捕獲時間: 2018/11/18 10:43

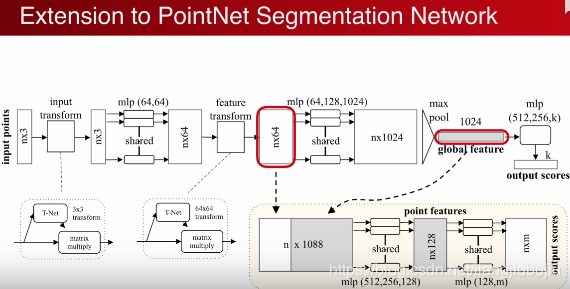

分類網路:(K類)

視角對齊-多層感知高維對映-特徵對齊-標準高維對映-對稱函式提取全域性特徵族(1024個)-多層高維對映-輸出分類

分割網路:(M類)

對每個點進行分類,單個點的特徵和全域性特徵結合,在全域性特徵族中尋找各自的位置。

![]()

螢幕剪輯的捕獲時間: 2018/11/18 10:51

螢幕剪輯的捕獲時間: 2018/11/18 10:53

螢幕剪輯的捕獲時間: 2018/11/18 10:54

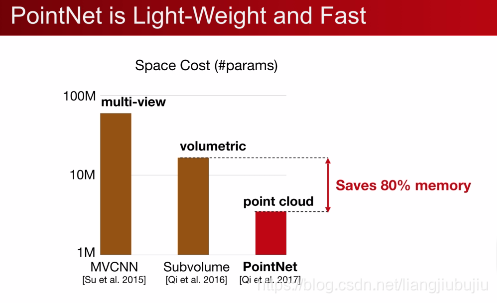

記憶體開支

螢幕剪輯的捕獲時間: 2018/11/18 10:55

計算複雜度開支

結論:適用於移動裝置和可穿戴裝置應用的演算法框架。

螢幕剪輯的捕獲時間: 2018/11/18 10:56

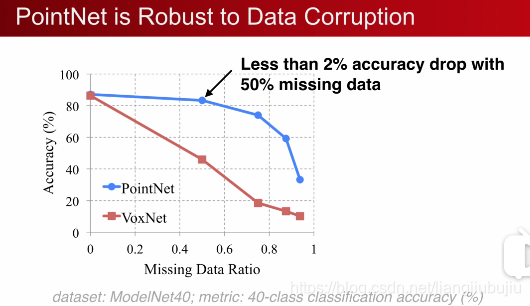

魯棒性分析,對丟失部分資料的場景分割。

螢幕剪輯的捕獲時間: 2018/11/18 10:57

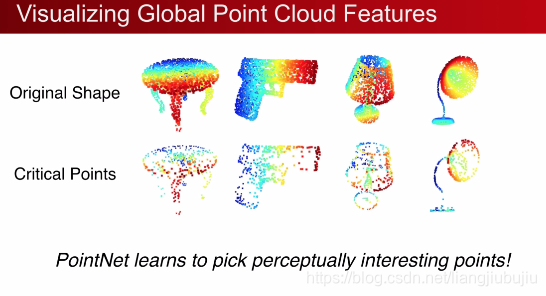

點雲對丟失資料魯棒性的解釋:少數的關鍵點是輪廓點,對場景分割任務或者分類任務起主導作用。

因此,對於輪廓特別清晰的圖片,點雲可以很優秀地學到特徵。

螢幕剪輯的捕獲時間: 2018/11/18 11:10

對於點雲資料,其難點在於當將一個場景中多個物體進行平移和旋轉後,點的座標發生了變換,每個點MLP後的特徵變化,MAX_POOLING後的全域性特徵族會發生變化,因此處理平移和旋轉不變性是關鍵的資料預處理任務。

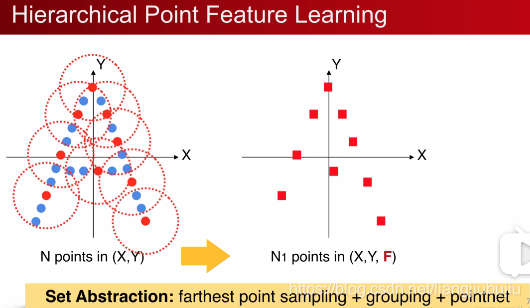

這裡提出在劃分的區域性小區域使用pointnet進行特徵提取和形狀向量表示,將一個複雜形狀用更加少的點座標和形狀向量表示。

螢幕剪輯的捕獲時間: 2018/11/18 11:16

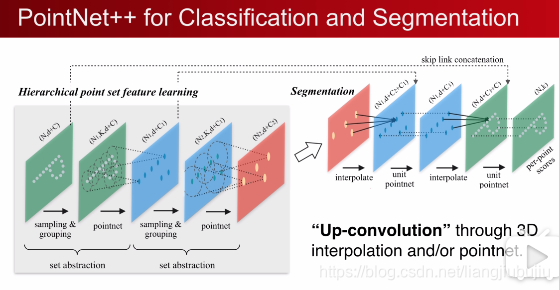

展示了兩層pointnet++,隨後可以使用插值或者是pointnet對原複雜圖形進行恢復。

螢幕剪輯的捕獲時間: 2018/11/18 11:20

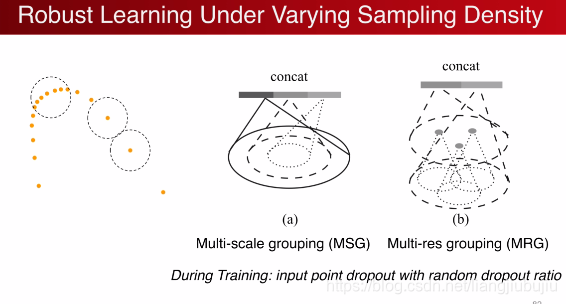

實驗:對同一幅圖片隨機位置減少點雲的數量,對比兩種網路的分類精確度。

如果kernel太小,類似於VGG,kernel選取3*3,由於點雲資料具有采樣率不均勻的性質,近處取樣點多遠處取樣點少,導致輸入圖片的取樣率對網路的影響很大。

螢幕剪輯的捕獲時間: 2018/11/18 12:02

取樣率不均勻的解決方案。

PiointNet++總結:

-

- pointnet區域性特徵學習,平移和視角變換的不變性。

- 部分填充資料丟失的魯棒性。

- 取樣率變化的魯棒性。

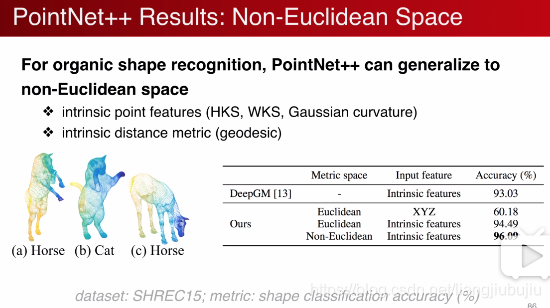

- 外形相似的分類魯棒性,如下。

螢幕剪輯的捕獲時間: 2018/11/18 12:06

螢幕剪輯的捕獲時間: 2018/11/18 14:00

應用場景:

-

- 分類

- 部分分割

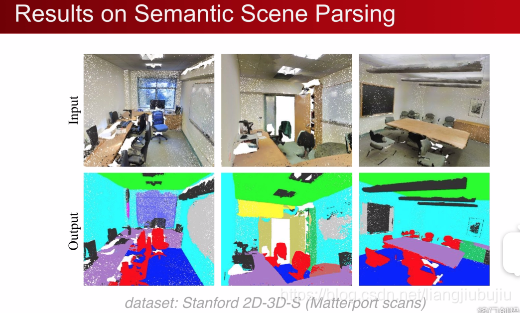

- 3D場景語義分割(semantic segmentation)

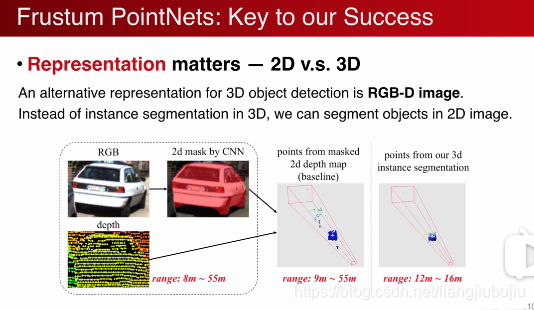

2D+Depth map輸入神經網路。

3D神經網路。

螢幕剪輯的捕獲時間: 2018/11/18 13:17

螢幕剪輯的捕獲時間: 2018/11/18 13:20

對點雲進行矩陣的乘法,完成座標系的歸一化,在進行物體檢測與分割,準確度大大提升。

缺點:2D資料的解析度較高,texture紋理豐富;3D做不到。今後可能是2D和3D資料結合。

螢幕剪輯的捕獲時間: 2018/11/18 13:23

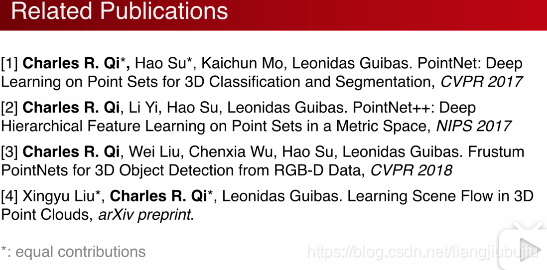

相關研究組:

Standford

Berkeley

MIT

SPLATNet: Sparse Lattice Networks for Point Cloud Processing

來自 <https://arxiv.org/abs/1802.08275>