如何啟動hadoop以及如何查詢hadoop服務是否起來了

重啟了下虛擬機器,hive連線半天都連線步上,想了想好像是hadoop都沒執行。

準備執行的時候,連hadoop怎麼啟動都忘了,這個水平怎麼面試呢。

所以趕緊記下來。

啟動方式:

/usr/local/hadoop/sbin$ start-all.sh

在hadoop安裝目錄下進sbin目錄,執行以上命令。

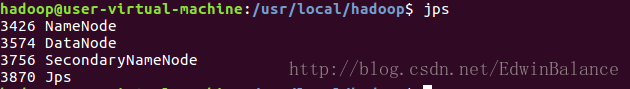

啟動完成後,輸入命令jps來判斷是否啟動成功

若成功啟動則會列出如下程序: “NameNode”、”DataNode” 和 “SecondaryNameNode”

成功啟動後,可以訪問 Web 介面 http://localhost:50070

能夠訪問localhost:9870 就說明啟動成功

相關推薦

如何啟動hadoop以及如何查詢hadoop服務是否起來了

重啟了下虛擬機器,hive連線半天都連線步上,想了想好像是hadoop都沒執行。 準備執行的時候,連hadoop怎麼啟動都忘了,這個水平怎麼面試呢。 所以趕緊記下來。 啟動方式: /usr/local/hadoop/sbin$ start-all.sh 在hadoop安裝目錄下進

【Hadoop】hiveserver2 不能啟動端口 10000 開啟服務的相關經驗總結

error: pro mon 進行 org multipl html pen exp 轉載來自http://blog.csdn.net/lsttoy/article/details/53490144。 這個問題困擾了我三天,各種查資料踩坑填坑的嘗試,終於搞定了這個

大資料Hadoop系列之Hadoop服務開機自啟動配置

1. 編寫執行指令碼 $ sudo cd /etc/init.d $ sudo vi hadoop #!/bin/bash #chkconfig:35 95 1 #description:script to start/stop hadoop su - hadoop

Hadoop分別啟動NN DN SN等服務

查詢當前解壓檔案之後,hadoop2.7.3的預設配置檔案, 四個檔案的.xml, 1.core-default.xml common\hadoop-common-2.7.3.jar 2.hdfs-default.xml

安裝hadoop和配置hadoop,啟動namenode和設置免密登錄的詳細解析!

啟動namenode和hadoop的配置首先安裝hadoop要安裝好java的開發環境,配置好jdk其實創建一個hadoop的用戶cd到這個用戶的目錄下創建一個apps的目錄。以後所有的東西都解壓進入apps解壓後的目錄中的文件如下這裏lib是本地的庫!bin是自己的操作命令,sbin是啟動命令!etc是配置

大資料元件之----HIVE,win10下安裝以及配置hadoop詳細步驟

HIVE其本質是以Hadoop作為基礎的資料倉庫基礎設施。其中hadoop為資料的儲存和執行在商業機器上提供了可擴充套件以及容錯性的可能,其中容錯性可通過副本來進行理解。 目標: HIVE是讓資料彙總更加簡單和針對大容量資料的查詢和分析,提供了SWL來使得使用者可以更簡單查詢,彙總和資料分析

Hadoop YARN中web服務的REST API介紹

本文轉自: 轉載自過往記憶(https://www.iteblog.com/) 歡迎前往原部落格檢視學習,還參考此篇部落格:https://blog.csdn.net/lumingkui1990/article/details/52175263 Hadoop YARN自帶了一系列的web

安裝 Hadoop 以及 Hadoop 的目錄結構

搭建 Hadoop 的環境 安裝 JDK,關閉防火牆。 JKD 的安裝請自行百度。 檢視防火牆狀態:systemctl status firewalld.service 關閉防火牆:systemctl stop firewalld.service(如果重啟,則會重啟防火牆)

安裝hadoop以及部署本地模式(單詞詞數統計程式)

準備實驗的環境: 1、安裝Linux、JDK 有關centOS安裝詳見:https://blog.csdn.net/zxdspaopao/article/details/83277479 有關jdk安裝詳見:https://blog.csdn.net/zx

linux下【centos】nginx自動原始碼編譯安裝指令碼,以及通過service 啟動/停止/過載 nginx的服務指令碼

第一:指令碼為nginx原始碼編譯安裝的指令碼,可以幫助使用者自動建立系統使用者“nginx”;可以使用者自己指定安裝路徑,配置檔案路徑,執行檔案路徑等; 第二:可以配置第二個指令碼使用,通過service服務來管理nginx。 [[email protect

Hadoop快速入門 -- (Hadoop叢集的配置及啟動 含編譯軟體)

hadoop: hdfs叢集:負責檔案讀寫 yarn叢集:負責為mapreduce程式分配運算硬體資源 name node 本身的地位是很重要的,它記錄了使用者上傳的檔案分別在哪些dat node 上,記錄了這些檔案的元資訊.所以它叫名稱節點,記錄了檔案的名稱和

Init.d的作用以及如何配置服務自啟動(mysql踩坑集錦)

我用的第三種方法安裝的,這些坑困住了我2天,真心煩,好在都解決了。 坑1:第一個錯誤應該是報的 mysqld: Can't create directory '/usr/local/mysql/data/' 這問題是我自己把mysql目錄裝在了別的目錄,沒有安

day06.Hadoop快速入門&雲服務三種模式IaaS,PaaS和SaaS【大資料教程】

day06.Hadoop快速入門&雲服務三種模式IaaS,PaaS和SaaS【大資料教程】1. HADOOP背景介紹1.1 什麼是HADOOP1). HADOOP是apache旗下的一套開源軟體

Systemd服務啟動管理以及awk命令詳解

1、簡述systemd的新特性及unit常見型別分析,能夠實現編譯安裝的如nginx\apache實現通過systemd來管理 Systemd: POST--BIOS--Bootloader(MBR)--Kernel(ramdisk)--rootfs--/sbin/in

Hadoop以及元件介紹

一、背景介紹 在接觸過大資料相關專案的時候常常都會聽到Hadoop這個東西,簡單來說,他是一個用分散式計算來處理大資料的開源軟體,下面包含了許多的元件和子專案,這篇文章將會介紹Hadoop的原理以及一些元件的應用。 二、準備工作 1、確認儲存規模 有很多的大資料專案其實資料量跟本沒這麼

藍芽上層協議,服務端的啟動,獲取以及藍芽裝置的連線

1,藍芽協議/服務端的啟動 上一篇文章中,分析了Bluetooth.apk啟動過程,啟動Bluetooth.apk時,一般啟動了AdapterService這一對應的服務。檢視package/app/Bluetooth的原始碼,裡面主要是一些具體的協議,其中每一個協議對應一

Hadoop HDFS 配置、格式化、啟動、基本使用Hadoop MapReduce配置、wordcount程式提交

Hadoop的安裝方式 單機:所有的服務執行在一個程序裡面,開發階段才會使用 分散式:將多個服務(JVM),分別執行在多臺機器上。 偽分散式:將多個服務(JVM)執行在一臺機器上 Hadoop偽分散式安裝 文件:http://hadoop.a

PHP環境搭建以及解決wampapache服務啟動不了的問題

由於工作需要,現在開始研究PHP語言。剛開始搭建伺服器環境就困難重重啊。首先看了下配置說明,很複雜很複雜(超級想念Visual Studio)。然後問了下群裡的老鳥,他們都是安裝WAMPServer環境包,裡面包含了PHP、MYSQL、Apache環境。所以就在Php100下載了一個(傳送門:WAMPSe

查詢Hadoop-2.7.3版本的預設配置檔案

1.core-default.xml:【hadoop-common-2.7.3.jar】 2.hdfs-default.xml:【hadoop-hdfs-2.7.3.jar】 3.mapred-default.xml:【hadoop-mapreduce-client-co

大資料開發面試部分:正常工作的Hadoop叢集中Hadoop都分別需要啟動哪些程序,它們的作用分別是什麼(大資料開發面試)

啟動的程序: namenode socondarynamenode datanode ResourceManager(JobTracker)JobTracker NodeManager(TaskTracker) DFSZKFailoverController J