Spark學習之RDDs介紹

什麼是RDDS?

RDDS即Resilient distributed datasets(彈性分散式資料集)。

Spark中,所有計算都是通過RDDs的建立,轉換,操作完成的。

一個RDD是一個不可改變的分散式集合物件。

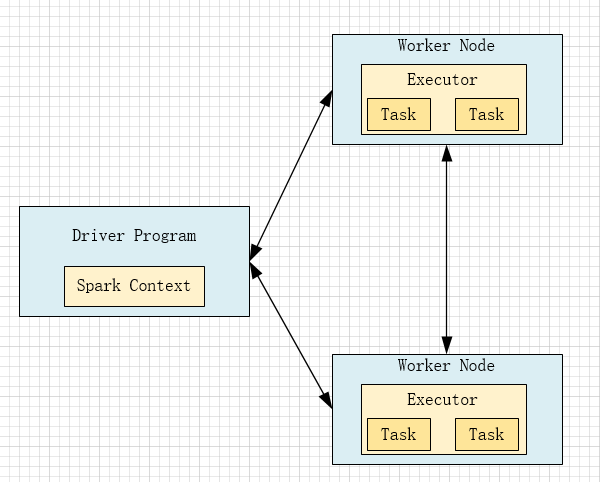

Driver Program

包含程式的main方法,RDDs的定義和操作。

它管理很多節點,我們稱之為excetor。

Spark Context

Driver Program是通過SparkContext物件訪問spark。

SparkContext物件代表和一個叢集的連線。

在Shell中SparkContext自動建立好了,就是sc。

分片

每個分片包含一部分資料,partitions可在叢集的不同節點上計算。

分片是spark並行執行的單元,spark是順序的,並行的處理分片。

RDDs的建立方法

1

把一個存在的集合傳給Sprakcontext的parallelize()方法,用於測試

var rdd = sc.parallelize(Array(1,2,2,4),4)其中,第一個引數表示待並行化處理的集合,第二個引數:分片的個數。

2

載入外部資料集

val rddText = sc.textFile('helloSpark.txt')相關推薦

Spark學習之RDDs介紹

什麼是RDDS? RDDS即Resilient distributed datasets(彈性分散式資料集)。 Spark中,所有計算都是通過RDDs的建立,轉換,操作完成的。 一個RDD是一個不可改變的分散式集合物件。 Driver Program 包含程式的main方法,RDDs的定義和操作。 它管

我的RabbitMQ學習之1(介紹)

代理 tutorials 轉發數據 一個 mode 圖片 ssa 方式 初始化 官方網址:http://www.rabbitmq.com 我翻譯官網的文檔,僅供自己學習用................... RabbitMQ 是什麽,它就是一個消息隊列,用在哪裏,用

Spark學習之第一個程序打包、提交任務到集群

4.4.2 2.6.0 reat apach import chmod 程序 rsa cas 1、免秘鑰登錄配置: ssh-keygen cd .ssh touch authorized_keys cat id_rsa.pub > authorized_keys ch

Spark學習之路 (二)Spark2.3 HA集群的分布式安裝

serve html 元數據 不安裝 rec ive cut 再次 apps 一、下載Spark安裝包 1、從官網下載 http://spark.apache.org/downloads.html 2、從微軟的鏡像站下載 http://mirrors.hust.

Spark學習之路 (四)Spark的廣播變量和累加器

img 還原 變量定義 如果 style 調優 學習之路 park 系統 一、概述 在spark程序中,當一個傳遞給Spark操作(例如map和reduce)的函數在遠程節點上面運行時,Spark操作實際上操作的是這個函數所用變量的一個獨立副本。這些變量會被復制到每臺機器

Spark學習之路 (十一)SparkCore的調優之Spark內存模型

精準 規模 memory 此外 結構定義 申請 管理方式 存儲 內部 摘抄自:https://www.ibm.com/developerworks/cn/analytics/library/ba-cn-apache-spark-memory-management/index

Spark學習之路 (十二)SparkCore的調優之資源調優JVM的基本架構

程序員 存儲 src ron 指示器 引用 double strong 功能 一、JVM的結構圖 1.1 Java內存結構 JVM內存結構主要有三大塊:堆內存、方法區和棧。 堆內存是JVM中最大的一塊由年輕代和老年代組成,而年輕代內存又被分成三部分,Eden空間、

Spark學習之路 (十二)SparkCore的調優之資源調優

限制 無法 數據 block 可能 executors 頻繁 通過 操作 摘抄自:https://tech.meituan.com/spark-tuning-basic.html 一、概述 在開發完Spark作業之後,就該為作業配置合適的資源了。Spark的資源參數,基

Spark學習之路 (十四)SparkCore的調優之資源調優JVM的GC垃圾收集器

當前 復制 event 只需要 引用 應用 之前 相互 分享 一、概述 垃圾收集 Garbage Collection 通常被稱為“GC”,它誕生於1960年 MIT 的 Lisp 語言,經過半個多世紀,目前已經十分成熟了。 jvm 中,程序計數

Spark學習之路 (十五)SparkCore的源碼解讀(一)啟動腳本

-o 啟動服務 binary dirname ppi std 參數 exp 情況 一、啟動腳本分析 獨立部署模式下,主要由master和slaves組成,master可以利用zk實現高可用性,其driver,work,app等信息可以持久化到zk上;slaves由一臺至多

Linux學習之Sersync介紹 Linux運維

Linux運維i Linux學習 Linux基礎 Linux雲計算 Sersync利用inotify技術實現水服務器數據實時同步的解決方案,其中監控sersync所在服務器上文件系統的事件變化,rsync是目前廣泛使用的本地及異地數據同步工具,其優點是只對發生變化的目錄數據操作,甚至是一個文件

Spark學習之路 (二十八)分布式圖計算系統

尺度 內存 底層 mapr 分區 ces 兩個 傳遞方式 cat 一、引言 在了解GraphX之前,需要先了解關於通用的分布式圖計算框架的兩個常見問題:圖存儲模式和圖計算模式。 二、圖存儲模式 巨型圖的存儲總體上有邊分割和點分割兩種存儲方式。2013年,Gra

Spark學習之Spark Shuffle

文章目錄 一、什麼是Spark Shuffle? 二、HashShuffle執行原理 三、Shuffle可能面臨的問題? 四、如何優化解決問題? 五、SortShuffle執行原理 一、什麼是Spark Shuffle? 1

Spark學習之問題整理

Stage中的一些問題: 1、stage中每一個task(管道計算模式)在什麼時候落地磁碟? 如果是stage後面是action類運算元: collect:將每一個管道的計算結果收集到Driver端的記憶體中。 saveAsTextFile:將每一個管道的計算結果寫到指定記

Spark學習之Spark核心

一、Spark中的一些專業術語 任務: Application:使用者寫的應用程式,包括Driver Program和Executor Program。 Job:一個action類運算元觸發執行的操作。 stage:一組任務(task)就是一個stage。

JAVA集合學習之基本介紹

1.JAVA集合框架的體系結構 2.區別 1.List(列表) 特點:元素有序並且可以重複的集合,可以精確的控制每個元素的插入位置,或刪除某個位置的元素 主要實現類: 1.ArrayList(動態陣列):動態增長,適合查詢和更新元素,元素的值可以為null

Spark學習之Scala的基礎知識

Scala的變數宣告 在Scala建立變數的時候,必須使用val或者var val,變數值不可修改,一旦分配不能重新指向別的值 var,分配後,可重新指向型別相同的值 舉例 val lines = sc.textFile("helloSpark.txt") lines = sc.textFile("he

Spark學習之路--官方文件+簡單

一、學習spark中官方文件: 1.《Spark 官方文件》Spark快速入門 1.1 RDD Programming Guide 1.2 Spark SQL, DataFrames and Datasets Guide 二、簡單demo 以上技術全部

Spark學習之RDD

1、由圖可知每一個RDD由一系列partition組成。 2、例如將flatMap作用在每一個分割槽上,即父RDD作為flatMap的輸入,子RDD作為flatMap的輸出。 3、當一個partition內丟失,由於子RDD知道父RDD是誰,所以子RDD可以將函式再次作用在父RDD的partition上,重新

DPDK學習之開篇介紹

1、前言 記得剛開始工作的時,老大將我安排到資料面組,當時第一次聽說”資料面“這個概念,感覺挺新鮮的。誤打誤撞就開始搞了,剛開始接觸的時候,由於不懂其中的原理,覺得很神奇,因為報文的轉發是在應用層,通過一個程序進行轉發。而傳統的報文轉發是基於核心的,要想控制報文,需要寫驅動程式。後面接觸了一段時間,發現