RNN與LSTM(反向傳播待補充)

阿新 • • 發佈:2018-11-27

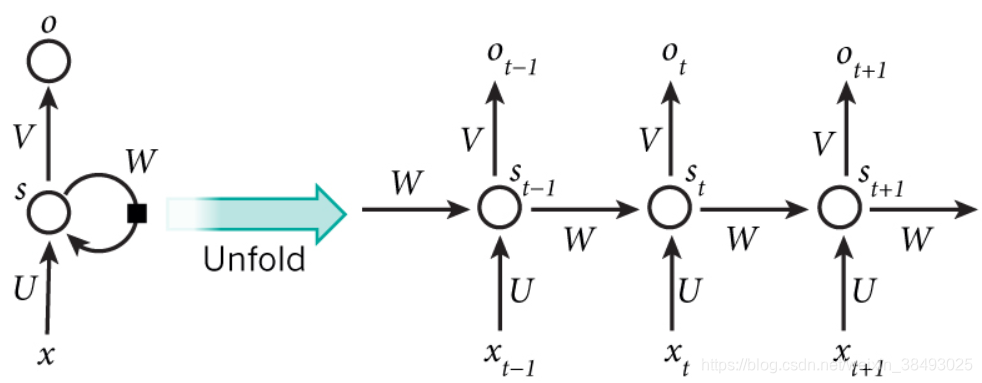

1.RNN

- 針對問題:訓練樣本是序列資料

- 模型思想:迴圈反饋

- 模型特點:

(1)隨著序列的推進,前面的隱層將會影響後面的隱層

(2)U、V、W權值共享

(3)每個輸入只與它本身的那條路線建立權連線,不會和別的神經元連線。 - 模型缺點:梯度消失,無法處理長序列資料(解決:LSTM、GRU)

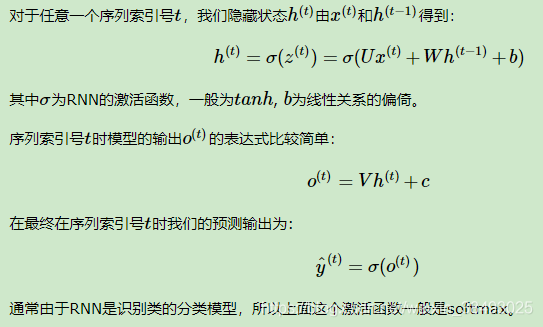

RNN的前向傳播

基於時間反向傳播BPTT

(略)

2.LSTM

針對RNN梯度消失問題,對序列索引位置t的隱藏結構做改進:

- 新增另一個隱藏狀態,稱為細胞狀態(LSTM的核心思想)

- 設定門控結構控制細胞狀態:遺忘門、輸入門、輸出門

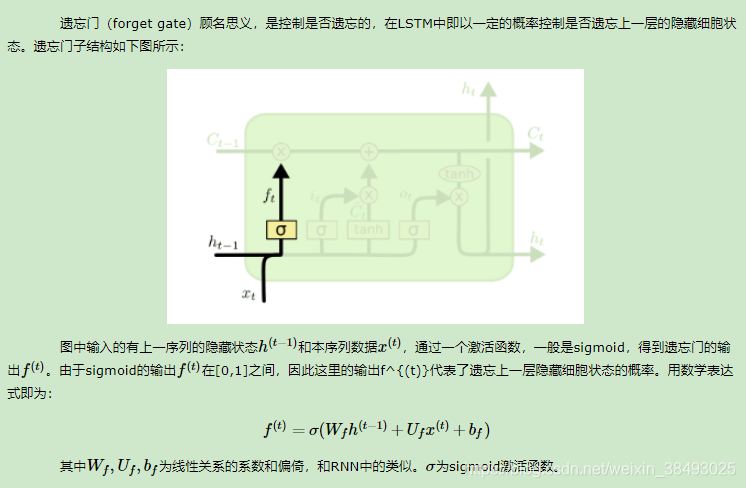

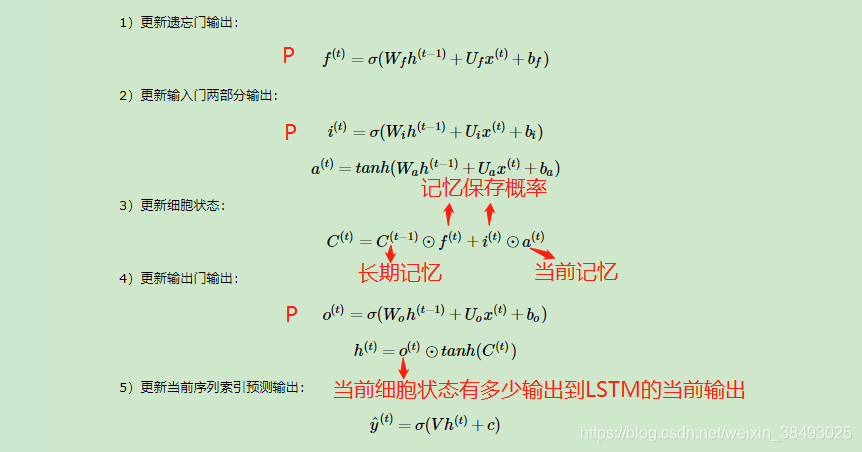

2.1 遺忘門

遺忘門決定了上一時刻的細胞狀態

(代表長期的記憶) 有多少保留到當前時刻的細胞狀態

。

遺忘門

的公式形式和RNN的隱藏狀態

更新公式一致,區別在於啟用函式,RNN是tanh啟用函式,取值[-1,1],遺忘門是sigmoid函式,取值[0,1]代表遺忘概率。

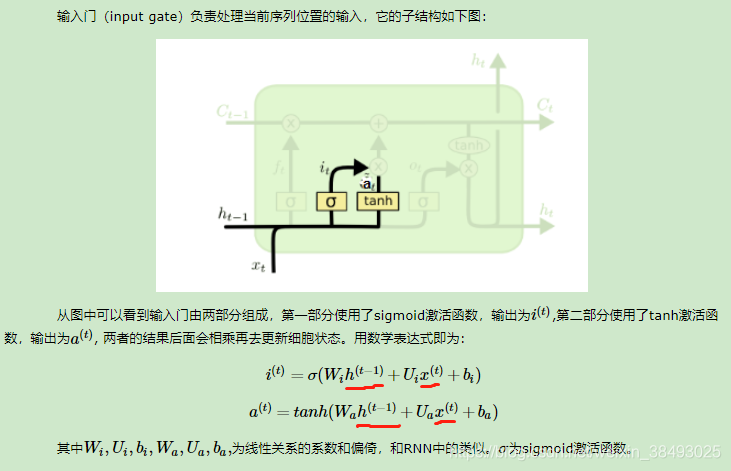

2.2 輸入門

輸入門決定了當前時刻的輸入

有多少儲存到當前時刻的細胞狀態

輸入門的第一部分

表示儲存概率,取值[0,1],公式形式和遺忘門完全一樣,第二部分

代表當前的記憶,公式形式則和RNN的隱藏狀態

更新公式完全一致。

2.3 細胞狀態更新

在研究LSTM輸出門之前,我們要先看看LSTM之細胞狀態。前面的遺忘門和輸入門的結果都會作用於細胞狀態

。

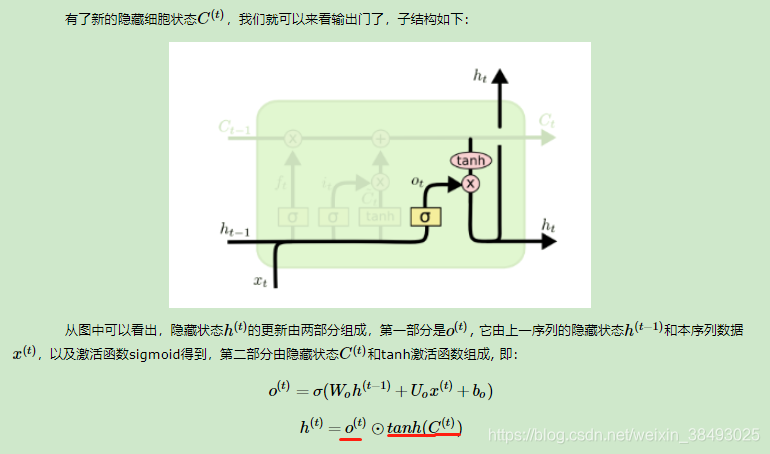

2.4 輸出門

輸出門決定了當前細胞狀態

有多少輸出到 LSTM 的當前輸出值

。

輸出門的第一部分

表示儲存概率,公式形式和遺忘門完全一樣

LSTM的前向傳播

LSTM的反向傳播

(略)