“希希敬敬對”團隊作業——敏捷衝刺4

“希希敬敬對”百度貼吧小爬蟲任務計劃:

今天的團隊討論照片:

龍江騰(隊長) 201810775001

完成“爬取發帖主題人的主題回覆資料”程式碼review,明天完成程式碼,實現“把10個頁面的資料整合到一個數據組中,並進行排序”的功能。

楊希 201810812008

完成程式碼,實現“爬取發帖主題人的主題回覆資料”功能,明天完成“把10個頁面的資料整合到一個數據組中,並進行排序”的程式碼review。

何敬上 201810812004

完成“爬取發帖主題人的主題回覆資料”程式碼review,明天完成程式碼,實現“把10個頁面的資料整合到一個數據組中,並進行排序”的功能。

遇到的問題:

暫無

燃盡圖:

程式程式碼(基於昨天程式碼的基礎上的更新):

# 找到資料對應的網頁,分析網頁結構找到資料所在的標籤位置

#模擬HTTP請求,向伺服器傳送這個請求,獲取到伺服器返回給我們的HTML

import re

from urllib import request

class BDTBCrawler():

url = "http://tieba.baidu.com/f?kw=%E4%B8%9C%E5%8D%8E%E7%90%86%E5%B7%A5%E5%A4%A7%E5%AD%A6&ie=utf-8"

Name_num_list = []

def __init__(self, url):

BDTBCrawler.url = url

#匹配到包含了主題作者和帖子回覆數關鍵字的標籤

root_pattern = '<span class="threadlist_rep_num center_text"([\s\S]*?)data-field='

# 匹配到對應的帖子回覆數

num_pattern = 'title="回覆">([\s\S]*?)</span>'

# 匹配到主題作者

name_pattern = 'title="主題作者: ([\s\S]*?)"'

#模擬HTTP請求,向伺服器傳送請求,獲取到伺服器返回給我們的HTML

def __fetch_content(self):

r = request.urlopen(BDTBCrawler.url)

htmls = r.read()

# 將伺服器返回的位元組碼轉換成字串格式

htmls = str(htmls, encoding='utf-8')

return htmls

def __analysis(self, htmls):

#root_html獲取包含了主題作者和帖子回覆數關鍵字的標籤

root_html = re.findall(BDTBCrawler.root_pattern, htmls)

# 用anchors這個列表來存放提取出來的主題作者和帖子回覆陣列成的字典

anchors = []

for html in root_html:

# 提取主題作者(列表型別)

name = re.findall(BDTBCrawler.name_pattern, html)

# #提取回複數(列表型別)

number = re.findall(BDTBCrawler.num_pattern, html)

anchor = {'name': name, 'number': number}

anchors.append(anchor)

# print(anchors)

return anchors

def go(self):

#使用for迴圈爬取前10頁

htmls = ''

for i in range(0, 10):

pn = i * 50

#page記錄當前爬取頁面需要在URL上新增的字串

page = '&pn=' + str(pn)

BDTBCrawler.url += page

htmls += self.__fetch_content()

anchors = self.__analysis(htmls)

for i in anchors:

print(i)

crawler = BDTBCrawler(BDTBCrawler.url)

crawler.go()

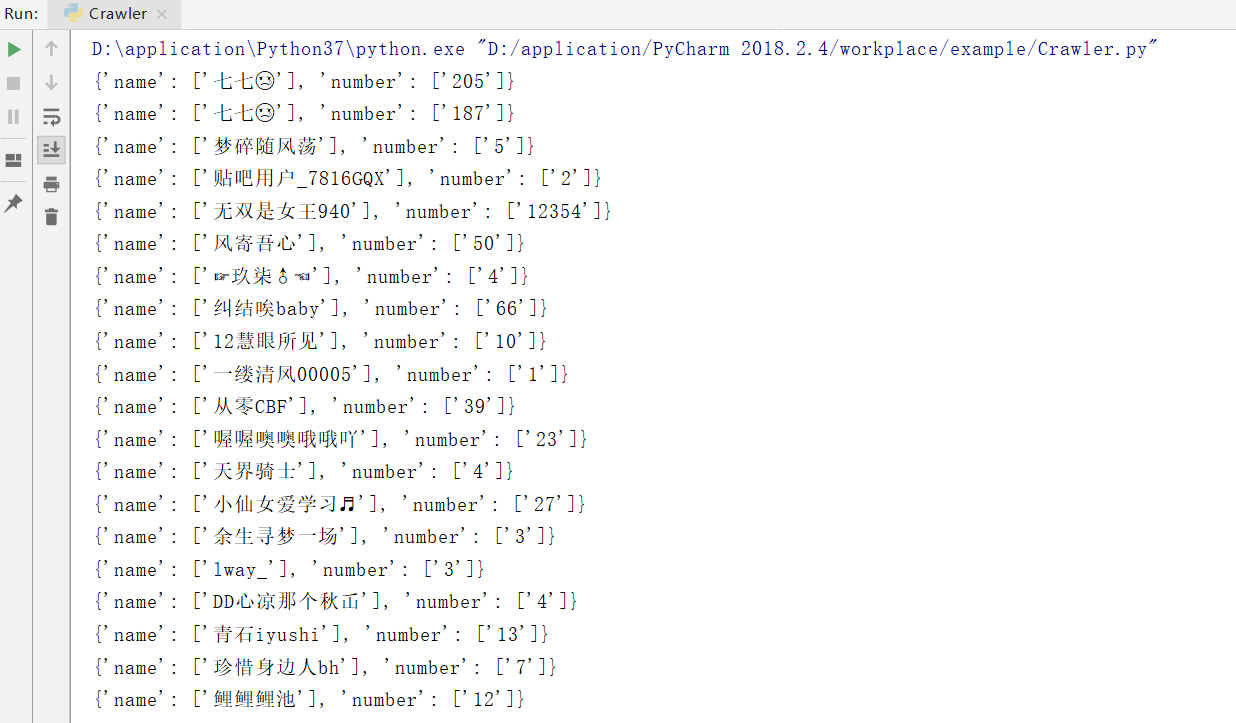

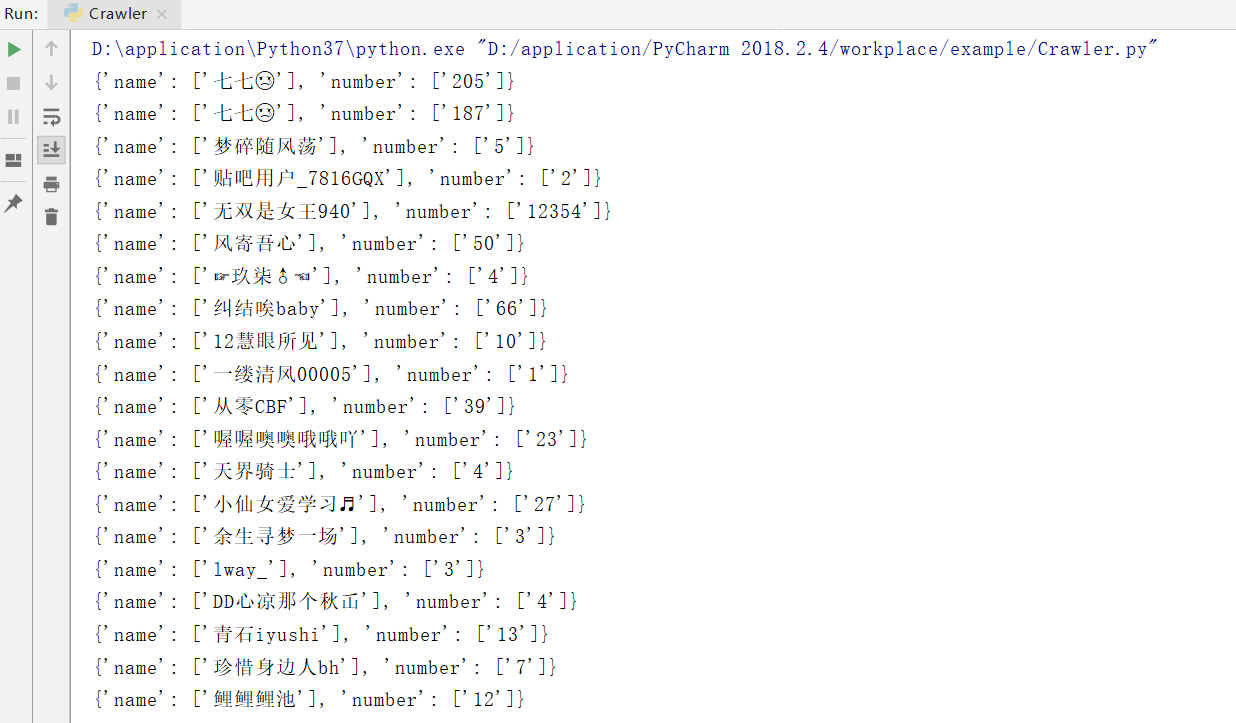

程式執行結果部分截圖:

“希希敬敬對”百度貼吧小爬蟲任務計劃:

今天的團隊討論照片:

龍江騰(隊長) 201810775001

完成“爬取發帖主題人的主題回覆資料”程式碼review,明天完成程式碼,實現“把10個頁面的資料整合到一個數據組中,並進行排序”的功能。

楊希 201810812008

完成程式碼,實現“爬取發帖主題人的主題回覆資料”功能,明天完成“把10個頁面的資料整合到一個數據組中,並進行排序”的程式碼review。

何敬上 201810812004

完成“爬取發帖主題人的主題回覆資料”程式碼review,明天完成程式碼,實現“把10個頁面的資料整合到一個數據組中,並進行排序”的功能。

遇到的問題:

暫無

燃盡圖:

程式程式碼(基於昨天程式碼的基礎上的更新):

# 找到資料對應的網頁,分析網頁結構找到資料所在的標籤位置

#模擬HTTP請求,向伺服器傳送這個請求,獲取到伺服器返回給我們的HTML

import re

from urllib import request

class BDTBCrawler():

url = "http://tieba.baidu.com/f?kw=%E4%B8%9C%E5%8D%8E%E7%90%86%E5%B7%A5%E5%A4%A7%E5%AD%A6&ie=utf-8"

Name_num_list = []

def __init__(self, url):

BDTBCrawler.url = url

#匹配到包含了主題作者和帖子回覆數關鍵字的標籤

root_pattern = '<span class="threadlist_rep_num center_text"([\s\S]*?)data-field='

# 匹配到對應的帖子回覆數

num_pattern = 'title="回覆">([\s\S]*?)</span>'

# 匹配到主題作者

name_pattern = 'title="主題作者: ([\s\S]*?)"'

#模擬HTTP請求,向伺服器傳送請求,獲取到伺服器返回給我們的HTML

def __fetch_content(self):

r = request.urlopen(BDTBCrawler.url)

htmls = r.read()

# 將伺服器返回的位元組碼轉換成字串格式

htmls = str(htmls, encoding='utf-8')

return htmls

def __analysis(self, htmls):

#root_html獲取包含了主題作者和帖子回覆數關鍵字的標籤

root_html = re.findall(BDTBCrawler.root_pattern, htmls)

# 用anchors這個列表來存放提取出來的主題作者和帖子回覆陣列成的字典

anchors = []

for html in root_html:

# 提取主題作者(列表型別)

name = re.findall(BDTBCrawler.name_pattern, html)

# #提取回複數(列表型別)

number = re.findall(BDTBCrawler.num_pattern, html)

anchor = {'name': name, 'number': number}

anchors.append(anchor)

# print(anchors)

return anchors

def go(self):

#使用for迴圈爬取前10頁

htmls = ''

for i in range(0, 10):

pn = i * 50

#page記錄當前爬取頁面需要在URL上新增的字串

page = '&pn=' + str(pn)

BDTBCrawler.url += page

htmls += self.__fetch_content()

anchors = self.__analysis(htmls)

for i in anchors:

print(i)

crawler = BDTBCrawler(BDTBCrawler.url)

crawler.go()

程式執行結果部分截圖: