提交spark streaming產生大量磁碟檔案

前一天提交的spark streaming測試程式,master為local[*]

第二天從cdh介面發現該主機多了100多G檔案

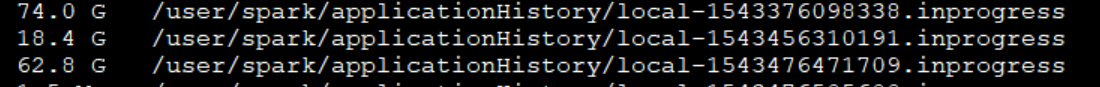

檢視hdfs 目錄下/user/spark/applicationHistory,發現提交的spark程式產生了大量日誌檔案

hdfs dfs -du -h /user/spark/applicationHistory

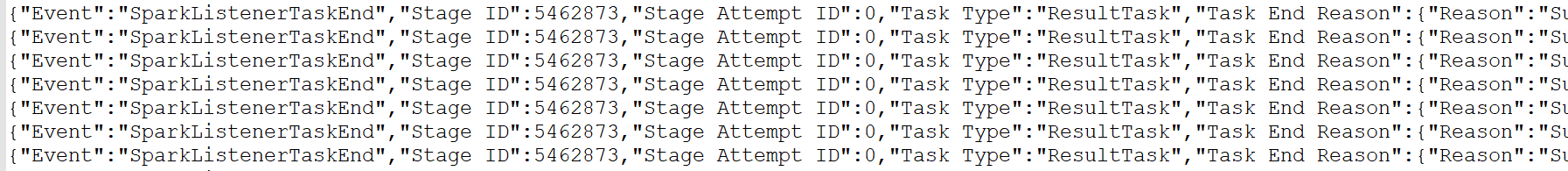

檢視前幾行,都是些event日誌,下面是一部分截圖。

去cdh介面,spark搜配置,spark.eventlog.enabled

預設是開啟,關閉就ok了,然後將日誌檔案刪除,並清空hdfs回收站.

相關推薦

提交spark streaming產生大量磁碟檔案

前一天提交的spark streaming測試程式,master為local[*] 第二天從cdh介面發現該主機多了100多G檔案 檢視hdfs 目錄下/user/spark/applicationHistory,發現提交的spark程式產生了大量日誌檔案 hdfs dfs -du -h

解決Flume採集資料時在HDFS上產生大量小檔案的問題

問題:flume指定HDFS型別的Sink時,採集資料至HDFS指定目錄,會產生大量小檔案。問題重現:1、建立flume配置檔案flume-env.sh,:flume配置檔案如下(根據自身需要修改): 因為flume可以配置多種採集方式,每種採集方式對應一個agent配

spark批量讀取大量小檔案的辦法

在實際工程中,經常會遇到要一起讀取眾多小檔案的辦法。本來正常情況下是進行資料夾的遍歷。 幸運的是,spark原生是支援這種功能的。它可以批量地讀取眾多的檔案,也可以按照一定的方式進行過濾。 命令十分簡單。如下: sc.textfile("/dir/*.txt") 其

spark-streaming任務提交遇到的坑

option 優化 機器 -s shc ref top 解決 而是 一、背景 基本所有公司互聯網公司都會有離線和實時任務,達到實時的目的手段據個人了解有storm、spark-streaming、flink。今天來探討一下spark-streaming任務的開發到上線過

Structure Streaming和spark streaming原生API訪問HDFS檔案資料對比

此文已由作者嶽猛授權網易雲社群釋出。 歡迎訪問網易雲社群,瞭解更多網易技術產品運營經驗。 Structure Stream訪問方式 code examples import org.apache.spark.sql.streaming._ val df = spark.

Oracle 11g 在audit_file_dest目錄下產生大量的aud檔案

每次sysdba或者sysoper許可權登入都會寫入一個audit trail檔案或者在現有的trail檔案後面新增登入資訊,而這個並不受audit_trail引數限制,audit_trail是顯示是否啟用審計和審計內容儲存的具體位置有關audit_sys_operations引數:AUDIT_SYS_OPE

Spark——Streaming原始碼解析之資料的產生與匯入

此文是從思維導圖中匯出稍作調整後生成的,思維腦圖對程式碼瀏覽支援不是很好,為了更好閱讀體驗,文中涉及到的原始碼都是刪除掉不必要的程式碼後的虛擬碼,如需獲取更好閱讀體驗可下載腦圖配合閱讀: 此博文共分為四個部分: DAG定義 Job動態生成 資料的產生與匯入 容錯 資料的產生與匯入主要分為以下五個部分

Spark Streaming 輸入DStream之基礎資料來源HDFS檔案

Socket:之前的wordcount例子,已經演示過了,StreamingContext.socketTextStream() HDFS檔案 基於HDFS檔案的實時計算,其實就是,監控一個

spark streaming應用提交到yarn上一直處於ACCEPTED狀態,也未報錯

原因已經找到,這裡做個記錄,防止下次再犯類似的錯誤。實際上是因為程式碼中將執行模式設定為本地模式,在提交到yarn上後driver端的程式碼正常執行,並且也正常運行了很多批次。但由於是本地模式,所以driver不會向resourcemanager申請資源,所以也就不會向rm註

解決spark streaming重複提交第三方jar包問題

背景: 由於spark streaming每次提交都需要上傳大量jar包到hdfs,為節約HDFS資源,現只存一份來解決這個問題 元件: CDH 5.13 spark2.2.x 針對cluster模

spark解決方案系列--------1.spark-streaming實時Join儲存在HDFS大量資料的解決方案

spark-streaming實時接收資料並處理。一個非常廣泛的需求是spark-streaming實時接收的資料需要跟儲存在HDFS上的大量資料進行Join。要實現這個需求保證實時性需要解決以下幾個問題: 1.spark-streaming的資料接收間隔往往很小,

Spark Streaming--1 檔案預設資料來源

檔案資料流:能夠讀取所有HDFS API相容的檔案系統檔案,通過fileStream方法進行讀取 Spark Streaming 將會監控 dataDirectory 目錄並不斷處理移動進來的檔案,記

Spark Streaming 讀取本地檔案壓檔案

package streamings.studys import org.apache.spark.SparkConf import org.apache.spark.streaming.dstre

spark streaming監控HDFS檔案目錄

叢集環境:CDH5.8.0 / spark1.6.0 / scala2.10.4基於Scala的基本使用方式如下:package com.egridcloud.sparkstreaming import org.apache.hadoop.conf.Configuratio

spark streaming 根據檔案內容自定義檔名輸出,並實現檔案內容追加

spark streaming 從kafka拉取資料,根絕訊息內容,需要將不容的訊息放到不同的資料夾下,大致內容為 從訊息中拆分出域名,不同域名分不到不同目錄,域名下按訊息中的時間分年月日目錄,底層目錄下自定義檔案個數,實現追加 由於sparkstrea

解決Spark Streaming任務日誌打爆磁碟問題

1.在standlone模式下,為了減少日誌在磁碟佔用的輸出的量,可以設定一下幾個引數。spark.executor.logs.rolling.maxRetainedFilesspark.executor.logs.rolling.enableCompressionspark

Linux伺服器 /var/spool/clientmqueue 目錄下產生大量檔案的解決辦法

今天收到nagios報警郵件,其中一臺server中的磁碟分割槽空間超過95%,登入到伺服器檢視 [[email protected]Hadoop-node-29 ~]# df -h Filesystem Size Used Avail Use% Mounted on /d

Spark Streaming之使用Spark Streaming處理檔案系統(local/hdfs)的資料

package com.yys.spark.project import org.apache.spark.SparkConf import org.apache.spark.streaming.{Seconds, StreamingContext} /** * 使用S

[spark streaming] ReceiverTracker 資料產生與儲存

前言 在Spark Streaming裡,總體負責任務的動態排程是JobScheduler,而JobScheduler有兩個很重要的成員:JobGenerator 和 ReceiverTracker。JobGenerator 負責將每個 batch 生成具體的

【Spark深入學習 -15】Spark Streaming前奏-Kafka初體驗

rod htm 新的 callback tails 包括 -c 舉例 清理 ----本節內容------- 1.Kafka基礎概念 1.1 出世背景 1.2 基本原理 1.2.1.前置知識 1.2.2.架構和原理 1.2.