My thoughts through a robot's eyes: An augmented reality-brain–machine interface

My thoughts through a robot’s eyes: An augmented reality-brain–machine interface

機器人是我的眼:增強現實-腦機介面

文章目錄

- My thoughts through a robot's eyes: An augmented reality-brain–machine interface

- 機器人是我的眼:增強現實-腦機介面

- 摘要

- 正文

-

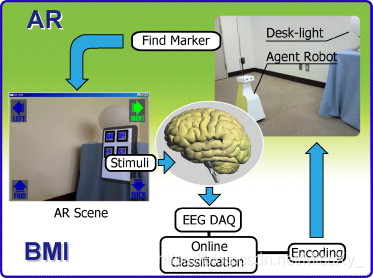

圖1 增強現實 - 腦機介面。受試者被要求觀看計算機監視器,該計算機監視器顯示代理機器人上的USB攝像頭檢測到的場景。控制機器人運動(前,後,右和左)的四個圖示顯示在顯示器的角落。當機器人的眼睛檢測到AR標記時,預先指定的紅外裝置變得可控。顯示屏上還會顯示一個面板,其中包含四個用於控制燈光的圖示(開啟,關閉,亮起並調暗)。因此,受試者可以在代理機器人的環境中操作燈。 -

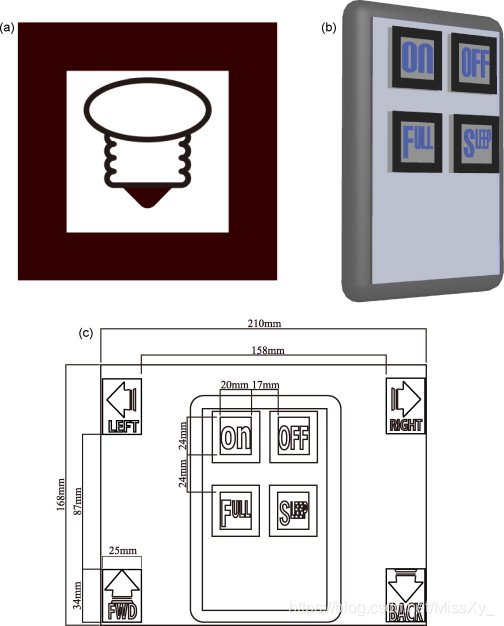

圖2 用於AR-BMI的AR標記和麵板。(a)桌面燈控制的AR標記。當機器人的眼睛檢測到AR標記時,它變得可控制。(b)用於控制檯燈的控制面板的3D模型。(c)PC監視器上顯示的場景圖。 -

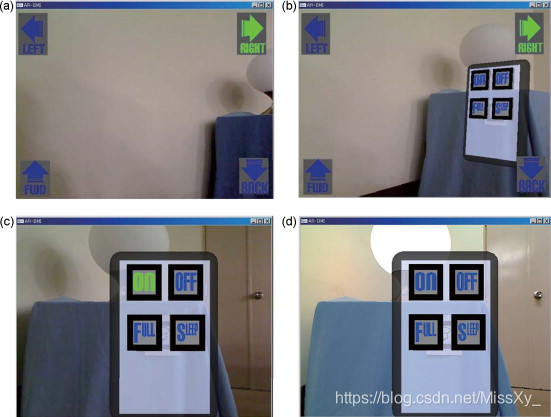

圖3 實驗場景。受試者在實驗中看到的場景的例子。(a)機器人接近光線。(b)機器人的眼睛檢測到AR標記,並顯示光控制面板。(c)燈光控制面板閃爍。(d)成功傳送開啟燈的命令。 -

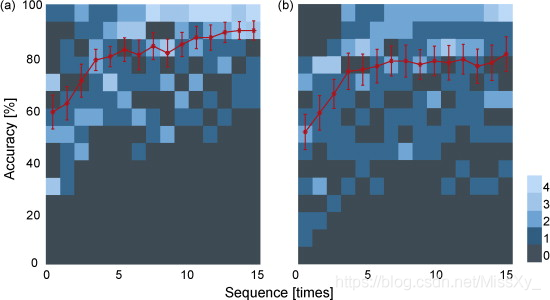

圖4 受試者的控制準確性。顯示控制:(a)機器人和(b)光的準確度。橫軸表示序列數,縱軸表示精度。紅色實線表示標準誤差(SE)的平均精度。紅色實線後面的藍色方塊是二維直方圖,每個藍色方塊表示每個序列中受試者的頻率及其準確性。

來源:https://www.sciencedirect.com/science/article/pii/S0168010209020094

摘要

腦機介面(BMI)使用來自大腦的神經生理訊號來控制外部裝置,例如機器人手臂或計算機游標。將增強現實與BMI相結合,我們研究表明使用者的大腦訊號成功地控制了環境中的機器人的行為和操作裝置。通過機器人的眼睛,使用者的想法變為現實,增強人體解剖結構外的真實環境。

Keywords:BMI; BCI; Augmented reality ; Human body

正文

大腦和人工裝置之間的直接功能介面技術,即所謂的腦機(BMI)或腦機(BCI)介面,在過去十年中已經取得了令人印象深刻的成長(Lebedev和Nicolelis,2006,Birbaumer和Cohen,2007) 。BMI的一種研究方法利用神經生理學訊號,例如單個細胞的神經元放電。使用猴子或大鼠的電生理學研究成功地對機器人手臂進行了多維控制(Chapin等,1999,Moritz等,2008)),旨在控制感覺和行為像四肢的革命假肢。另一種方法利用來自大腦的神經生理學訊號,主要使用腦電圖(EEG)進行非侵入性訪問,腦電圖是一種使用放置在頭皮上的電極記錄神經生理訊號的技術。基於腦電圖的BMI成功實現了二維游標控制(Wolpaw和McFarland,2004)。

廣泛的BMI研究使使用者能夠在自己的環境中控制外部裝置; 然而,使用大腦訊號來控制使用者環境之外的裝置仍然是BMI的新概念。在人類獲得新的視覺觀點的情況下,最近的神經科學研究報告我們的身體方案可能會改變(Botvinick和Cohen,1998,Ehrsson等,2004,Lenggenhager等,2007),e。例如,視覺視角的操縱會影響我們身體內部的正常持續體驗,並且可能會出現與另一個人或人造體交換身體的感知錯覺(Petkova和Ehrsson,2008))。因此,開發新BMI的一個挑戰是將使用者的視覺直觀放在另一個環境中。這也可能引起必須進一步評估的各個方面。新BMI的另一個可能方向是準備具有可視透視的可控代理機器人,然後讓使用者看到機器人“看到”的內容。在這裡,我們描述了一種新的BMI系統,它允許控制使用者自身身體環境之外的裝置; 我們將增強現實(AR)與BMI技術相結合,並表明大腦訊號不僅可以控制代理機器人的運動,還可以通過其眼睛在機器人的環境中操作光。通過機器人的眼睛,使用者的想法變為現實,使人體解剖結構外的真實環境得以增強。

招募了10名未參加本研究的健康,未訓練的幼稚受試者(年齡19-39歲; 2名女性和8名男性)作為參與者。根據愛丁堡清單,所有受試者均為神經正常且右手強烈。該研究得到了機構審查委員會的批准。所有受試者均根據機構指南提供書面知情同意書。

AR-BMI系統包括個人計算機(PC),監視器,實驗室代理機器人,USB攝像頭(QCAM-200V,Logicool,東京,日本),EEG放大器(gUSBamp,Guger Technologies OEG,Graz,Austria),和EEG上限(g.EEGcap,Guger Technologies OEG,格拉茨,奧地利)(圖1)。當機器人的眼睛檢測AR標記(圖2),預先指定的紅外裝置變得可控。AR標記的位置和方向由相機檢測到的影象計算,並且用於器具的控制面板由AR系統建立併疊加在機器人眼睛檢測到的場景上。為了通過使用腦訊號控制我們的系統,我們修改了Donchin P300拼寫器。這使用了P300範例,它提供了一系列以矩陣排列的圖示。該主題將注意力集中在矩陣中的一個圖示上作為目標,並且矩陣中的每個行/列或單個圖示以隨機序列加強。目標刺激表現為罕見的刺激(Oddball Paradigm)。引出與目標刺激相關的P300相關響應,然後可以提取並分類該響應以確定目標(Farwell和Donchin,1988)。注意,需要引起注意的方向以引起與P300相關的反應,而不一定是引人注目的方向。最近,我們的研究小組修改了Donchin P300 speller(Takano et al。,2009),並通過環境控制系統(ECS)應用它,使C3 / C4級四肢癱瘓患者能夠成功使用該系統(28個正確訊號/沒有經過重大培訓的28項試驗(Komatsu等,2008)。

圖1 增強現實 - 腦機介面。受試者被要求觀看計算機監視器,該計算機監視器顯示代理機器人上的USB攝像頭檢測到的場景。控制機器人運動(前,後,右和左)的四個圖示顯示在顯示器的角落。當機器人的眼睛檢測到AR標記時,預先指定的紅外裝置變得可控。顯示屏上還會顯示一個面板,其中包含四個用於控制燈光的圖示(開啟,關閉,亮起並調暗)。因此,受試者可以在代理機器人的環境中操作燈。

圖2 用於AR-BMI的AR標記和麵板。(a)桌面燈控制的AR標記。當機器人的眼睛檢測到AR標記時,它變得可控制。(b)用於控制檯燈的控制面板的3D模型。(c)PC監視器上顯示的場景圖。

AR-BMI系統使用ARToolKit(Kato和Billinghurst,1999)和OpenGL。ARToolKit C語言庫用於檢測和確定AR標記的位置,OpenGL C語言庫用於繪製3D控制面板。圖 2b示出了用於控制檯燈的控制面板的3D模型。圖 2c示出了PC監視器上顯示的場景的圖。請注意,AR-BMI系統可以控制代理機器人和檯燈。機器人控制面板有四個圖示(向前,向後,向右和向左),光控制面板也是如此(開啟,關閉,打亮,調暗)。我們準備了綠色/藍色閃爍圖示(Takano et al。,2009並且,閃爍的增強/靜止的持續時間是100/50 ms。所有圖示以隨機順序閃爍,形成一個序列(600 毫秒)。每15個序列進行一次分類。受試者被要求傳送15個命令紅外訊號以控制機器人和光。在試驗之前,我們檢查了受試者將要傳送的命令,然後使用該資訊來評估受試者的線上表現。我們還使用記錄的資料執行了離線評估。

使用以下方法記錄8通道(擴充套件國際10-20系統的Fz,Cz,Pz,P3,P4,Oz,PO7和PO8)EEG資料(Krusienski等,2007,Lu等,2008)。腦電圖上限。所有通道都參考Fpz並接地到AFz。儲存的EEG資料通過0.1Hz的八階高通濾波器 和四階48-52Hz陷波濾波器,並以128Hz的速率放大/數字化 。一階帶通濾波器(8.0-18.0 rad / s)應用於記錄的EEG資料。然後,根據強化的時間記錄120個事件相關電位(ERP)資料樣本。來自前20個樣品(強化前)的資料用於基線校正。將最後100個樣品(強化後)下采樣至25.6 Hz和Fisher的線性判別分析用於分類。在Fisher的線性判別分析中,我們首先收集資料以匯出後續測試會話的特徵向量。分配了四個目標來製作特徵向量。使用閃光定時資訊對EEG資料進行分類,然後使用Fisher的線性判別分析來生成特徵向量(160維,每個EEG通道20維),以區分目標和非目標。針對每種條件匯出特徵向量。在測試階段,使用特徵向量評估來自EEG特徵的視覺誘發反應。分類的結果被解釋為總和分數的最大值。

使用基於EEG的BMI系統,參與者首先需要使機器人在機器人的環境中移動到檯燈(圖3a和b )。為了控制機器人,每個命令是在一系列15個序列中選擇的,並且參與者需要傳送15個命令。評估線上效能,控制機器人的平均精度為90.0%。

圖3 實驗場景。受試者在實驗中看到的場景的例子。(a)機器人接近光線。(b)機器人的眼睛檢測到AR標記,並顯示光控制面板。(c)燈光控制面板閃爍。(d)成功傳送開啟燈的命令。

當機器人的眼睛檢測到檯燈的AR標記時,在螢幕上顯示用於控制器具的閃爍面板(圖 3c和d)。然後,參與者必須使用他們的大腦訊號通過機器人的眼睛操作機器人環境中的光。為了操作燈,每個命令在一系列15個序列中被選中,並且參與者被要求傳送15個命令。評估線上效能,光控制的平均準確度為80.7%。

圖4示出了在機器人控制(a)和光控制(b)條件下的參與者的效能的離線評估。控制機器人和檯燈的效能差異顯著,雙向重複ANOVA(F (1,280) = 6.53,p < 0.05)觀察到相互作用。事後測試顯示機器人控制條件和光控條件之間存在顯著差異(Tukey-Kramer測試,p < 0.05)。差異可能與螢幕上閃爍圖示的相對位置的差異有關(Cheng et al。,2002)(另請參見圖 2)。

圖4 受試者的控制準確性。顯示控制:(a)機器人和(b)光的準確度。橫軸表示序列數,縱軸表示精度。紅色實線表示標準誤差(SE)的平均精度。紅色實線後面的藍色方塊是二維直方圖,每個藍色方塊表示每個序列中受試者的頻率及其準確性。

通過將AR技術應用於BMI,我們成功地證明了大腦訊號不僅可以控制代理機器人,還可以在機器人環境中操作家用電子裝置。BMI研究已經開發出革命性的假肢,感覺和行為就像使用者的四肢(Chapin等,1999,Moritz等,2008)或計算機裝置(Wolpaw和McFarland,2004)),但這些還沒有控制使用者環境之外的裝置。在本研究中,我們應用AR技術併成功地增強了真實環境。我們還應用了P300拼寫演算法,併成功地將主體的思想轉化為預先分配給每個圖示的命令; 受試者的想法成功地操作了機器人和機器人環境中的檯燈。

在這項研究中,人類成功地使用了一種具有人體外部另一種視角的藥劑。其他可能的方法可以包括直接向用戶提供新的視覺觀點; 在這方面需要謹慎應用,因為這可能很容易改變使用者的身體方案(Botvinick和Cohen,1998,Ehrsson等,2004,Lenggenhager等,2007,Petkova和Ehrsson,2008)。沿著這些線路擴充套件人類活動的環境,使用未來的非侵入性神經生理訊號或神經元射擊資料,可以為身體殘疾人和身體健全的人提供新的日常活動。