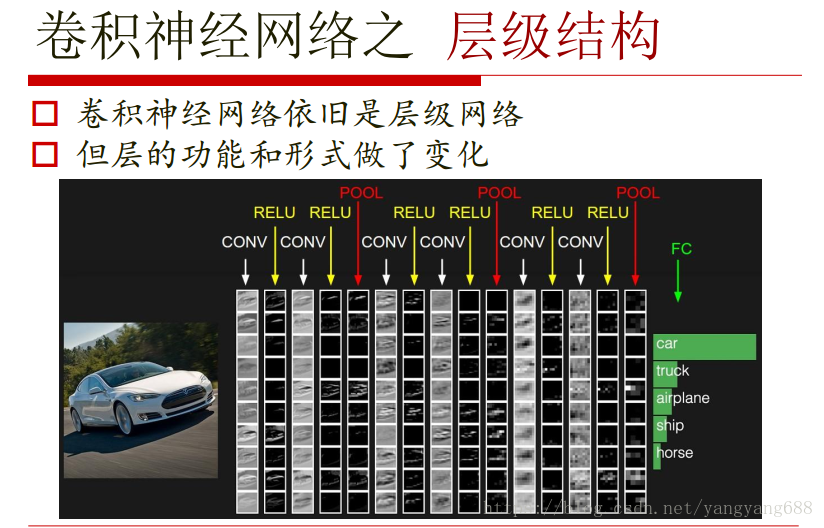

CNN-卷積神經網路

阿新 • • 發佈:2018-12-10

開局一張圖

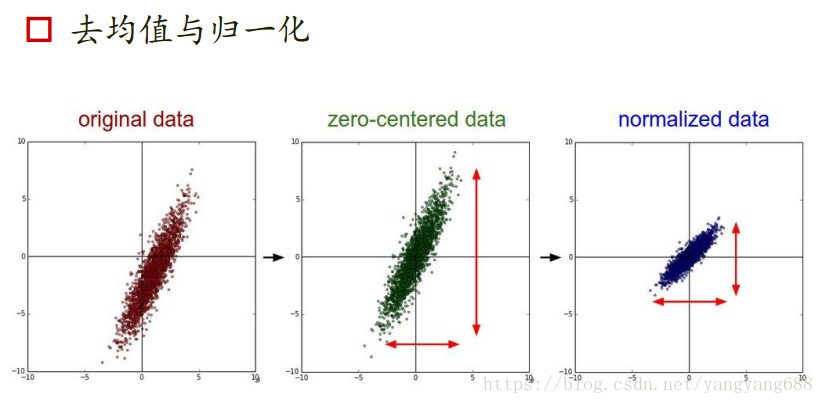

資料輸入層

- 去均值:把輸入資料各個維度都中心化到0

注意只是在訓練資料上,測試集上減去的是訓練集上的均值,不要再求測試集的均值。

- 歸一化:幅度歸一到同一範圍。

在實際操作中不用,因為RGB天生就是0-255範圍的

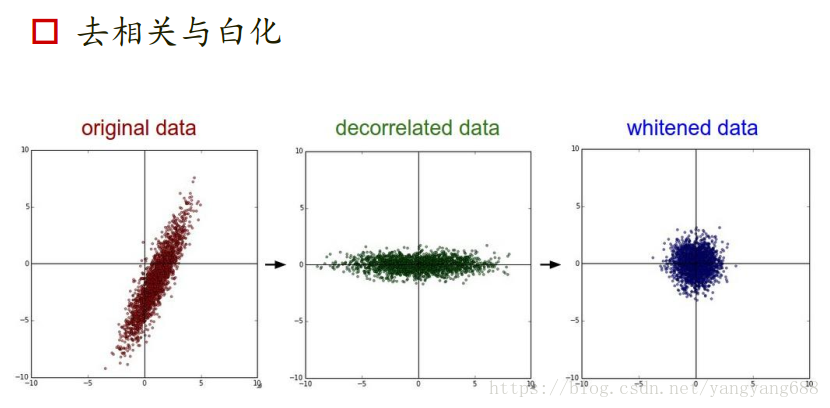

- PCA/白化:白化是對資料每個特徵軸上的幅度歸一化

在實際操作中一般不用,因為在處理影象時會resize,之後的維度就不會很大了

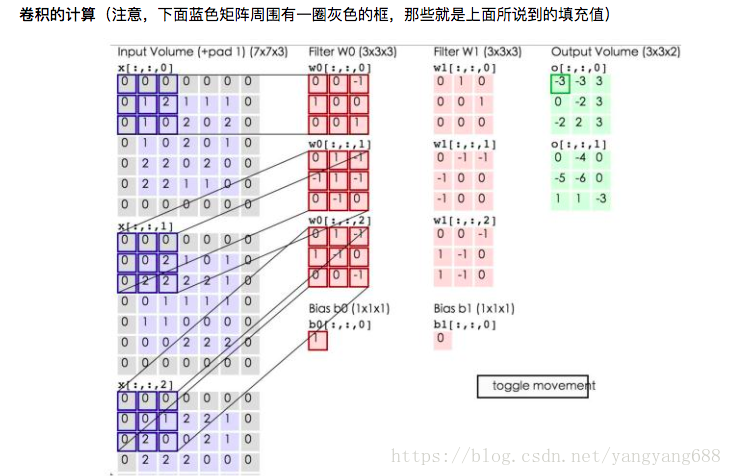

卷積層

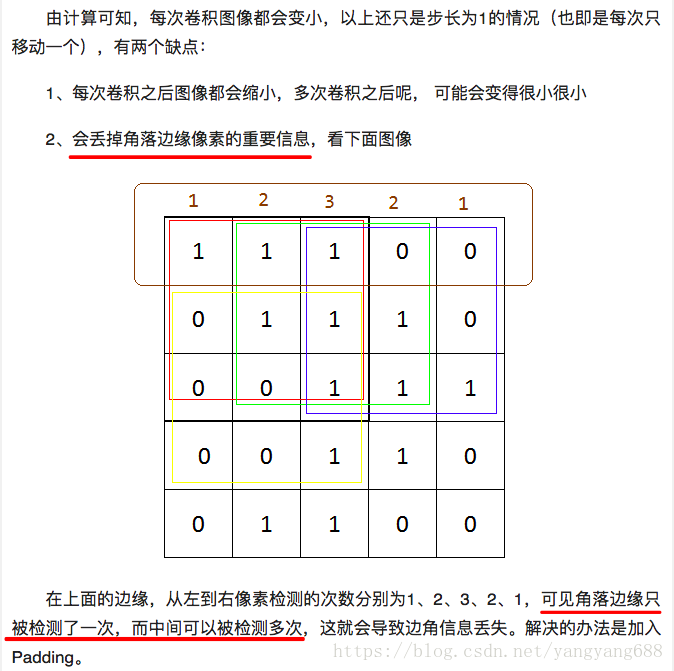

為什麼加入填充值?

原因1

原因2

注意:三維卷積,輸出的是單層圖(如果,Q不是整數,向下取整)

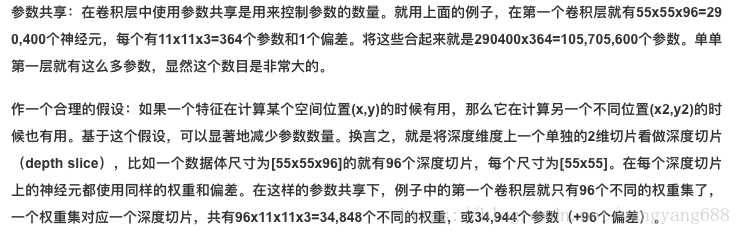

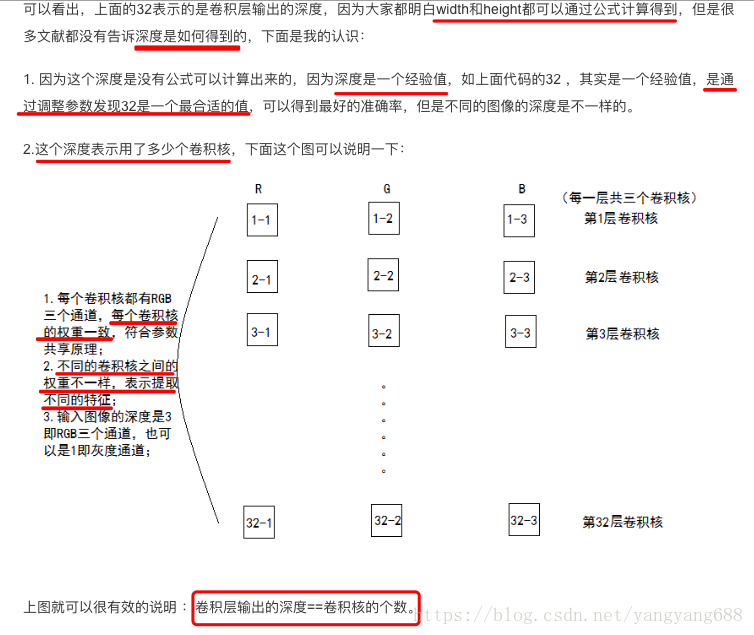

引數共享機制

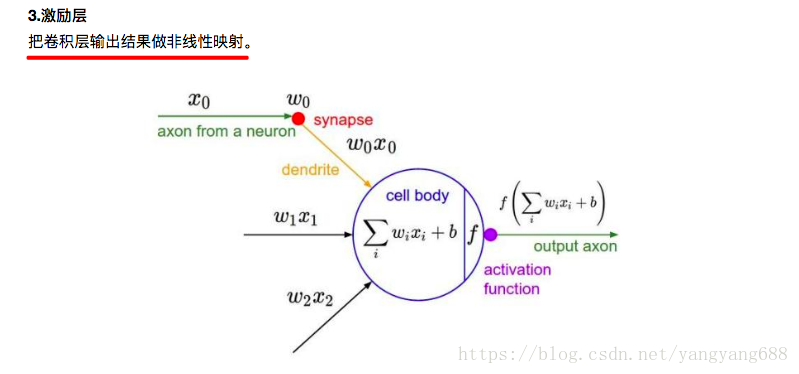

激勵層

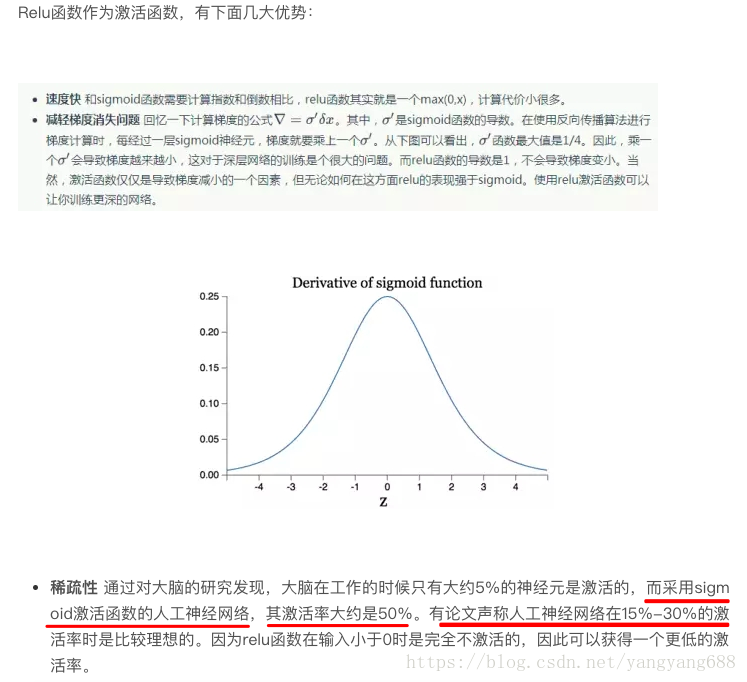

why RELU?

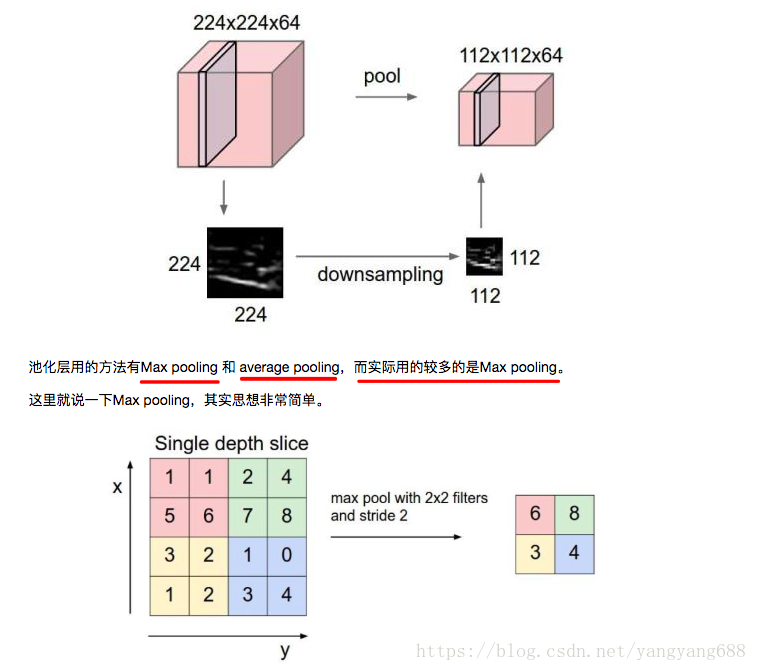

池化層

池化層夾在連續的卷積層中間,用於壓縮資料和引數的量,減小過擬合。 簡而言之,如果輸入是影象的話,那麼池化層的最主要作用就是壓縮影象。 這裡再展開敘述池化層的具體作用。 1.特徵不變性,也就是我們在影象處理中經常提到的特徵的尺度不變性,池化操作就是影象的resize, 平時一-張狗的影象被縮小了一倍我們還能認出這是一張狗的照片, 這說明這張影象中仍保留著狗最重要的特徵,我們一看就能判斷影象中畫的是一隻狗,影象壓縮時去掉的資訊只是一些無關緊要的資訊,而留下的資訊則是具有尺度不變性的特徵,是最能表達影象的特徵。

2.特徵降維

3.在一定程度上防止過擬合,更方便優化。