【機器學習】EM演算法在高斯混合模型學習中的應用

前言

EM演算法,此部落格介紹了

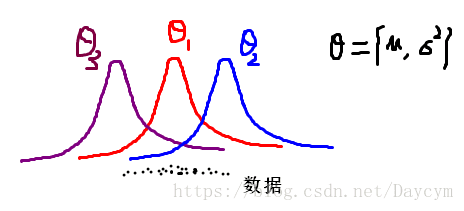

本篇部落格打算先從單個高斯分佈說起,然後推廣到多個高斯混合起來,最後給出高斯混合模型引數求解過程。

單個高斯分佈

假如我們有一些資料,這些資料來自同一個高斯分佈(獨立同分布),那個我們如何根據這些資料估計出這個高斯分佈的引數呢?我們知道只要知道高斯分佈的引數

假設資料為

由貝葉斯公式知:

關於貝葉斯公式的,可參考我之前的部落格,裡面有提到:連結

不加上先驗概率,就是極大似然估計; 加上先驗概率,就是極大後驗概率估計 這裡我們只介紹極大似然估計,極大後驗概率估計類似

(1)寫出對數似然函式

(2)求極大似然估計

分別對

相關推薦

05 EM演算法 - 高斯混合模型 - GMM

04 EM演算法 - EM演算法收斂證明 __GMM__(Gaussian Mixture Model, 高斯混合模型)是指該演算法由多個高斯模型線性疊加混合而成。每個高斯模型稱之為component。 __GMM演算法__描述的是資料的本身存在的一種分佈,即樣本特徵屬性的分佈,和預測值Y無關。顯然G

【機器學習】EM演算法在高斯混合模型學習中的應用

前言 EM演算法,此部落格介紹了EMEM演算法相關理論知識,看本篇部落格前先熟悉EMEM演算法。 本篇部落格打算先從單個高斯分佈說起,然後推廣到多個高斯混合起來,最後給出高斯混合模型引數求解過程。 單個高斯分佈 假如我們有一些資料,這些資料來自同一個

機器學習讀書筆記(高斯混合模型GMM與EM)(改)

高斯混合模型(Gaussian mixture model,GMM)是單一高斯概率密度函式的延伸。GMM能夠平滑地近似任意形狀的密度分佈。 欲瞭解高斯混合模型,那就先從基礎的單一高斯概率密度函式講起。(數學公式字型太難看了!!!!!!!) 注意:這一一篇致力於詳

高斯混合模型學習筆記

0 預備知識 l 設離散型隨機變數X的分佈律為 則稱 為X的數學期望或均值 l 設連續型隨機變數X的概率密度函式(PDF)為 其數學期望定義為 l 稱為隨機變數X的方差,稱為X的標準差 l 正態分佈 ~ 概率密度函式 l 設(X, Y)為二維隨機變數,若存在

【機器學習】機器學習(十二、十三):K-means演算法、高斯混合模型

簡介: 本節介紹STANFORD機器學習公開課中的第12、13集視訊中的演算法:K-means演算法、高斯混合模型(GMM)。(9、10、11集不進行介紹,略過了哈) 一、K-means演算法 屬於無監督學習的聚類演算法,給定一組未標定的資料

【機器學習】EM演算法詳細推導和講解

眾所周知,極大似然估計是一種應用很廣泛的引數估計方法。例如我手頭有一些東北人的身高的資料,又知道身高的概率模型是高斯分佈,那麼利用極大化似然函式的方法可以估計出高斯分佈的兩個引數,均值和方差。這個方法基本上所有概率課本上都會講,我這就不多說了,不清楚的請百度。 然而現在我面臨的是這種情況,我

【轉載】【機器學習】EM演算法詳細推導和講解

今天不太想學習,炒個冷飯,講講機器學習十大演算法裡有名的EM演算法,文章裡面有些個人理解,如有錯漏,還請讀者不吝賜教。 眾所周知,極大似然估計是一種應用很廣泛的引數估計方法。例如我手頭有一些東北人的身高的資料,又知道身高的概率模型是高斯分佈,那麼利用極大化似然函式的

斯坦福大學機器學習——EM演算法求解高斯混合模型

EM演算法(Expection-Maximizationalgorithm,EM)是一種迭代演算法,通過E步和M步兩大迭代步驟,每次迭代都使極大似然函式增加。但是,由於初始值的不同,可能會使似然函式陷入區域性最優。辜麗川老師和其夫人發表的論文:基於分裂EM演算法的GMM引數

【EM演算法】在高斯混合模型中的應用及python示例

一、EM演算法 EM演算法是一種迭代演算法,用於含有隱含變數的概率模型引數的極大似然估計。設Y為觀測隨機變數的資料,Z為隱藏的隨機變數資料,Y和Z一起稱為完全資料。 觀測資料的似然函式為: 模型引數θ的極大似然估計為: 這個問題只有通過迭代求解,下面給出EM演算法的迭代

[吳恩達機器學習筆記]15.1-3非監督學習異常檢測演算法/高斯回回歸模型

15.異常檢測 Anomaly detection 覺得有用的話,歡迎一起討論相互學習~Follow Me 15.1問題動機 Problem motivation 飛機引擎異常檢測

CS229 Machine Learning學習筆記:Note 7(K-means聚類、高斯混合模型、EM算法)

learn 不同的 inf ear 公式 course splay alt spa K-means聚類 ng在coursera的機器學習課上已經講過K-means聚類,這裏不再贅述 高斯混合模型 問題描述 聚類問題:給定訓練集\(\{x^{(1)},\cdots,x^{(m

EM演算法與高斯混合模型

由k個高斯模型加權組成,α是各高斯分佈的權重,Θ是引數。對GMM模型的引數估計,就要用EM演算法。更一般的講,EM演算法適用於帶有隱變數的概率模型的估計,即不同的高斯分佈所對應的類別變數。 為何不能使用極大似然估計,如果直接使用極大似然估計

Stanford機器學習課程筆記4-Kmeans與高斯混合模型

這一部分屬於無監督學習的內容,無監督學習內容主要包括:Kmeans聚類演算法、高斯混合模型及EM演算法、Factor Analysis、PCA、ICA等。本文是Kmeans聚類演算法、高斯混合模型的筆記,EM演算法是適用於存在latent/hidden變數的通用演算法,高斯混

高斯混合模型視訊背景建模的EM演算法與Matlab 實現

1.問題描述 影像的背景前景分離. 輸⼊為影像監控的1000 幀 (如下⽅圖中左邊所⽰), 要求輸出是背景和前景 (如下⽅圖中右邊所⽰). 2.背景知識 觀察待處理的監控影像,可以發現,前景主要是來來往往的行人,背景始終是攝像頭對準的固定區域,

聚類之高斯混合模型(Gaussian Mixture Model)【轉】

k-means應該是原來級別的聚類方法了,這整理下一個使用後驗概率準確評測其精度的方法—高斯混合模型。 我們談到了用 k-means 進行聚類的方法,這次我們來說一下另一個很流行的演算法:Gaussian Mixture Model (GMM)。事實上,GMM 和 k-means 很像,不過 GMM 是學習

Spark2.0機器學習系列之10: 聚類(高斯混合模型 GMM)

在Spark2.0版本中(不是基於RDD API的MLlib),共有四種聚類方法: (1)K-means (2)Latent Dirichlet allocation (LDA) (3)Bisecting k-m

EM(期望最大演算法)在高斯混合模型中的python實現

以下程式碼僅實現了兩個高斯混合模型在均勻分佈條件下的引數估計,想要實現完全隨機的非均勻分佈的多高斯混合模型,可在上面加以修改。具體參考書中的9.3.2節 ##python實現## import math #import copy import numpy

EM演算法之高斯混合模型(二)

EM引數求解 我們將GMM帶入 θ(g+1) \theta^{(g+1)}中 θ(g+1)=argmaxθ∫zln{P(X,z|θ)P(z|X,θ(g))}dz(6.1) \theta^{(g+1)} = {argm

EM演算法之高斯混合模型(一)

單個高斯模型 如果我們有一堆資料,其分佈屬於一個高斯模型,那麼有 p(X)=N(x|μ,Σ)=1(2π)m|Σ|‾‾‾‾‾‾‾‾√exp[−12(x−μ)TΣ−1(x−μ)](1.1) p(X) = N(x|\mu,\Sigma) = \

高斯混合模型(GMM)及其EM演算法的理解

一個例子 高斯混合模型(Gaussian Mixed Model)指的是多個高斯分佈函式的線性組合,理論上GMM可以擬合出任意型別的分佈,通常用於解決同一集合下的資料包含多個不同的分佈的情況(或者是同一類分佈但引數不一樣,或者是不同型別的分佈,比如正態分佈和伯