[PyTorch]PyTorch中反捲積的用法

阿新 • • 發佈:2018-12-13

文章來源:https://www.jianshu.com/p/01577e86e506

pytorch中的 2D 卷積層 和 2D 反捲積層 函式分別如下:

class torch.nn.Conv2d(in_channels, out_channels, kernel_size, stride=1, padding=0, groups=1, bias=True)class torch.nn.ConvTranspose2d(in_channels, out_channels, kernel_size, stride=1, padding=0, output_padding=0, bias=True)我不禁有疑問:

- 問題1: 兩個函式的引數為什麼幾乎一致呢?

- 問題2: 反捲積層中的 output_padding是什麼意思呢?

- 問題3: 反捲積層如何計算input和output的形狀關係呢?

看了中文文件後,我得不出答案,看了英文文件,才弄明白了。花費了一個下午的時間去研究這個問題,值得用此文紀錄一下。

我們知道,在卷積層中,輸入輸出的形狀關係為:

o = [ (i + 2p - k)/s ] +1 (1)其中:

- O : 為 output size

- i: 為 input size

- p: 為 padding size

- k: 為kernel size

- s: 為 stride size

- [] 為下取整運算

(1) 當 S=1 時

若 s等於1,則公式(1)中的取整符號消失,o 與 i 為 一一對應 的關係。 我們有結論:

如果卷積層函式和反捲積層函式的 kernel_size, padding size引數相同(且 stride= 1),設反捲基層的輸入輸出形狀為 i' 和 o', 卷積層的輸入輸出形狀i和o, 則它們為 交叉對應 的關係,即:

i = o'

o = i'為回答問題3, 我們將上述關係代入公式中,即:

i' = o' + 2p - k +1已知 i', 即可推出 o':

o' = i' - 2p + k - 1 (2)摘兩個例子:

(2) 當 S>1 時

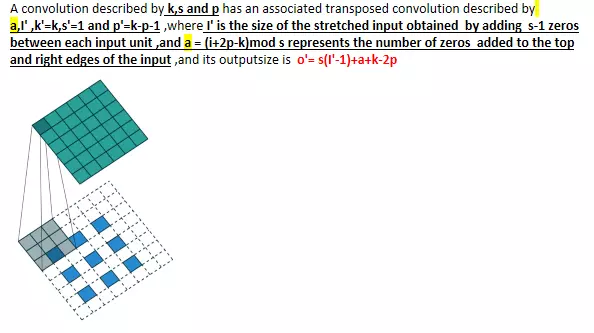

若 S>1 , 則公式(1)中的取整符號不能消去,o 與 i 為 多對1 的關係。 效仿 S=1時的情形, 我們有結論:

如果卷積層函式和反捲積層函式的 kernel_size, padding size引數相同(且 stride>1),設反捲基層的輸入輸出形狀為 i' 和 o', 卷積層的輸入輸出形狀i和o,

i' = [ (o' + 2p - k)/s ] +1已知 i', 我們可以得出 s 個 o' 解:

o'(0) = ( i' - 1) x s + k - 2p

o'(1) = o'(1) + 1

o'(2) = o'(1) + 2

...

o'(s-1) = o'(1) + s-1即:

o'(n) =o'(1) + n = ( i' - 1) x s + k - 2p + n,

n = {0, 1, 2...s-1}為了確定唯一的 o' 解, 我們用反捲積層函式中的ouput padding引數指定公式中的 n 值。這樣,我們就回答了問題(2)。

摘一個簡單的例子:

(3) 實驗驗證

給出一小段測試程式碼,改變各個引數值,執行比較來驗證上面得出的結論,have fun~.

from torch import nn

from torch.nn import init

from torch.autograd import Variable

dconv = nn.ConvTranspose2d(in_channels=1, out_channels= 1, kernel_size=2, stride=2, padding=1,output_padding=0, bias= False)

init.constant(dconv.weight, 1)

print(dconv.weight)

input = Variable(torch.ones(1, 1, 2, 2))

print(input)

print(dconv(input))