caffe原始碼分析-DataTransformer

阿新 • • 發佈:2018-12-13

本文主要分析caffe中DataTransformer這個類, 主要作用是:

-

將

Datum型別或者cv::Mat, 轉化為caffe的Blob<Dtype>,並按照Transformation``Parameter引數對影象做處理,例如scale,mirro等 -

推斷

blob的shape

proto定義如下:

// Message that stores parameters used to apply transformation // to the data layer's data message TransformationParameter { optional float scale = 1 [default = 1]; // Specify if we want to randomly mirror data. optional bool mirror = 2 [default = false]; // Specify if we would like to randomly crop an image. optional uint32 crop_size = 3 [default = 0]; // mean_file and mean_value cannot be specified at the same time optional string mean_file = 4; repeated float mean_value = 5; // Force the decoded image to have 3 color channels. optional bool force_color = 6 [default = false]; // Force the decoded image to have 1 color channels. optional bool force_gray = 7 [default = false]; }

使用示例1:

layer {

name: "mnist"

type: "Data"

top: "data"

top: "label"

include {

phase: TEST

}

transform_param {

scale: 0.00390625 # 1 / 255

}

data_param {

source: "/home/xy/caffe-master/examples/mnist/mnist_test_lmdb"

batch_size: 100

backend: LMDB

}

}

使用示例2:

transform_param { # randomly horizontally mirror the image mirror: 1 crop_size: 227 # substract mean value(RGB three channel): or use mean.binaryproto file # mean_file: name_of_mean_file.binaryproto mean_value: 104 mean_value: 117 mean_value: 123 }

下面看其核心的資料成員以及函式定義:

template <typename Dtype> class DataTransformer { public: explicit DataTransformer(const TransformationParameter& param, Phase phase); void Transform(const Datum& datum, Blob<Dtype>* transformed_blob); void Transform(const cv::Mat& cv_img, Blob<Dtype>* transformed_blob); vector<int> InferBlobShape(const Datum& datum); vector<int> InferBlobShape(const cv::Mat& cv_img); protected: // Tranformation parameters TransformationParameter param_; shared_ptr<Caffe::RNG> rng_; Phase phase_; Blob<Dtype> data_mean_; vector<Dtype> mean_values_; };

下面僅僅給出將Datum型別轉化為caffe的Blob, cv::Mat的轉化同理.

template<typename Dtype>

void DataTransformer<Dtype>::Transform(const Datum& datum,

Dtype* transformed_data) {

const string& data = datum.data();

const int datum_channels = datum.channels();

const int datum_height = datum.height();

const int datum_width = datum.width();

const int crop_size = param_.crop_size();

const Dtype scale = param_.scale();

const bool do_mirror = param_.mirror() && Rand(2);

const bool has_mean_file = param_.has_mean_file();

const bool has_uint8 = data.size() > 0;

const bool has_mean_values = mean_values_.size() > 0;

Dtype* mean = NULL;

if (has_mean_file) {

mean = data_mean_.mutable_cpu_data();

}

if (has_mean_values) {

if (datum_channels > 1 && mean_values_.size() == 1) {

// Replicate the mean_value for simplicity

for (int c = 1; c < datum_channels; ++c) {

mean_values_.push_back(mean_values_[0]);

}

}

}

int height = datum_height;

int width = datum_width;

int h_off = 0;

int w_off = 0;

if (crop_size) {

height = crop_size;

width = crop_size;

// We only do random crop when we do training.

if (phase_ == TRAIN) {

h_off = Rand(datum_height - crop_size + 1);

w_off = Rand(datum_width - crop_size + 1);

} else {

h_off = (datum_height - crop_size) / 2;

w_off = (datum_width - crop_size) / 2;

}

}

Dtype datum_element;

int top_index, data_index;

for (int c = 0; c < datum_channels; ++c) {

for (int h = 0; h < height; ++h) {

for (int w = 0; w < width; ++w) {

data_index = (c * datum_height + h_off + h) * datum_width + w_off + w;

if (do_mirror) {

top_index = (c * height + h) * width + (width - 1 - w);

} else {

top_index = (c * height + h) * width + w;

}

if (has_uint8) {

datum_element =

static_cast<Dtype>(static_cast<uint8_t>(data[data_index]));

} else {

datum_element = datum.float_data(data_index);

}

if (has_mean_file) {

transformed_data[top_index] =

(datum_element - mean[data_index]) * scale;

} else {

if (has_mean_values) {

transformed_data[top_index] =

(datum_element - mean_values_[c]) * scale;

} else {

transformed_data[top_index] = datum_element * scale;

}

}

}

}

}

}

caffe系列原始碼分析介紹

本系列深度學習框架caffe 原始碼分析主要內容如下:

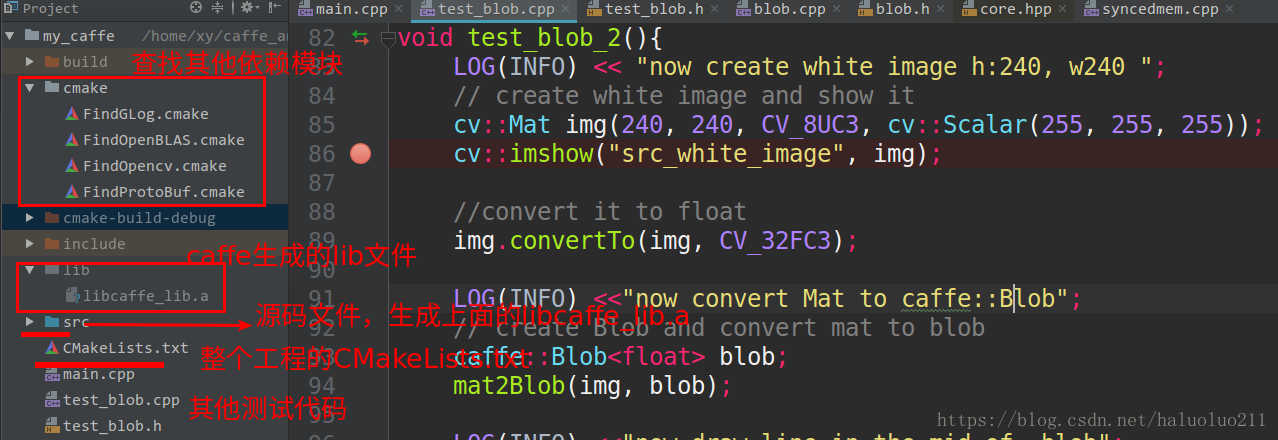

自己從頭構建一遍工程,這樣能讓我更好的瞭解大型的專案的構建。當然原始的caffe的構建感覺還是比較複雜(主要是cmake),我這裡僅僅使用cmake構建,而且簡化點,當然最重要的是支援CLion直接執行除錯(如果需要這個工程可以評論留下你的郵箱,我給你傳送過去)。

2. caffe的資料記憶體分配類SyncedMemory, 以及類Blob資料傳輸的媒介.

主要內容:

caffe原始碼分析-SyncedMemory

caffe原始碼分析-Blob

其中Blob分析給出了其直接與opencv的圖片相互轉化以及操作,可以使得我們更好的理解Blob.

3. caffe layer的原始碼分析,包括從整體上說明了layer類別以及其proto定義與核心函式.

首先分析了最簡單的layer Relu,然後在是inner_product_layer全連線層, 最後是layer_factorycaffe中 以此工廠模式create各種Layer.

4. 資料輸入層,主要是多執行緒+BlockingQueue的方式讀取資料訓練:

5. IO處理例如讀取proto檔案轉化為網路,以及網路引數的序列化

6. 最後給出了使用純C++結合多層感知機網路訓練mnist的示例

內容如下:

類似與caffe一樣按照layer、solver、loss、net等模組構建的神經網路實現可以見下面這篇blog,相信看懂了這個python的程式碼理解caffe框架會更簡單點.

最後如果需要cmake + CLion直接執行除錯caffe的程式碼工程,可以評論留下你的郵箱,我給你傳送過去.