各種attention注意力機制之間的比較

阿新 • • 發佈:2018-12-17

1、Show, Attend and Tell: Neural Image Caption Generation with Visual Attention.Kelvin Xu, Jimmy Ba, Ryan Kiros, Kyunghyun Cho, Aaron Courville, Ruslan Salakhudinov, Rich Zemel, Yoshua Bengio ; Proceedings of the 32nd International Conference on Machine Learning, PMLR 37:2048-2057, 2015.

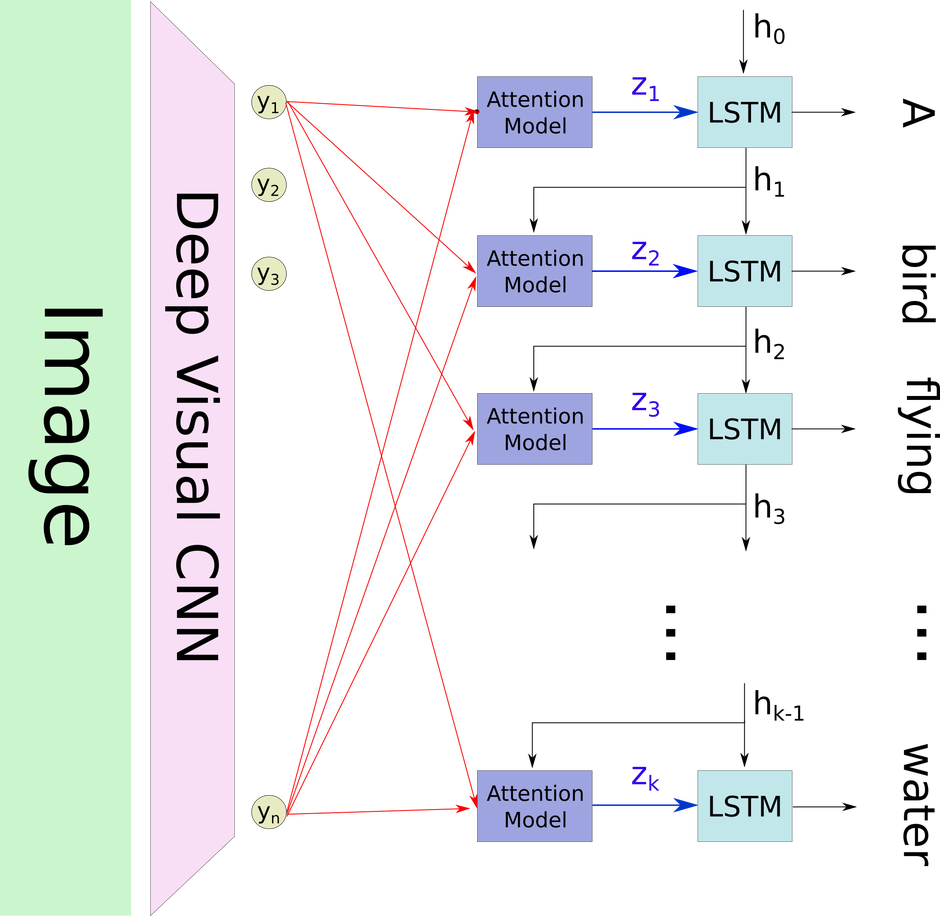

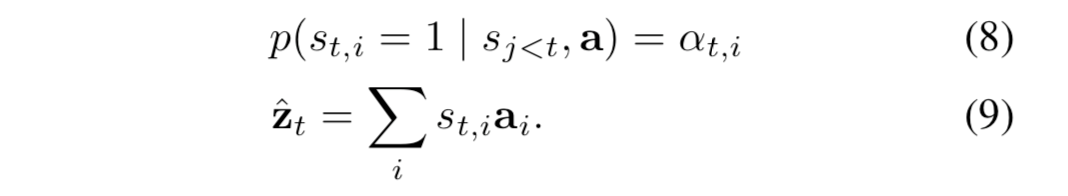

這篇文章中提出了hard attention與soft attention兩種注意力機制,二者的通用計算框架相同,區別在於注意力計算方式的不同:

1)通用計算框架

步驟一:

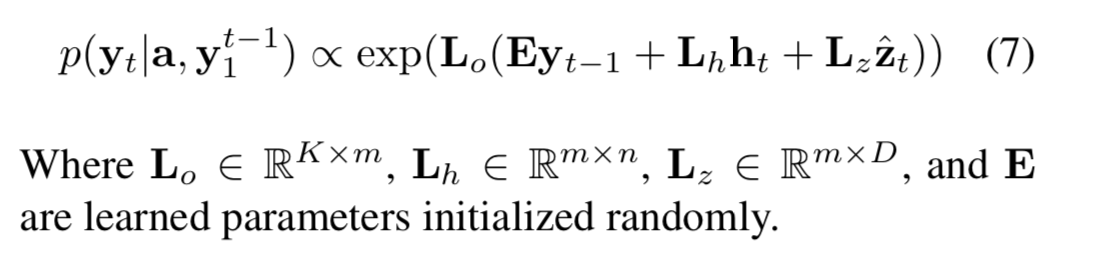

yt-1表示熱編碼的詞向量,ht表示隱藏層,Zt表示(頭部有箭頭)上下文向量

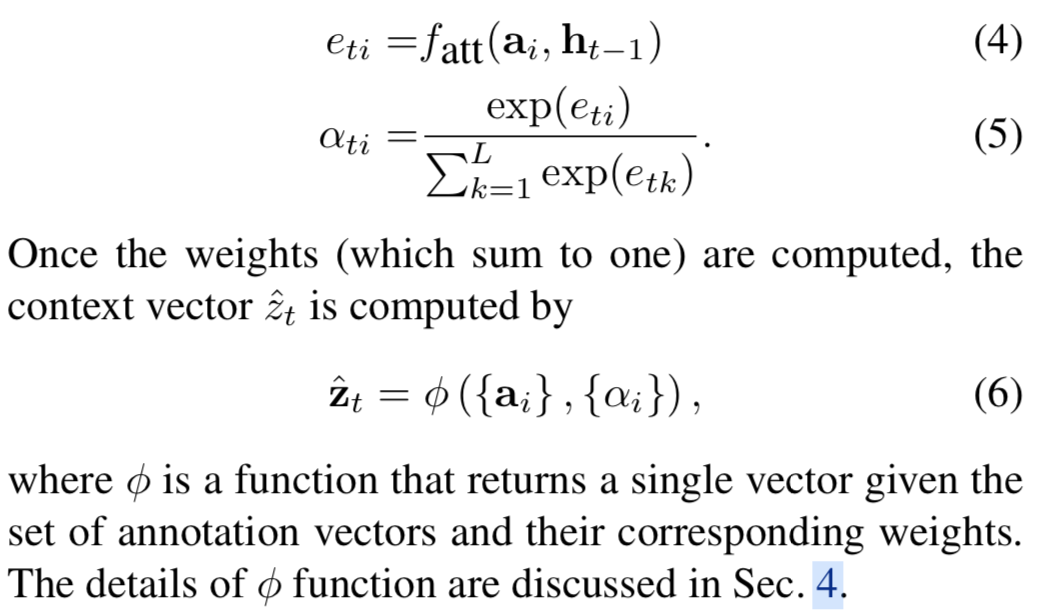

軟、硬注意力的主要區別在於φ函式的計算方式的不同,ai表示抽取出的影象特徵向量。

說完“硬”的 attention,再來說說“軟”的 attention。 相對來說 soft attention 很好理解,在 hard attention 裡面,每個時刻 t 模型的序列 [ St1,…,StL ] 只有一個取 1,其餘全部為 0,

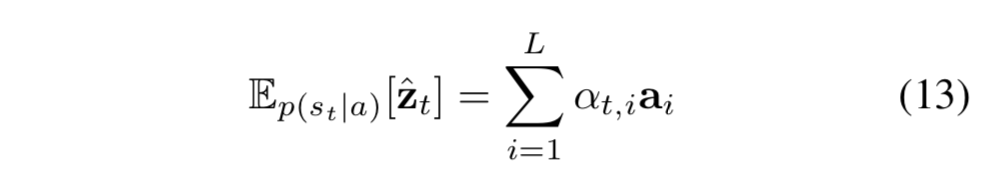

也就是說每次只 focus 一個位置,而 soft attention 每次會照顧到全部的位置,只是不同位置的權重不同罷了。這時 Zt 即為 ai 的加權求和: