大資料學習之路------藉助HDP SANDBOX開始學習

一開始...

一開始知道大資料這個概念的時候,只是感覺很高大上,引起了我的興趣。當時也不知道,這個東西是做什麼的,有什麼用,當然現在看來也是很模糊的樣子,但是的確比一開始強了不少。

所以學習的過程可能會很艱辛甚至有時候會很緩慢,但是感覺這東西未來會很有用途,最初瞭解大資料是從《大資料時代》這本書開始的,裡面的很多概念和預測讓我覺得很神奇。

但是漸漸生活中的一些事物被印證,我漸漸接受了這本書的內容,我覺得這本書還是值得一看的。

在國內這個技術似乎是比較新穎的,做的人似乎不是很多,正因為如此,資料也會匱乏,學習難度也上升了,但是這不是我們放棄的理由不是麼?

藉助平臺管理工具

廢話少說,多學些東西才是正經事,在公司實習過一段時間了,感覺初學的困難之一就是,搭建平臺。

所以我們可以瞭解一下一些比較流行的平臺管理工具:

HDP、CDH

而我在公司使用的便是HDP,所以我就大概的說一下HDP好了

HDP

HDP是什麼?

HDP全稱叫做Hortonworks Data Platform。

Hortonworks資料平臺是一款基於Apache Hadoop的是開源資料平臺,提供大資料雲端儲存,大資料處理和分析等服務。該平臺是專門用來應對多來源和多格式的資料,並使其處理起來能變成簡單、更有成本效益。HDP還提供了一個開放,穩定和高度可擴充套件的平臺,使得更容易地整合Apache Hadoop的資料流業務與現有的資料架構。該平臺包括各種的Apache Hadoop專案以及Hadoop分散式檔案系統(HDFS)、MapReduce、Pig、Hive、HBase、Zookeeper和其他各種元件,使Hadoop的平臺更易於管理,更加具有開放性以及可擴充套件性。

官網地址為:http://zh.hortonworks.com/

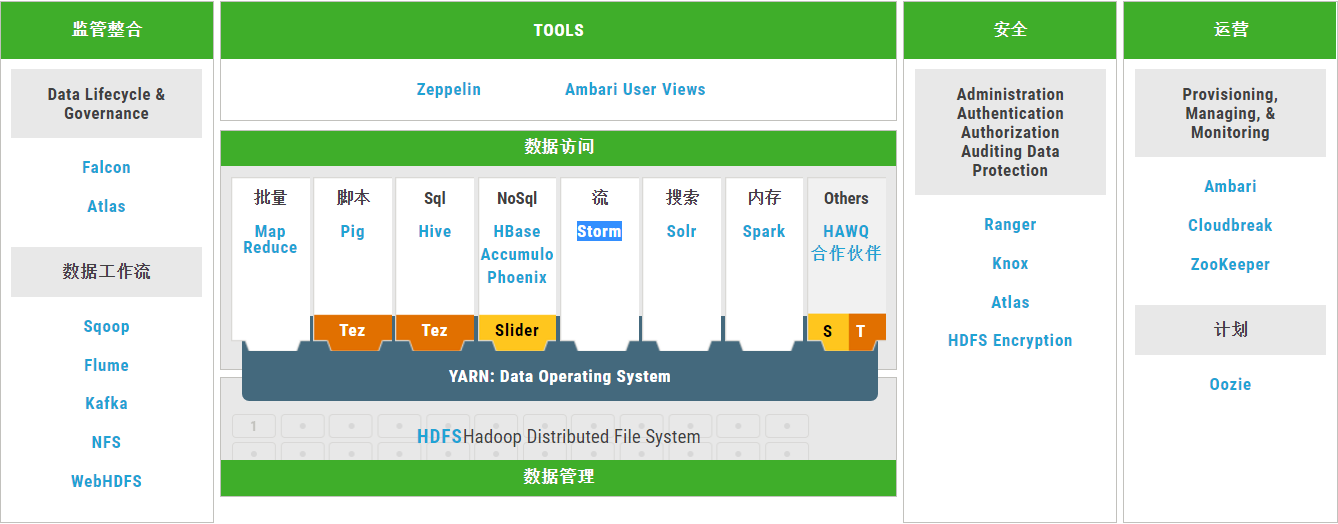

HDP的架構

學習路線:

由上圖看出

大概分為這麼幾類工具:

資料管理: HDFS、YARN

資料訪問: Hive、Tez、Pig、Storm、Spark、HBase、Accumulo、Solr

資料管制和整合:

Atlas、Falcon、Oozie、Sqoop、Flume、Kafka

安全性:

Knox、Ranger

運營:

Ambari Zookeeper

Cloud:

Cloudbreak

既然沒有什麼具體的路線那麼就是一個類一個類的來學習好了。

Hortonworks Sandbox的安裝與使用:

官網上解釋:Hortonworks Sandbox,可以使用它嘗試一下最新的hdp特性和功能。

它可以裝在一個VM上,如此來說,給我們學習大資料相關內容提供了極大的便利

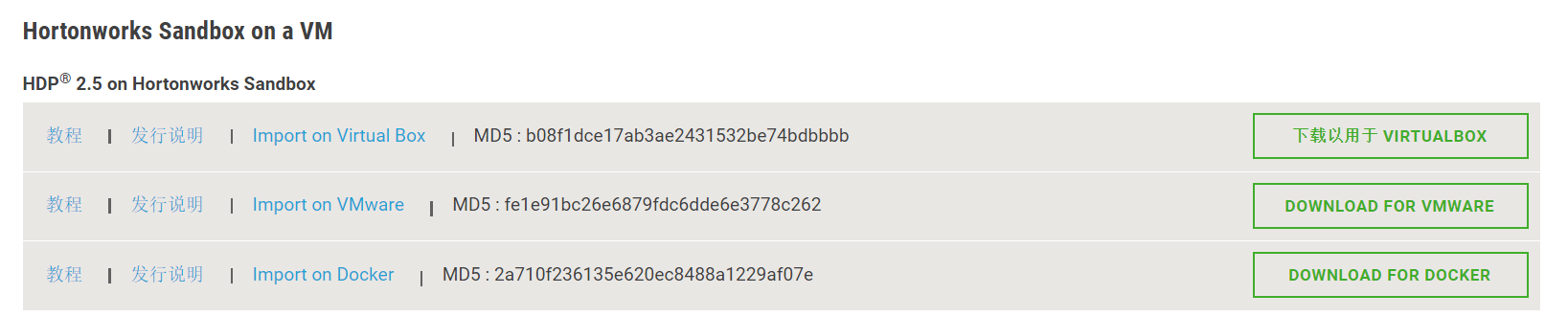

下載地址:http://zh.hortonworks.com/downloads/#sandbox

安裝的方法很簡單,使用相應的虛擬機器軟體,直接匯入就OK了。

注意:我的膝上型電腦是12g記憶體的,而HDP2.5所需要的最小記憶體是8G,而如果你的記憶體不夠,可以選擇低版本的SANDBOX。

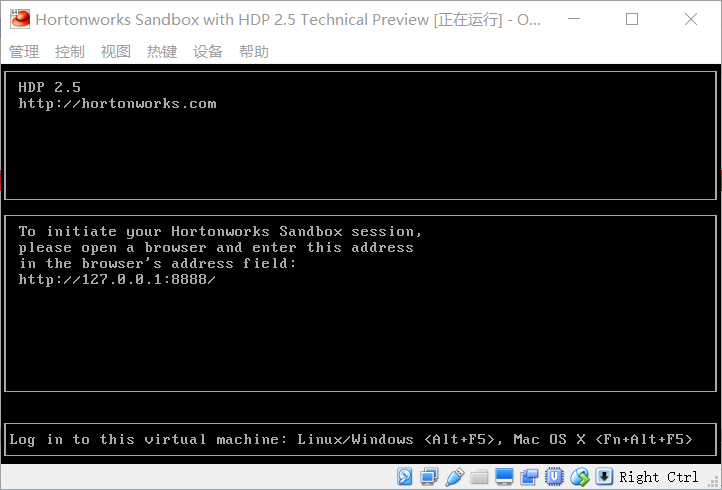

安裝後,開啟虛擬機器就可以了

啟動的過程可能會很久要耐心等待。

啟動如下圖所示:

開啟瀏覽器,輸入http://127.0.0.1:8888/即可。

進入後可以點開 view advanced options來檢視更多的資訊。

右下角有如下內容:

* Service disabled by default. To enable the service you need to log in as an ambari admin.

The ambari admin password can be set by following this tutorial

這裡需要我們進行ssh登入後,新增admin賬戶的密碼,並使用這個admin賬戶來登入虛擬機器。

ssh工具登入使用地址127.0.0.1 埠為 2222

這裡也可以使用瀏覽器進行登入:

在瀏覽器裡輸入127.0.0.1:4200,訪問即可

使用者名稱:root

密碼: hadoop

登入後需要修改密碼,這裡的密碼設定複雜一些,簡單密碼有可能通不過(不過經過本人測試,當你以後再次登入後,可以執行passwd root,修改成任意你想要的密碼)

然後執行ambari-admin-password-reset命令,修改ambari的admin賬戶密碼。

修改後,我們在瀏覽器裡輸入172.0.0.1:8080,並用admin賬戶登入。

截張圖,

關於ambari的介紹如下:

Apache Ambari是一種基於Web的工具,支援Apache Hadoop叢集的供應、管理和監控。Ambari目前已支援大多數Hadoop元件,包括HDFS、MapReduce、Hive、Pig、 Hbase、Zookeper、Sqoop和Hcatalog等。

Apache Ambari 支援HDFS、MapReduce、Hive、Pig、Hbase、Zookeper、Sqoop和Hcatalog等的集中管理。也是5個頂級hadoop管理工具之一。

以後我們就用它來學習了!