Tensorflow下配置CPU+GPU

博主最近剛入坑Tensorflow,配置環境時走了很多坑

找了很多文章,都認為CPU和GPU不能共存

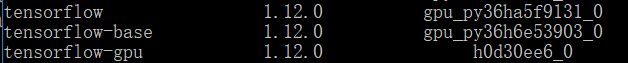

切換到Tensorflow-gpu下 conda list 發現存在 tensorflow

所以呼叫時會先使用 CPU

因此需要uninstall tensorflow 對應命令為 pip uninstall tensorflow

解除安裝後即可優先使用GPU

相關推薦

Tensorflow下配置CPU+GPU

博主最近剛入坑Tensorflow,配置環境時走了很多坑 找了很多文章,都認為CPU和GPU不能共存 切換到Tensorflow-gpu下 conda list 發現存在 tensorflow 所以呼叫時會先使用 CPU 因此需要uninstall tensorfl

win10+vs2013+python2.7 環境下配置下配置無gpu的caffe

##配置之前,請大家一定要注意自己的python版本,一定要是py2.7 caffe 下載地址: https://github.com/Microsoft/... 例外,我這裡有已經編譯好的caffe,在python裡可以直接import,下載地址:https://download.csdn.n

TensorFlow在指定CPU/GPU上執行的方法

轉自:http://wiki.jikexueyuan.com/project/tensorflow-zh/how_tos/using_gpu.html 使用 GPUs 支援的裝置 在一套標準的系統上通常有多個計算裝置. TensorFlow 支援 CPU 和 GPU 這兩種裝置. 我們用指定字串

Caffe初體驗之Caffe-Windows的配置(CPU/GPU)與Mnist資料集測試

配置編譯caffe-windows安裝CUDA(適用GPU版本) 去英偉達下載CUDA7.5,windows10,x86_64,本地安裝,如下圖:下載安裝CUDNN(V4 for cuda7.0或者V5 for cuda7.5)(適用GPU版本) 這個過程的話新使

ubuntu下檢視CPU/GPU/記憶體使用率

在跑一些程式,例如deep learning的時候,總是希望檢視一下cpu、gpu、記憶體的使用率 1. cpu、記憶體 使用top命令 $ top 有一個更直觀的監測工具,叫htop $ sudo apt-get install htop

windows下配置tensorflow-gpu

目錄 1-檢視是否有老版本的nvidia顯示卡驅動,沒有即下載** 2-下載並安裝cuda 1-檢視是否有老版本的nvidia顯示卡驅動,沒有即下載** #終端依次輸入如下命令列下載安裝:

ubuntu環境下配置tensorflow-cpu

目錄 1 這是在本地環境下的tensorflow配置 2下載anaconda來隔離環境,建立環境 3、配置anaconda: 4、啟動Tensorflow開發環境 我個人是從ubuntu系統開始,先配置tensorflow-cpu,然後配置tensorflow-gpu,本文先

tensorflow模型中的GPU和CPU配置

1.GPU和CPU硬體環境設定 1.1. 多GPUs環境設定 gpu='0' #表示PCI卡槽gpu0可見 gpu='3' #表示PCI卡槽gpu3可見 gpu='3,2,0' #表示PCI卡槽g

tensorflow下設定使用某一塊GPU、多GPU、CPU的情況

你要的答案或許都在這裡:tensorflow下設定使用某一塊GPU(從0開始編號):import os os.environ["CUDA_DEVICE_ORDER"] = "PCI_BUS_ID" os

win7下配置faster-rcnn的tensorflow版本(gpu版本)

首先給出原始碼網址:https://github.com/dBeker/Faster-RCNN-TensorFlow-Python3.5所需的軟體環境:python3.5+tensorflow-gpu1.40(gpu版本)+vs2015+pycharm+cuda8.0+cud

Win10下安裝tensorflow教程(cpu版本和GPU版本)

Win10下安裝tensorflow教程 目錄 一、環境配置 1、win10-64位系統 3、anaconda 4.3.14 (vs_community__21855616.1542252661.exe) (社群版下載地址:h

TensorFlow安裝--(方法3)Anaconda方式下檢視TensorFlow版本選擇性安裝(Windows10 64位CPU/GPU)

其它環節與通過Anaconda環境配置方式一樣,就是在安裝TensorFlow時不直接使用pip install --upgrade --ignore-installed tensorflow-gpu命令,而是根據需求選擇TensorFlow版本安裝。 1.執行命令anaconda search

Ubuntu下配置TensorFlow-Gpu版,其對應CUDA、cuDNN版本

TensorFlow官網安裝指導介面提示“執行支援 GPU 的 TensorFlow 所需滿足的 NVIDIA 要求” 檢視機器CUDA、cuDNN版本命令分別是: cat /usr/local/cuda/version.txt cat /usr/local/cuda

TensorFlow學習筆記(一)——Win10下安裝與配置CPU執行的TensorFlow

由於課題需要,在下之後一階段工作主要是使用深度網路來解決問題,擬使用TensorFlow來進行實驗。由於在下對於TensorFlow完全只有小白級別的認識,因此決定一邊學習一邊記錄,一方面便於分享共同進步,一方面請各位大牛幫忙指出在下認識上的錯誤。 由於實驗

[tensorflow] tensorflow-cpu/gpu 安裝過程

src round 兩種 inf 下載安裝 機器 區別 tail anaconda tensorflow由於谷歌的原因,不同的版本有時候改動比較大,所以決定好自己想使用的版本後就不要輕易更改,免得後續移植程序的時候出現很多錯誤。 本文以及後續文章關於tensorfl

tensorflow獲取可用運算裝置(CPU,GPU)

Welcome To My Blog 正常來說,執行下面兩句會列印tensorflow能用的CPU和GPU from tensorflow.python.client import device_lib print(device_lib.list_local_devices())

Linux下檢視CPU和GPU使用情況

Linux下檢視CPU和GPU使用情況 本文記錄瞭如何在Linux系統(以Ubuntu 16.04為例)檢視電腦的GPU和CPU使用情況,包括命令和查詢得到的介面。更新於2018.10.18。 CPU使用情況檢視 動態檢視 開啟終端,輸入: top 即可看到實時

Ubuntu 16.04下配置GPU版CUDA和cuDNN

先介紹一下我自己的配置環境 Ubuntu 16.04 Intel i7 CPU 16G記憶體 GTX980Ti 顯示卡 1、安裝NVIDIA顯示卡驅動 (1)先在NVIDIA官網上下載對應的驅動程式,可根據自己的GPU的型號下載相應的.run檔案 例如NVIDIA-L

7 Recursive AutoEncoder結構遞迴自編碼器(tensorflow)不能呼叫GPU進行計算的問題(非機器配置,而是網路結構的問題)

一、原始碼下載 程式碼最初來源於Github:https://github.com/vijayvee/Recursive-neural-networks-TensorFlow,程式碼介紹如下:“This repository contains the implementation of a single h

linux下檢視CPU、記憶體、磁碟資訊,資料夾資訊,GPU資訊

1、檢視CPU資訊 # 總核數 = 物理CPU個數 X 每顆物理CPU的核數 # 總邏輯CPU數 = 物理CPU個數 X 每顆物理CPU的核數 X 超執行緒數 # 檢視物理CPU個數 cat /proc/cpuinfo| grep "physical id"| sort| uniq| w