David Silver RL課程第1課(關於增強學習的介紹)

1.The difference of the reinforcement learning:(區別於傳統的監督/非監督學習)

-

no supervisor ,only a reward signal(小孩試錯的過程)

-

feedback is delayed,not instantaneous(錯誤的決定不會即時顯現災難,要經過幾個階段的驗證,反饋被延遲)

-

time really matters(sequential連續的,not i.i.d data)(獨立同分布已經被破壞掉了,agent根據環境影響來採取措施應對環境的變化)

2.增強學習可以用在各個領域利用獎勵機制便於優化決策,需要不同資料集的集合。例如在遊戲中通過不斷地學習試錯找到完美的策略。

3.Rewards

-

是一個標量的反饋訊號,用隨機變數

表示。

表示。 -

轉換後的標量獎勵訊號要足夠多,並且有一定的優先順序(有衡量尺度)。

-

每一步決策都要找到對應的

,時每一步的reward相加最後實現最大化

,時每一步的reward相加最後實現最大化

4.Goal:select actions to maximise total future reward

建立統一的框架,使用機器學習的方法,使用相同的形式應對不同的連續決策問題,提前考慮未來,最大化未來的獎勵

-

Actions may have long term consequences

-

Reward may be dalayed

-

It may be better to sacrifice(犧牲) immediate reward to gain more long-term reward

需要提前考慮未來,結果是長期性的。可能不是當下想要的結果,但是經過幾步以後,就變成我們想要的結果了,這就意味著現在需要放棄一些好的獎勵,而在不久的未來則會得到更高的獎勵,所以不要太貪心,需要目光長遠,例如長期投資問題或者飛機飛行油耗問題

5.資料流傳播方向:

agent負責take action,agent採取行動的每一步都是基於它當前所獲得的資訊。agent有兩個輸入,一個是觀察得到的外部資訊,另外一個就是獲得的獎勵,共同決定了下一步的措施。我們的目標就是找到位於大腦中的演算法。

在另一個方面,我們有一個外部環境。隨著時間不斷迴圈agent與environment之間的互動,agent每採取一步行動,agent就會得到來自外部世界觀測的輸入;agent採取行動之後,新的環境就產生了,產生對應的obsercation和reward,產生了下一個外部資訊以及對應的分數。我們不能控制環境,只能唯一地通過agent採取行動這個渠道來影響環境。

-

增強學習是基於觀察,獎勵,行動措施的時間序列。

-

這個時間序列代表著agent的經驗,這個經驗就是用於增強學習的資料。

-

因此增強學習的問題就是聚焦這個資料來源,即這個資料流。

6.History:The history is the sequence of observations,actions,rewards。

![]()

-

What happens next depends on the history:

-

The agent selects actions depends on the history.(建立對映)

-

The environment selects observations/rewards(環境根據history發生變化產生rewards)

-

但是history通常很巨大

7.State 對history簡要的總結,用state代替history

-

State is the information used to determine what happens next.

-

State is a function of the history.

-

state分為agent state和environment state

8.An information state(Markov state) contains all useful information from history.

Markov鏈 (Markov性質)

A state ![]() is Markov if and only if

is Markov if and only if ![]()

下一時刻的狀態與原來的state無關,僅和當下有關

![]()

-

Once the state is known,the history may be thrown away.

-

The state is a sufficient statistic of the future.

-

The environment stste

is Markov.

is Markov. -

The history

is Markov(定義,可以儲存整個的history)

is Markov(定義,可以儲存整個的history)

9.Full observability environment (全觀察環境)(課程大部分涉及到此種環境)

-

agent directly observes environment state(數字所表示的狀態)

-

agent state和environment state相同

agent state和environment state相同 -

This is a Markov decision process(MDP)

10.Partial observability:agent indirectly observes environment

-

eg: robot/poker playing agent

-

此時agent state和environment state不相同

-

This is a partially observable Markov decision process(POMDP)

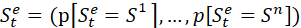

11.建立代理 ![]()

-

記住每一次的觀測,動作,獎勵 complete history:

-

Beliefs of environment state:

(貝葉斯問題)

(貝葉斯問題) -

neural network:

線性組合方式將最近agent的狀態與最近的觀測結合起來,就能得到最新的狀態(迴圈神經網路)

線性組合方式將最近agent的狀態與最近的觀測結合起來,就能得到最新的狀態(迴圈神經網路)

12.An RL agent may include one or more of these components:

-

policy:agent's behaviour function(行為函式,狀態到行動的對映)

-

value function:how good is each state and/or action.(預期獎勵)

-

model:agent's representation of the environment(判斷環境的變化)

13.Policy

-

A policy is the agent's behaviour

-

It is a map from statre to action.

-

Deterministic policy:

-

Stochastic(隨機)policy:

隨即方式狀態對映到狀態

隨即方式狀態對映到狀態

14.Value:未來獎勵的預測

-

Value function is a prediction of future reward.

-

Used to evaluate the goodness and badnenss of states.

-

And therefore to select between actions.

-

對於一種policy

,其中

,其中 是下一階段的獎勵,其中增加一個小於1的權重值,這表明我們更關注當前的獎勵,即

是下一階段的獎勵,其中增加一個小於1的權重值,這表明我們更關注當前的獎勵,即 ,作為折現值。

,作為折現值。

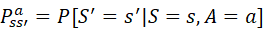

15.Model:並不是環境本身,不是必須要求的。

-

A model predicts what the environment will do next.

-

transition model:P predicts the next state(dynamics)

-

reward model:R predicts the next (immediate) reward.

-

狀態轉換模型:

是根據當前的狀態和動作,環境所處的下一個狀態的概率。

是根據當前的狀態和動作,環境所處的下一個狀態的概率。

![]() 預期獎勵是基於先前的以及當下的狀態的。

預期獎勵是基於先前的以及當下的狀態的。

16.對增強學習分類根據agent是否包含這三個關鍵元素:

-

Value Based:No Policy(Implicit不清楚的),即不需要明確的Policy;Value Function

-

Policy Based:Policy;No Value Function

-

Actor Critic:Policy;Value Function

17.根據model分類:

-

Model Free:Policy and/or Value Function;No Model

-

Model Based:Policy and/or Value FUnction;Model