python網路爬蟲資訊組織與提取

提取HTML中所有URL連結

搜尋到所有<a>標籤

解析<a>標籤格式,提取href後的連結內容!

import requests

r = requests.get("http://python123.io/ws/demo.html")

r.text

demo = r.text

from bs4 import BeautifulSoup

soup = BeautifulSoup(demo , "html.parser")

print(soup.prettify())

from bs4 import BeautifulSoup

Soup = BeautifulSoup(demo, “html.parser”)

for link in soup.find_all('a'):

print(link.get(‘href’))

如果輸入報錯:

https://blog.csdn.net/weixin_42859280/article/details/84203450

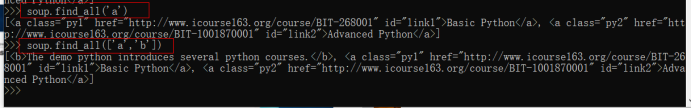

find_all(name)

查詢所有的tag name:

for tag in soup.find_all(True):

Print(tag.name)

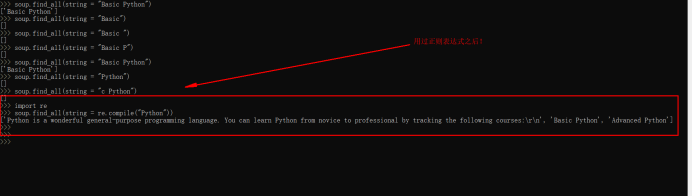

引入正則表示式:import re

匹配含有‘b’的標籤。並將其輸出!

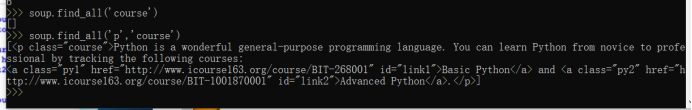

查詢屬性。必須帶個‘p’。因為這個是一個類別。p中包含course字串的資訊!

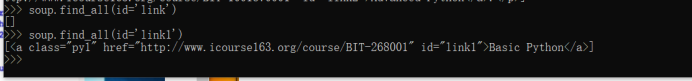

對屬性做約束!看來通過,id=’link1’進行匹配的錯誤一個都不可以!

模糊查詢,就需要正則表示式啦!

Import re

soup.find_all(id=re.compile(‘link’))

以link開頭,但是不完全一致!

用正則表達只需要給出一部分就可以進行模糊搜尋!

soup.find_all('a',recursive=False)對子孫進行搜尋。

String:<>...</>中字串區域的檢索字串。

用過之後:

<tag>(..)等價於<tag>.find_all(..)

soup(..)等價於 soup.find_all(..)

7個方法:

總結:

三種標記資訊的比較:好多圖系列~

YAML:

JSON

HTML:

YAML1: