【七】Spark SQL命令和Spark shell命令操作hive中的表

阿新 • • 發佈:2018-12-22

1.把hive的配置檔案hive-site.xml複製到spark/conf下。

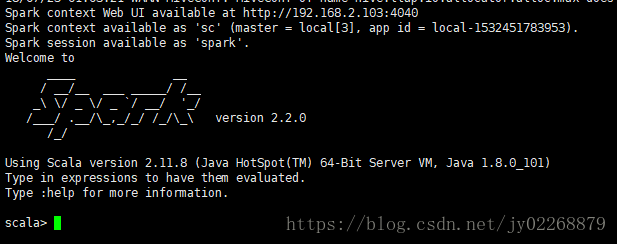

2.啟動的時候帶上MySQL的連線驅動

Spark-shell命令使用

spark-shell是通過得到sparksession然後呼叫sql方法執行hive的sql。

cd /app/spark/spark-2.2.0-bin-2.9.0/bin

./spark-shell --master local[3] --jars /app/mysql-connector-java-5.1.46.jar

spark.sql("show tables").show 通過spark-shell查詢hive中有哪些表

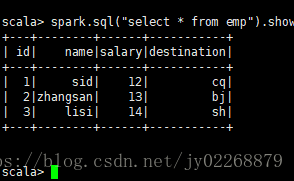

spark.sql("select * from emp").show通過spark-shell查詢hive中的表所有的資料

Spark SQL命令的使用

cd /app/spark/spark-2.2.0-bin-2.9.0/bin

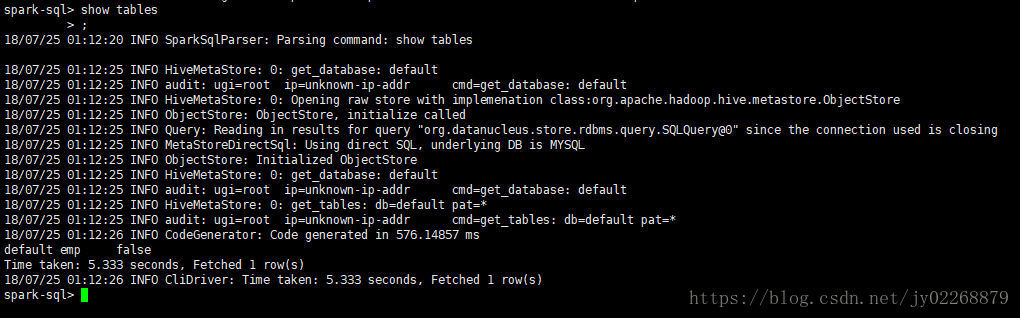

./spark-sql --master local[3] --jars /app/mysql-connector-java-5.1.46.jar

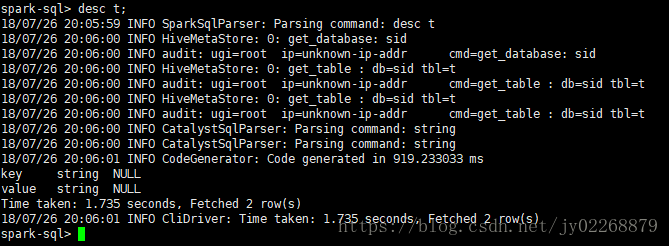

在Spark SQL中可以直接執行SQL操作Hive

檢視hive中有哪些表

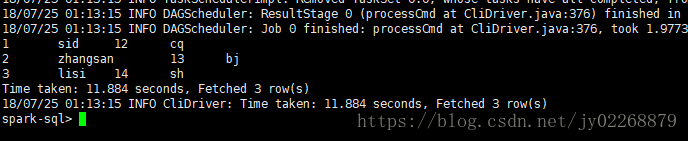

檢視hive的emp表中的資料

spark-sql>select * from emp;

建立一張表到hive中

create table t(key string,value string);