【AI】分類演算法的評估方法

1. 常見術語

這裡首先介紹幾個 常見 的 模型評價術語,現在假設我們的分類目標只有兩類,記為正例(positive)和負例(negtive)分別是:

- True positives(TP): 被正確地劃分為正例的個數,即實際為正例且被分類器劃分為正例的例項數(樣本數)

- False positives(FP): 被錯誤地劃分為正例的個數,即實際為負例但被分類器劃分為正例的例項數

- False negatives(FN):被錯誤地劃分為負例的個數,即實際為正例但被分類器劃分為負例的例項數

- True negatives(TN): 被正確地劃分為負例的個數,即實際為負例且被分類器劃分為負例的例項數

1)P=TP+FN 表示實際為正例的樣本個數。

2)True、False 描述的是分類器是否判斷正確。

3)Positive、Negative 是分類器的分類結果,如果正例計為 1、負例計為-1,即 positive=1、negtive=-1。用 1 表示 True,-1 表示 False,那麼實際的類標=TFPN,TF 為 true 或 false,PN為 positive 或 negtive。

4)例如 True positives(TP)的實際類標=11=1 為正例,False positives(FP)的實際類標=(-1)1=-1 為負例,False negatives(FN)的實際類標=(-1)

2 、評價指標

1)正確率(accuracy)

正確率是我們最常見的評價指標,accuracy = (TP+TN)/(P+N),正確率是被分對的樣本數在所有樣本數中的佔比,通常來說,正確率越高,分類器越好。

2)錯誤率(error rate)

錯誤率則與正確率相反,描述被分類器錯分的比例,error rate = (FP+FN)/(P+N),對某一個例項來說,分對與分錯是互斥事件,所以 accuracy =1 - error rate。

3)靈敏度(sensitive)

sensitive = TP/P,表示的是所有正例中被分對的比例,衡量了分類器對正例的識別能力。

4)特效度(specificity)

specificity = TN/N,表示的是所有負例中被分對的比例,衡量了分類器對負例的識別能力。

5)精度(precision)

精度是精確性的度量,表示被分為正例的示例中實際為正例的比例,precision=TP/ (TP+FP)。

6)召回率(recall)

召回率是覆蓋面的度量,度量有多個正例被分為正例,recall=TP/(TP+FN)=TP/P=sensitive,可以看到召回率與靈敏度是一樣的。

7)其他評價指標

- 計算速度:分類器訓練和預測需要的時間;

- 魯棒性:處理缺失值和異常值的能力;

- 可擴充套件性:處理大資料集的能力;

- 可解釋性:分類器的預測標準的可理解性,像決策樹產生的規則就是很容易理解的,而神經網路的一堆引數就不好理解,我們只好把它看成一個黑盒子。

8)查準率和查全率反映了分類器分類效能的兩個方面。

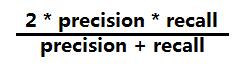

如果綜合考慮查準率與查全率,可以得到新的評價指標 F1 測試值,也稱為綜合分類率:

為了綜合多個類別的分類情況,評測系統整體效能,經常採用的還有微平均 F1(micro-averaging)和巨集平均 F1(macro-averaging )兩種指標。巨集平均 F1 與微平均 F1 是以兩種不同的平均方式求的全域性的 F1 指標。其中巨集平均 F1 的計算方法先對每個類別單獨計算F1 值,再取這些 F1 值的算術平均值作為全域性指標。而微平均 F1 的計算方法是先累加計算各個類別的 a、b、c、d 的值,再由這些值求出 F1 值。由兩種平均 F1 的計算方式不難看出,巨集平均 F1 平等對待每一個類別,所以它的值主要受到稀有類別的影響,而微平均 F1 平等考慮文件集中的每一個文件,所以它的值受到常見類別的影響比較大。