博導推薦給我一本基於Python實現爬蟲的書, 最適合程式猿們看的!

網際網路包括了至今為止最有效的資料集,並且大年夜大年夜區域性能地下收費拜候。但這些資料根基上不克不及複用。它們被嵌入在網站的佈局、樣式中,得抽取出來才調應用。我們從網頁中抽取資料的過程就是我們熟知的彙集爬蟲,網際網路期間每天都有大年夜大年夜量的資訊被頒佈發表到彙集上,彙集爬蟲也愈來愈有效。

網際網路包含了迄今為止最有效的資料集,並且大年夜大年夜區域性可以收費地下拜候。

在這裡相信有許多想要學習Python的同學,大家可以+下Python學習分享裙:叄零肆+零伍零+柒玖玖,即可免費領取一整套系統的 Python學習教程!

爬蟲甚麼時辰有效

假定我有一個服裝店,並且想要及時知道競爭敵手的代價。

總之,我們不克不及僅僅依託於API去拜候我們所需的線上資料,而是該當進修一些彙集爬蟲技能的相干常識。

本書基於Python 3

在本書中完全應用Python 3遏制開闢

關於初學者來講,我引薦應用Conda,因為其需要的裝配任務更少一些。

編寫第一個彙集爬蟲

抓取網站資料,我們起首得下載包含有感興味資料的網頁,這個過程稱之為爬取(crawling)。

1、抓取與爬取的對比

根據我們所存眷的資訊和站點內容、佈局的不合,可以或許需要遏制彙集抓取或是網站爬取。

那麼它們有甚麼差別呢?

例如:可否只用於抓取?可否也合用於爬蟲?

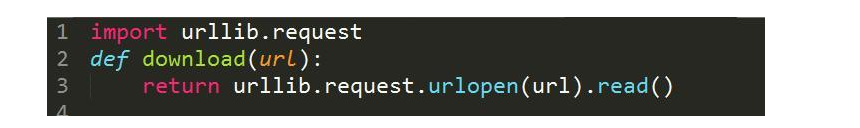

2、下載網頁

我們要想抓取網頁的話,起首需要將其下載上去。示例指令碼應用urllib模組下載URL。

傳入URL引數時,該函式將會下載網頁並前去其HTML。不過,這個程式碼片段存在一個結果,當我們下載網頁時,可以或許會碰著一些沒法節制的缺點,比如懇求的頁面可以或許不存在。這個時辰urllib會丟擲異常,然撤離撤離出指令碼。

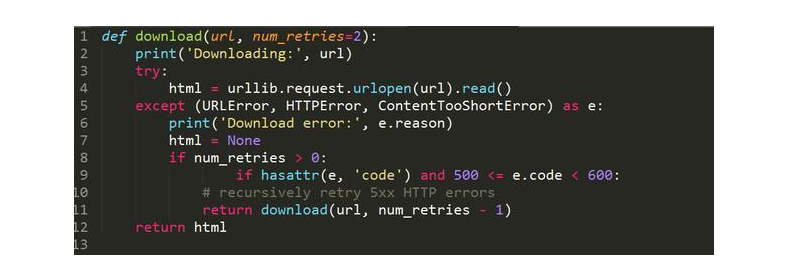

安然起見,下面再給出一個更穩建的版本,可以捕獲這些異常。

此刻,當呈現下載或URL缺點時,該函式可以或許捕獲到異常,然後前去None。

3、重試下載

我們不才載時碰著的缺點通俗都是臨時性的,例如處事器過載時前去的503 Service Unavailable缺點。

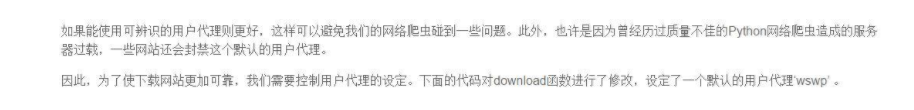

下面是支慎重試下載功用的新版本程式碼:

此刻,在download函式碰著5xx缺點碼時,會遞迴呼叫函式本身來重試。該函式還增加了一個引數,用於設定重試下載的次數,默覺得兩次。之所以在這裡限制網頁下載查驗查驗次數,可以或許是處事器缺點臨時還木有恢復。想要測這個該函式,可以查驗查驗下載http://httpstat.us/500,這個網址會一向前去500缺點碼。

疇前去的結果可以看出,download函式的行動和預期不合,先查驗查驗下載網頁,在採取到500缺點後,又遏制了兩次重試才對峙。

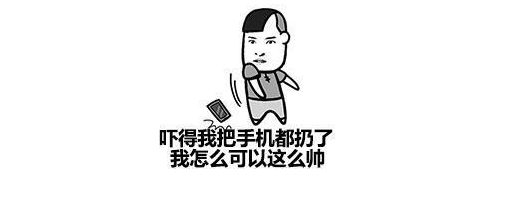

4、設定使用者代辦代理

在默許狀況下urllib應用Python-urllib/``3.x作為使用者代辦代理下載網頁內容,3.x是正在應用的Python版本號。

即Web Scraping with Python的首字母縮寫

此刻再次拜候meetup.com,便可以看到一個合法的HTML了。下載函式在後續程式碼中可以獲得複用,這個函式可以或許捕獲異常,在可以或許的狀況下重試網站和設定使用者代辦代理。

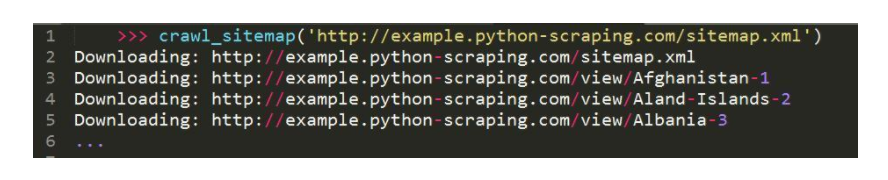

5、網站地圖爬蟲

在第一個簡單的爬蟲中,我們將應用示例網站robots.txt檔案中發現的網站地圖來下載一切網頁。為知道析網站地圖,就用一個簡單的正則表示式,從標籤中提取出URL。需要更新程式碼以措置編碼轉換,因為今朝的download函式只是簡單地前去了位元組。

程式碼:

此刻運轉網站地圖爬蟲,從示例網站中下載一切國度或地區頁面。

正以下面程式碼中的download編制所示,我們必須更新字元編碼才調應用正則表示式措置網站照顧。

下一節中,我們將會引見另外一個簡單的爬蟲,該爬蟲不再依託於Sitemap檔案。

6、ID遍歷爬蟲

本節中應用網站佈局的弱點,加倍輕鬆地拜候一切內容。

從上圖可以看出,網頁照樣可以載入成功,也就是說這個別例是有效的。此刻我們便可以疏忽頁面別號,只應用資料庫ID來下載一切國度(或地區)的頁面了。

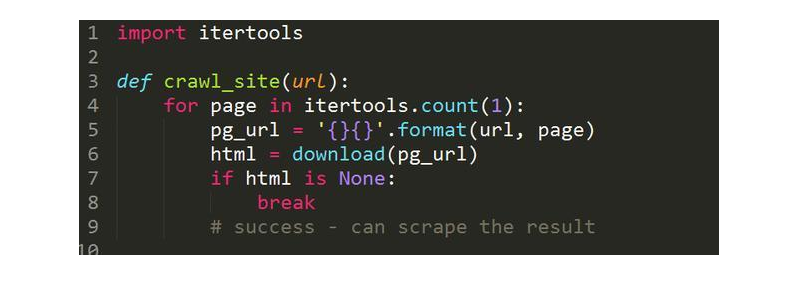

來看看應用了該身手的程式碼片段

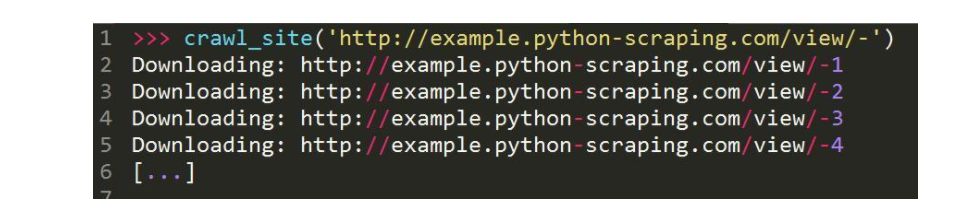

我們此刻可以應用該函式傳入根基URL

在這段程式碼中對ID遏制遍歷,直到呈現下載缺點再中斷,假定抓取已達到最後一個國度的頁面。

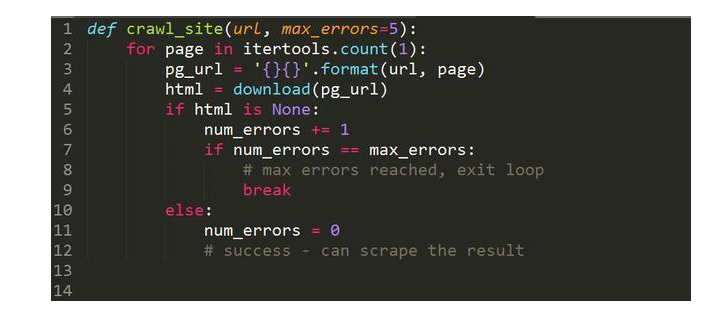

但這類完成編制是出缺點的,那就是某些記錄可以或許已被刪除,資料庫ID之間其實不是繼續的。這個時辰只需拜候到某個距離點,爬蟲就會立時參與。以下是這段程式碼的改進版本,在這個版本中繼續產生多次下載缺點後才會參與法度典型。

以上程式碼中完成的爬蟲得繼續5次下載缺點才會中斷遍歷,多麼就極大年夜大年夜地降落了碰著記錄被刪除或埋沒時過早中斷遍歷的風險。

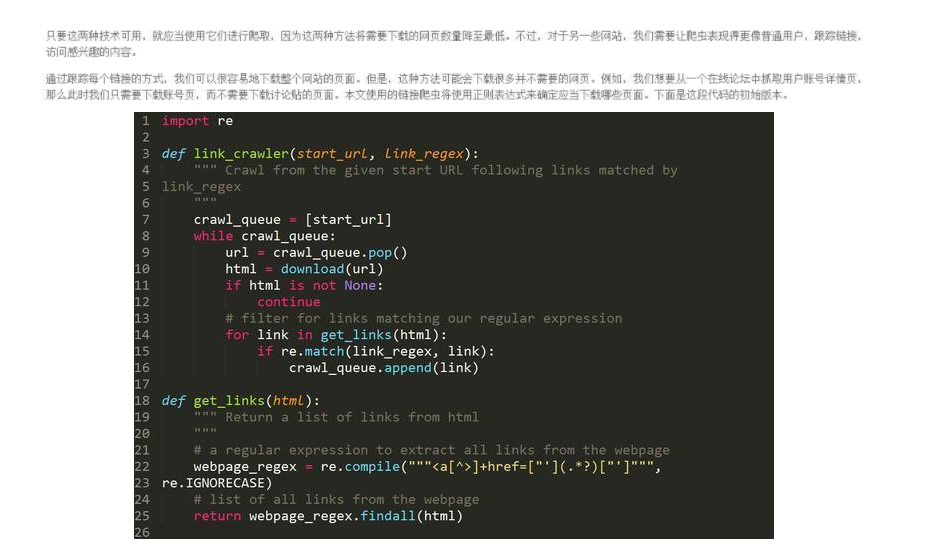

7、連結爬蟲

要運轉這段程式碼,只需要呼叫link_crawler函式,並傳入兩個引數。

要爬取的網站URL

用於婚配你想跟蹤的連結的正則表示式

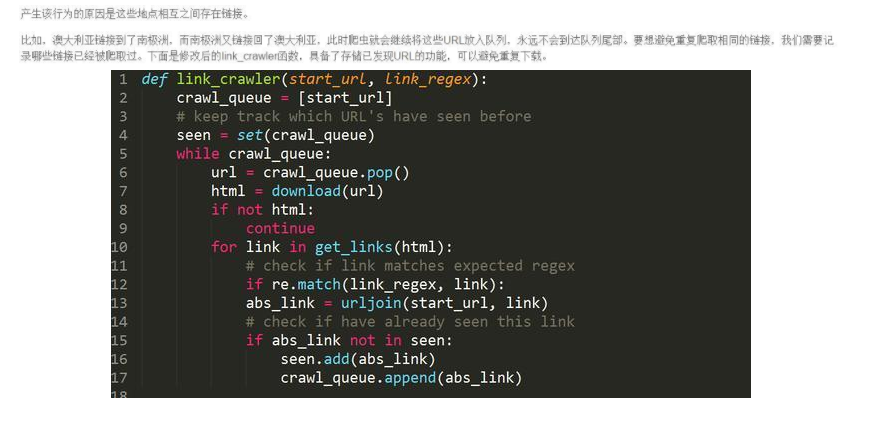

關於示例網站來講,我們想要爬取的是國度(或地區)列表索引頁和國度(或地區)頁面。

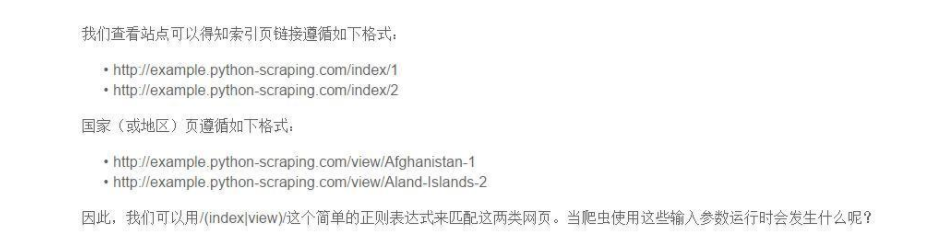

你會獲得以下所示的下載缺點:

可以看出,結果出不才載/index/1時,連結只要網頁的路子區域性沒有和談和處事器區域性,這是一個相對連結。

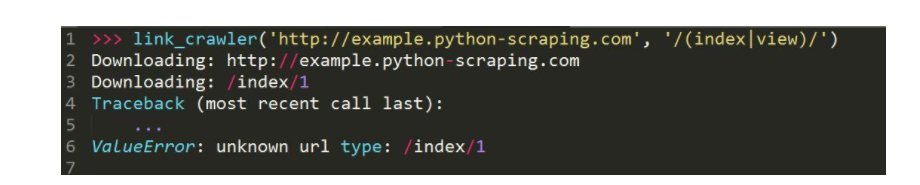

我們在運轉這段程式碼時,當然下載了婚配的網頁,然則異常的地址會被賡續反覆下載到。

我們運轉這個指令碼的時辰它會爬取一切地址,並且可以或許如期中斷。終究獲得了一個可用的連結爬蟲。