基於NFS的儲存_Kubernetes中文社群

1、NFS介紹

NFS是Network File System的簡寫,即網路檔案系統,NFS是FreeBSD支援的檔案系統中的一種。NFS基於RPC(Remote Procedure Call)遠端過程呼叫實現,其允許一個系統在網路上與它人共享目錄和檔案。通過使用NFS,使用者和程式就可以像訪問本地檔案一樣訪問遠端系統上的檔案。NFS是一個非常穩定的,可移植的網路檔案系統。具備可擴充套件和高效能等特性,達到了企業級應用質量標準。由於網路速度的增加和延遲的降低,NFS系統一直是通過網路提供檔案系統服務的有競爭力的選擇 。

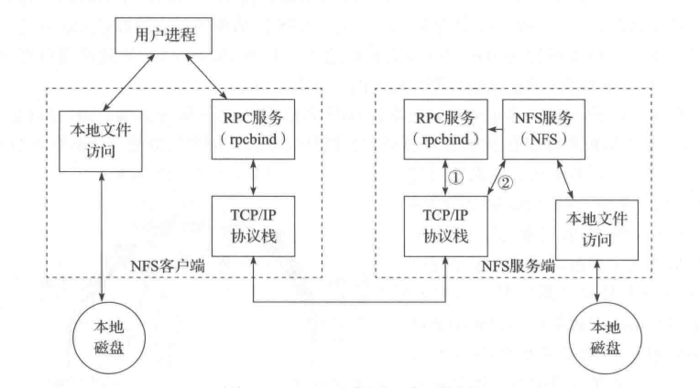

1.1 nfs原理

NFS 使用RPC(Remote Procedure Call)的機制進行實現,RPC使得客戶端可以呼叫服務端的函式。同時,由於有 VFS 的存在,客戶端可以像使用其它普通檔案系統一樣使用 NFS 檔案系統。經由作業系統的核心,將 NFS 檔案系統的呼叫請求通過 TCP/IP 傳送至服務端的 NFS 服務。NFS伺服器執行相關的操作,並將操作結果返回給客戶端。

NFS服務主要程序包括:

- rpc.nfsd:最主要的NFS程序,管理客戶端是否可登入

- rpc.mountd:掛載和解除安裝NFS檔案系統,包括許可權管理

- rpc.lockd:非必要,管理檔案鎖,避免同時寫出錯

- rpc.statd:非必要,檢查檔案一致性,可修復檔案

nfs的關鍵工具包括:

- 主要配置檔案:/etc/exports;

- NFS檔案系統維護命令:/usr/bin/exportfs;

- 共享資源的日誌檔案: /var/lib/nfs/*tab;

- 客戶端查詢共享資源命令: /usr/sbin/showmount;

- 埠配置: /etc/sysconfig/nfs。

1.2 共享配置

在NFS伺服器端的主要配置檔案為/etc/exports時,通過此配置檔案可以設定共享檔案目錄。每條配置記錄由NFS共享目錄、NFS客戶端地址和引數這3部分組成,格式如下:

[NFS共享目錄] [NFS客戶端地址1(引數1,引數2,引數3……)] [客戶端地址2(引數1,引數2,引數3……)]

- NFS共享目錄:伺服器上共享出去的檔案目錄;

- NFS客戶端地址:允許其訪問的NFS伺服器的客戶端地址,可以是客戶端IP地址,也可以是一個網段(192.168.64.0/24);

- 訪問引數:括號中逗號分隔項,主要是一些許可權選項。

1)訪問許可權引數

|

序號 |

選項 |

描述 |

| 1 | ro | 客戶端對於共享檔案目錄為只讀許可權。(預設設定) |

| 2 | rw | 客戶端對共享檔案目錄具有讀寫許可權。 |

2)使用者對映引數

|

序號 |

選項 |

描述 |

| 1 | root_squash | 使客戶端使用root賬戶訪問時,伺服器對映為伺服器本地的匿名賬號。 |

| 2 | no_root_squash | 客戶端連線服務端時如果使用的是root的話,那麼也擁有對服務端分享的目錄的root許可權。 |

| 3 | all_squash | 將所有客戶端使用者請求對映到匿名使用者或使用者組(nfsnobody)。 |

| 4 | no_all_squash | 與上相反(預設設定)。 |

| 5 | anonuid=xxx | 將遠端訪問的所有使用者都對映為匿名使用者,並指定該使用者為本地使用者(UID=xxx)。 |

| 6 | anongid=xxx | 將遠端訪問的所有使用者組都對映為匿名使用者組賬戶,並指定該匿名使用者組賬戶為本地使用者組賬戶(GID=xxx)。 |

3)其它配置引數

|

序號 |

選項 |

描述 |

| 1 | sync | 同步寫操作,資料寫入儲存裝置後返回成功資訊。(預設設定) |

| 2 | async | 非同步寫操作,資料在未完全寫入儲存裝置前就返回成功資訊,實際還在記憶體。 |

| 3 | wdelay | 延遲寫入選項,將多個寫操請求合併後寫入硬碟,減少I/O次數,NFS非正常關閉資料可能丟失(預設設定)。 |

| 4 | no_wdelay | 與上相反,不與async同時生效,如果NFS伺服器主要收到小且不相關的請求,該選項實際會降低效能。 |

| 5 | subtree | 若輸出目錄是一個子目錄,則nfs伺服器將檢查其父目錄的許可權(預設設定); |

| 6 | no_subtree | 即使輸出目錄是一個子目錄,nfs伺服器也不檢查其父目錄的許可權,這樣可以提高效率 |

| 7 | secure | 限制客戶端只能從小於1024的tcp/ip埠連線nfs伺服器(預設設定)。 |

| 8 | insecure | 允許客戶端從大於1024的tcp/ip埠連線伺服器。 |

2、nfs服務端配置

在nfs作為網路檔案儲存系統前,首先,需要安裝nfs和rpcbind服務;接著,需要建立使用共享目錄的使用者;然後,需要對共享目錄進行配置,這是其中相對重要和複雜的一個步驟;最後,需要啟動rpcbind和nfs服務,以供應用使用。

2.1 安裝nfs服務

1)通過yum目錄安裝nfs服務和rpcbind服務:

$ yum -y install nfs-utils rpcbind

2)檢查nfs服務是否正常安裝

$ rpcinfo -p localhost

2.2 建立使用者

為NFS服務其新增使用者,並建立共享目錄,以及設定使用者設定共享目錄的訪問許可權:

$ useradd -u nfs

$ mkdir -p /nfs-share $ chmod a+w /nfs-share

2.3 配置共享目錄

在nfs伺服器中為客戶端配置共享目錄:

$ echo "/nfs-share *(rw,async,no_root_squash)" >> /etc/exports

通過執行如下命令是配置生效:

$exportfs -r

2.4 啟動服務

1)由於必須先啟動rpcbind服務,再啟動nfs服務,這樣才能讓nfs服務在rpcbind服務上註冊成功:

$ systemctl start rpcbind

2)啟動nfs服務:

$ systemctl start nfs-server

3)設定rpcbind和nfs-server開機啟動:

$ systemctl enable rpcbind $ systemctl enable nfs-server

2.5 檢查nfs服務是否正常啟動

$ showmount -e localhost $ mount -t nfs 127.0.0.1:/data /mnt

3、nfs作為volume

nfs可以直接作為儲存卷使用,下面是一個redis部署的YAML配置檔案。在此示例中,redis在容器中的持久化資料儲存在/data目錄下;儲存卷使用nfs,nfs的服務地址為:192.168.8.150,儲存路徑為:/k8s-nfs/redis/data。容器通過volumeMounts.name的值確定所使用的儲存卷。

apiVersion: apps/v1 # for versions before 1.9.0 use apps/v1beta2

kind: Deployment

metadata:

name: redis

spec:

selector:

matchLabels:

app: redis

revisionHistoryLimit: 2

template:

metadata:

labels:

app: redis

spec:

containers:

# 應用的映象

- image: redis

name: redis

imagePullPolicy: IfNotPresent

# 應用的內部埠

ports:

- containerPort: 6379

name: redis6379

env:

- name: ALLOW_EMPTY_PASSWORD

value: "yes"

- name: REDIS_PASSWORD

value: "redis"

# 持久化掛接位置,在docker中

volumeMounts:

- name: redis-persistent-storage

mountPath: /data

volumes:

# 宿主機上的目錄

- name: redis-persistent-storage

nfs:

path: /k8s-nfs/redis/data

server: 192.168.8.150

4、nfs作為PersistentVolum

在Kubernetes當前版本的中,可以建立型別為nfs的持久化儲存卷,用於為PersistentVolumClaim提供儲存卷。在下面的PersistenVolume YAML配置檔案中,定義了一個名為nfs-pv的持久化儲存卷,此儲存卷提供了5G的儲存空間,只能由一個PersistentVolumClaim進行可讀可寫操作。此持久化儲存卷使用的nfs伺服器地址為192.168.5.150,儲存的路徑為/tmp。

apiVersion: v1

kind: PersistentVolume

metadata:

name: nfs-pv

spec:

capacity:

storage: 5Gi

volumeMode: Filesystem

accessModes:

- ReadWriteOnce

persistentVolumeReclaimPolicy: Recycle

storageClassName: slow

mountOptions:

- hard

- nfsvers=4.1

# 此持久化儲存卷使用nfs外掛

nfs:

# nfs共享目錄為/tmp

path: /tmp

# nfs伺服器的地址

server: 192.168.5.150

通過執行如下的命令可以建立上述持久化儲存卷:

$ kubectl create -f {path}/nfs-pv.yaml

儲存卷建立成功後將處於可用狀態,等待PersistentVolumClaim使用。PersistentVolumClaim會通過訪問模式和儲存空間自動選擇合適儲存卷,並與其進行繫結。

5、nfs作為動態儲存提供

5.1 部署nfs-provisioner

為nfs-provisioner例項選擇儲存狀態和資料的儲存卷,並將儲存卷掛接到容器的/export 命令。

... volumeMounts: - name: export-volume mountPath: /export volumes: - name: export-volume hostPath: path: /tmp/nfs-provisioner ...

為StorageClass選擇一個供應者名稱,並在deploy/kubernetes/deployment.yaml進行設定。

args: - "-provisioner=example.com/nfs" ...

完整的deployment.yaml檔案內容如下:

kind: Service

apiVersion: v1

metadata:

name: nfs-provisioner

labels:

app: nfs-provisioner

spec:

ports:

- name: nfs

port: 2049

- name: mountd

port: 20048

- name: rpcbind

port: 111

- name: rpcbind-udp

port: 111

protocol: UDP

selector:

app: nfs-provisioner

---

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

name: nfs-provisioner

spec:

replicas: 1

strategy:

type: Recreate

template:

metadata:

labels:

app: nfs-provisioner

spec:

containers:

- name: nfs-provisioner

image: quay.io/kubernetes_incubator/nfs-provisioner:v1.0.8

ports:

- name: nfs

containerPort: 2049

- name: mountd

containerPort: 20048

- name: rpcbind

containerPort: 111

- name: rpcbind-udp

containerPort: 111

protocol: UDP

securityContext:

capabilities:

add:

- DAC_READ_SEARCH

- SYS_RESOURCE

args:

# 定義提供者的名稱,儲存類通過此名稱指定提供者

- "-provisioner=nfs-provisioner"

env:

- name: POD_IP

valueFrom:

fieldRef:

fieldPath: status.podIP

- name: SERVICE_NAME

value: nfs-provisioner

- name: POD_NAMESPACE

valueFrom:

fieldRef:

fieldPath: metadata.namespace

imagePullPolicy: "IfNotPresent"

volumeMounts:

- name: export-volume

mountPath: /export

volumes:

- name: export-volume

hostPath:

path: /srv

在設定好deploy/kubernetes/deployment.yaml檔案後,通過kubectl create命令在Kubernetes叢集中部署nfs-provisioner。

$ kubectl create -f {path}/deployment.yaml

5.2 建立StorageClass

下面是example-nfs的StorageClass配置檔案,此配置檔案定義了一個名稱為nfs-storageclass的儲存類,此儲存類的提供者為nfs-provisioner。

apiVersion: storage.k8s.io/v1 kind: StorageClass metadata: name: nfs-storageclass provisioner: nfs-provisioner

通過kubectl create -f命令使用上面的配置檔案建立:

$ kubectl create -f deploy/kubernetes/class.yaml

storageclass “example-nfs” created

在儲存類被正確建立後,就可以建立PersistenetVolumeClaim來請求StorageClass,而StorageClass將會為PersistenetVolumeClaim自動建立一個可用PersistentVolume。

5.3 建立PersistenetVolumeClaim

PersistenetVolumeClaim是對PersistenetVolume的宣告,即PersistenetVolume為儲存的提供者,而PersistenetVolumeClaim為儲存的消費者。下面是PersistentVolumeClaim的YAML配置檔案,此配置檔案通過metadata.annotations[].volume.beta.kubernetes.io/storage-class欄位指定所使用的儲存儲類。

在此配置檔案中,使用nfs-storageclass儲存類為PersistenetVolumeClaim建立PersistenetVolume,所要求的PersistenetVolume儲存空間大小為1Mi,可以被多個容器進行讀取和寫入操作。

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: nfs-pvc

annotations:

volume.beta.kubernetes.io/storage-class: "nfs-storageclass"

spec:

accessModes:

- ReadWriteMany

resources:

requests:

storage: 1Mi

通過kubectl create命令建立上述的持久化儲存卷宣告:

$ kubectl create -f {path}/claim.yaml

5.4 建立使用PersistenVolumeClaim的部署

在這裡定義名為busybox-deployment的部署YAML配置檔案,使用的映象為busybox。基於busybox映象的容器需要對/mnt目錄下的資料進行持久化,在YAML檔案指定使用名稱為nfs的PersistenVolumeClaim對容器的資料進行持久化。

# This mounts the nfs volume claim into /mnt and continuously

# overwrites /mnt/index.html with the time and hostname of the pod.

apiVersion: v1

kind: Deployment

metadata:

name: busybox-deployment

spec:

replicas: 2

selector:

name: busybox-deployment

template:

metadata:

labels:

name: busybox-deployment

spec:

containers:

- image: busybox

command:

- sh

- -c

- 'while true; do date > /mnt/index.html; hostname >> /mnt/index.html; sleep $(($RANDOM % 5 + 5)); done'

imagePullPolicy: IfNotPresent

name: busybox

volumeMounts:

# name must match the volume name below

- name: nfs

mountPath: "/mnt"

#

volumes:

- name: nfs

persistentVolumeClaim:

claimName: nfs-pvc

通過kubectl create建立busy-deployment部署:

$ kubectl create -f {path}/nfs-busybox-deployment.yaml

參考資料

作者簡介:

季向遠,北京神舟航天軟體技術有限公司產品經理。本文版權歸原作者所有。