知識點-協程gvent爬蟲

採用協程,擋在io阻塞時候自動切換會加快程式縮短時間也利用了等待時間

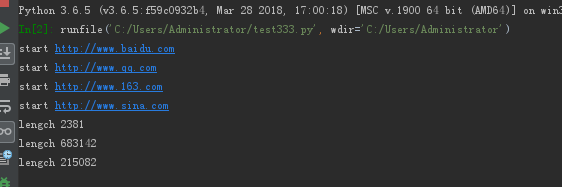

本案例注意gevent.monkey.patch_all() 放在requests庫引用前,避免出現ssl等錯誤

import gevent import gevent.monkey gevent.monkey.patch_all() import requests def download(url): print("start",url) data=requests.get(url).text print("lengch",len(data)) gevent.joinall([ gevent.spawn(download,"http://www.baidu.com"), gevent.spawn(download,"http://www.qq.com"), gevent.spawn(download,"http://www.163.com"), gevent.spawn(download,"http://www.sina.com"), ])

相關推薦

知識點-協程gvent爬蟲

採用協程,擋在io阻塞時候自動切換會加快程式縮短時間也利用了等待時間 本案例注意gevent.monkey.patch_all() 放在requests庫引用前,避免出現ssl等錯誤 import gevent import gevent.monkey gevent.monkey

python采用 多進程/多線程/協程 寫爬蟲以及性能對比,牛逼的分分鐘就將一個網站爬下來!

分配 返回 afa 一個 同方 except erer 簡單 direct 首先我們來了解下python中的進程,線程以及協程! 從計算機硬件角度: 計算機的核心是CPU,承擔了所有的計算任務。一個CPU,在一個時間切片裏只能運行一個程序。 從操作系統的角度: 進程

協程實現爬蟲的例子主要優勢在於充分利用IO時間去請求其他的url

ret value utf 換工作 發生 url monkey 兩個 利用 # 分別使用urlopen和requests兩個模塊進行演示 # import requests # 需要安裝的 # from urllib.request import urlopen # #

Python知識點-協程

完成 線程並發 猴子補丁 無限 從服務器 開始 nal def accep 協程就是一個線程,只是說再一個線程上來回切換。 協程切換任務是靠代碼,遇到IO 操作就切換,而線程和進程是靠操作系統自動切換 1.greenlet from greenlet import gr

小爬蟲程序協程版

write 提升 con AD pic exceptio 代碼 www. == import gevent from gevent import monkey import requests,time,re,os """ 協程爬蟲的意義在於解決堵塞的耗時操作,epoll機

進程,線程,協程,異步IO知識點

variables down mas sock pipe unique soc read 但是 進程: qq 要以一個整體的形式暴露給操作系統管理,裏面包含對各種資源的調用,內存的管理,網絡接口的調用等。。。對各種資源管理的集合 就可以成為 進程線程: 是操作系統最小的調

500 Lines or Less | A Web Crawler With asyncio Coroutines:用協程寫web爬蟲

1 def fetch(url): 2 sock = socket.socket() 3 sock.connect(('xkcd.com', 80)) 4 request = 'GET {} HTTP/1.0\r\nHost: xkcd.com\r\n\r\n'.form

python爬蟲——多執行緒+協程(threading+gevent)

以下摘自這篇文章:https://blog.csdn.net/qq_23926575/article/details/76375337 在爬蟲中廣泛運用的多執行緒+協程的解決方案,親測可提高效率至少十倍以上。 本文既然提到了執行緒和協程,我覺得有必要在此對程序、執行緒、協程做一個簡單的對

朋友爬蟲例項(採用協程池的方式)運用了Python的class

import gevent from gevent import monkey monkey.patch_all() import xlwt,xlrd,xlutils from xlutils.copy import copy import os,time im

使用協程池實現爬蟲的具體實現

# coding=utf-8 import gevent.monky gevent.monky.path_all() from gevent.pool import Pool import requests from lxml import etree from qu

python3.6 多程序+協程的配合 提升爬蟲效率?

上篇部落格協程asyncio+aiohttp模組非同步採集資料,效率比多執行緒或多程序高很多。是否還能再優化,利用多程序+協程將效率翻倍呢? 程式碼: (參照 L瑜的文章:<python中多程序+協程的使用以及為什麼要用它>寫了如下測試,非同步部分沒有用gev

Python奇技淫巧之利用協程加速百度百科詞條爬蟲

前一個系列文章主要利用百度AI的Python SDK進行影象識別、語音合成、語音識別,實現了一些有趣的小案例,實際上百度AI的功能遠不止這些,更多高逼格的東西例如NLP、輿情分析、知識圖譜等有待大家進一步發掘。 學習Python中有不明白推薦加入交流群 &

Python多程序協程爬蟲----1

考慮到CPU和IO之間巨大的速度差異,一個任務在執行的過程中大部分時間都在等待IO操作,單程序單執行緒模型會導致別的任務無法並行執行,因此,我們才需要多程序模型或者多執行緒模型來支援多工併發執行。 現代作業系統對IO操作已經做了巨大的改進,最大的特點就是支援非同步IO。

Python3之協程爬蟲應用

from gevent import monkey; monkey.patch_all() import gevent, requests def get_page(url): ret =

爬蟲進階之非同步協程

一、背景 之前爬蟲使用的是requests+多執行緒/多程序,後來隨著前幾天的深入瞭解,才發現,對於爬蟲來說,真正的瓶頸並不是CPU的處理速度,而是對於網頁抓取時候的往返時間,因為如果採用requests+多執行緒/多程序,他本身是阻塞式的程式設計,所以時間都花費在了等待網頁結果的返回和對爬取到的資料的寫

深入理解協程(四):async/await非同步爬蟲實戰

本文目錄: 同步方式爬取部落格標題 async/await非同步爬取部落格標題 本片為深入理解協程系列文章的補充。 你將會在從本文中瞭解到:async/await如何運用的實際的爬蟲中。 案例 從CSDN上批量爬取指定文章的標題。文章列表如下: urls = [ 'https://blog.csd

併發程式設計中死鎖、遞迴鎖、程序/執行緒池、協程TCP伺服器併發等知識點

1、死鎖 定義; 類似兩個人分別被囚禁在兩間房子裡,A手上拿著的是B囚禁房間的鑰匙,而B拿著A的鑰匙,兩個人都沒法出去,沒法給對方開鎖,進而造成死鎖現象。具體例子程式碼如下: # -*-coding:utf-8 -*- from threading import Thread,Lock,RLoc

LUA協程復用

hid unpack line comm pen ring 創建 -- end -----協程復用根函數 local function routine(fun, args) while (fun) do fun, args =

Unity在協程內部停止協程自身後代碼執行問題

num png urn cor art turn oid col 測試 當在協程內部停止自身後,後面的代碼塊還會繼續執行,直到遇到yield語句才會終止。 經測試:停止協程,意味著就是停止yield,所以在停止協程後,yield之後的語句也就不會執行了。 代碼如下: 1

協程-gevent

協程-gevent協程用gevent實現, 依賴libevent和greenlet###安裝1. 安裝libevent yum install libevent2. 安裝easy_install 【1】wget -q http://peak.telecommunity.com/dist/ez_setup