爬取某線上惡意軟體倉庫病毒檔案進行分析

阿新 • • 發佈:2018-12-30

前段時間,因為工作需要,要收集一些木馬檔案,於是就找到了一個網站:VirusShare.com,在這裡,研究者可以提交併獲得惡意軟體的樣本。該網站實時更新來自全球的惡意檔案樣本。本來打算自己動手下載呢,但是特徵檔案更新比較慢,等好久才會出現一個我想要的檔案。剛好當時也在寫Python的爬蟲,就寫了一個爬蟲來爬。後來實驗的效果果然不錯,一晚上就把我一星期的工作量就完成了。又一次說明一個道理:程式碼解放雙手。。。

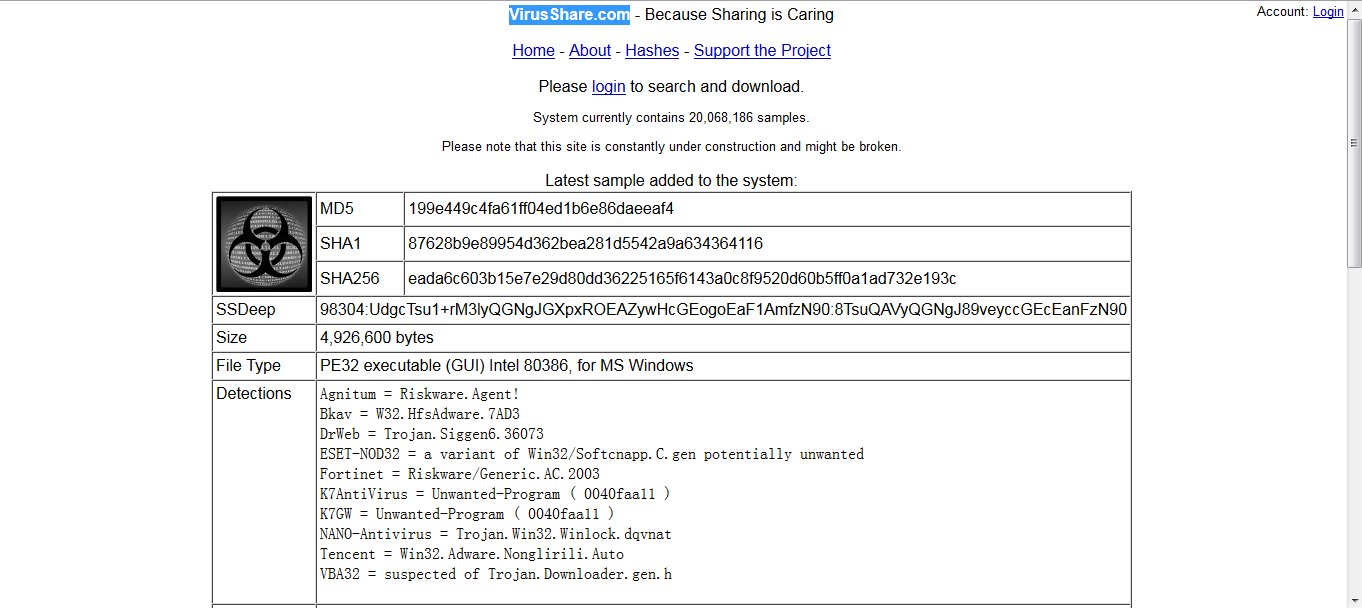

好了,不多說了,我們看一下這個網站的樣子:

可以看到現在圖片是黑白顏色的,原因是我們還沒有進行登陸。登陸後會有一些變化。因為是實時更新的,我們現在看到的惡意檔案的MD5和sha1以及SHA256的值,其中我們最想知道的是檔案的型別,這個在File Type中可以看到是PE檔案,也就是可執行檔案。還有一些其他的引數,沒怎麼仔細看。好了,不多說了,下面說一下爬蟲的編寫過程:

- 首先我們模擬一遍下載的過程,通過HTTPFox抓包分析每一條請求,然後把下載請求找出來,HTTPFox的使用細節不多說了。

- 然後,我直接上程式碼吧

# coding=utf-8

#author='CMZ'

import urllib

import urllib2

import cookielib

import datetime

import time

import re

url = 'http://www.virusshare.com'

def Get_Page():

#主機地址

hosturl = 'http://virusshare.com/'

# post的url 3.上面就是程式碼了,寫的很渣。

**

- 完!

**