文字分析之中文分詞

在處理文字分析時,我們經常需要面臨的一個問題就是分詞,特別是在中國當前的IT環境下,大部分文字資料都是中文,中文和英文有一些不一樣,中文字與字之間沒有明顯的分隔符,而英文單詞與單詞之間有自然的空格符來分隔。中文分詞屬於自然語言處理的範疇,中文分詞廣泛應用於搜尋引擎,線上機器翻譯等領域。

分詞常用的方法主要有以下三類,一個是基於字典匹配的分詞方法,一個是基於語義分析的分詞演算法,還有一個是基於概率統計模型的分詞方法。目前來講,基於概率統計模型的分詞方法效果比較好,基於語義分析的演算法太複雜,基於字典匹配的演算法相對比較簡單,關於分詞的原理推薦大家去看吳軍的科普讀物《數學之美》去了解更多資訊。

操作思路:

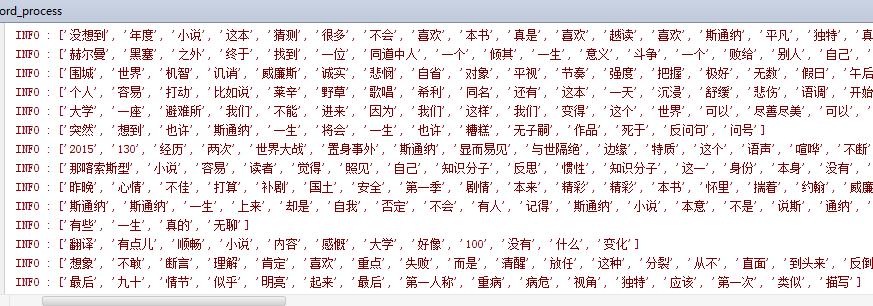

先讀取csv檔案上對應的評論那一列,然後根據stopwords過濾,然後做分詞,統計各個詞出現的頻率,程式碼就不貼了,直接貼執行的結果。

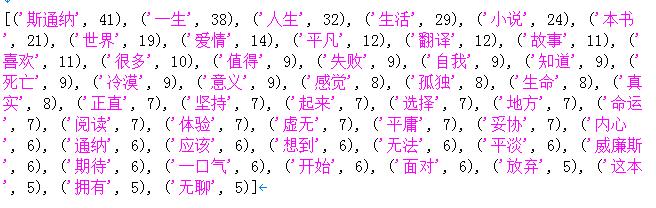

最後統計的評論中出現最多的前50個詞語如下:

相關推薦

文字分析之中文分詞

在處理文字分析時,我們經常需要面臨的一個問題就是分詞,特別是在中國當前的IT環境下,大部分文字資料都是中文,中文和英文有一些不一樣,中文字與字之間沒有明顯的分隔符,而英文單詞與單詞之間有自然的空格符來分隔。中文分詞屬於自然語言處理的範疇,中文分詞廣泛應用於搜尋引

文字分析--jieba中文分詞

分詞技術可以分為英文分詞和中文分詞: 對於英文分詞而言,由於英文單詞之間以空格來分隔,所以在進行英文分詞的過程中,只需要針對空格進行劃分就可以了。 對於中文分詞而言,中文單詞之間沒有英文單詞天然的空格來劃分,所以就需要對中文進行處理;

hanlp原始碼解析之中文分詞演算法詳解

詞圖 詞圖指的是句子中所有詞可能構成的圖。如果一個詞A的下一個詞可能是B的話,那麼A和B之間具有一條路徑E(A,B)。一個詞可能有多個後續,同時也可能有多個前驅,它們構成的圖我稱作詞圖。 需要稀疏2維矩陣模型,以一個詞的起始位置作為行,終止位置作為列,可以得到一個二維矩陣。例如:“他說的確實

Hanlp原始碼解析之中文分詞演算法

詞圖 詞圖指的是句子中所有詞可能構成的圖。如果一個詞A的下一個詞可能是B的話,那麼A和B之間具有一條路徑E(A,B)。一個詞可能有多個後續,同時也可能有多個前驅,它們構成的圖我稱作詞圖。 需要稀疏2維矩陣模型,以一個詞的起始位置作為行,終止位置作為列,可以得到一個二維矩陣。例如:“他說的確實

python_NLP實戰之中文分詞技術

一、規則分詞 1.1 正向最大匹配演算法 # 正向最大匹配演算法 MM法 規則分詞 class MM(object): def __init__(self): self.window_size=3 def cut(self,text)

資料探勘01---文字分析(jieba分詞和詞雲繪製)

一、定義: 文字挖掘:從大量文字資料中抽取出有價值的知識,並且利用這些知識重新組織資訊的過程。 二、語料庫(Corpus) 語料庫是我們要分析的所有文件的集合。 import os import os.path filePaths = [] #定義一個數組變數 #再用

Elasticsearch筆記六之中文分詞器及自定義分詞器

中文分詞器 在lunix下執行下列命令,可以看到本來應該按照中文”北京大學”來查詢結果es將其分拆為”北”,”京”,”大”,”學”四個漢字,這顯然不符合我的預期。這是因為Es預設的是英文分詞器我需要為其配置中文分詞器。 curlHTTP://192.168.79.131:9

Elasticsearch之中文分詞器

Elasticsearch的中文分詞器 1、單字分詞: 如:“我們是中國人” 效果:“我”“們”“是”“中”“國”“人” 2、二分法分詞:按兩個字進行切分。 如:“我們是中國人”,效果:“我們”、“們是”、“是中”、“中國”、“國人

自然語言處理之中文分詞器詳解

中文分詞是中文文字處理的一個基礎步驟,也是中文人機自然語言互動的基礎模組,不同於英文的是,中文句子中沒有詞的界限,因此在進行中文自然語言處理時,通常需要先進行分詞,分詞效果將直接影響詞性,句法樹等模組

python自然語言處理(一)之中文分詞預處理、統計詞頻

一個小的嘗試。。資料來源資料集 一共200條關於手機的中文評論,以XML格式儲存。分詞工具 python-jieba預處理包括去停用詞、去標點符號和數字去停用詞:使用的是他人總結的 停用詞表去標點符號和數字:用正則表示式。原本打算的是中文標點符號從網上覆制,英文標點符號用st

自然語言處理之中文分詞器-jieba分詞器詳解及python實戰

中文分詞是中文文字處理的一個基礎步驟,也是中文人機自然語言互動的基礎模組,在進行中文自然語言處理時,通常需要先進行分詞。本文詳細介紹現在非常流行的且開源的分詞器結巴jieba分詞器,並使用python實

自然語言處理基於java實現(1) 之 中文分詞

下一篇<自然語言處理基於java實現(2) 之 詞性註釋> 程式原始碼下載 一. 題目如下: 1、針對人民日報語料,編寫程式: 抽取詞表 統計總詞數、不同的詞及其次數。輸出檔案格式: 第一行

Java呼叫ICTCLAS2016 之中文分詞

win7 64位,java呼叫 1.下載ICTCLAS20160405171043_ICTCLAS2016分詞系統下載包 , 2.找到漢語分詞.....20140928/sample/Java/JNA,把該路徑下的JnaTest_NLPIR工程,匯入Myeclipse,

Elasticsearch之中文分詞器外掛es-ik的自定義詞庫

開發十年,就只剩下這套架構體系了! >>>

NLP舞動之中文分詞淺析(一)

一、簡介 針對現有中文分詞在垂直領域應用時,存在準確率不高的問題,本文對其進行了簡要分析,對中文分詞面臨的分詞歧義及未登入詞等難點進行了介紹,最後對當前中文分詞實現的演算法原理(基於詞表、統計以及序列標註等演算法)進行了簡要闡述,並對比了現有技術的優缺點,

中文分詞一席談之難點分析

什麼是分詞? 分詞就是利用計算機識別出文本中詞彙的過程。比如句子“內塔尼亞胡說的確實在理” 分詞作用 網際網路絕大多數應用都需要分詞,典型應用例項 漢字處理:拼音輸入法、手寫識別、簡繁轉換 …

【轉】中文分詞之HMM模型詳解

實現 含義 jieba 順序 清晰 bsp 中國 matrix 統計 關於HMM模型的介紹,網上的資料已經爛大街,但是大部分都是在背書背公式,本文在此針對HMM模型在中文分詞中的應用,講講實現原理。 盡可能的撇開公式,撇開推導。結合實際開源代碼作為例子,爭取做到雅俗共賞,

《數學之美》讀書記錄【思維導圖記錄】:第四章,談談中文分詞

post IT .cn splay top style title mage blog 《數學之美》讀書記錄【思維導圖記錄】:第四章,談談中文分詞

機器學習-文字特徵值抽取,中文分詞

在文字特徵值抽取過程中,將用到jieba分詞 特點 支援三種分詞模式: 精確模式,試圖將句子最精確地切開,適合文字分析; 全模式,把句子中所有的可以成詞的詞語都掃描出來,速度非常快,但是不能解決歧義。 搜尋引擎模式,在精確模式的基礎上,對長詞再次切分,提高

【NLP】【一】中文分詞之jieba

宣告:本文參考jieba官方文件而成,官方連結:https://github.com/fxsjy/jieba 【一】jieba安裝 pip install jieba 【二】jieba簡介 簡介可見jieba官方說明:https://pypi.org/project/jieba/