關於最大似然估計和最小二乘估計

看似最小二乘估計與最大似然估計在推導得到的結果很相似,但是其前提條件必須引起大家的注意!!!

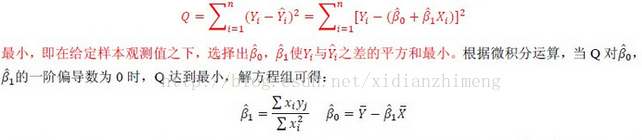

對於最小二乘估計,最合理的引數估計量應該使得模型能最好地擬合樣本資料,也就是估計值和觀測值之差的平方和最小,其推導過程如下所示。其中Q表示誤差,Yi表示估計值,Yi'表示觀測值。

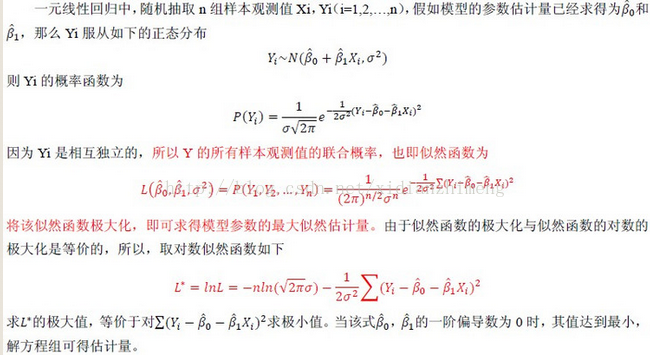

對於最大似然法,最合理的引數估計量應該使得從模型中抽取該n組樣本觀測值的概率最大,也就是概率分佈函式或者說是似然函式最大。顯然,這是從不同原理出發的兩種引數估計方法。因此最大似然法需要已知這個概率分佈函式,一般假設其滿足正態分佈函式的特性,在這種情況下,最大似然估計和最小二乘估計是等價的,也就是說估計結果是相同的,但是原理和出發點完全不同。其推導過程如下所示

最小二乘法以估計值與觀測值的差的平方和作為損失函式,極大似然法則是以最大化目標值的似然概率函式為目標函式,從概率統計的角度處理線性迴歸並在似然概率函式為高斯函式的假設下同最小二乘建立了的聯絡。

相關推薦

最大似然損失和交叉熵損失函式的聯絡

在利用深度學習模型解決有監督問題時,比如分類、迴歸、去噪等,我們一般的思路如下: 資訊流forward propagation,直到輸出端; 定義損失函式L(x, y | theta); 誤差訊號back propagation。採用數學理論中的“鏈式法則”,求L(x,

似然函式(likelihood)、最大似然函式、最小二乘解

在英語語境裡,likelihood 和 probability 的日常使用是可以互換的,都表示對機會 (chance) 的同義替代。但在數學中,probability 這一指代是有嚴格的定義的,即符合柯爾莫果洛夫公理

最小二乘法和最大似然估計的聯系和區別(轉)

enc bsp 聯系 角度 tro span nbsp sdn .science 對於最小二乘法,當從模型總體隨機抽取n組樣本觀測值後,最合理的參數估計量應該使得模型能最好地擬合樣本數據,也就是估計值和觀測值之差的平方和最小。而對於最大似然法,當從模型總體隨機抽取n組樣本觀

關於最大似然估計和最小二乘估計

看似最小二乘估計與最大似然估計在推導得到的結果很相似,但是其前提條件必須引起大家的注意!!! 對於最小二乘估計,最合理的引數估計量應該使得模型能最好地擬合樣本資料,也就是估計值和觀測值之差的平方和最小,其推導過程如下所示。其中Q表示誤差,Yi表示估計值,Yi'表示觀測值

關於最大似然估計和最小二乘法的理解和公式推導

最小二乘法可以從Cost/Loss function角度去想,這是統計(機器)學習裡面一個重要概念,一般建立模型就是讓loss function最小,而最小二乘法可以認為是 loss function = (y_hat -y )^2的一個特例,類似的想各位說的還可以用各種距離度量來作為loss functi

最大似然估計與最小二乘

現在 最小 bayesian 我不知道 什麽 改變 我不 tps 有關 參考: 最大似然估計,就是利用已知的樣本結果,反推最有可能(最大概率)導致這樣結果的參數值。例如:一個麻袋裏有白球與黑球,但是我不知道它們之間的比例,那我就有放回的抽取10次,結果我發現我抽到了8次黑球

似然函式和最大似然估計與機器學習中的交叉熵函式之間的關係

關於似然函式和最大似然估計的詳細說明可以看這篇文章:https://blog.csdn.net/zgcr654321/article/details/83382729 二分類情況和多分類情況下的似然函式與最大似然估計: 二分類情況下的似然函式與最大似然估計: 我們知道按照生活中的常識

伯努利分佈和高斯分佈下的最大似然估計

最大似然估計: 由於每一個樣本是否出現都對應著一定的概率,而且一般來說這些樣本的出現都不那麼偶然,因此我們希望這個概率分佈的引數能夠以最高的概率產生這些樣本。如果觀察到的資料為D1 , D2 , D3 ,…, DN ,那麼極大似然的目標如下: 通常上面這個概率的計算並不容易。

最大似然估計(MLE)、最大後驗概率估計(MAP)以及貝葉斯學派和頻率學派

前言 frequentist statistics:模型引數是未知的定值,觀測是隨機變數;思想是觀測數量趨近於無窮大+真實分佈屬於模型族中->引數的點估計趨近真實值;代表是極大似然估計MLE;不依賴先驗。 Bayesian statistics:模型引數是隨機變數,

最大似然和貝葉斯引數估計

引數估計是指已知分類器結構或函式形式,從訓練樣本中估計引數。以貝葉斯分類為例,假定概率密度分佈符合一維高斯分佈,則引數估計的任務就是根據訓練樣本估計μ和σ。常用的引數估計方法有最大似然估計和貝葉斯引數估計法。 最大似然估計 假設引數為確定值,根據似然度最大進行最

最大似然估計和最大後驗概率估計(貝葉斯引數估計)

舉個例子:偷盜的故事,三個村莊,五個人偷。 村子被不同小偷偷的概率:P(村子|小偷1)、P(村子|小偷2)、P(村子|小偷3) 小偷1的能力:P(偷盜能力)=P(村子1|小偷1)+P(村子2|小偷1)+P(村子3|小偷1)+P(村子4|小偷1)+P(村子5|小偷1) 小

點估計(矩估計法和最大似然估計法)

估計即是近似地求某個引數的值,需要區別理解樣本、總體、量、值 大致的題型是已知某分佈(其實包含未知引數),從中取樣本並給出樣本值 我只是一個初學者,可能有的步驟比較繁瑣,請見諒~ 1、矩估計法

【機器學習】MAP最大後驗估計和ML最大似然估計區別

A maximum a posteriori probability (MAP) estimate is an estimate of an unknown quantity, that equals the mode of the posterior distribution. The MAP can

最大似然估計(MLE)與最小二乘估計(LSE)的區別

最大似然估計與最小二乘估計的區別 標籤(空格分隔): 概率論與數理統計 最小二乘估計 對於最小二乘估計來說,最合理的引數估計量應該使得模型能最好地擬合樣本資料,也就是估計值與觀測值之差的平方和最小。 設Q表示平方誤差,Yi表示估計值,Ŷ

引數估計和最大似然估計

點估計 設總體XXX的分佈函式的形式已知,但它的一個或多個引數未知,藉助於總體XXX的一個樣本來估計總體未知引數的值得問題稱為引數的點估計問題。 舉例: 某炸藥廠,一天中發生著火現象的次數XXX是一個隨

機器學習演算法篇:最大似然估計證明最小二乘法合理性

最小二乘法的核心思想是保證所有資料誤差的平方和最小,但我們是否認真思考過為什麼資料誤差平方和最小便會最優,本文便從最大似然估計演算法的角度來推導最小二乘法的思想合理性,下面我們先了解一下最大似然估計和最小二乘法,最後我們通過中心極限定理剋制的誤差ε服從正態分佈

協方差最大似然估計為什麼比實際協方差小一點 E(ΣML)=(N-1)/N * Σ

我們都知道,給定N個一維實數空間上的樣本點{ xi,i=1,2,3... },假定樣本點服從單峰高斯分佈,那麼,最大似然估計的引數表示式為: 期望: 方差: 可是,你是否注意過,在我們從小接受到的方差定義公式,卻與最大似然估計的不一樣,一個分母為n-1,一個為n。這是

極大似然估計和最大似然估計定義

最近看樸素貝葉斯法,發現有關於極大似然估計部分,網上找了好久,感覺也都說不清。然後還有個最大似然估計,最要命的是我發現還有人專門對兩者區別做了論述。然後我就看了下英文定義: 最大似然估計(maximum likelihood estimation, MLE) 極大似然估計方

理解交叉熵和最大似然估計的關係

理解交叉熵作為神經網路的損失函式的意義: 交叉熵刻畫的是實際輸出(概率)與期望輸出(概率)的距離,也就是交叉熵的值越小,兩個概率分佈就越接近,即擬合的更好。 CrossEntropy=H(p)+DKL(p∣∣q)Cross Entropy= H(p)+DKL(p

最大似然估計、最大後驗估計和貝葉斯估計的關係

最大似然估計(MLE) 原理:設X1, X2…Xn是取自總體X的一個樣本,樣本的聯合密度(連續型)或聯合概率密度(離散型)為f(X1, X2…Xn; Θ)。當給定樣本X1, X2…Xn時,定義似然函式為L(Θ)= f(X1, X2…Xn; Θ)。 L(Θ)